1.文章信息

本次介绍的文章是2019年发表在第28届人工智能国际联合会议论文集(IJCAI-19)的《Graph WaveNet for Deep Spatial-Temporal Graph Modeling》。

2.摘要

时空图建模是分析系统中各组成部分的空间关系和时间趋势的重要任务。现有的方法大多捕获固定图结构上的空间依赖性,假设实体之间的潜在关系是预先确定的。但是,显式的图结构(关系)并不一定反映真正的依赖关系,可能由于数据中的不完全连接而缺少真正的关系。此外,现有的方法不能有效地捕获时间趋势,因为这些方法中使用的rnn或cnn不能捕获长时间序列。为了克服这些限制,我们在本文中提出了一种新的图神经网络架构,GWN,用于时空图建模。通过开发一个新的自适应依赖矩阵,并通过节点嵌入学习它,我们的模型可以精确地捕获数据中隐藏的空间依赖。Graph WaveNet使用了一个堆叠的膨胀一维卷积组件,其接收域随着层数的增加呈指数增长,能够处理非常长的序列。这两个组件在统一的框架中无缝集成,整个框架以端到端方式学习。在METR-LA和PEMS-BAY两个公共交通网络数据集上的实验结果证明了该算法的优越性能。

3.介绍

随着图神经网络的发展,时空图建模受到越来越多的关注。它的目的是通过假设连接节点之间的相互依赖性来对动态节点级输入建模,如图1所示。

但目前的研究存在一些缺点,比如连接的两个节点不需要相互依赖关系,或者两个节点存在相互依赖关系但缺少一个连接。GWN解决了这两个缺点,提出了一种图卷基层,可以通过端到端监督训练从数据中学习自适应邻接矩阵。

主要贡献:首先提出了自适应邻接矩阵保留了隐藏的空间依赖性。其次,我们把图卷积与扩展因果卷积组合,使得每个图卷基层处理由不同颗粒级别的扩展因果卷积层提取的节点信息的空间依赖性。最后就是计算成本较低结果较好。(创新点:时序上一维卷积神经网络改为扩展卷积神经网络,空间上图扩散卷积增加了自适应节点之间关系的待学习参数)

4.模型建立

1.问题定义

图用G = (V, E)表示,其中V是节点的集合,E是边的集合。由图导出的邻接矩阵记为a∈RN×N。如果vi, vj∈V, (vi, vj)∈E,则Aij为1,否则为0。在每一个时间步t,图G有一个动态特征矩阵X(t)∈RN×D。在本文中,特征矩阵可与图信号互换使用。给定一个图G和它的历史S阶跃图信号,我们的问题是学习一个函数f,它能够预测它的下一个T阶跃图信号。映射关系表示如下

其中,X (t -S):t∈RN×D×S和X (t + 1): (t + t)∈RN×D×t。

2.图卷积层

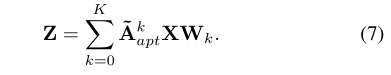

图卷积层定义为:

有研究人员提出了一种扩散卷积层,该层被证明在时空建模中是有效的。他们用K个有限步来模拟图信号的扩散过程。我们将其扩散卷积层推广为式2的形式,得到

其中Pk为转换矩阵的幂级数。对于无向图,P = A/rowsum(A)。在有向图的情况下,扩散过程有正向和逆向两个方向,其中正向跃迁矩阵Pf = a /rowsum(a)和反向跃迁矩阵Pb = AT/rowsum(AT)。利用前向和后向跃迁矩阵,扩散图卷积层被写成

自适应邻接矩阵,通过随机初始化两个具有可学习参数的节点。模型加上了自适应邻接矩阵的图卷积层,通过随机初始化两个具有可学习参数E1, E2∈RN×c的节点嵌入字典来实现这一点。我们提出自适应邻接矩阵为

模型加上了自适应邻接矩阵的图卷积层,

如果图结构不可用了就单独使用自适应邻接矩阵捕获隐藏的空间依赖性。

3.时域卷积层

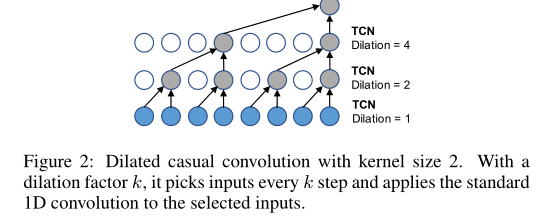

采用扩展因果卷积作为时域卷积层捕获节点的时间趋势。作为标准1d卷积的一种特殊情况,扩展因果卷积操作通过跳过某一步的值在输入上滑动,如图2所示。数学上,给定一维序列输入x∈RT和滤波器f∈RK, x与f在步长t处的扩张因果卷积运算表示为

其中d为控制跳跃距离的膨胀因子。

门控TCN。门控机制在循环神经网络中至关重要。一个简单的门控TCN只包含一个输出门。给定输入X∈RN×D×S,其形式为

4.图WaveNet的框架

我们在图3中展示了Graph WaveNet的框架。

它由堆叠的时空层和输出层组成。时空层由图卷积层(GCN)和由两个并行时间卷积层(TCN- A和TCN-b)组成的门控时间卷积层(gated TCN)构成。通过堆叠多个时空层,Graph WaveNet能够处理不同时间级别的空间依赖关系。例如,在底层,GCN接收短期时间信息,而在顶层,GCN处理长期时间信息。实际上,图卷积层的输入h是大小为[N,C,L]的三维张量,其中N是节点数,C是隐藏维数,L是序列长度。我们将图卷积层应用于h[:,:, i]∈RN×C。

我们选择使用平均绝对误差(MAE)作为Graph WaveNet的训练目标,其定义为

我们的Graph WaveNet输出了一整个的X(t+1):(t+ t),而不是通过t步递归地生成X(t)。解决了训练和测试之间不一致的问题,这是由于一个模型在训练期间学习对一个步骤进行预测,而在推理期间预计会对多个步骤进行预测。为此,我们人为地将Graph WaveNet的接受场大小设计为输入的序列长度,使得在最后一个时空层中输出的时间维恰好等于1。在此之后,我们将最后一层的输出通道数设置为步长T的因子,以得到我们想要的输出维度。

5.实验结果与分析

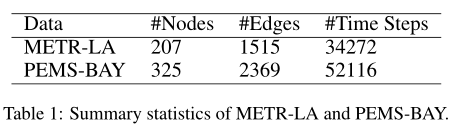

1.我们在两个公共交通网络数据集METRO-LA和PEMS-BAY上验证了Graph WaveNet。METRO-LA在洛杉矶县高速公路上的207个传感器上记录了四个月的交通速度统计数据。PEMS-BAY包含海湾地区325个传感器6个月的交通速度信息。我们采用与[Li et al, 2018b]相同的数据预处理程序。传感器的读数汇总到5分钟的窗口。节点的邻接矩阵由道路网络距离构造,具有阈值高斯核[Shuman等,2012]。Z-score归一化应用于输入。数据集按时间顺序划分,其中70%用于训练,10%用于验证,20%用于测试。表1提供了详细的数据集统计信息。

我们将Graph WaveNet与以下模型进行比较。如表2

2.实验结果

表2比较了Graph WaveNet和基线模型在METR-LA和PEMS-BA Y数据集上提前15分钟、30分钟和60分钟预测的性能。图WaveNet在两个数据集上都获得了较好的结果。它优于包括ARIMA、FCLSTM和WaveNet在内的时间模型。与其他时空模型相比,Graph WaveNet显著优于之前基于卷积的方法STGCN,同时优于基于递归的方法DCRNN和GGRU。对于次佳模型GGRU, Graph WaveNet在15min范围内较GGRU有小幅提升;然而,在60分钟的范围内实现更大的增强。我们的体系结构更能够检测每个时间阶段的空间依赖性。GGRU使用循环架构,其中GCN层的参数在所有循环单元之间共享。相比之下,Graph WaveNet采用了堆叠的时空层,其中包含具有不同参数的独立GCN层。因此,Graph WaveNet中的每个GCN层都能够专注于自己的时间输入范围。

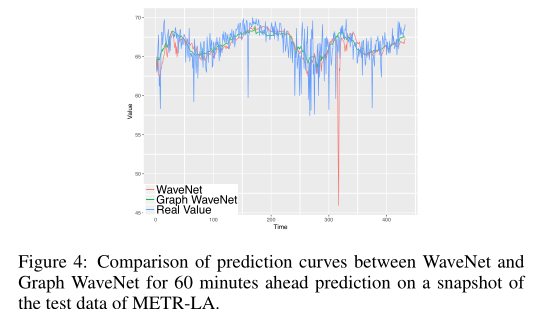

我们在图4中的测试数据快照上绘制了提前60分钟的预测值与图WaveNet和WaveNet的真实值。结果表明,Graph WaveNet产生的预测比WaveNet更稳定。特别是WaveNet产生的红色尖峰,与实际值相差甚远。相反,Graph WaveNet的曲线始终处于实数的中间。

自适应邻接矩阵的效果

为了验证我们提出的自适应邻接矩阵的有效性,我们使用五种不同的邻接矩阵配置对Graph WaveNet进行了实验。表3显示了MAE、RMSE和MAPE在12个预测水平上的平均得分。我们发现,仅自适应模型甚至比仅前向模型的平均MAE更好。当图结构不可用时,图WaveNet仍然能够实现良好的性能。

前后自适应模型在三个评价指标上得分最低。这表明,在给定图结构信息的情况下,加入自适应邻接矩阵可以为模型引入新的有用信息。在图5中,我们进一步研究了在metra - la数据集上训练的前后自适应模型配置下学习到的自适应邻接矩阵。从图5a可以看出,有些列的高值点比其他列的高值点多,比如左边框中的第9列与右边框中的第47列相比。这表明一些节点对图中的大多数节点有影响,而其他节点的影响较弱。图5b证实了我们的观察。可以看出,节点9位于多条主干道的交叉口附近,节点47位于一条主干道上。

计算时间

我们在表4中比较了Graph WaveNet与DCRNN和STGCN在METR-LA数据集上的计算成本。在训练中,WaveNet比DCRNN快5倍,但比STGCN慢2倍。对于推断,我们测量每个模型在验证数据上的总时间成本。图WaveNet在推理阶段是最有效的。这是因为Graph WaveNet在一次运行中生成12个预测,而DCRNN和STGCN必须根据先前的预测生成结果。

6.结论

本文提出了一种新的时空图建模模型。我们的模型通过将图卷积与扩展随机卷积相结合,有效地捕获时空依赖性。我们提出了一种从数据中自动学习隐藏空间依赖关系的有效方法。这为时空图建模开辟了一个新的方向,其中系统的依赖结构是未知的,但需要发现。在两个公共交通网络数据集上,Graph WaveNet实现了最先进的结果。在未来的工作中,我们将研究在大规模数据集上应用Graph WaveNet的可扩展方法,并探索学习动态空间依赖关系的方法。

Attention

欢迎关注微信公众号《当交通遇上机器学习》!如果你和我一样是轨道交通、道路交通、城市规划相关领域的,也可以加微信:Dr_JinleiZhang,备注“进群”,加入交通大数据交流群!希望我们共同进步!

3645

3645

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?