e智团队实验室项目-第三周-卷积神经网络的学习

赵雅玲 *, 张钊* , 李锦玉,迟梦瑶,贾小云,赵尉,潘玉,刘立赛,祝大双,李月,曹海艳,

(淮北师范大学计算机科学与技术学院,淮北师范大学经济与管理学院,安徽 淮北)

*These authors contributed to the work equllly and should be regarded as co-first authors.

🌞欢迎来到深度学习的世界

🌈博客主页:卿云阁💌欢迎关注🎉点赞👍收藏⭐️留言📝

🌟本文由卿云阁原创!

🌠本阶段属于练气阶段,希望各位仙友顺利完成突破

📆首发时间:🌹2022年11月1日🌹

✉️希望可以和大家一起完成进阶之路!

🙏作者水平很有限,如果发现错误,请留言轰炸哦!万分感谢!

目录

🍈 经典的卷积神经网络1:Lenet-5

从上图我们可以可以看到,其网络结构和之前在上一篇博客中介绍的网络结构相似,这里我们就不做详细的介绍了。

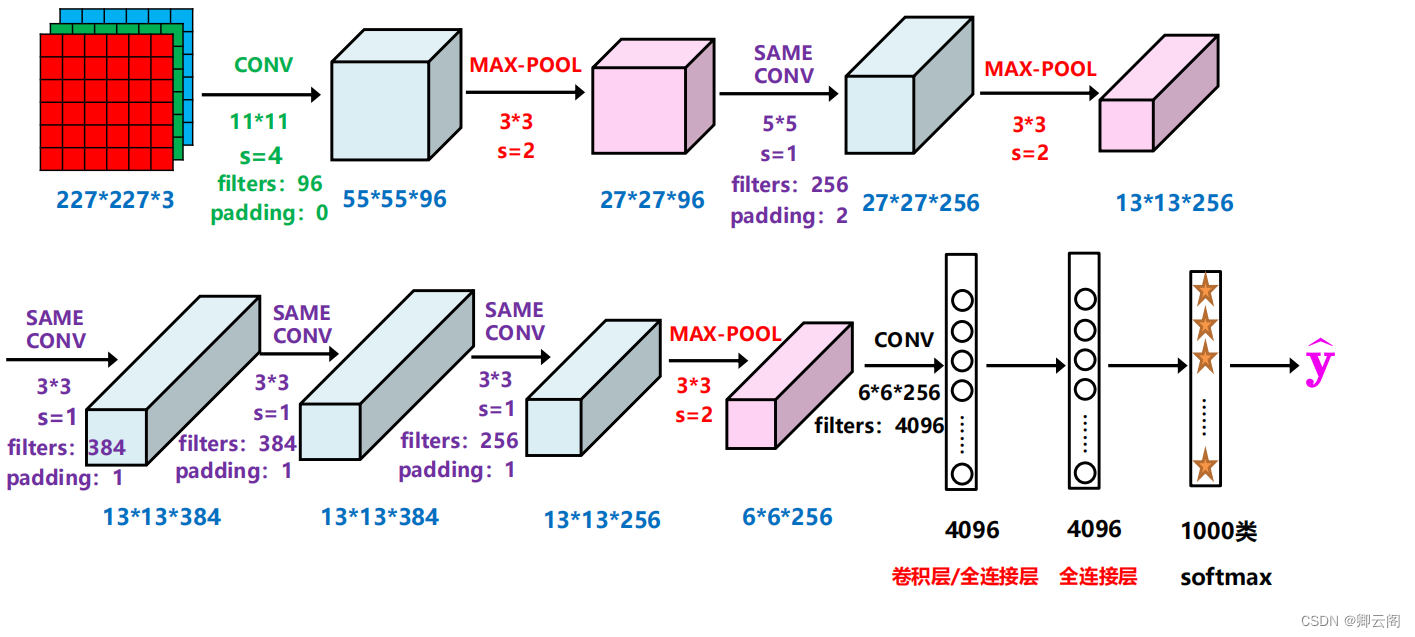

🍉 经典的卷积神经网络2:Alexnet

Alexnet网络的创新方式

(1)网络更深: Same卷积( 2)卷积层叠: 卷积层 + 卷积层 + 池化层( 3)Dropout: 减少过拟合( 4)数据增强: 样本多样化,减少过拟合(5) Relu函数: 在当时,标准的神经元激活函数是tanh()函数,即 这种饱和的非线性函数在梯度下降的时候要比非饱和的非线性函数慢得多,因此,在AlexNet中使用ReLU函数作为激活函数。Local Response Normalization(局部响应归一化)

在神经网络中,我们用激活函数将神经元的输出做一个非线性映射,但是tanh和sigmoid这些传统的激活函数的值域都是有范围的,但是ReLU激活函数得到的值域没有一个区间,所以要对ReLU得到的结果进行归一化。遇到的三个问题:1.为什么要在卷积层后加入Relu激活函数?以及它是怎么作用的?一般跟在卷积神经网络的卷积层后面进行非线性运算,作用于每一个像素点。科学就是质疑,这只是论文作者说好,现在也有很多的的网络结构中没有激活函数。一个局部范围内对于某一个现象的解释。但是相比于其他的激活函数,它的计算量相对较小。2.Same卷积的目的为了防止在卷积的过程中,特征图的尺寸越来越小。3.池化的目的为了防止在卷积的过程中,特征图的尺寸越来越小,比如在人的认知,是一个渐进的过程。计算机的认知是处理的像素,先细节,再放大形成认知。

4.Local Response Normalization(局部响应归一化)把每个像素点的值,转换成0-1之间的值,统一度量。比如路长和身高。

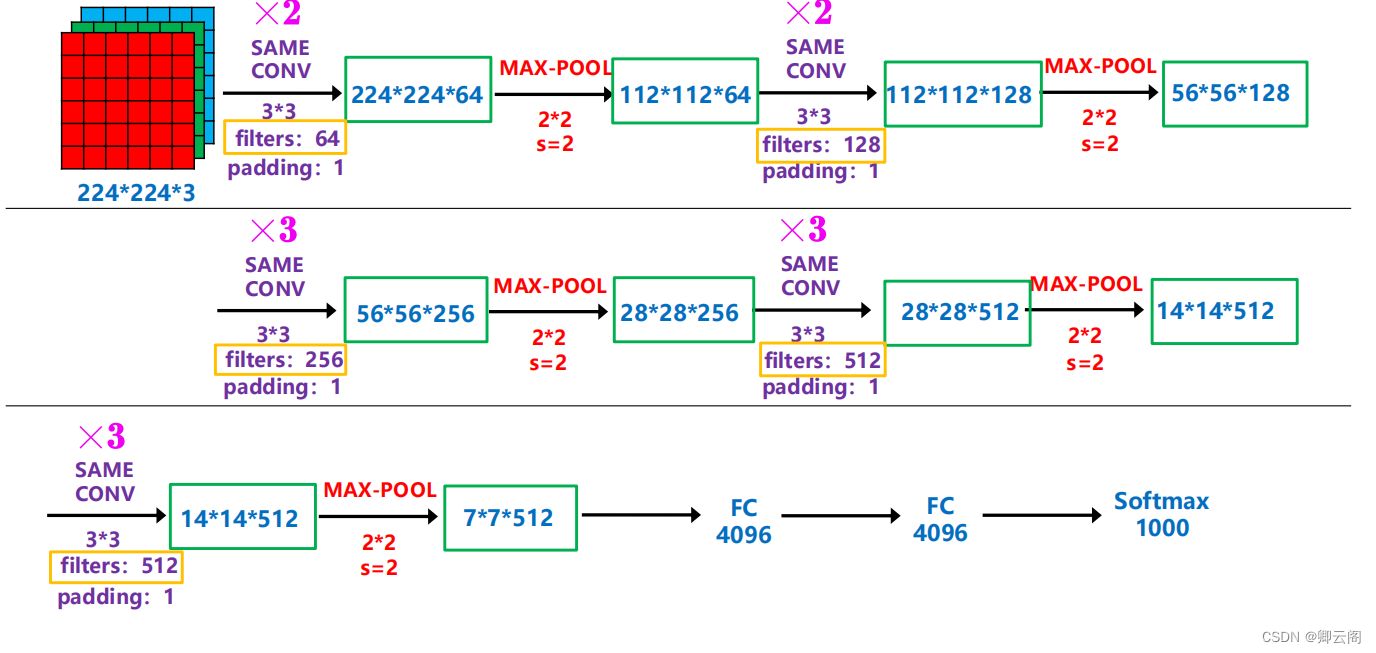

🍊经典的卷积神经网络3:Vgg

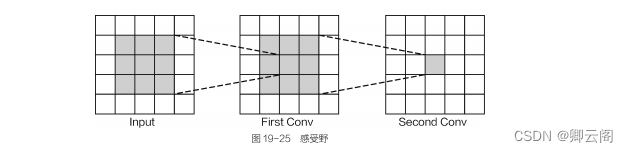

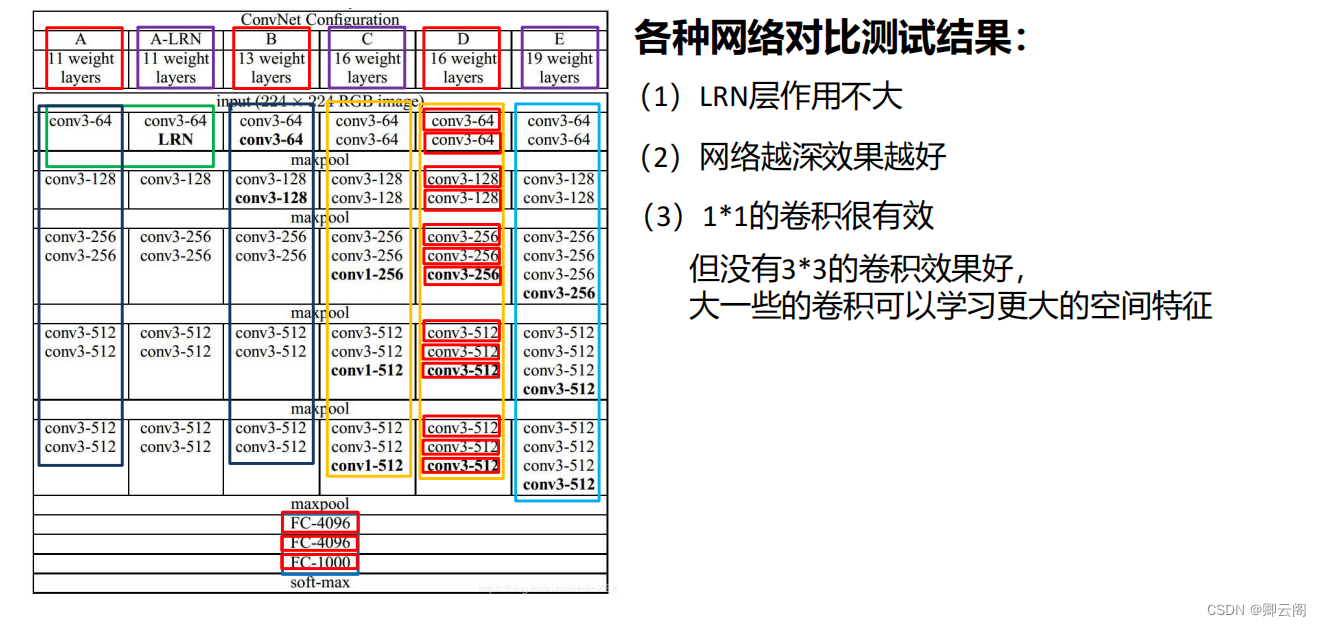

各种网络对比测试结果:(1) LRN 层作用不大(2)网络越深效果越好(3) 1*1 的卷积很有效,但没有3*3 的卷积效果好, 大一些的卷积可以学习更大的空间特征。在这里我们要主要感受野的概念。感受野(Receptive Field)的定义:卷积神经网络每一层输出的特征图(feature map)上的像素点映射回输入图像上的区域大小。通俗点的解释是,特征图上一点,相对于原图的大小,也是卷积神经网络特征所能看到输入图像的区域。

各种网络对比测试结果:(1) LRN 层作用不大(2)网络越深效果越好(3) 1*1 的卷积很有效,但没有3*3 的卷积效果好, 大一些的卷积可以学习更大的空间特征。在这里我们要主要感受野的概念。感受野(Receptive Field)的定义:卷积神经网络每一层输出的特征图(feature map)上的像素点映射回输入图像上的区域大小。通俗点的解释是,特征图上一点,相对于原图的大小,也是卷积神经网络特征所能看到输入图像的区域。

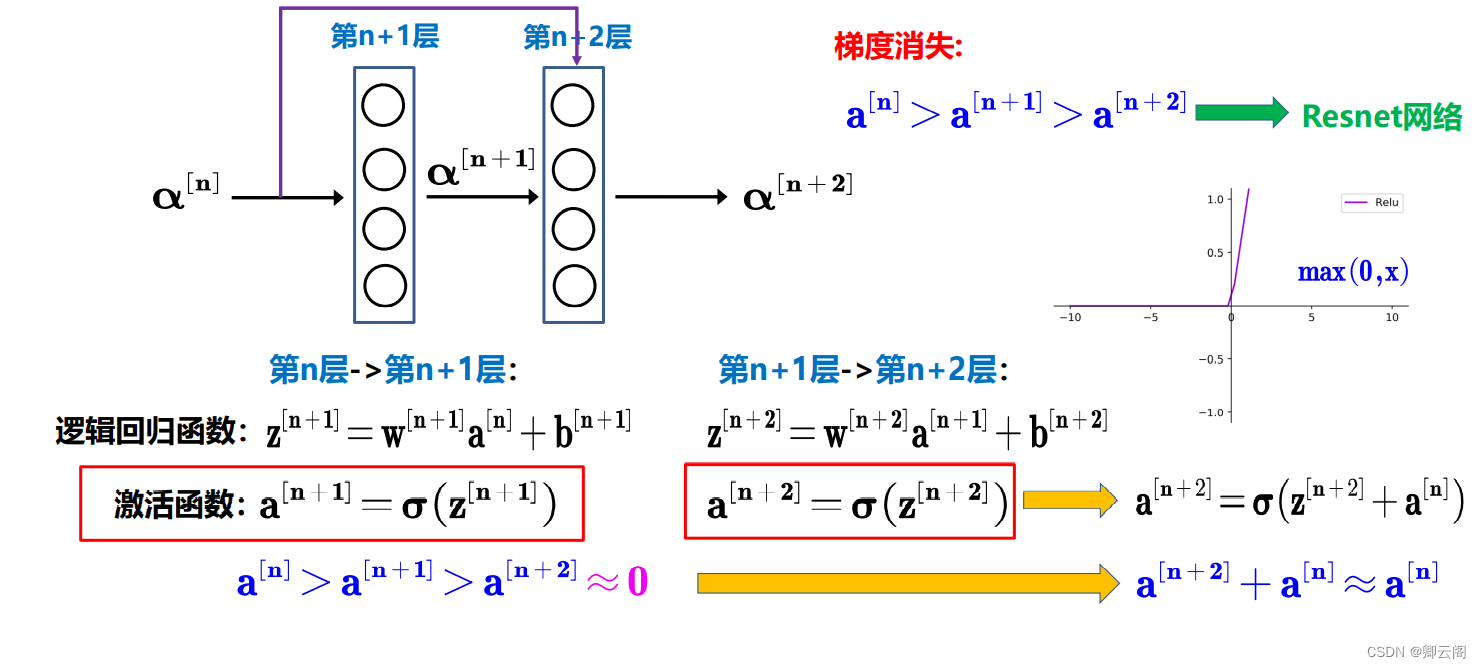

🍋Resnet网络

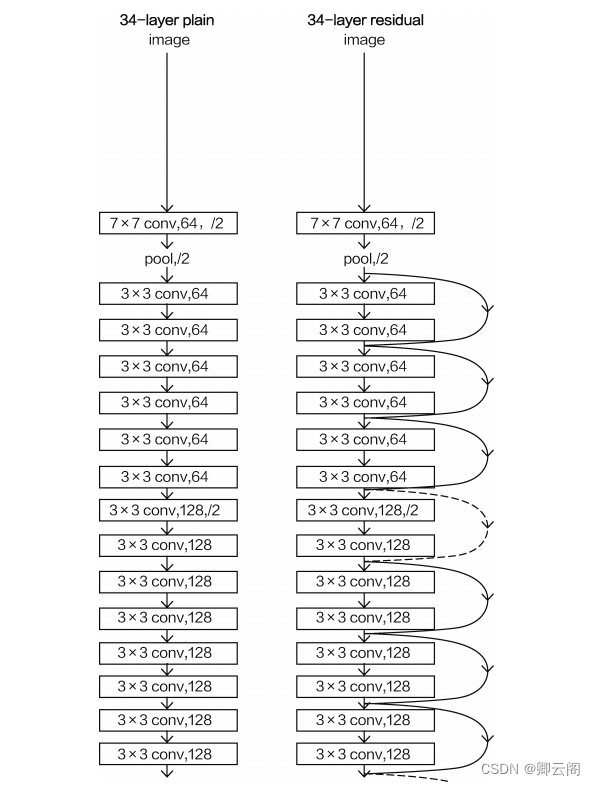

通过前面的学习,我们可能会产生一个认识,网络越深,效果越好,但是如果把Vgg的网络加深,实际的效果可能并不好,这使得深度学习出现了瓶颈,为了解决上述问题,又一个神作诞生了——深度残差网络,值得一提的是这个网络是我们中国人提出来的。

它的基本思想是,随着网络结构的增加,效果会变差,不可否认的是其中有些网络层的学习效果可能不好,有些可能很好,对于学习效果不错的网络层还可以被利用。为了选择并利用效果好的网络层,Resnet网络加入和一种新的网络叠加方法-残差模块。

残差模块:加深网络的层数,提升模型性能

Resnet网络

对于输入的特征图x,我们分两路走,第一条路不对x进行任何处理直接输出x,另一条路中,经过两次卷积操作得到最后的输出结果。然后再把这两个结果相加在一起,这就相当于让网络自己判断哪一种效果更好,如果效果不好输出就是x,如果效果提升输出就是H(x)。

网络的整体架构

疑问:

判断效果好不好的标准是什么?

如果该层网络结构效果好的话,为什么输出的是H(x)不是F(x)?

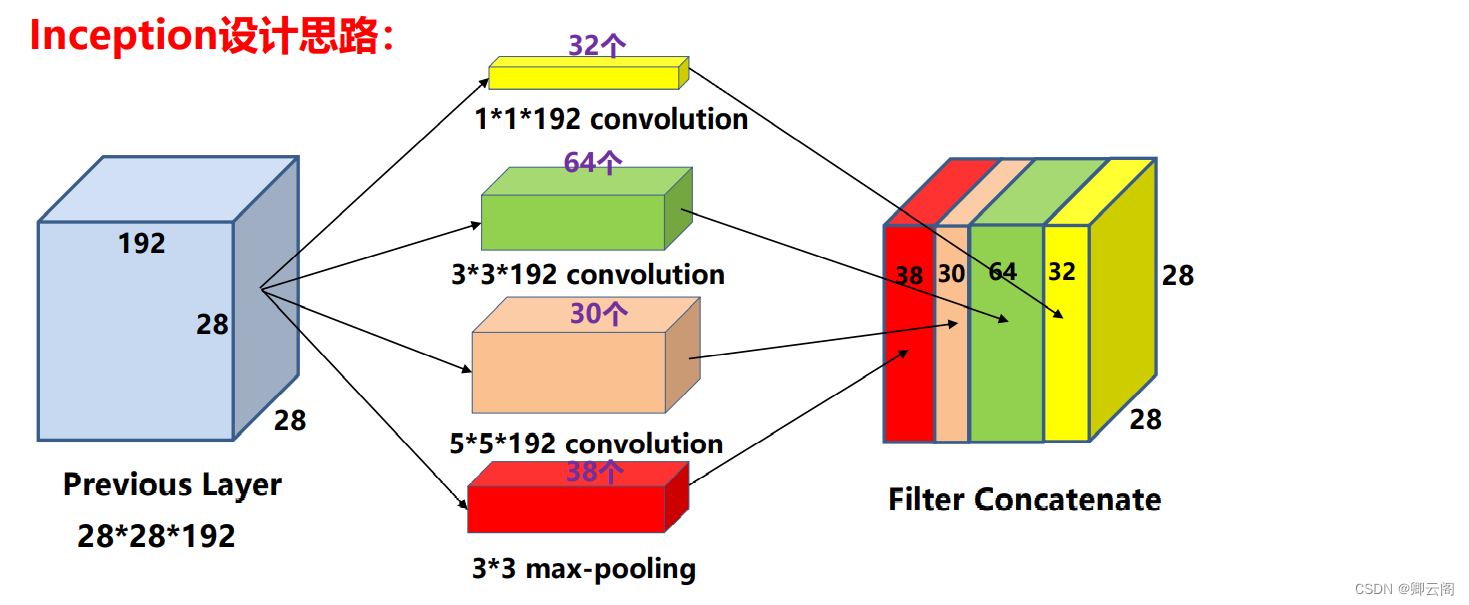

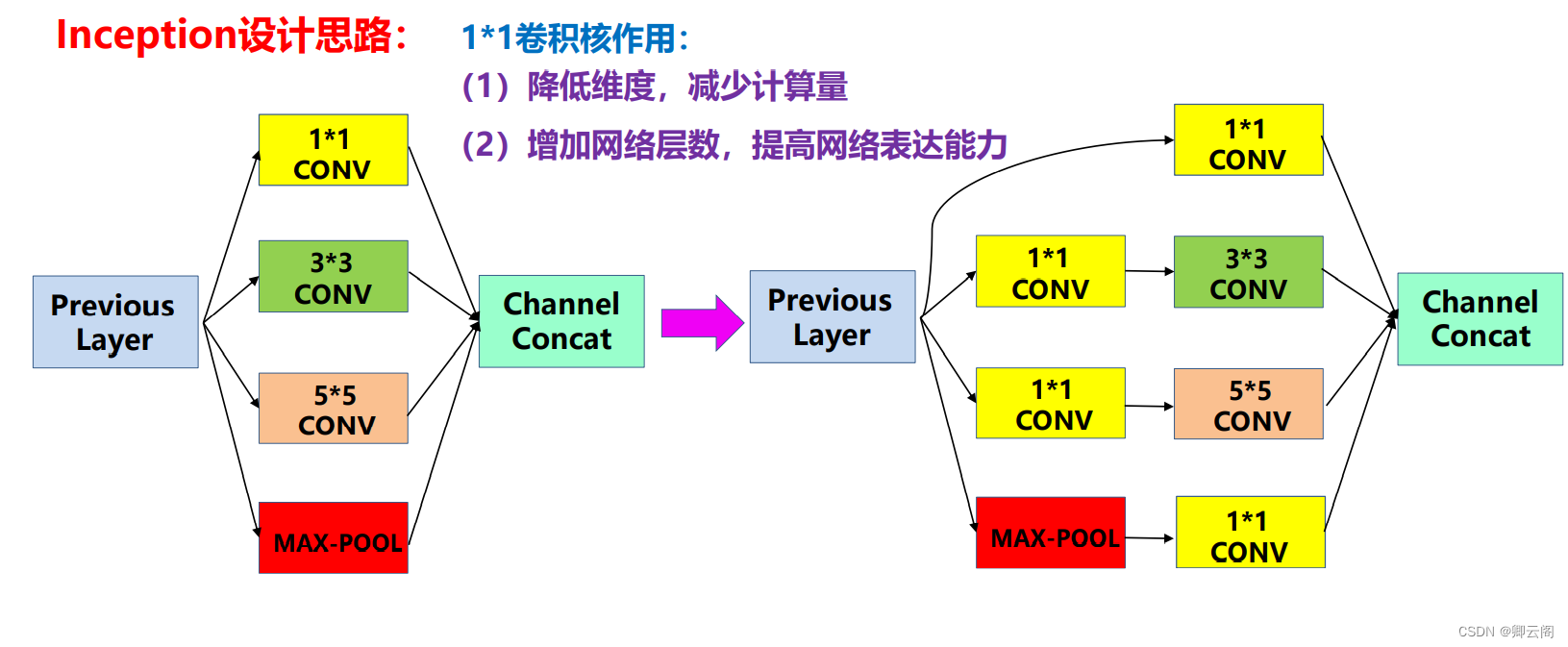

🍓Inception

目的:减少计算量和获得多尺度的特征。

获得多尺度的特征

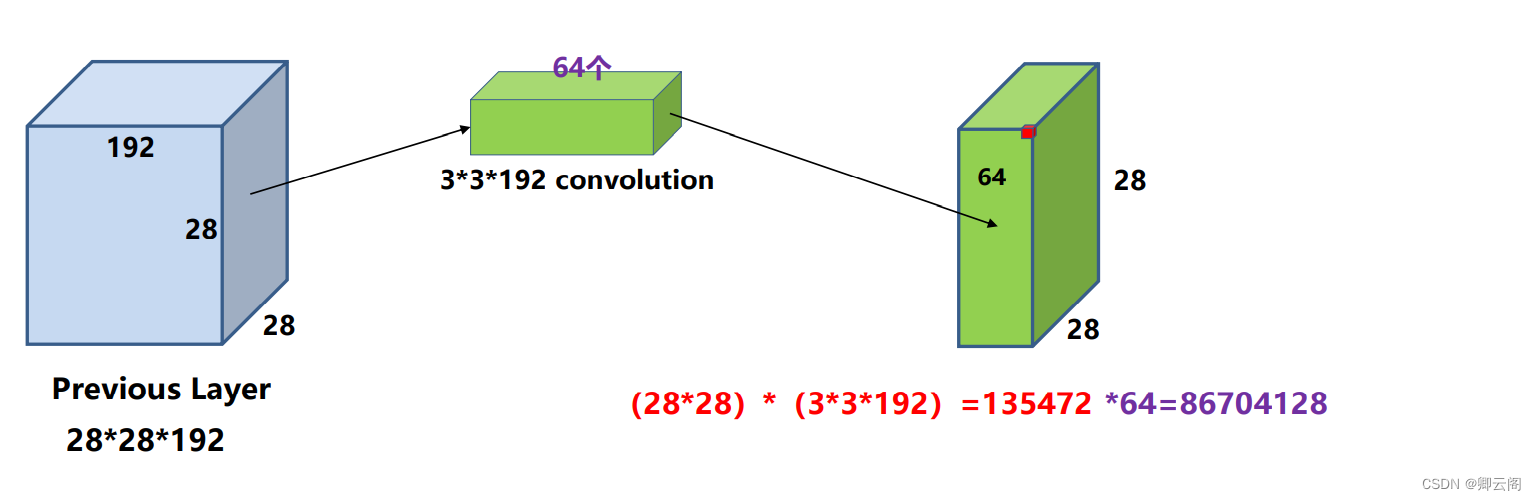

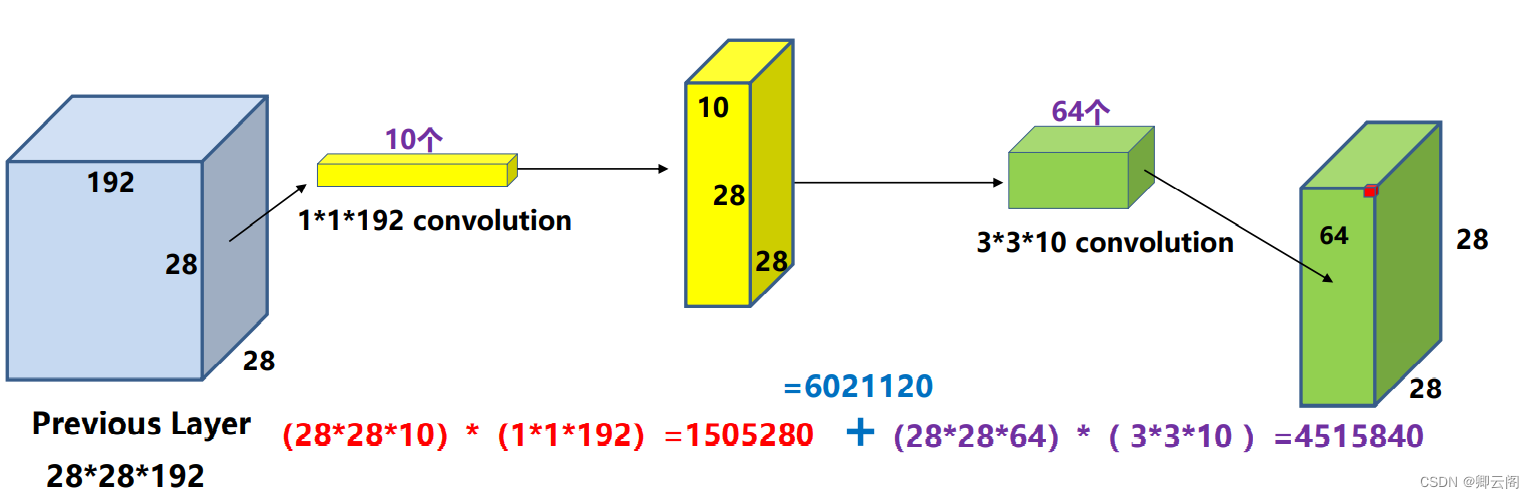

减少计算量

Institutional Review Board Statement: Not applicable.

Informed Consent Statement: Not applicable.

Data Availability Statement: Not applicable.

Author Contributions:All authors participated in the assisting performance study and approved the paper.

Conflicts of Interest: The authors declare no conflict of interest

470

470

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?