随着国产大模型DeepSeek-R1模型在网上爆火,出于数据安全与隐私保护、个性化定制、离线可用性等诸多需求,今天来教大家如何在本地部署DeepSeek-R1模型。

一、安装Ollama

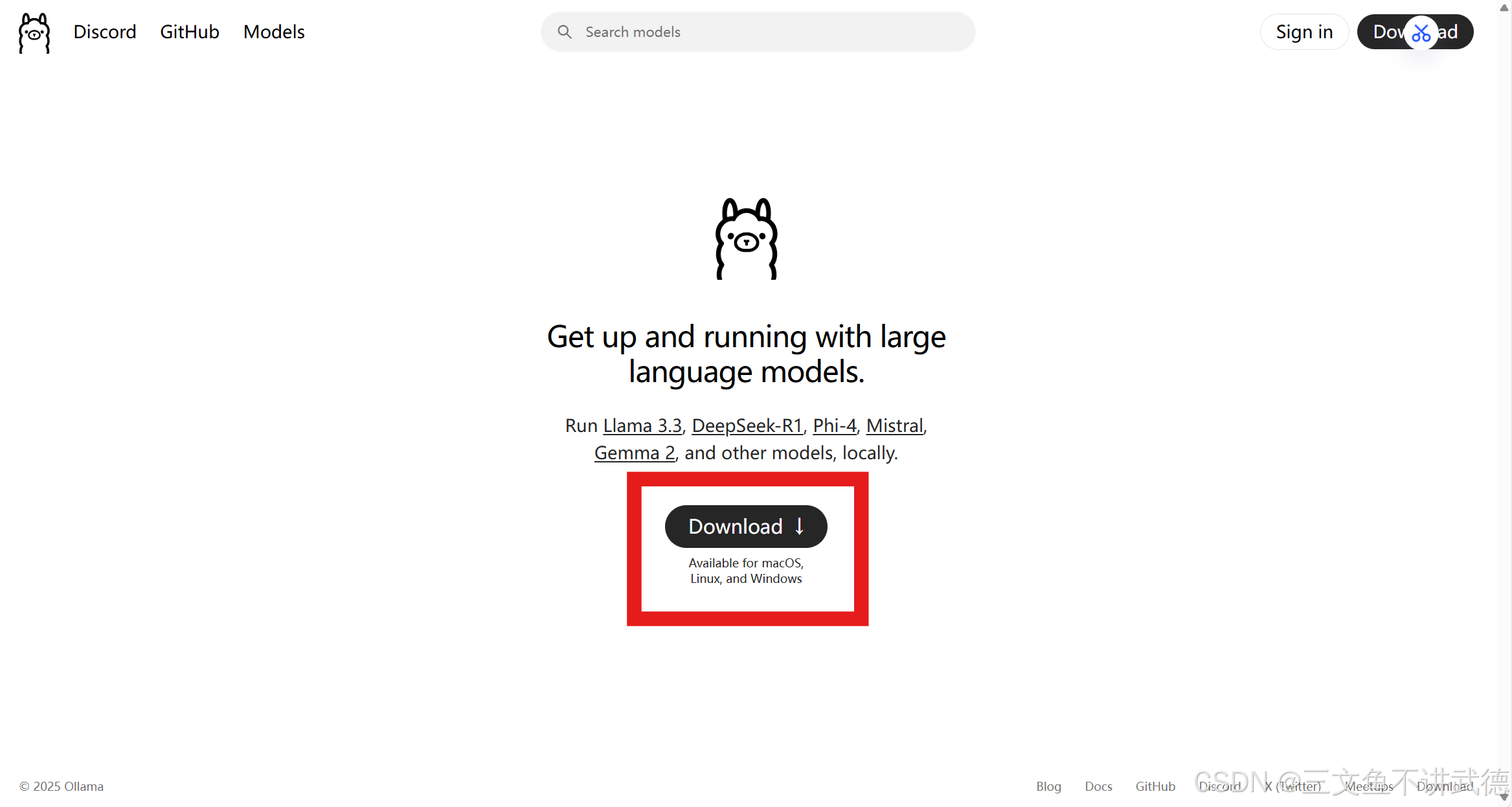

打开Ollama官网Ollama![]() https://ollama.com/点击下载

https://ollama.com/点击下载

选择对应的版本

下载完成之后点击exe这个文件(找到下载的位置)

点击Install 等待软件安装完毕

在电脑的搜索框输入cmd 调出命令提示符

输入ollama -v

如果出现Ollama的版本 则说明Ollama已经安装完毕

二、部署DeepSeek-R1模型

打开Ollama官网 找到Models 选择第一个

根据需求和设备条件选择相应的版本

模型越大越好用 但对显卡以及电脑的配置的要求也越高

复制安装命令

进入命令提示符,粘贴命令之后按回车

当显示success时,表示安装完毕

此时已经可以直接对话

输入/bye可以退出

当想要再次开启对话时,可以输入ollama list

接着复制想要打开的模型的名字

输入ollama runn 粘贴名字,按回车即可进入对话

三、美化使用界面

搜索Chatbox

Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载![]() https://chatboxai.app/zh下载Chatbox或者使用网页版

https://chatboxai.app/zh下载Chatbox或者使用网页版

点击设置选择OLLAMA APL 接着再选择已下载的模型

注意!!!一定一定一定要参考教程操作 确保远程Ollama服务能够远程连接

操作完成之后点击保存即可

以上就是关于如何在本地部署DeekSeep-R1模型的全部内容啦 希望大家都能顺利部署成功!

7万+

7万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?