生成式AI中常说的token是什么?嵌入(Embeddings)是什么意思?为什么现在的AI具有生成能力?AI是怎么和你进行对话的?为什么都说提示词很重要?为什么同一段提示词,同一个AI模型/工具,多问几次可能得到截然不同的结果?

要回答以上这些问题,你需要了解大语言模型(LLM)是如何工作的。知其然,也要知其所以然。

步骤1:分词(Tokenize)

面对一个问题,我们人类的习惯性操作是什么?理解问题。LLM也是一样。

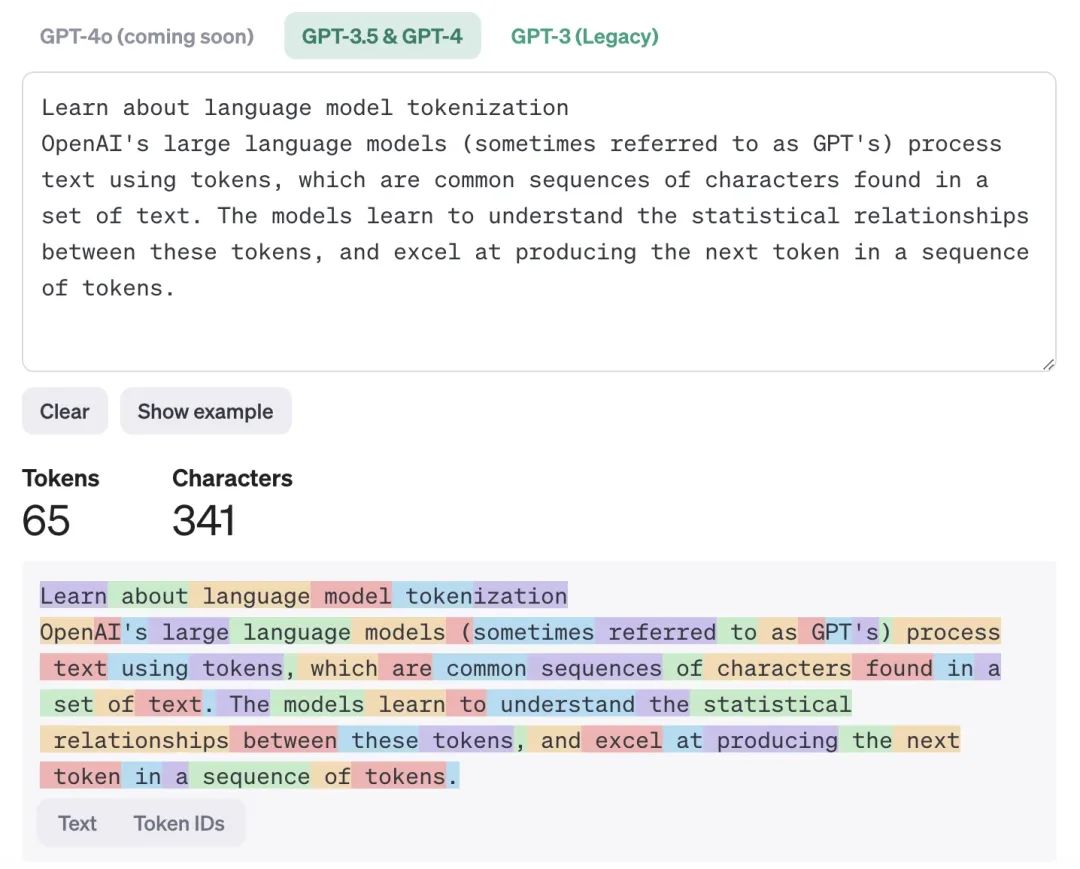

LLM在处理输入文本时,首先使用分词器(Tokenizer)将文本分割成若干小的文本块,即tokens。这些tokens由可变数量的字符组成,随后被转换成高维向量的数值表示,也就是嵌入(embeddings),供模型处理。这一步骤是模型理解语言的基础,类似于人类阅读和解析文本的过程。

分词(Tokenize)是LLM工作的第一步,在这个过程中将输入文本转换为模型可以处理的数值表示。这个过程通常包括以下几个步骤:

-

文本分割:输入文本首先被分割成若干小的文本块(tokens)。每个token可以是一个单词、部分单词或字符序列。分词的方式取决于具体的分词器算法和模型的需求。例如,BERT模型通常使用WordPiece分词方法,而GPT系列模型使用Byte Pair Encoding (BPE)。

-

Token映射:分割后的tokens被映射到特定的token索引,即整数编码。这些整数编码是模型内部词汇表的一部分。通过这种方式,文本被转换为数值序列,模型可以更高效地进行处理。

-

嵌入(Embeddings):这些整数编码随后被转换为高维向量,这些向量称为嵌入(embeddings)。嵌入是对文本语义信息的密集表示,捕捉了词汇之间的语义关系和上下文信息。嵌入向量在模型的初始层被计算和优化,以便在后续的模型层中进行处理。

步骤2:预测(Predict)

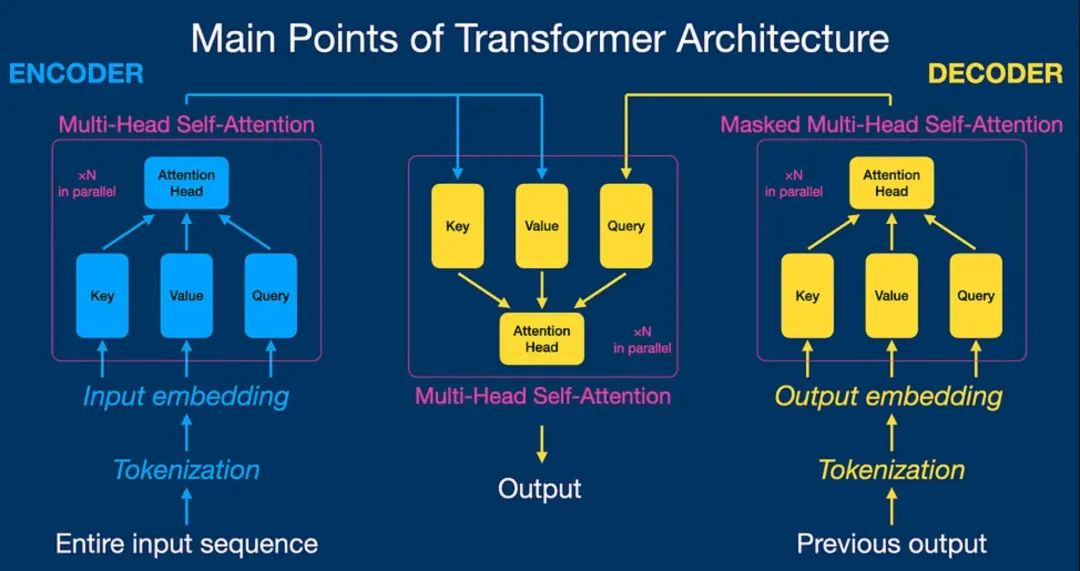

在完成分词和嵌入后,LLM进入核心的预测阶段。这一过程通过多层神经网络和注意力机制来完成,以确保生成的文本在语法和语义上都是合理的。自注意力机制(Self-Attention)允许模型在生成文本时关注输入序列中的不同部分,从而理解单词之间的依赖关系。例如,Transformer架构通过自注意力机制有效地捕捉长距离依赖关系,并能够高效并行地进行计算。

-

输入处理:模型接收n个输入tokens的嵌入表示。通过多层的神经网络(通常是基于Transformer架构的层),这些嵌入被处理以捕捉词与词之间的依赖关系和上下文信息。

-

自注意力机制:在每一层中,模型使用自注意力机制来计算每个token与其他token的关系。自注意力机制允许模型在处理当前token时考虑整个输入序列的上下文。这对于生成连贯和上下文相关的文本至关重要。

-

前馈神经网络:经过自注意力机制处理的输出被传递给前馈神经网络层,进一步进行非线性变换和特征提取。经过多层的自注意力和前馈处理后,模型生成用于预测的特征表示。

步骤3:概率分布和选择(Probability Distribution & Selection)

在生成文本时,LLM会为每个可能的下一个token计算一个概率分布。然后,模型会选择概率最高的token作为输出,或者通过引入随机性来选择token,从而模拟创造性思维。这种随机性的引入是为了增加模型输出的多样性,避免每次生成相同输入的相同文本。

-

概率分布计算:模型为每个可能的下一个token计算一个概率分布。这些概率反映了每个token在当前上下文中作为下一个token的可能性。概率分布是通过softmax函数计算的,确保所有可能token的概率之和为1。

-

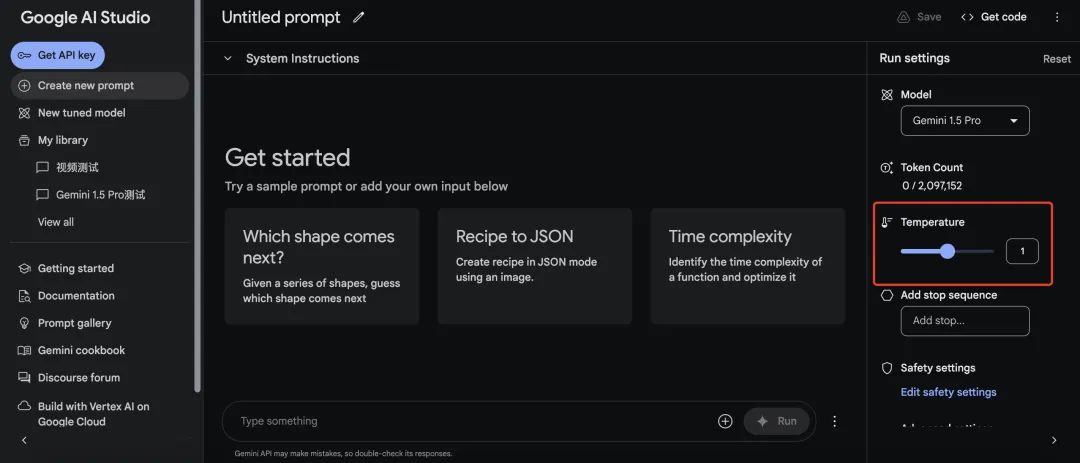

选择输出token:根据计算出的概率分布,模型选择一个token作为输出。通常会选择概率最高的token,但为了增加生成文本的多样性和创造性,模型有时会引入随机性。这种随机性可以通过“温度Temperature”参数进行调整,温度越高,生成的文本越随机。

-

迭代生成:选择的输出token会被加入到输入序列中,模型重新进行上述步骤,以生成下一个token。这种迭代过程一直持续,直到生成完整的句子或文本。

结语

知其然,更要知其所以然。

生成式AI中常说的token是什么?

Token是LLM处理文本的最小单位,可以是一个单词、部分单词或字符序列。分词器将文本分割成tokens,并将其映射为数值表示,供模型处理。

嵌入(Embeddings)是什么意思?

嵌入是将tokens转换为高维向量的过程,这些向量捕捉了词汇之间的语义关系和上下文信息,是模型理解语言的基础。

为什么现在的AI具有生成能力?

LLM通过大规模数据训练和复杂的神经网络结构,能够预测并生成符合上下文的文本。这种能力源自模型对语言模式的深度学习和对上下文的理解。

AI是怎么和你进行对话的?

AI通过接收你的输入,进行分词和嵌入,然后预测下一个可能的token,生成回应文本。这个过程是连续且动态的,确保对话的连贯性和相关性。

为什么都说提示词很重要?

提示词(prompts)是模型生成内容的起点,好的提示词能引导模型生成更符合预期的高质量文本。

为什么同一段提示词,同一个AI模型/工具,多问几次可能得到截然不同的结果?

这是因为模型在选择输出token时引入了随机性,尤其是温度参数较高时。这种随机性模拟了创造性思维,确保生成的文本多样性。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

98

98

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?