信息瓶颈

给定的数据 X 在经过连续层时可能会导致信息丢失。

从式(1)中我们认为,随着网络层数越深,信息流就越容易丢失。 就 SISR 任务而言,总体目标是找到具有优化函数参数 θ 的映射函数 F,以最大化 HR 和 SR 图像之间的互信息。

图像超分辨中空间信息消失

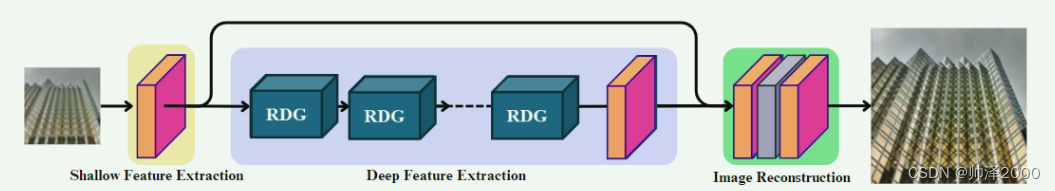

SISR方法一般可以分为三个部分

(1)浅层特征提取(2)深层特征提取(3)图像重建

浅层特征提取一般来说就是简单的卷积层,图像重建是卷积层加上采样

两种深层特征提取方法:

**** 残差连接学习局部特征

采用残差学习使得模型只更新各层之间的差异,而不是直接输出前一层的全部信息。

由于残差块内的信息不一定能保留空间信息,这最终会导致特征图强度方面的不平滑,从而在前向传播过程中造成最深层的信息瓶颈。 这使得当梯度流到达网络的更深层时,空间信息很容易丢失,从而导致数据效率降低或需要更复杂的网络设计来实现更好的性能。

****稠密链接稳定信息流

将密集连接纳入基于 Swin-Transformer 的 SISR 模型具有两个显着优势。 一是全局辅助监管。 它有效地融合了不同残差组之间的空间信息,在整个深度特征提取过程中保留了高频特征。 其次,使SISR模型摆脱信息瓶颈。 通过利用空间信息的集成,该模型确保空间信息的平滑传输,从而减轻信息损失并增强感受野。

网络架构

浅层特征提取就是一个3*3卷积

之后经过多个RDG(Residual Deep feature extraction Group),通过3*3卷积输出

图像重塑需要把浅层特征与深层特征短接,再上采样输出SR image

Same-task ProgressiveTraining Strategy

先在imagenet等大型数据集上训练模型,然后在特定数据集上进行微调,从而提高SISR结果。

可以先使用L1-loss训练SISR,再用L2-loss来消除奇异像素和伪影,提高PSNR

数据集

DF2K数据集包括DIV2K和Flickr2K,DIV2K有800张图像,Flickr2K有2650张。

对于训练输入,通过应用缩放因子分别为 2、3 和 4 的双三次下采样方法来生成这些图像的 LR 版本。

1083

1083

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?