在paper with code排名35,2024年发表的文章,有github,但是还没有上传源码

学习一下为什么可以在2024年发出排名第35的文章

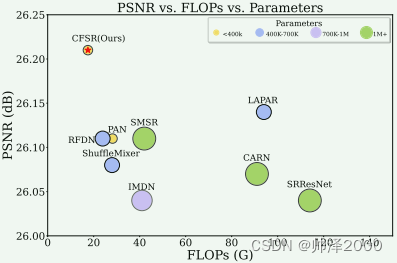

可以看出CFSR以较低的FLOPs和Parameters取得了较高的PSNR值

与其他模型的对比,确实很轻量化,性能要比一些老牌CNN模型强一点,比如SRResnet,RFDN等,比Transformer轻量化模型弱一点点,这里是跟SwinIR作对比

摘要

单图像超分辨率(SISR)的最新进展已经取得了显着的性能,但这些方法的计算成本对于在资源受限的设备上部署仍然是一个挑战。 特别是对于基于 Transformer 的方法,此类模型中的自注意力机制带来了巨大的突破,同时带来了大量的计算成本。 为了解决这个问题,引入了卷积变换层(ConvFormer)和基于ConvFormer的超分辨率网络(CFSR),它们为轻量级图像超分辨率任务提供了有效且高效的解决方案。 具体来说,CFSR利用大核卷积作为特征混合器来取代自注意力模块,以少量的计算成本有效地建模长程依赖性和广泛的感受野。 此外,我们提出了一种边缘保留前馈网络,简化为 EFN,以获得局部特征聚合并同时保留更多高频信息。 大量实验表明,与现有的轻量级 SR 方法相比,CFSR 可以在计算成本和性能之间实现高级权衡。 与最先进的方法相比,例如 ShuffleMixer 中,所提出的 CFSR 在 Urban100 数据集上的 ×2 SR 任务上实现了 0.39 dB 的增益,同时参数和 FLOP 分别减少了 26% 和 31%。

相关工作

Re-parameterizing Methods

RepVGG提出了实用的网络架构和重参数化的概念。通过重新参数化,在训练过程中学习的多个线性卷积可以在推理中合并为一个卷积,而不是引入额外的成本。

RepSR 通过重参数化完成架构,并引入BN操作。

ECBSR,通过重参数化将更多的一阶和二阶梯度信息引入到普通卷积中。

DDistill-SR,将重参数化与动态卷积相结合,扩展感受野,同时降低推理的复杂性。

网络结构

论文里没提,个人感觉上图的RCFB就是BRB,LRimage经过3*3卷积得到浅层特征F0,浅层特征经过两个BRB然后3*3卷积,得到的深层特征与浅层特征组合,进行图像重塑。图像重塑包含一个3*3卷积和pixel-shuffle。

常规架构,使用L1LOSS

这是LKM的公式说明,总感觉公式描述与图像对不上,V是上面那条的输出,Fgate是下面那条的输出,Fgate的1*1卷积跟大核Dw卷积写反了吧,Fout应该还得再加一个1*1卷积,这里V与Fgate进行的是per-pixel production。

DwCONV是depth-wise convolution,深度可分离卷积中的第一步

这是EFN的公示说明,看的麻烦,实际上就是先经过1*1卷积加GELU激活,再经过EDC加ReLU激活,最后1*1卷积输出。

上图是EDC的流程图,Sobel-Dx的水平和垂直卷积核如下

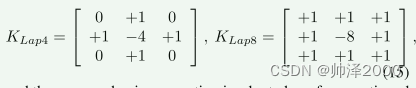

拉普拉斯滤波器KLap用于提取二阶梯度,其中采用4邻域和8邻域拉普拉斯算子如下:

可以在推理中将多分支 EDC 层合并为一个 DwConv,而不会引入额外的复杂性。 将 K 和 B 表示推理中普通 DwConv 的合并核权重和偏差。 它们可以通过以下方式实现:

99

99

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?