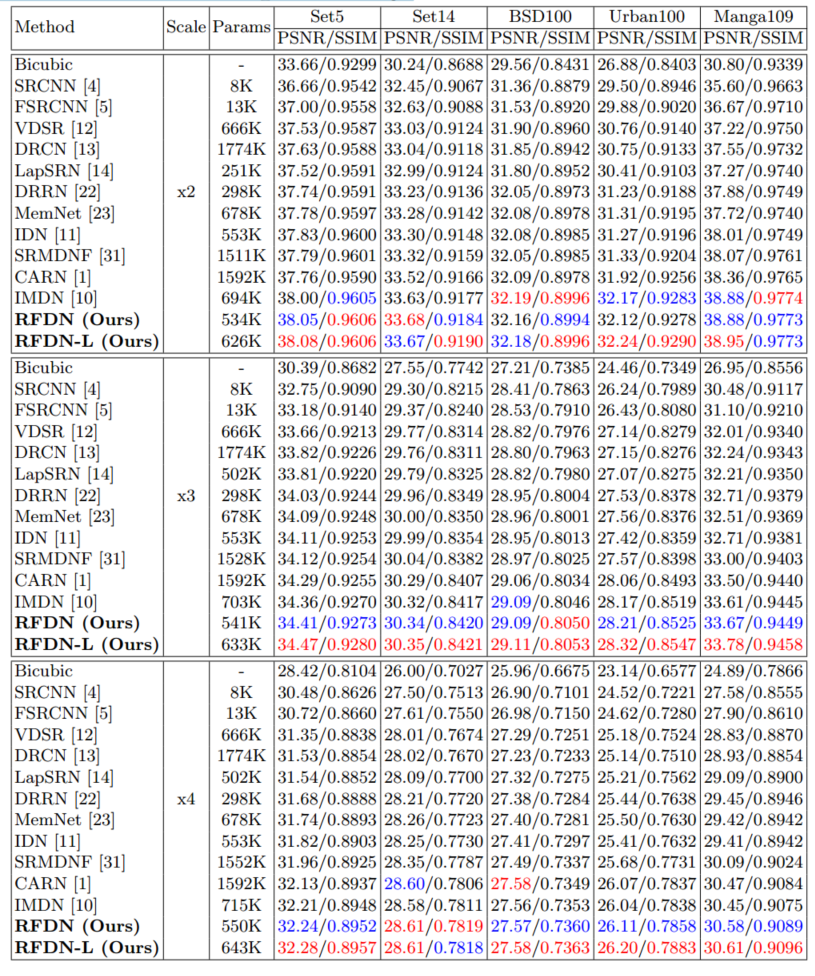

论文名字Residual Feature Distillation Network for Lightweight Image Super-Resolution,发表于2020年

这个实力在当时还是很能打的,放到现在排名40左右吧,参数几乎是同水平的CARN的1/3。

摘要

信息蒸馏网络是目前最先进的方法之一,它采用通道分裂操作提取提取的特征。然而,这种操作如何帮助设计高效的SISR模型还不够清楚。在本文中,我们提出了特征蒸馏连接(FDC),它在功能上等同于通道分割操作,但更轻量和灵活。基于残差特征蒸馏网络,我们对信息多蒸馏网络(IMDN)进行了重新思考,提出了一种轻量级、精确的信息多蒸馏网络(RFDN)模型。RFDN使用多个特征蒸馏连接来学习更具判别性的特征表示。我们还提出了一个浅残差块(SRB)作为RFDN的主要构建块,这样网络可以从残差学习中获益最多,同时仍然足够轻量。

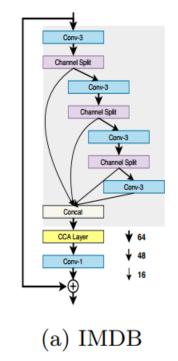

对IMDB的重新思考

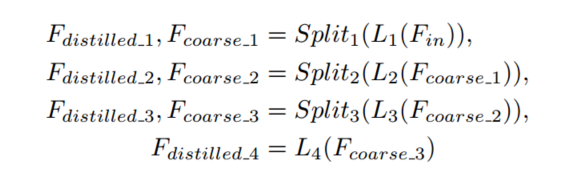

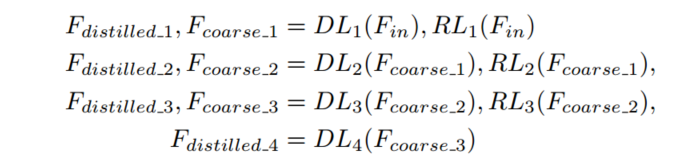

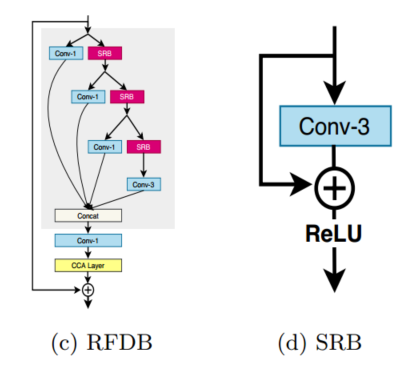

这是IMDN网络提出的IMDB,灰色背景是PRM,用于特征蒸馏, 尽管PRM取得了显著的改进,但由于信道分割操作,它的效率不够高,并且引入了一些不灵活性。提取的特征由3×3卷积滤波器生成,该滤波器具有许多冗余参数。此外,特征细化管道(沿着PRM的右分支)与通道分割操作耦合在一起,因此很难仅对该管道使用身份连接。接下来,我们将重新考虑信道分割操作,并给出一个新的等价的PRM架构来解决上述问题。

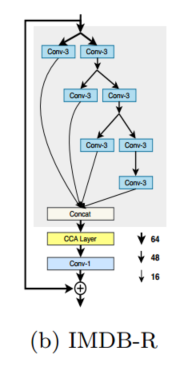

上述方程描述了每组拆分操作都可以看作是并发工作的两个卷积层。我们称这种新架构为IMDB- R,它比原来的IMDB更灵活。它对PRM如何工作有一个更清晰的视图,这样我们就可以得到更多关于如何设计更有效的SR模型的线索。

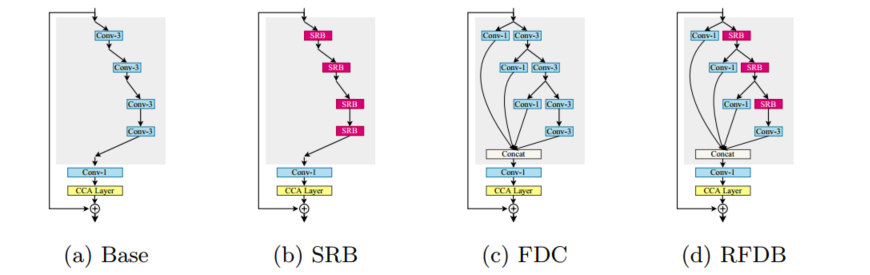

RFDB

我们可以看到信息蒸馏操作实际上是通过以固定比率压缩特征通道的3 × 3卷积实现的。然而,我们发现使用1 × 1卷积来减少通道更有效,就像在许多其他CNN模型中所做的那样。如图2c所示,左边的三个卷积被替换为1 × 1的卷积,这大大减少了参数的数量。最右边的卷积仍然使用3 × 3核。这是因为它位于RFDB的主体上,必须考虑到空间上下文,以便更好地细化特征。

除了上述改进之外,我们还在网络中引入了更细粒度的残差学习。为此,我们设计了一个浅残差块(SRB),如图2d所示,它由一个3 × 3卷积、一个身份连接和激活单元组成。SRB可以在不引入任何额外参数的情况下从残差学习中获益。原始IMDB只包含中级剩余连接,这些连接太粗糙,网络无法从剩余连接中获益最多。相比之下,我们的SRB支持更深的残差连接,即使使用轻量级的浅SR模型,也能更好地利用残差学习的力量。

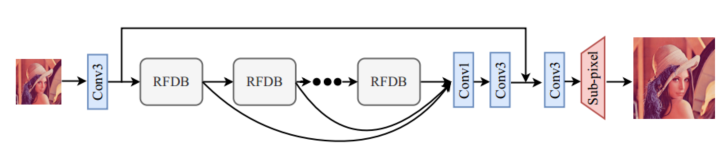

网络框架

其他都好理解,这里给出深层特征提取公式

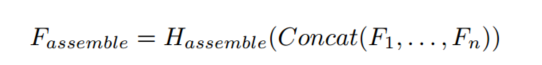

F1,F2,Fn这些是每个RFDB的输出(细化后的特征),沿着通道拼接,经过 1*1卷积组合,最后经过3*3卷积对聚合特征进行平滑处理。

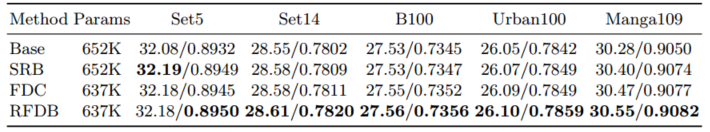

实验结果

为了验证SRB的作用,作者设置了以上四个网络进行消融实验,下面是结果

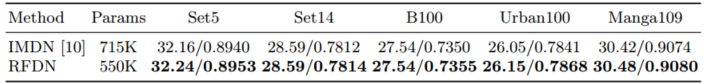

整篇文章实在IMDN的基础上进行的改进,最后也是秀了一下结果

1027

1027

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?