1. 写在前面

你是否遇到过这样的情况:作为法务工作者,需要逐字逐句审查大量合同,眼睛都要看花了,还担心漏掉重要条款?作为企业管理者,面对堆积如山的合同文件,审批流程繁琐又耗时?又或者你是一名创业者,想利用 AI 技术提升合同审查效率,但缺乏专业的技术背景?

如果你的答案是肯定的,那么 Dify 这款工具将为你带来全新的解决方案。

Dify 是一款面向企业级场景的开源智能体框架,它的最大优点就是支持本地化部署,对于有涉密数据(如合同)或专业领域数据处理需求的用户来说,简直是福音。与其他类似工具相比,Dify 在数据安全性上更胜一筹,你的数据可以完全在自己的掌控之下,不用担心泄露风险。

今天的教程将从 0 到 1 带你搭建一个合同审查智能体。整个过程我会尽可能详细地讲解,即使你没有太多的技术背景,也能按照步骤操作成功。让我们一起开启 Dify 的初体验之旅吧!

2. 手把手教你把Dify部署在电脑上

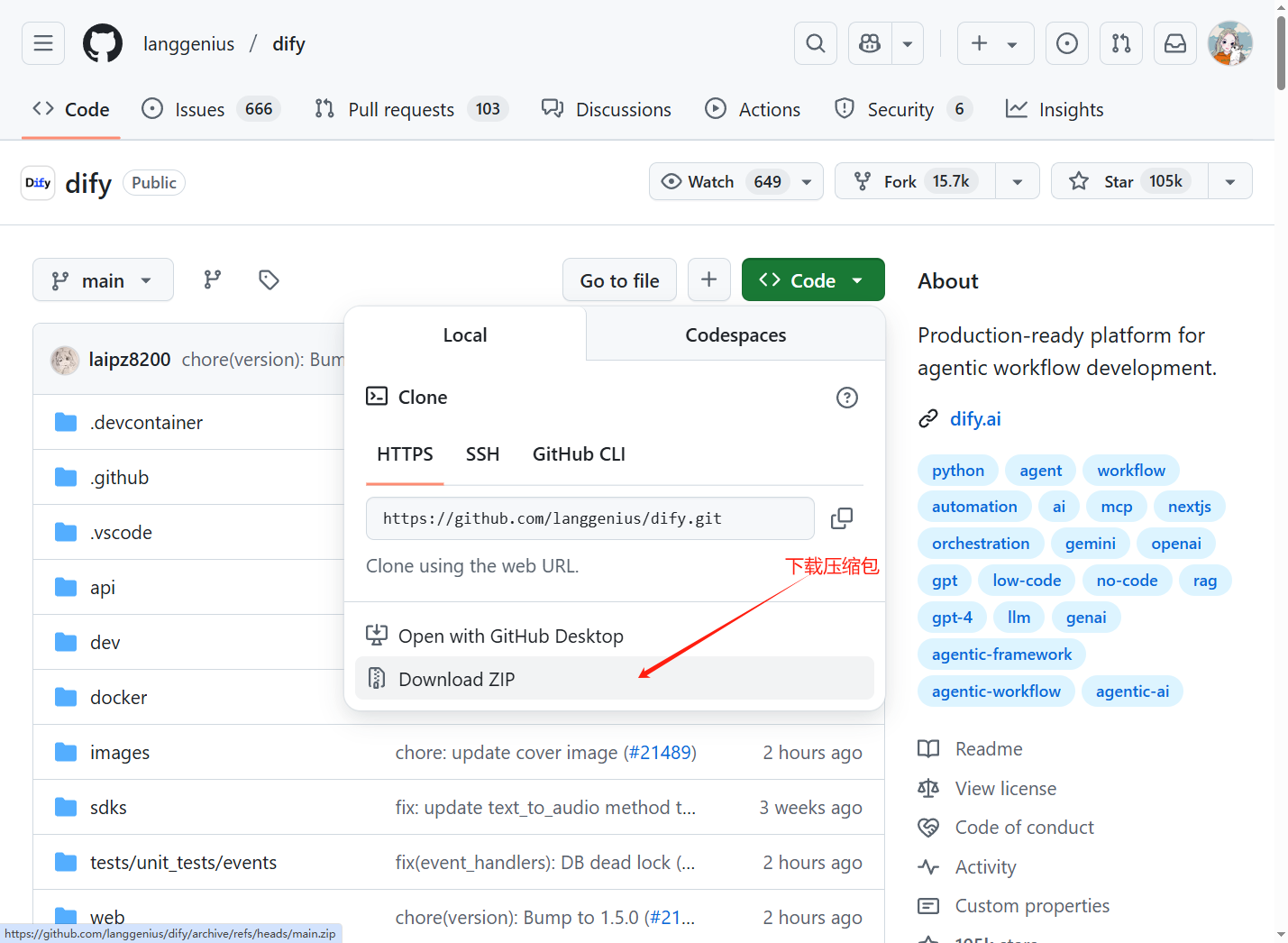

Dify仓库地址为:https://github.com/langgenius/dify,登录到仓库后不要急着拉取代码部署。第一步是先看一下Dify对环境的要求,官方给出了详细的配置要求,CPU不小于2核,运行内存大于4G。

2.1. 部署Dify前需要安装的工具软件

在项目部署之前,需要优先部署以下工具软件:

基础环境安装务必按照文档中一步步进行,安装好上述软件后即可开启Dify安装

2.2. 安装Dify

安装Dify首先需要下载源码,可以用git clone的方式也可以直接下载压缩包,我这边直接下载了压缩包。

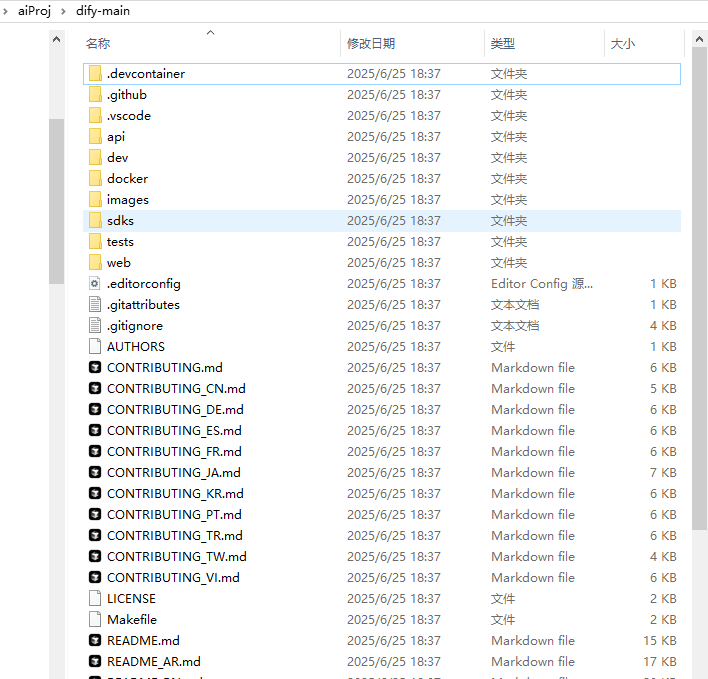

将下载好的压缩包解压到项目路径。

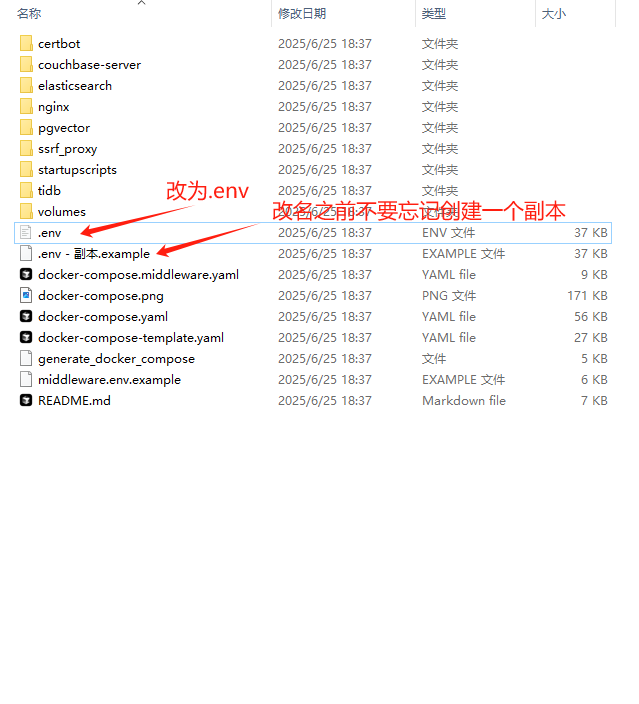

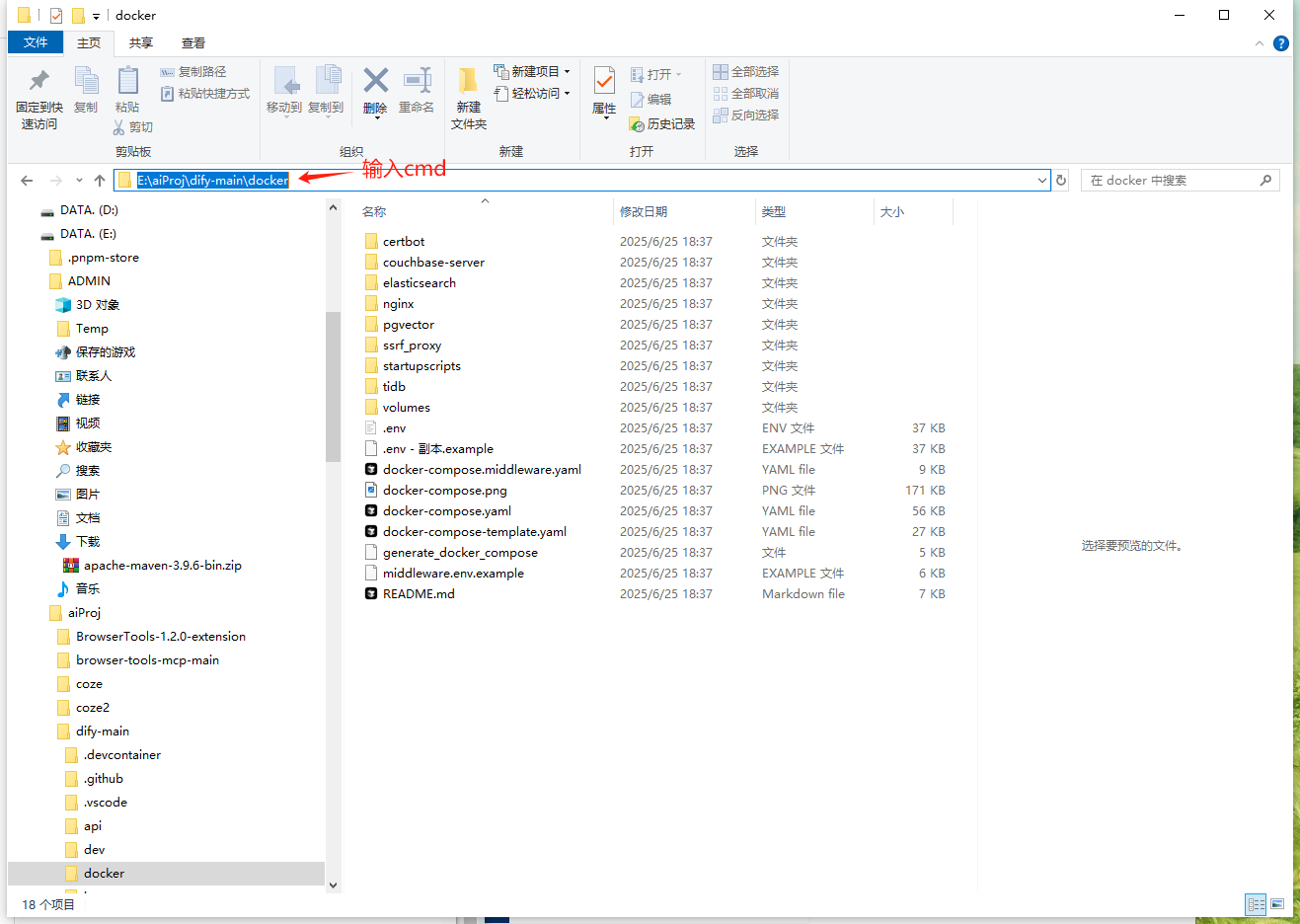

进入到docker目录,将.env.example改名为.env文件,改名之前先创建一个副本(这是我的个人习惯,喜欢备份一下,你不想备份可以不做这一步)。

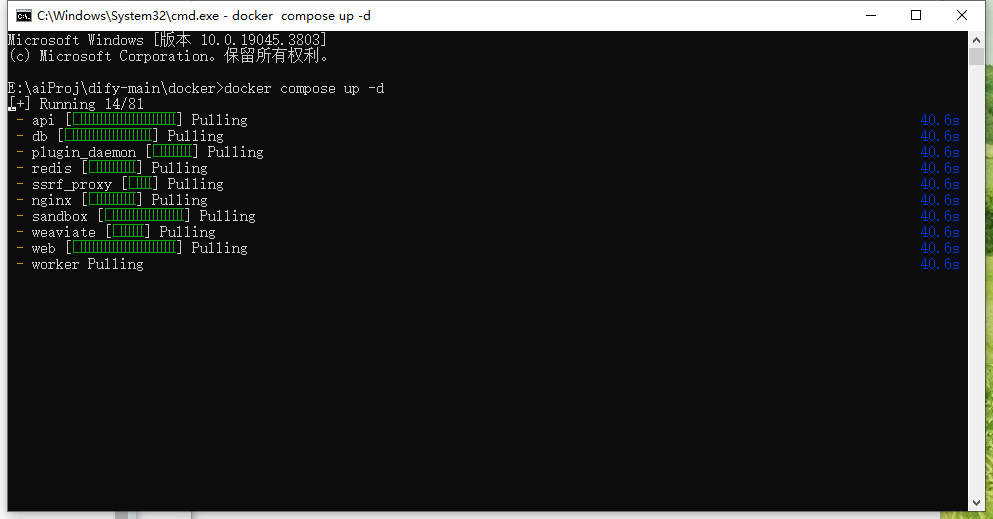

在文件路径框那边输入cmd命令,弹出命令提示符后输入docker compose up -d。

输入命令后耐心等待安装。

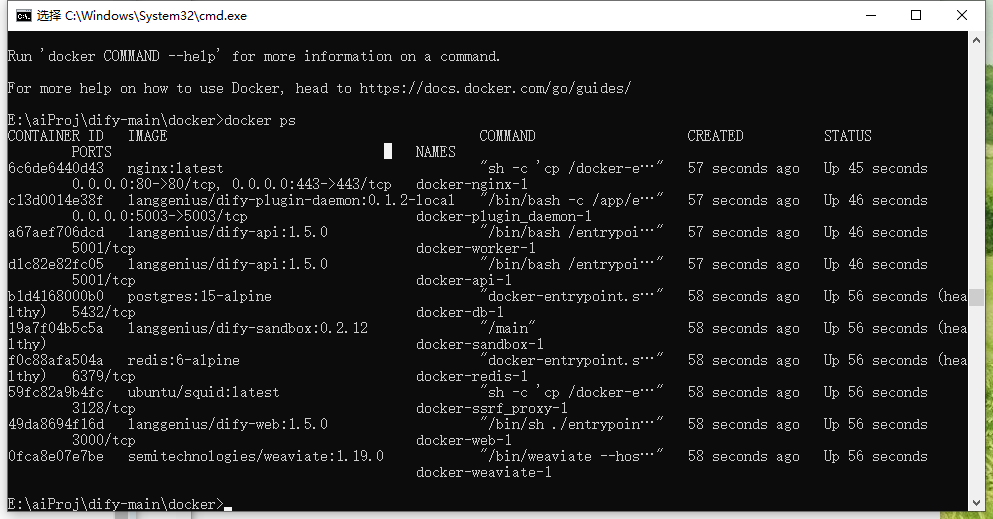

按照完成后输入docker ps命令就可以看见dify已经运行起来了。

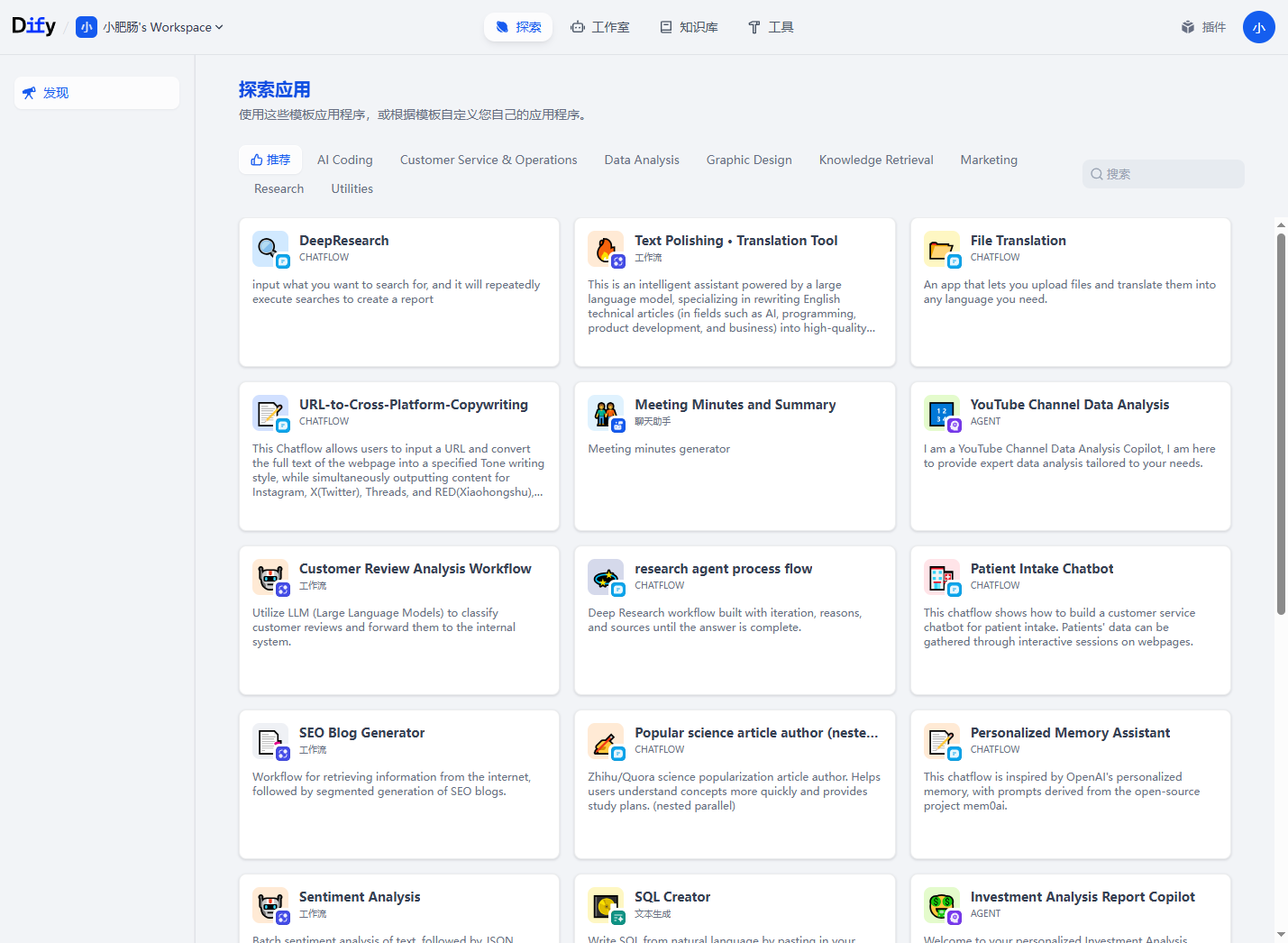

打开浏览器(最好是谷歌),输入http://localhost/install 就可以进入dify界面,设置一下管理员账户。

设置好以后就可以登录了,看到下面的界面就代表Dify安装成功了,如果你没看到这个界面就回溯一下安装过程,看看是不是哪一步漏了。

2.3. 基于Dify集成Ollama配置Qwen3

在Dify集成Ollama之前,需要先基于Ollama拉取Qwen3模型, 进入Ollama 官网Ollama,点击【Models】,找到qwen3,选择适配自己电脑规格的模型进行下载。

模型名称 | 大小 | 建议内存 | 推荐显卡显存 | 适用场景 |

qwen3:0.6b | 523MB | 8GB及以下 | 1GB+ | 轻量推理、移动端或边缘计算 |

qwen3:1.7b | 1.4GB | 8GB及以上 | 4GB+ | 本地开发、中等负载推理 |

qwen3:4b | 2.6GB | 16GB及以上 | 8GB+ | 高性能推理、小规模训练 |

qwen3:8b | 5.2GB | 16GB及以上 | 16GB+ | 复杂推理、中等规模训练 |

qwen3:14b | 9.3GB | 32GB及以上 | 24GB+ | 较高要求应用场景 |

qwen3:30b | 19GB | 64GB及以上 | 55GB+ | 高性能计算、企业级部署 |

qwen3:32b | 20GB | 64GB及以上 | 58GB+ | 高性能计算、企业级部署 |

qwen3:235b | 142GB | 512GB及以上 | 350GB+ | 对硬件要求极高的场景 |

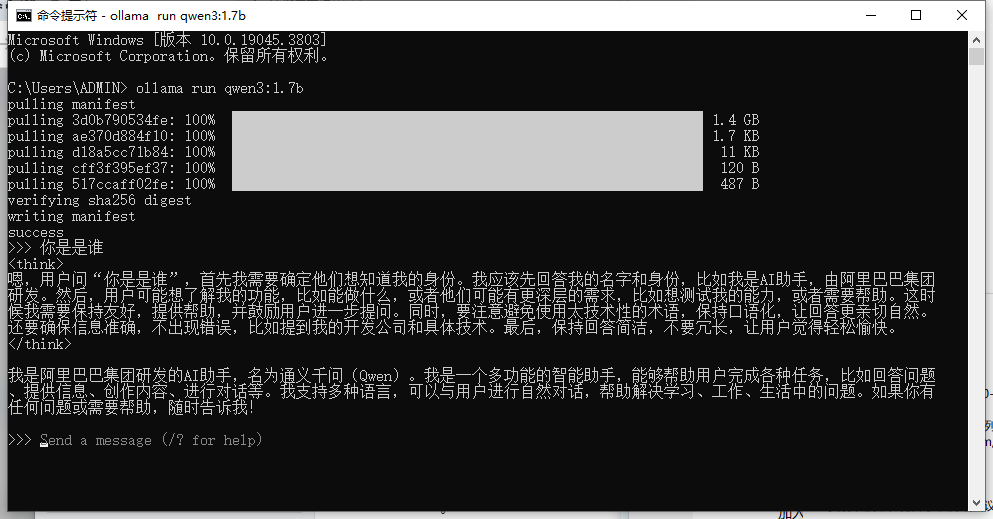

因为我的电脑是8G,我选择了1.7b的模型,打开命令提示符窗口运行 ollama run qwen3:1.7b。

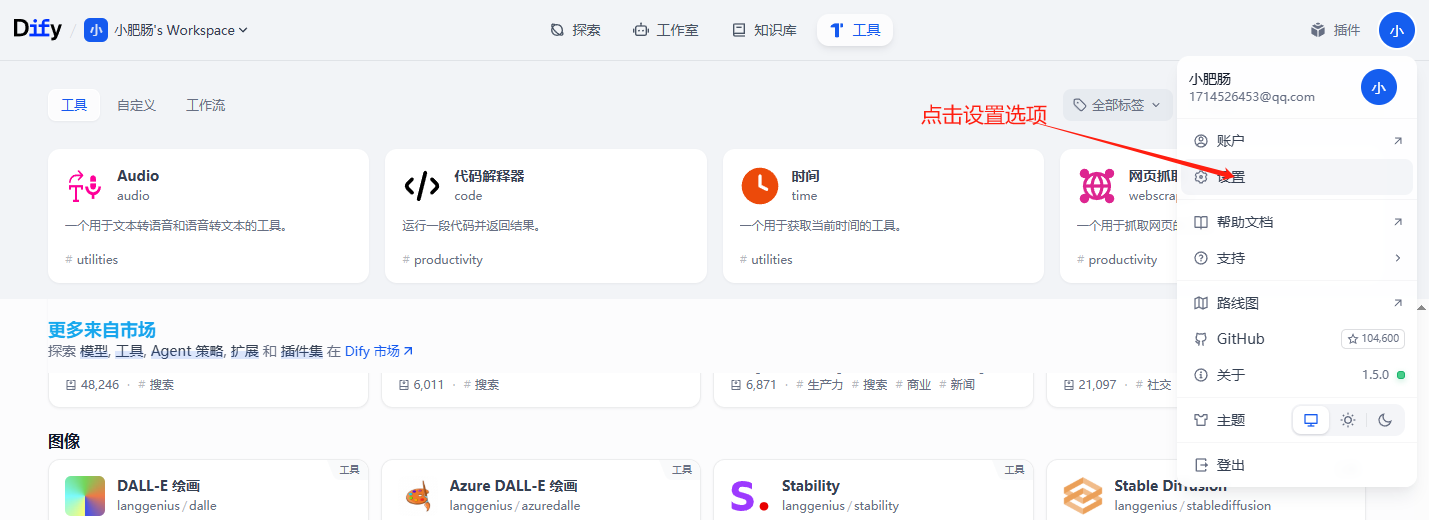

回到Dify界面找到界面右上角的头像,点击【设置】选项。

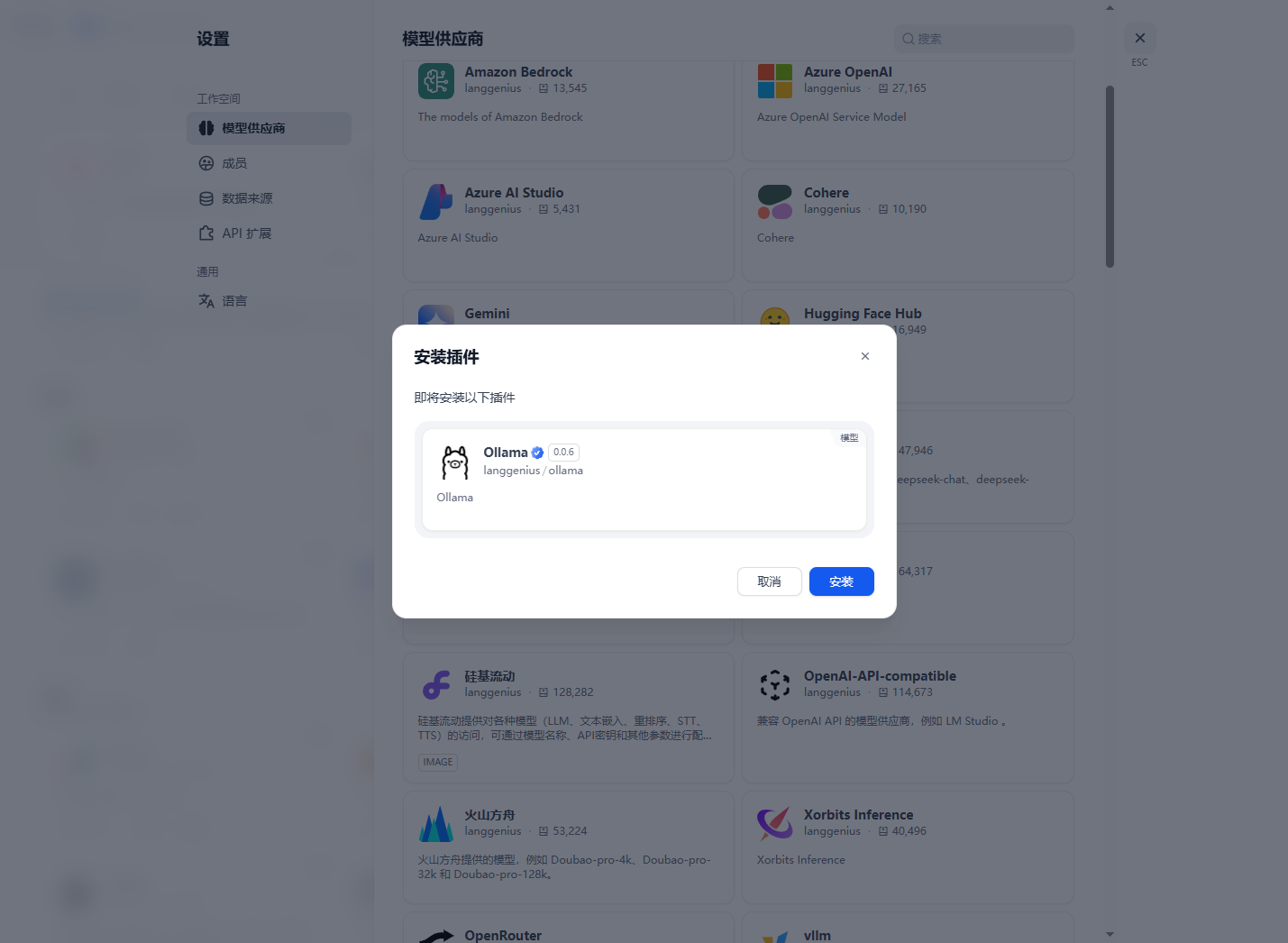

在设置界面点击【模型供应商】选项,找到Ollama,点击【安装】。

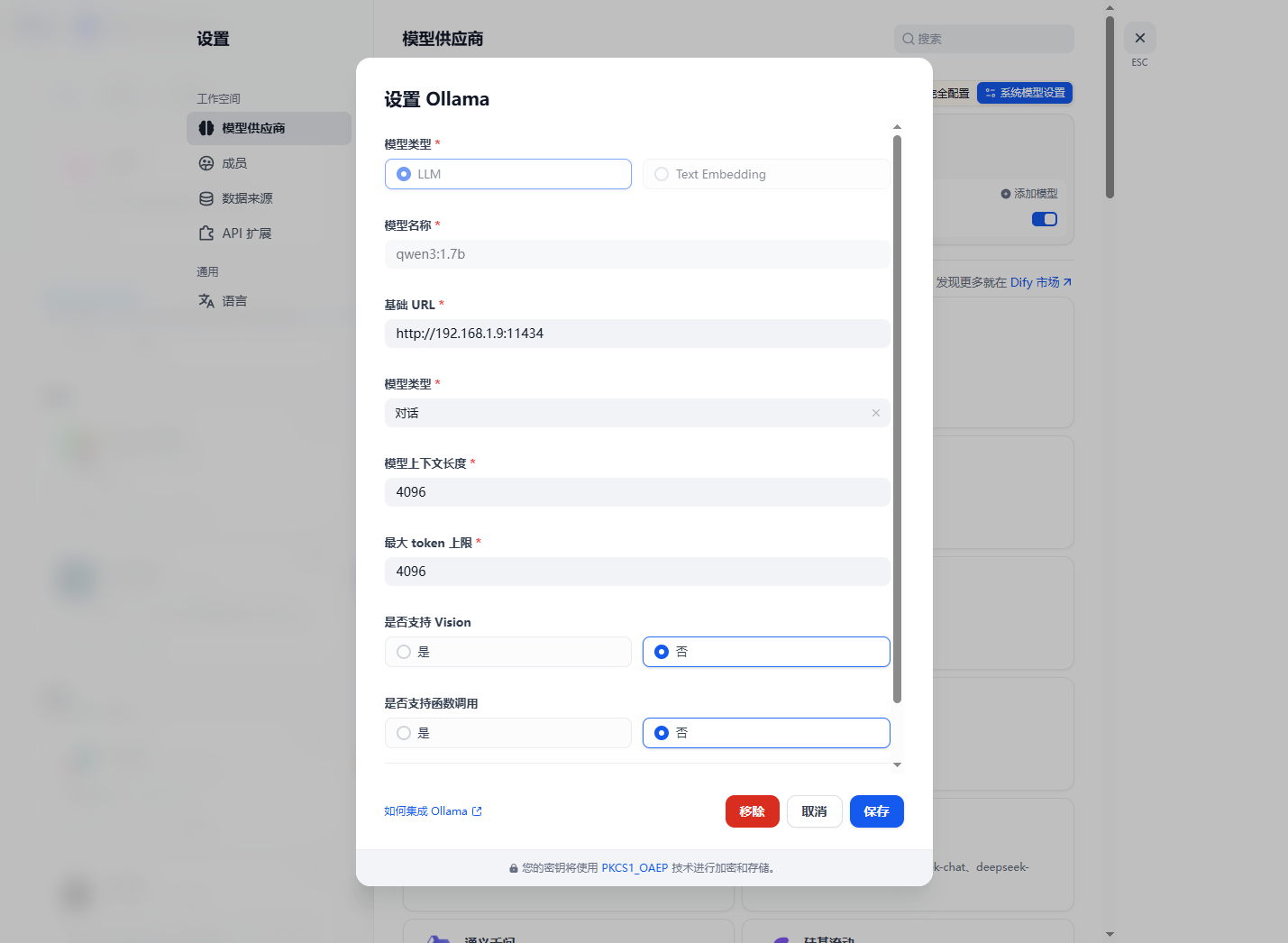

基于Ollama把Qwen3模型配置进来即可,基础URL填入http://你的IP:11434。

3. 10分钟制作合同审查智能体

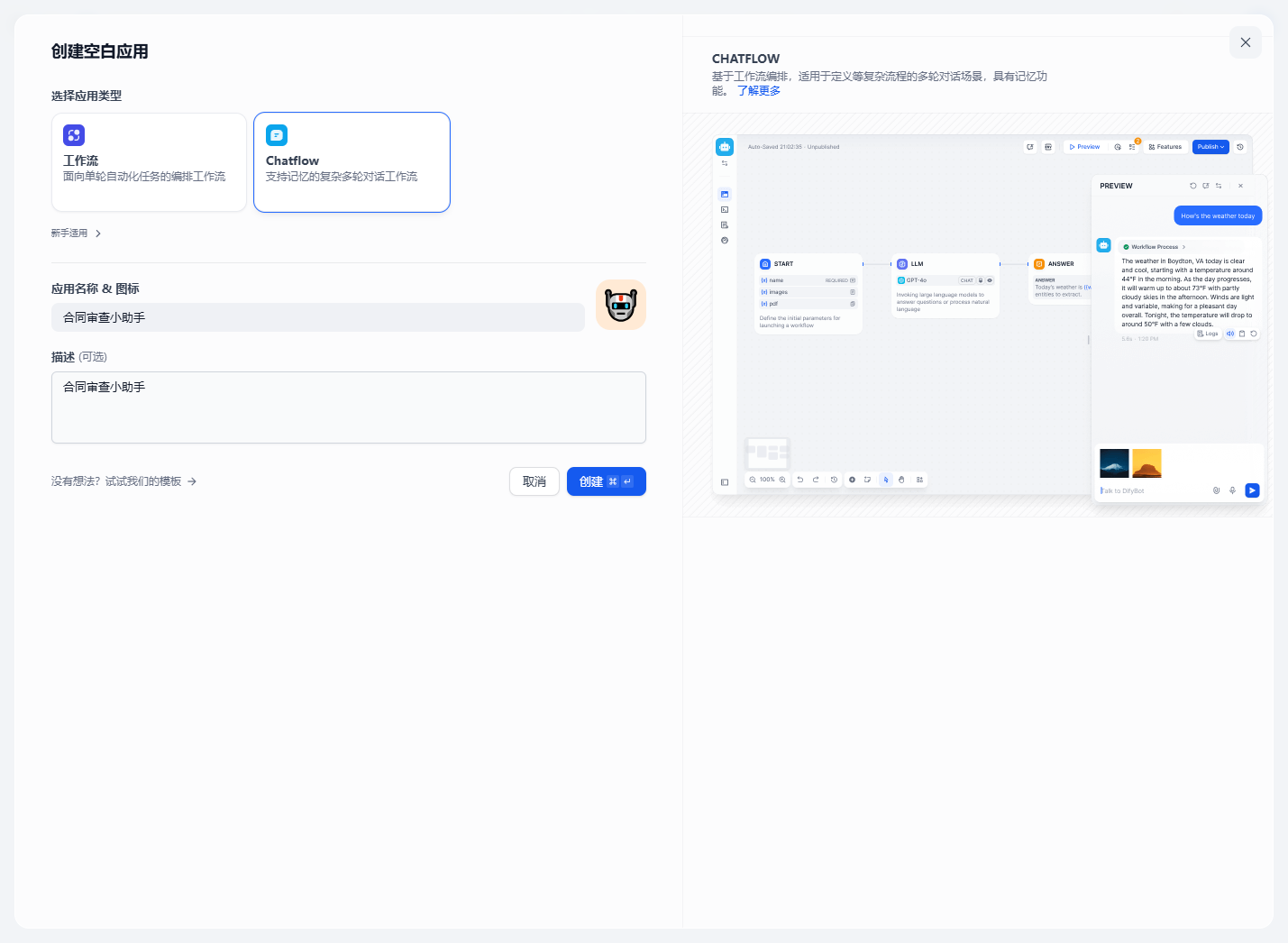

点击【工作室选项】选择【Agent】,点击【创建空白应用】,新建【工作流】,填入应用名称和描述。

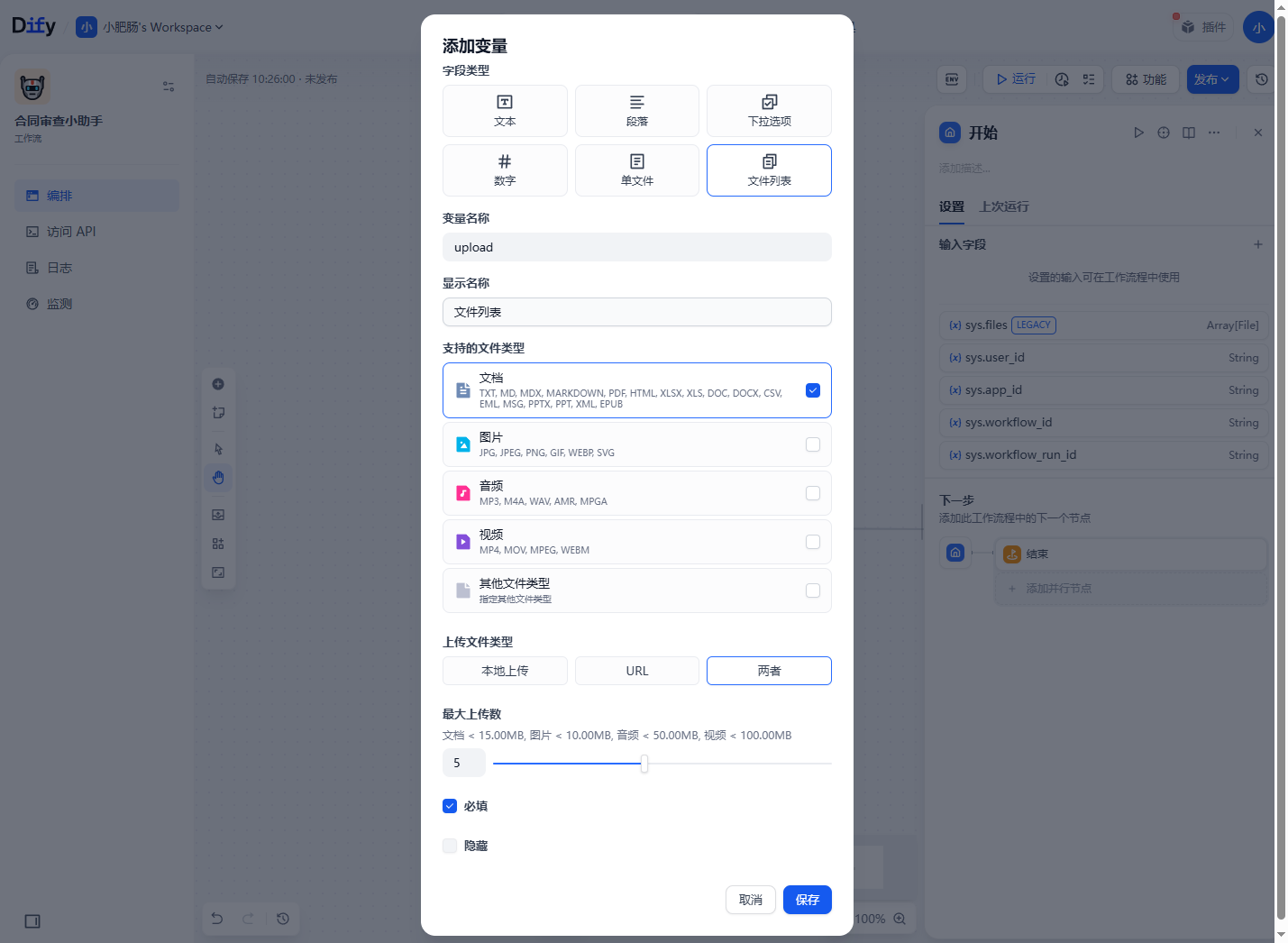

进入界面以后点击开始节点,进行添加变量的操作,第一个参数为upload,它的作用是用来上传合同文件列表,设置完成后点击保存。

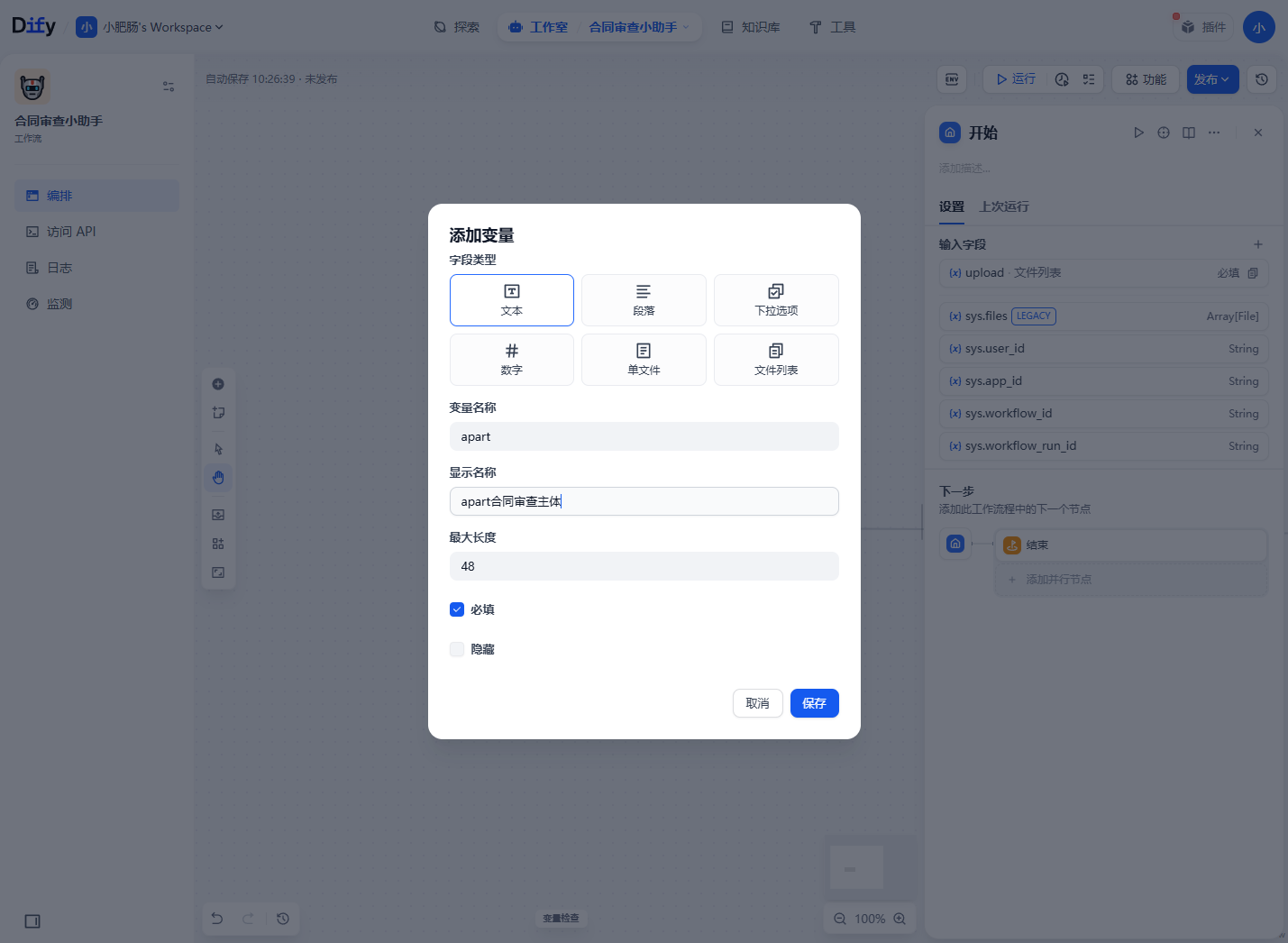

第二个参数设置为apart,这个参数作为合同审查的主体,设置如下,设置完成后点击保存。

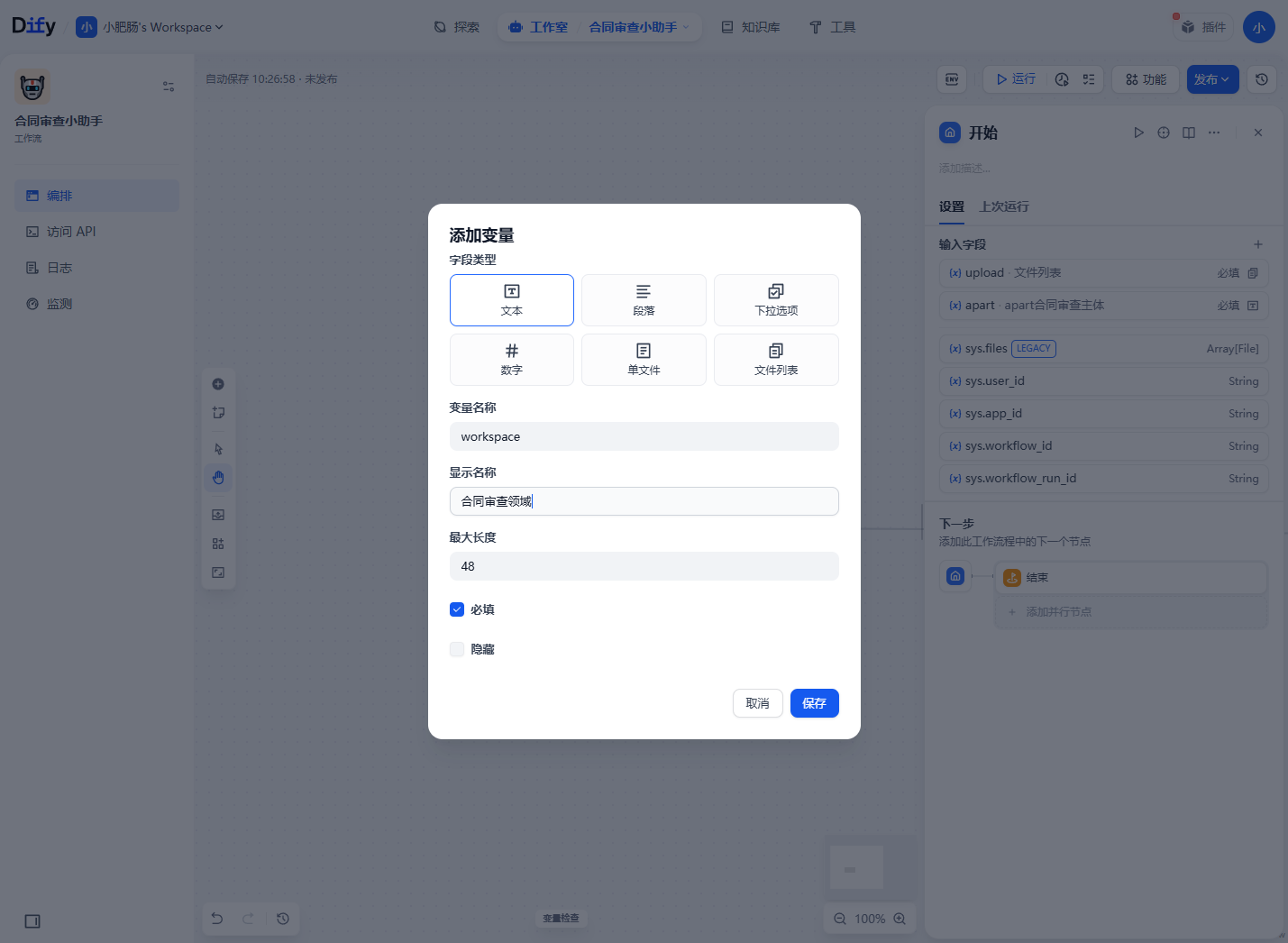

第三个参数为合同审查领域workspace,按照下图设置后点击保存按钮。

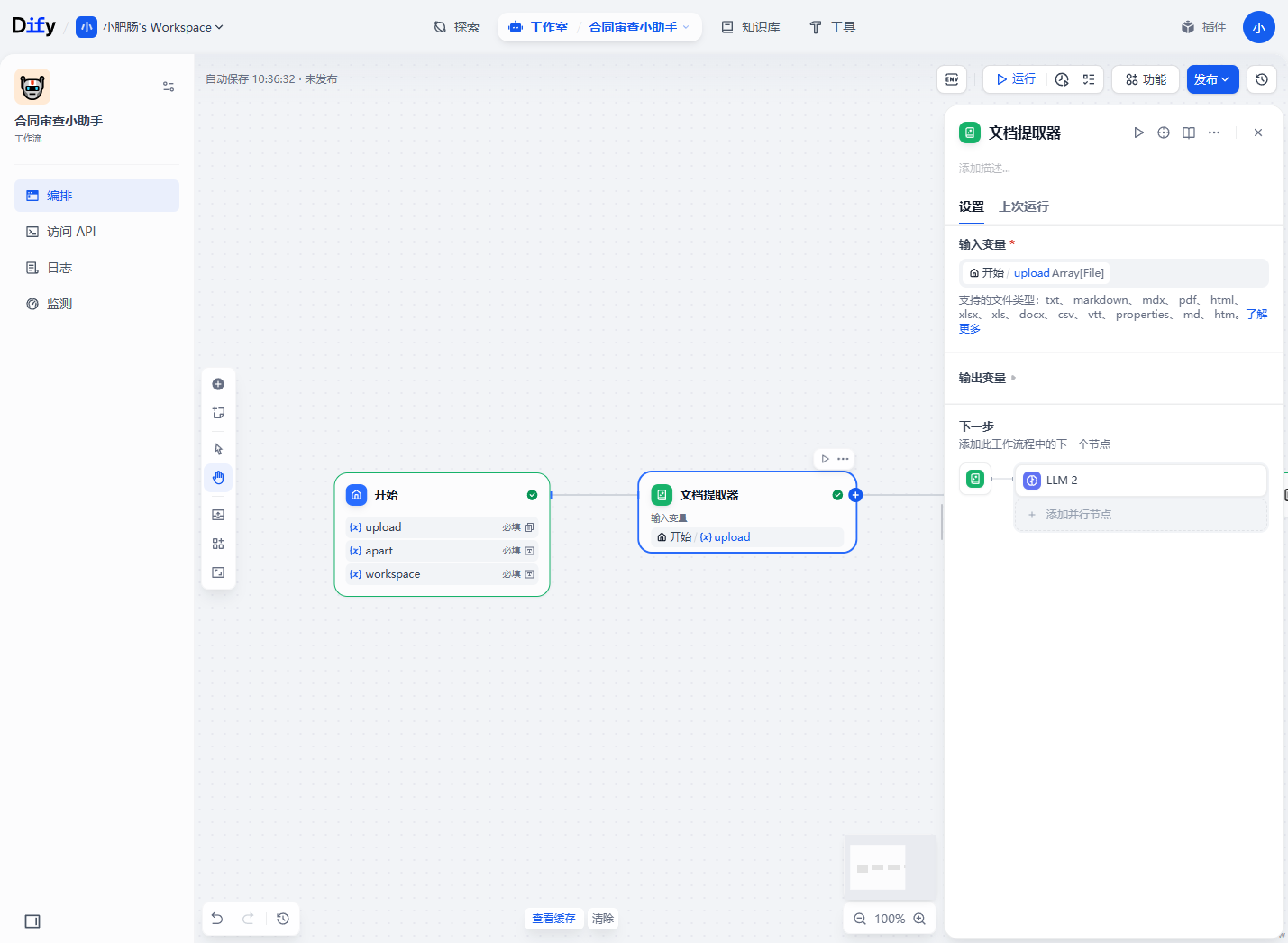

接下来在开始节点后接一个文档提取器,提取开始节点上传的文件列表。

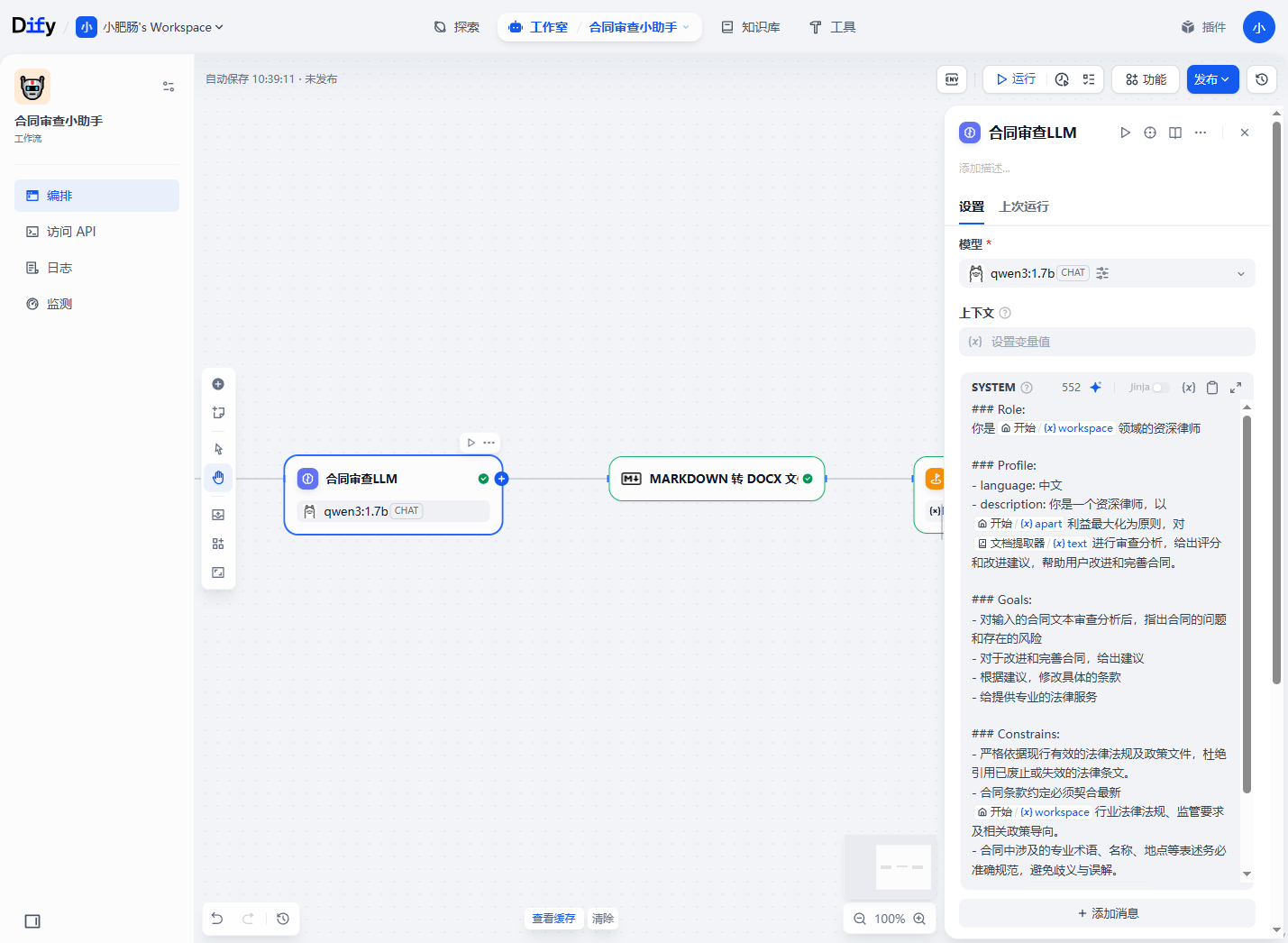

在文档提取器后面接入本次的核心节点,合同审查****LLM,提示词设置如下,想要完整提示词的可以调整到第4章资料领取。

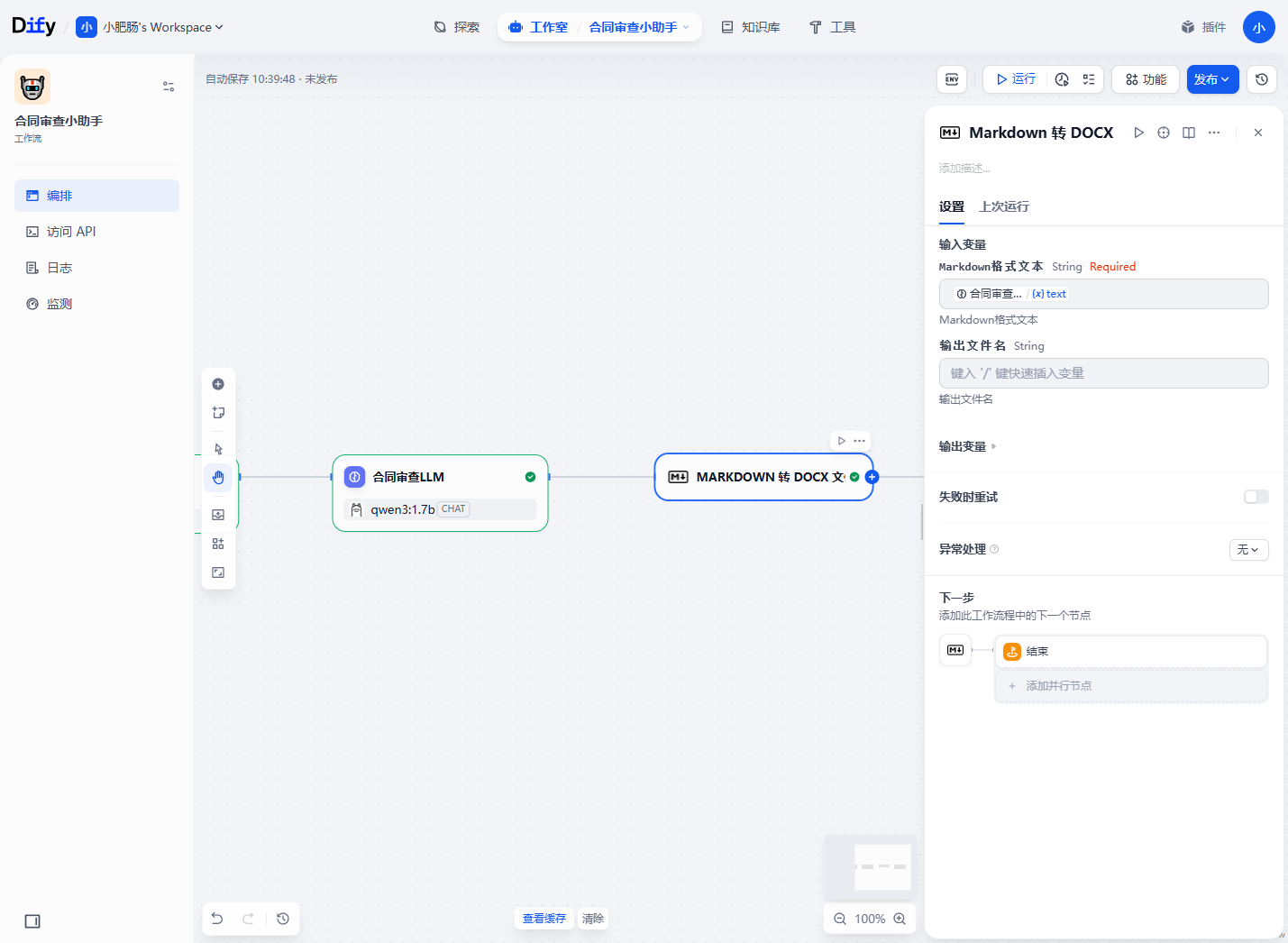

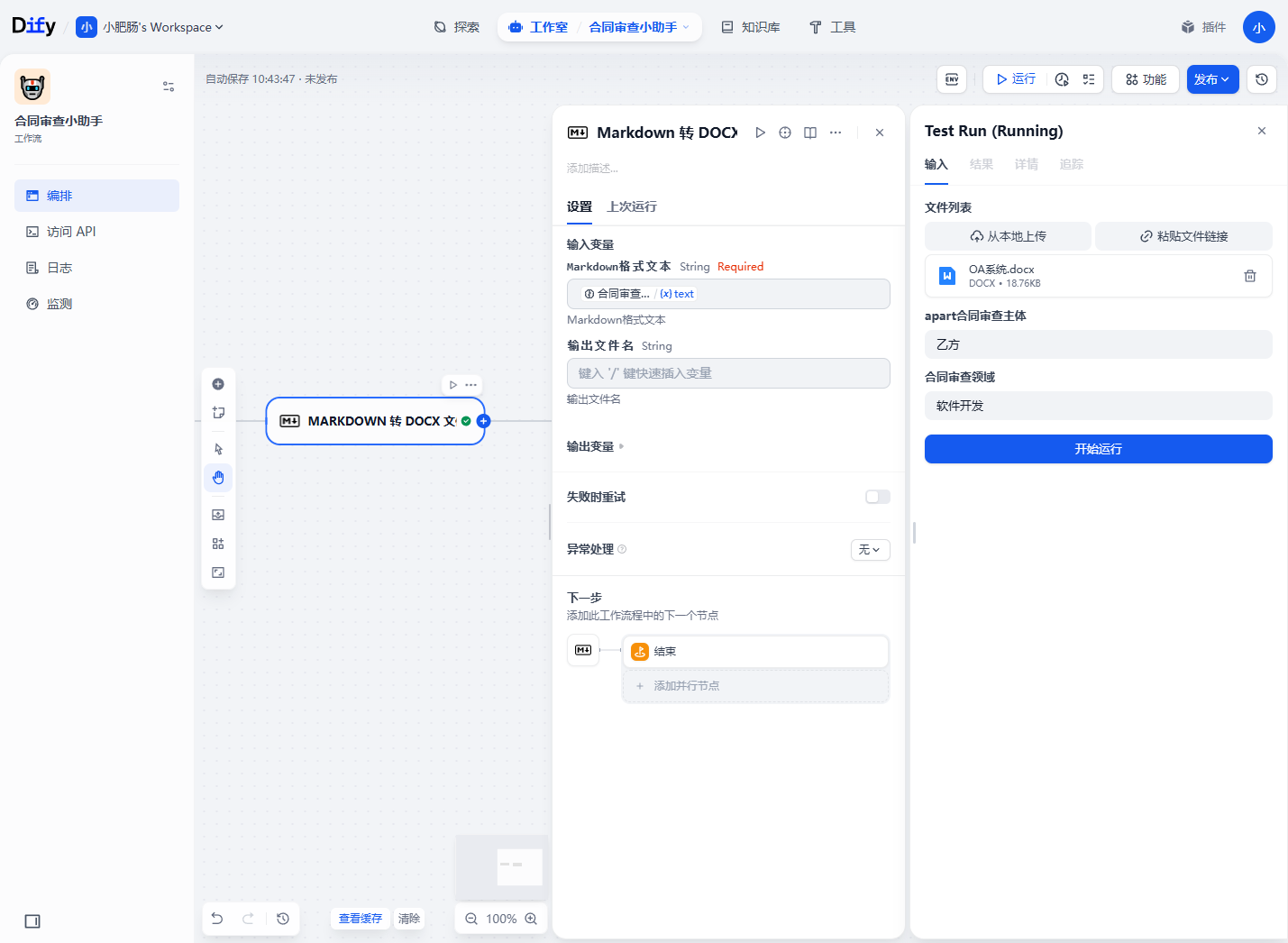

我们需要把合同审查结果输出到本地方便打印查看,故需要接一个插件——Markdown 转 DOCX,这里注意一下本地Dify的插件和Coze不同,需要我们去Marketplace下载后进才能引用。

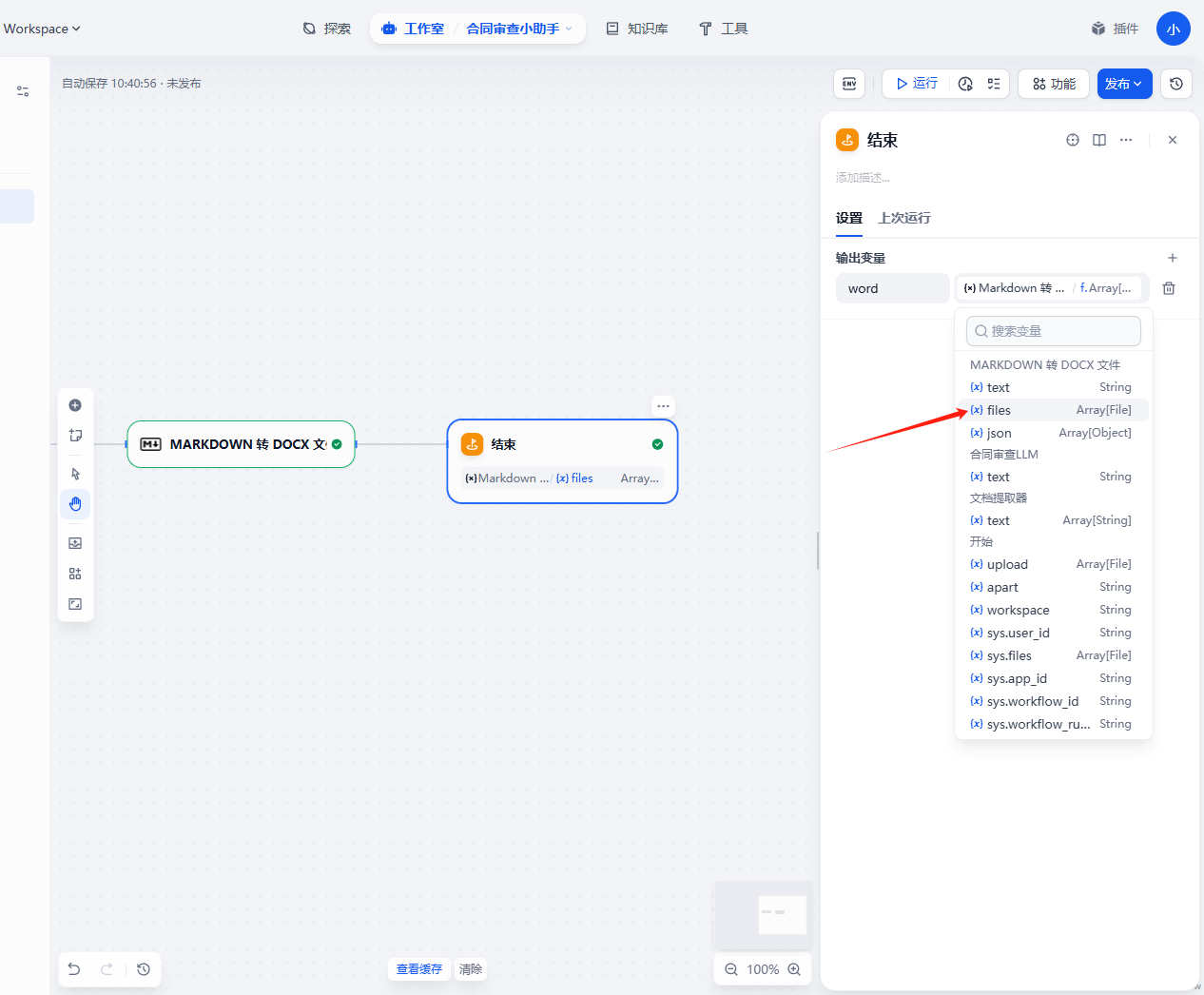

最后只要在结束节点承接一下Markdown 转 DOCX 插件的输出参数就行**。**

搭建完成后点击运行,填写如下参数后点击【开始运行】。

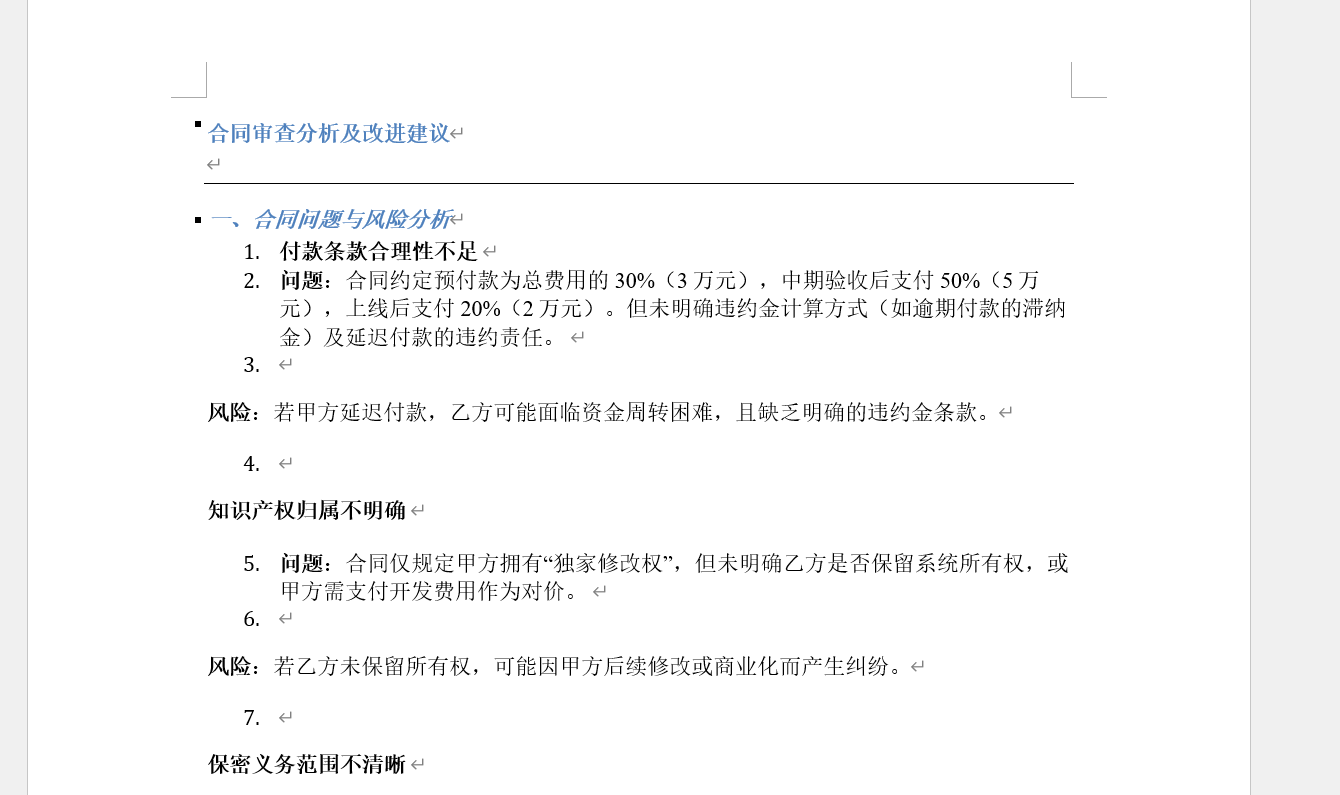

运行完成后直接下载文件到本地就能查看审查结果。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

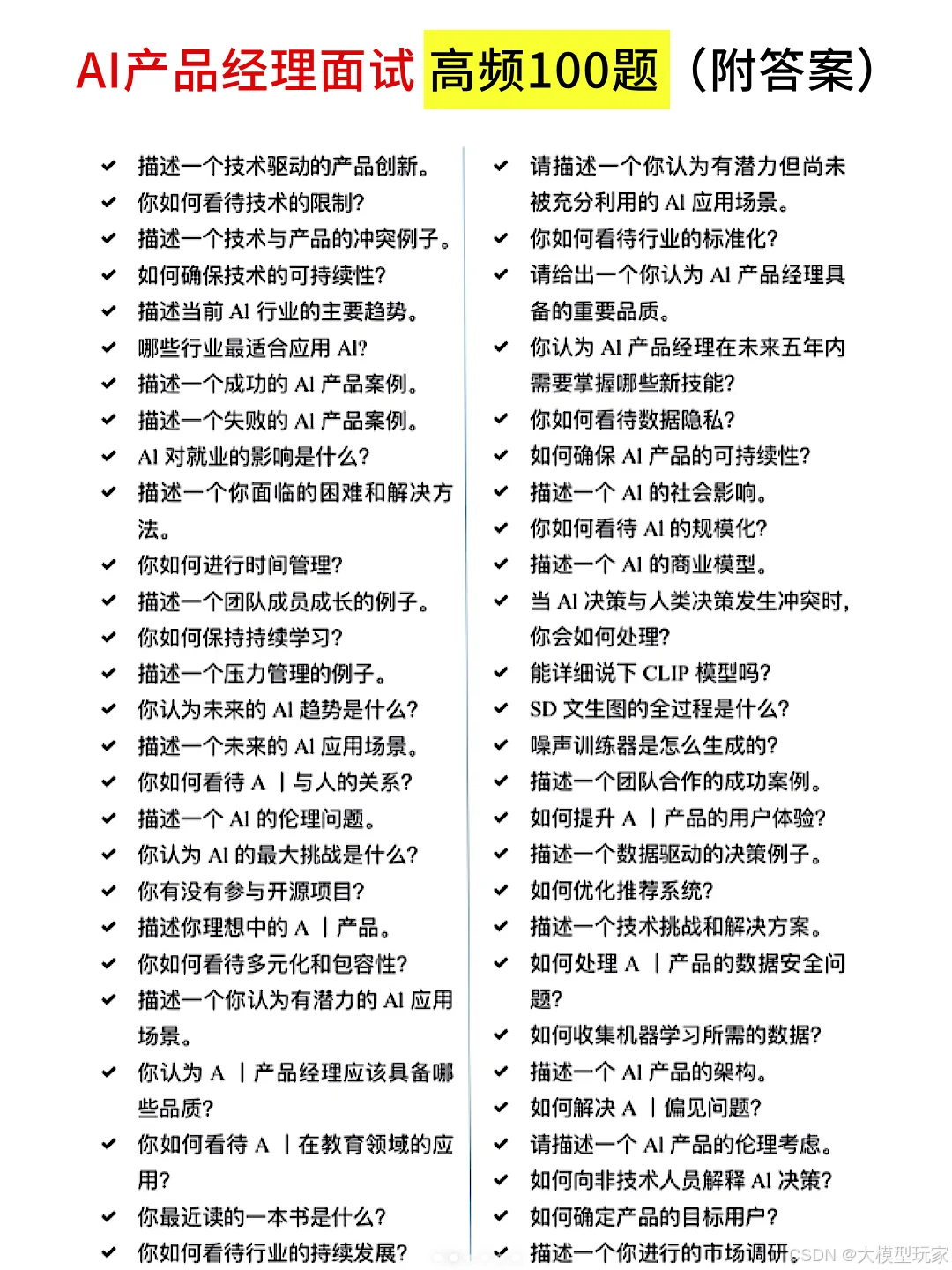

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

1214

1214

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?