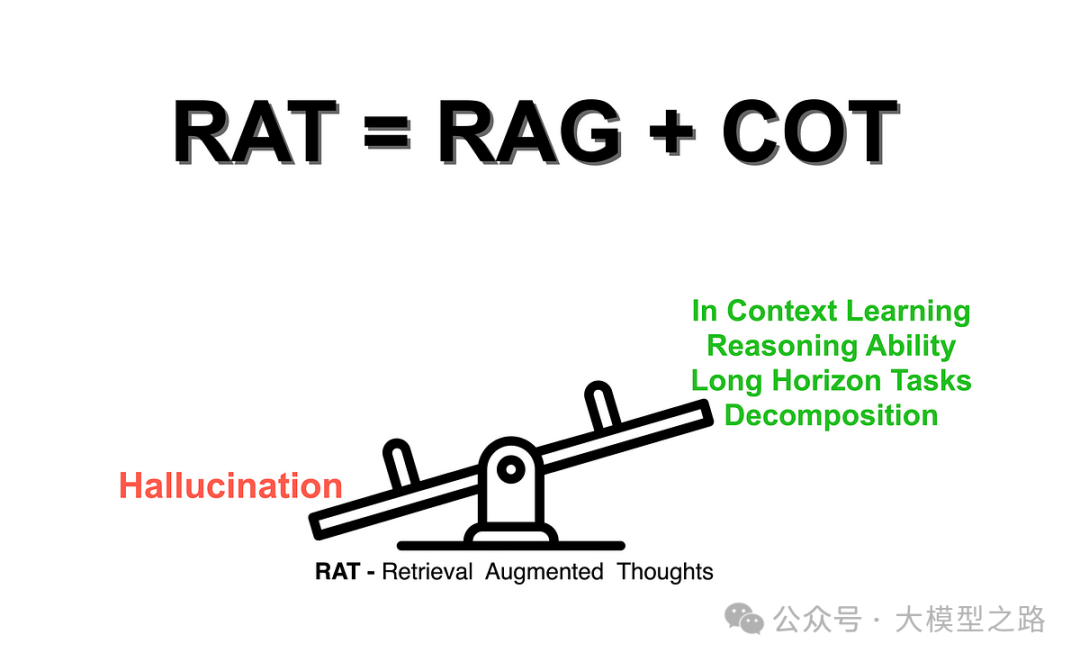

在人工智能领域,大型语言模型(LLMs)已经取得了显著的进展,能够生成类似人类的文本并回答各种问题。然而,它们在推理过程中仍面临一些挑战,例如缺乏对事实的准确把握以及难以处理复杂的多步骤问题。为了解决这些问题,检索增强生成(RAG)和思维链(CoT)提示技术应运而生,而它们的结合(RAG + CoT,即检索增强思想 RAT)更是展现出了强大的优势。

一、RAG:知识的注入器

RAG,即检索增强生成,是一种允许LLMs在推理过程中访问外部信息源的技术。想象一个LLMs正在解决数学问题,RAG就像是一个贴心的辅导老师,能够实时地为LLMs提供所需的公式或定理,确保其每一步推理都基于准确的知识。这样,LLMs就能减少产生幻想性解决方案的风险,其推理过程也因此变得更加坚实可靠。

RAG的工作机制相当直观:当LLMs遇到一个需要特定知识才能解决的问题时,它会利用RAG技术从外部知识库中检索相关信息。这些信息可以是文本、图像、音频等多种形式,关键在于它们能够为LLMs提供解决问题的必要背景知识。通过这种方式,LLMs不仅能够更准确地回答问题,还能在回答中融入更丰富的细节和背景信息,从而提升回答的整体质量([RAG(Retrieval Augmented Generation)及衍生框架:CRAG、Self-RAG与HyDe的深入探讨]。

二、CoT:让思考可视化

与RAG相辅相成的是CoT技术,它旨在帮助LLMs解决那些需要逐步推理的复杂问题。CoT提示鼓励LLMs在给出最终答案之前,先解释其思考过程。这就像在数学课上展示你的计算步骤一样,LLMs需要将其推理过程分解为更小、更易于管理的步骤,并逐一解释这些步骤。

实现CoT提示有两种主要方法:零样本(Zero-shot)提示和少样本(Few-shot)提示([探索 Prompt:从基础概念到高级工程技术。零样本提示通过在提示本身中使用特殊词汇或短语(如“让我们一步一步地思考”)来引导LLMs解释其推理过程。而少样本提示则向LLMs展示几个解决类似问题的例子,这些例子中的解决步骤被清晰地解释出来。LLMs在观察这些例子后,会尝试模仿这种逐步推理的方式来解决问题。

尽管CoT提示在提升LLMs推理能力方面取得了显著成效,但它也面临着一些挑战。例如,如果LLMs对某个主题的知识储备不足,其推理步骤可能会出错。此外,LLMs有时会陷入错误的思维定式,提出与现实不符的解释。这些问题需要通过进一步的优化和训练来解决。

三、RAG 与 CoT 的结合(RAT)

原理与机制

RAT 将 CoT 提示与 RAG 相结合,以处理长期推理和生成问题。首先,LLMs 会生成零次思维链(CoT),然后这些思维链与 RAG 合并。以这些想法为探究对象,对其进行因果修正,并逐渐形成最终的回答。在这个过程中,会迭代地使用信息检索来修正思维链的每一个步骤。这包括任务查询以及在初始零次 CoT 生成之后的当前和过去的思维步骤。

应用场景

在代码生成、数学推理、创意写作和任务规划等多种任务中都展现出了强大的应用能力。例如,在代码生成任务中,RAT 可以帮助程序员更高效地生成准确的代码。通过结合 RAG 从代码库中获取相关的代码片段和知识,以及 CoT 对编程思路的逐步梳理,能够大大提高代码生成的质量和效率。在创意写作方面,RAT 可以从外部知识源获取灵感和素材,同时通过 CoT 对写作思路进行组织和展开,创作出更富有创意和深度的作品。

优势

-

提高准确性

通过允许 LLMs 访问外部知识并完善其推理过程,RAT 有效地减少了错误,生成了更准确的解决方案。例如,在数学推理任务中,对比不使用 RAT 的方法,使用 RAT 后错误率显著降低,答案的准确性得到了大幅提升。 -

增强可解释性

迭代过程中的解释提供了对 LLMs 思维过程的深入了解,使得更容易识别和解决任何可能出现的问题。这对于一些对结果可解释性要求较高的领域,如医疗诊断和金融风险评估等,具有重要意义。 -

强化长期推理能力

对于复杂的多步骤任务,RAT 的优势更加明显。它确保了推理过程的透明性,使得 LLMs 能够更好地处理需要长期推理的任务。比如在任务规划中,从初始目标设定到最终计划的制定,RAT 可以引导 LLMs 逐步进行合理的推理和规划。

四、RAT 面临的挑战

1、信息过载

随着外部数据源的不断增加和丰富,如何高效地检索和处理大量信息成为了一个关键问题。如果不能有效地处理信息过载问题,可能会导致检索效率低下,甚至影响 LLMs 的回答质量。

2、自动思维链生成

目前,CoT 提示往往需要人工干预。开发能够自动生成 CoT 解释的算法对于提高 RAT 的效率和可扩展性至关重要。只有实现了自动生成,才能更广泛地应用 RAT 技术。

3、伦理考虑

随着 LLMs 推理能力的增强,偏见和公平性等伦理问题变得更加突出。例如,在一些涉及社会敏感问题的回答中,如果存在偏见,可能会引发社会争议。因此,研究如何减轻偏见并确保 RAT 的负责任发展是必不可少的。

五、RAT 的未来发展方向

1、个性化学习

想象一下,配备了 RAT 的 LLMs 成为智能导师,能够根据学生的理解程度逐步解释概念,并调整解释方式。这种个性化的学习方式有可能彻底改变教育模式,提高学习效果。

2、科学发现加速

RAT 赋能的 LLMs 可以与科学家合作,提出假设并通过实验进行推理,从而有可能加速科学发现的进程。在一些复杂的科学研究领域,如药物研发和宇宙探索等,RAT 可以提供更多的思路和方法。

3、可解释人工智能(XAI)的推进

RAT 为可解释人工智能铺平了道路,使得 LLMs 不仅能够生成解决方案,还能解释其思维过程。这将增强人类对人工智能的信任,促进人机之间的更好合作。

检索增强生成(RAG)和思维链(CoT)提示技术的结合(RAT)为 AI 推理能力的提升带来了新的机遇和突破。尽管它面临着一些挑战,但它在提高准确性、增强可解释性和强化长期推理能力等方面的优势不可忽视。

如何学习AI大模型?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

想正式转到一些新兴的 AI 行业,不仅需要系统的学习AI大模型。同时也要跟已有的技能结合,辅助编程提效,或上手实操应用,增加自己的职场竞争力。

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高

那么针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉[CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)]()👈

学习路线

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

429

429

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?