人工智能技术的不断发展,多模态大模型作为一种新型的机器学习技术,逐渐成为人工智能领域的热点话题。多模态大模型能够处理多种媒体数据,如文本、图像、音频和视频等,并通过学习不同模态之间的关联,实现更加智能化的信息处理。

一、基本概念

多模态大模型是一种基于深度学习的机器学习技术,其核心思想是将不同媒体数据(如文本、图像、音频和视频等)进行融合,通过学习不同模态之间的关联,实现更加智能化的信息处理。在多模态大模型中,不同模态的数据经过预处理后被输入到一个深度神经网络中,经过多层的特征提取和融合,最终输出相应的结果。

多模态大模型的优点在于能够充分利用不同媒体数据的信息,提取出更加丰富、全面的特征,从而提高模型的性能和泛化能力。此外,多模态大模型还可以通过学习不同模态之间的关联,进一步增强模型的语义理解和表达能力。

二、应用场景

多模态大模型在许多领域都有广泛的应用,下面介绍几个典型的应用场景:

1. 自然语言处理

多模态大模型在自然语言处理领域的应用主要表现在跨媒体理解和生成方面。通过将文本和图像等多模态数据输入到模型中,可以完成诸如文本与图像的跨模态检索、文本与视频的语义对齐等任务。同时,多模态大模型还可以用于生成具有视觉效果的文本描述,如给定一张图片,输出一段描述其内容的文字。

2. 计算机视觉

多模态大模型在计算机视觉领域的应用主要表现在跨媒体分析和跨媒体生成方面。通过将文本、图像和视频等多模态数据输入到模型中,可以完成诸如文本与图像的关联分析、视频语义分割等任务。同时,多模态大模型还可以用于生成具有语义信息的图像或视频,如根据一段文字描述生成相应的图片或视频。

3. 多媒体处理

多模态大模型在多媒体处理领域的应用主要表现在跨媒体理解和跨媒体生成方面。通过将音频、视频和文本等多模态数据输入到模型中,可以完成诸如音频与视频的跨模态检索、音频与文本的语义对齐等任务。同时,多模态大模型还可以用于生成具有多媒体特征的文本或视频,如根据一段音频描述生成相应的文字或视频。

三、发展趋势

随着多模态大模型的不断发展,其应用场景也将越来越广泛。未来,多模态大模型的发展将呈现出以下几个趋势:

1. 数据规模不断扩大

随着数据规模的扩大,多模态大模型的性能和泛化能力将得到进一步提升。未来,将会有更多的数据集被用于训练多模态大模型,从而使其更好地适应各种实际应用场景。

2. 模型结构不断创新

随着深度学习技术的不断发展,多模态大模型的架构和算法也将不断创新。未来,将会有更多的新型神经网络结构被应用于多模态大模型中,从而使其更好地处理不同媒体数据之间的关联和转换。

浅析多模态大模型的前世今生

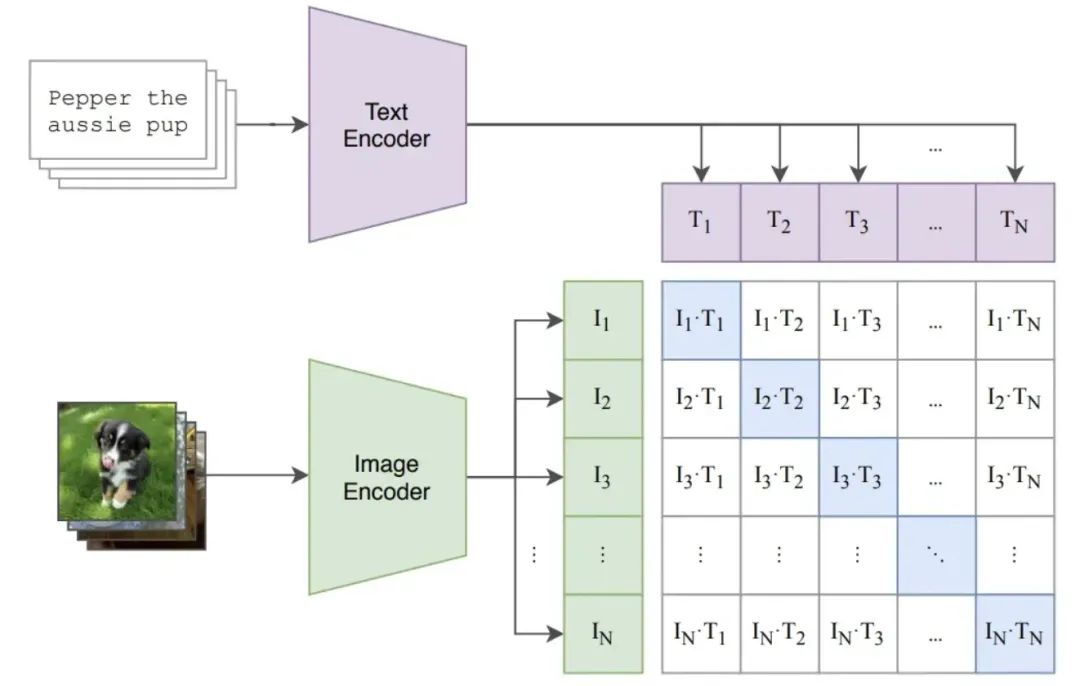

CLIP 是由 OpenAI 在 2021 年提出的预训练模型,用于评估给定图像与给定文本描述的匹配程度。该模型使用大量(约 4 亿)从网页中爬取的图像-文本对(pair)数据进行对比学习。

数据的收集:

-

搜索了 50w 个 queries(query 列表主要来自英文版维基百科中至少出现 100 次的所有单词,并做了些其他补充)

-

为了保证每个 query 的数据相对平衡,每个 query 保留最多 2w 个(image, text)

典型的双塔模型,有两个 encoder,一个对应图片,一个对应文本,图像和文本经过各自的 encoder 后,通过简单的点乘来代表不同模态的交互(相似性)。

文章的主要贡献有两个:

-

ALBEF 解决了多模态领域中图像和文本对齐、交互的问题。在 ALBEF 之前,多模态方法通常使用 transformer 的多模态编码器来同时编码视觉和文本特征,由于目标检测器是提前训练好的,因此视觉和文本特征并不是对齐的。图像和文本特征可能距离很远,这使得多模态编码器难以学习到它们之间的交互。为了解决这个问题,ALBEF 通过一个对比损失(也就是 CLIP 中的 ITC 损失)在进行多模态交互之前对齐图像和文本数据。

-

网上爬取的大量图文对通常噪声很大(图文不匹配)。ALBEF 采用动量蒸馏(momentum distillation)的自训练方法来从网络图文对数据中学习,以缓解原始数据中的噪声问题。从理论上讲,ALBEF 通过互信息最大化的角度解释了不同的多模态任务,说明不同任务实际上为图文对提供了不同的视角,类似于数据增强,使得训练得到的多模态模型能够理解不同模态下的语义,具备语义保持的能力。

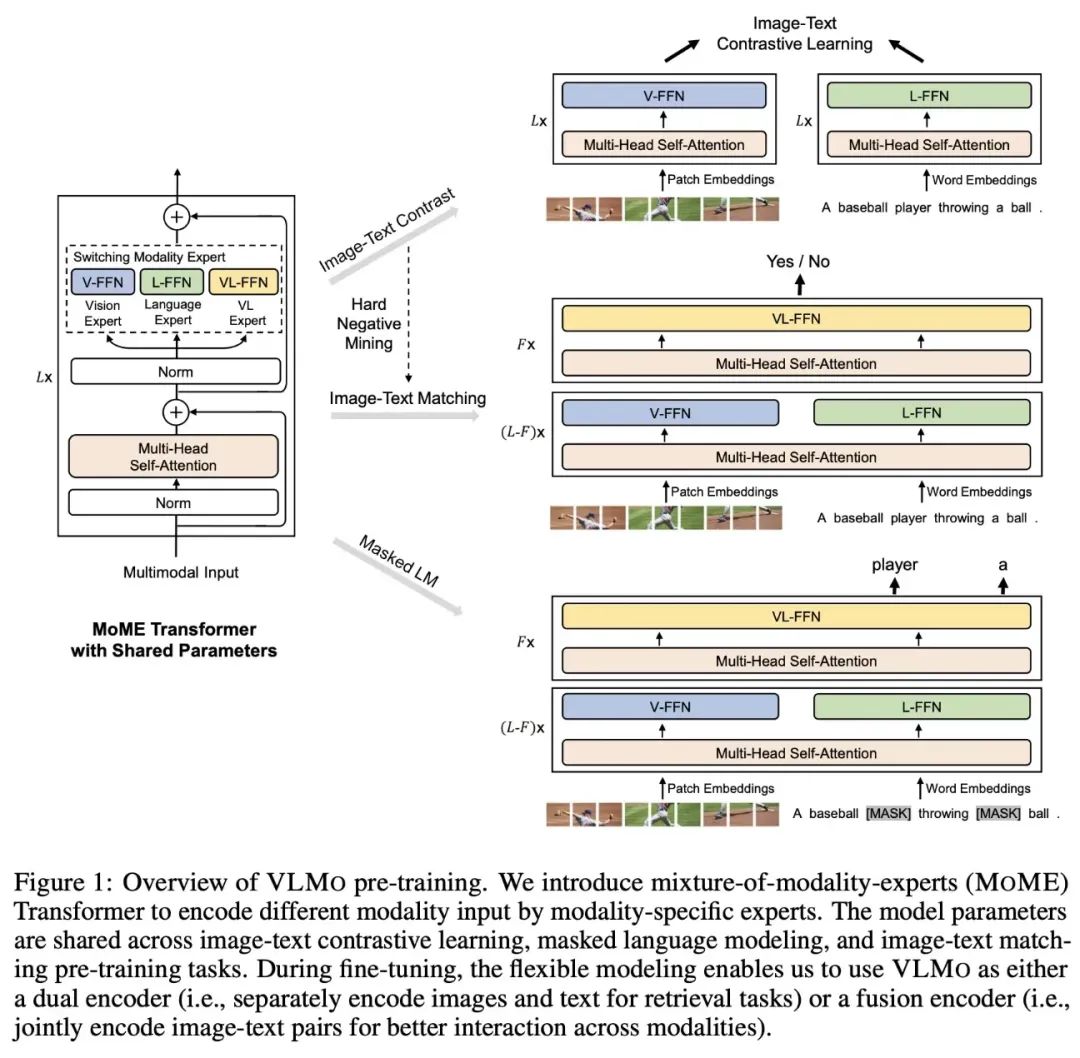

VLMo 模型通过使用混合模态专家(MoME)Transformer 实现了统一的视觉-语言预训练。MoME Transformer 的结构设计允许根据输入信号的不同使用对应的 FFN 层参数进行计算。具体来说,VLMo 模型包括了视觉专家(V-FFN)、文本专家(L-FFN)和图文专家(VL-FFN),它们分别用于处理图像、文本和图像-文本输入。这种灵活的设计使得VLMo 模型能够根据任务的不同使用不同的结构进行训练和推理。

文章的研究动机:

-

现有的预训练模型通常在理解型任务或生成型任务中表现出色,但很少有模型能够同时在这两种任务上达到优秀的性能。

-

现有的性能改进主要是通过扩大数据集规模并使用从网络收集的带有噪声的图像-文本对进行训练实现的。然而,网络数据集中的噪声会对模型的性能产生负面影响。

主要的贡献:

-

统一了图像-语言的理解与生成任务

-

Bootstrap 的方式清洗网络噪声数据

在模型的设计上结合了 ALBEF 和 VLMo,看下图中红色框中就类似 ALBEF,只是画 image-grounded text encoder 的位置不同;蓝色框中类似 VLMo,虽然有三个模型,但是大部分参数都是共享的。

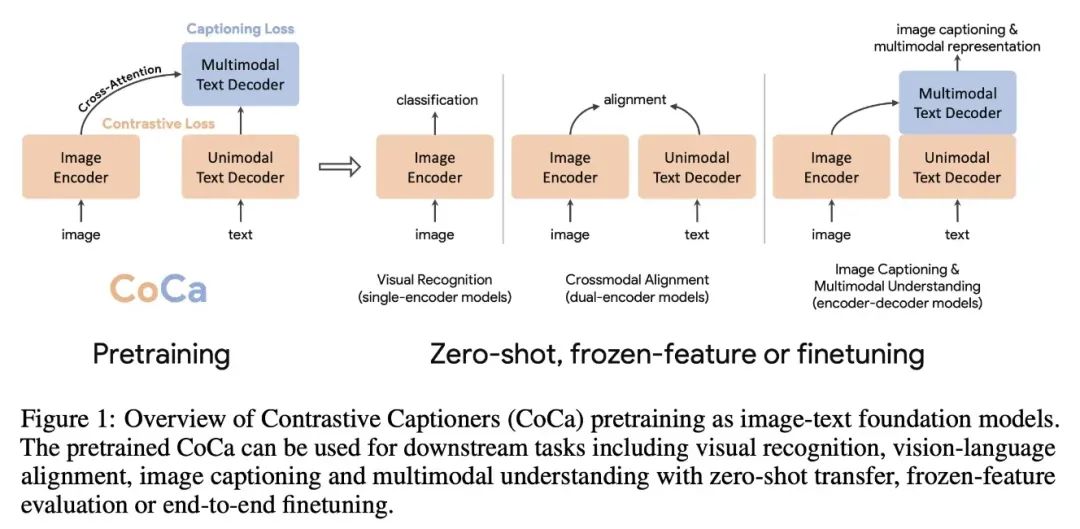

CoCa 将解决图像或多模态问题的模型概括成 3 种经典结构,分别是 single-encoder model、dual-encoder model、encoder-decoder model。Single-encoder model 指的是基础的图像分类模型,dual-encoder model 指的是类似 CLIP 的双塔图文匹配模型,encoder-decoder model 指的是用于看图说话任务的生成式模型。

BEITv3 的主要想法就是希望统一多模态学习中的模型结构、预训练任务以及模型规模。为此将图片也看作一种语言(Imglish),图像文本对看作是 parallel sentences。在输入形式统一之后,也就不需要 ITC、ITM、MLM、WPA 等其他目标函数,而是可以使用统一的 masked “language” modeling 的方式进行训练。

BEITv3 的模型结构使用的是 Multiway Transformer (其实就是前面 VLMo 的 MoME),因此也就具备了之前提到的灵活性的特点,可以适用于非常多的下游任务。

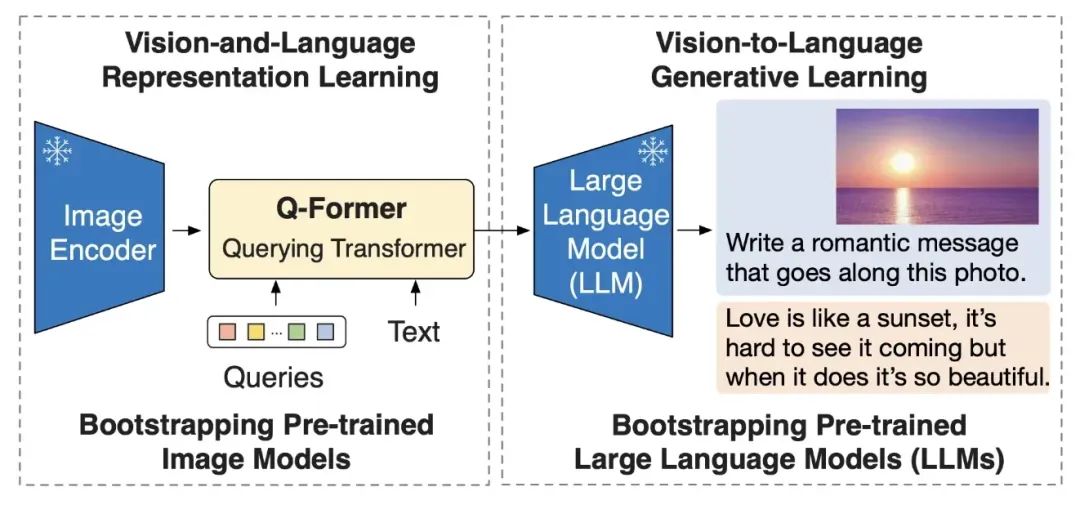

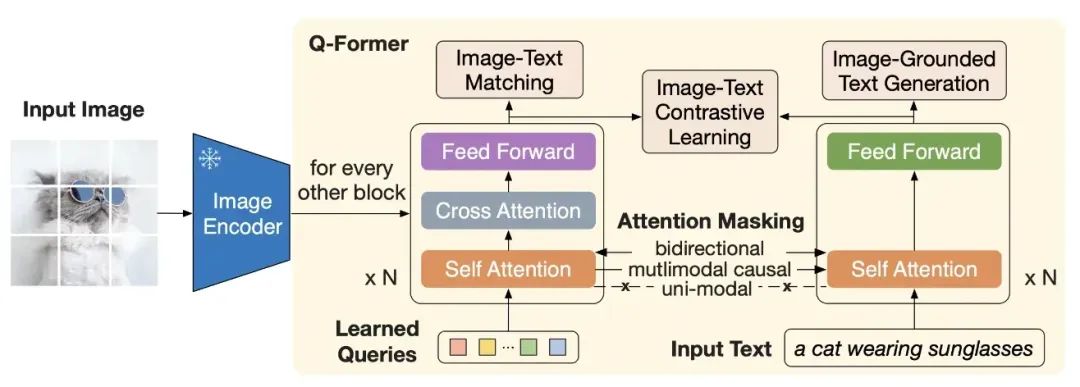

BLIP-2 通过在冻结的预训练图像编码器和冻结的预训练大语言模型之间添加一个轻量级 查询 Transformer (Query Transformer, Q-Former) 来弥合视觉和语言模型之间的模态隔阂。在整个模型中,Q-Former 是唯一的可训练模块,而图像编码器和语言模型始终保持冻结状态。

Q-Former 由两个子模块组成,这两个子模块共享相同的自注意力层:

-

与冻结的图像编码器交互的图像 transformer,用于视觉特征提取

-

文本 transformer,用作文本编码器和解码器

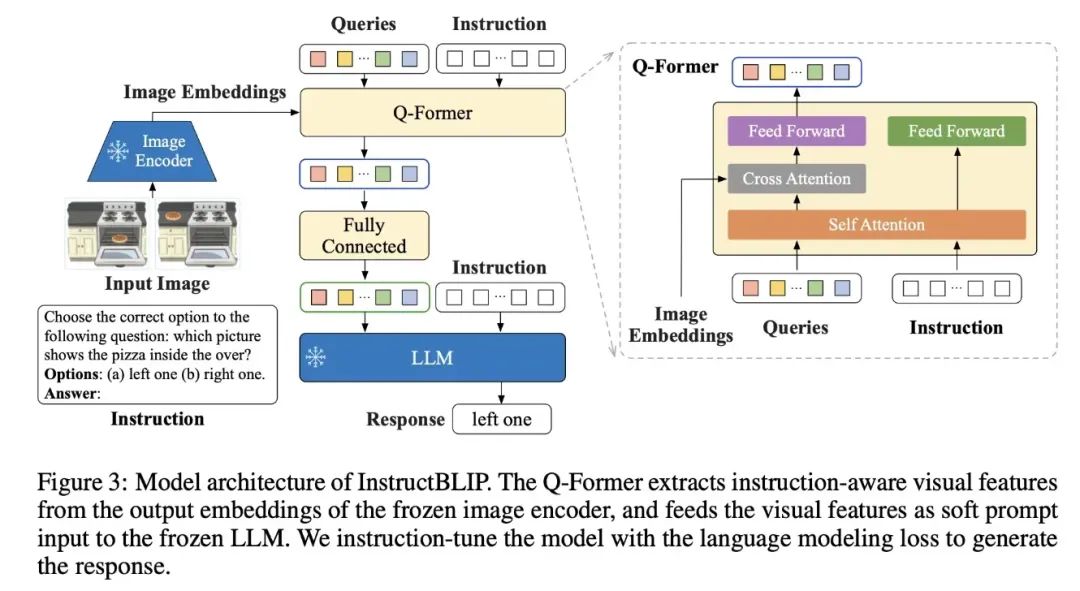

InstructBLIP 可以理解为是 BLIP2 + 指令微调

-

作者们收集了 26 数据集并转化指令微调的格式

-

并改进 BLIP2 中的 Query Transformer 为 指令感知的 Query Transformer,能够抽取和给定指令相关的信息

InstructBLIP 的模型结构如下所示:

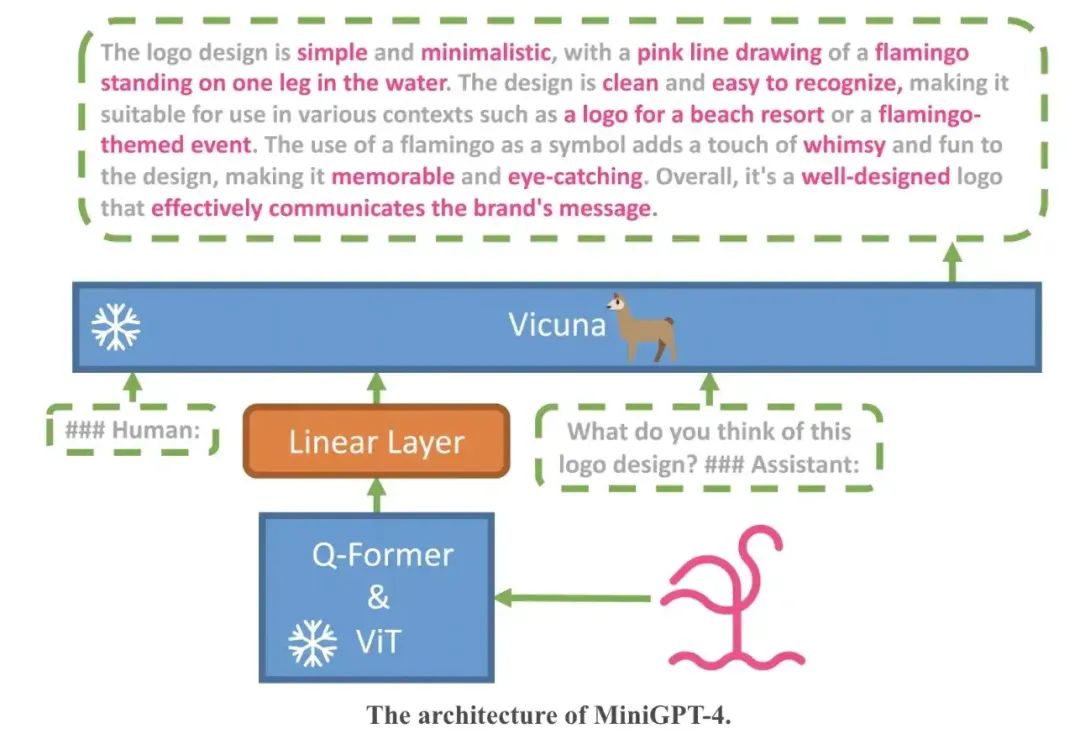

对于 GPT4 能够具有超强的图文理解能力,作者们的理解是这是得益于大语言模型的能力,因此考虑将最新的一些能跟 ChatGPT “媲美”的语言模型引入其中,这里采用了 Vicuna 作为语言模型,在视觉理解上,作者采用了和 BLIP2 里面一样的视觉模块,包含一个 ViT 模块和一个 Q-Former 模块。模型的整体框架如下所示,我们从下往上看:首先一张图片会经过视觉模块(ViT&Q-Former)进行编码得到一个图像 embedding,由于视觉模块给出的 embedding 不能够直接被语言模型理解,因此一般需要将视觉 embedding 和文本 embedding 进行对齐,这里加入了一个线性层,可以理解为这里假设图片编码器得到的输出经过一个线性层后就能够被语言模型理解了,然后将原始的文本信息和经过对齐后的图像信息拼接起来,送入 LLM,就可以实现能够接受多模态信息的 GPT 了。

之前的工作大多是考虑的是多模态理解(看图说话),最近刚提出的 MiniGPT-5 则想着直接多模态同时生成(同时生成文本和图片)。

图片生成的话用 Stable Diffusion 来做是个比较常规的操作了,简单回忆下 Stable Diffusion 怎么做的,其实就是一个 Unet 接收加噪的图片、时间步长、以及文本的 token embedding 来进行生成,这里的文本编码器来自于 CLIP,那多模态发展得风风火火,把这里的文本编码器换成新一点的模型是不是可行?

- GPT-4V:远远领先!

openai 还是保持着 closeai 的风格,关于 GPT-4V 的模型以及训练相关的细节并没有公布,只有一份微软的测评论文,从结果上来看是远远领先。

看完两个模态的多模态工作,我们再来看看如何扩展到更多的模态

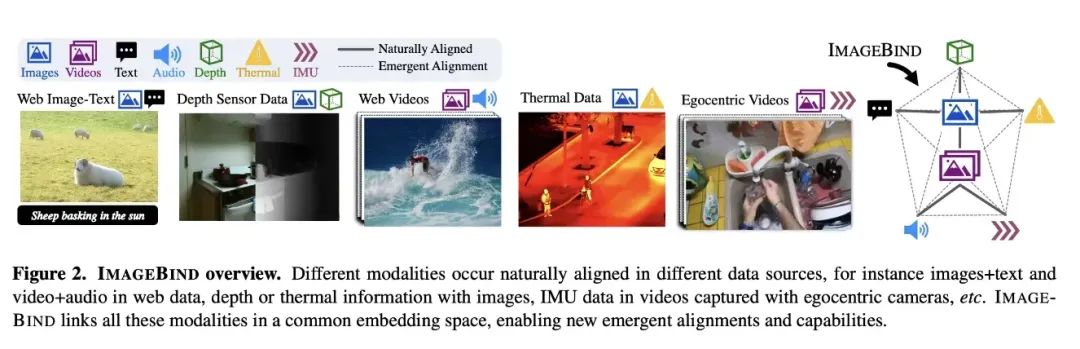

ImageBind:更多模态一起对齐

ImageBind 的目标是将不同模态的 embedding 对齐到一个公共的空间,可以理解为是 CLIP 的多模态版本。

文章的主要思想是通过图片作为桥梁来将不同模态的数据关联起来。

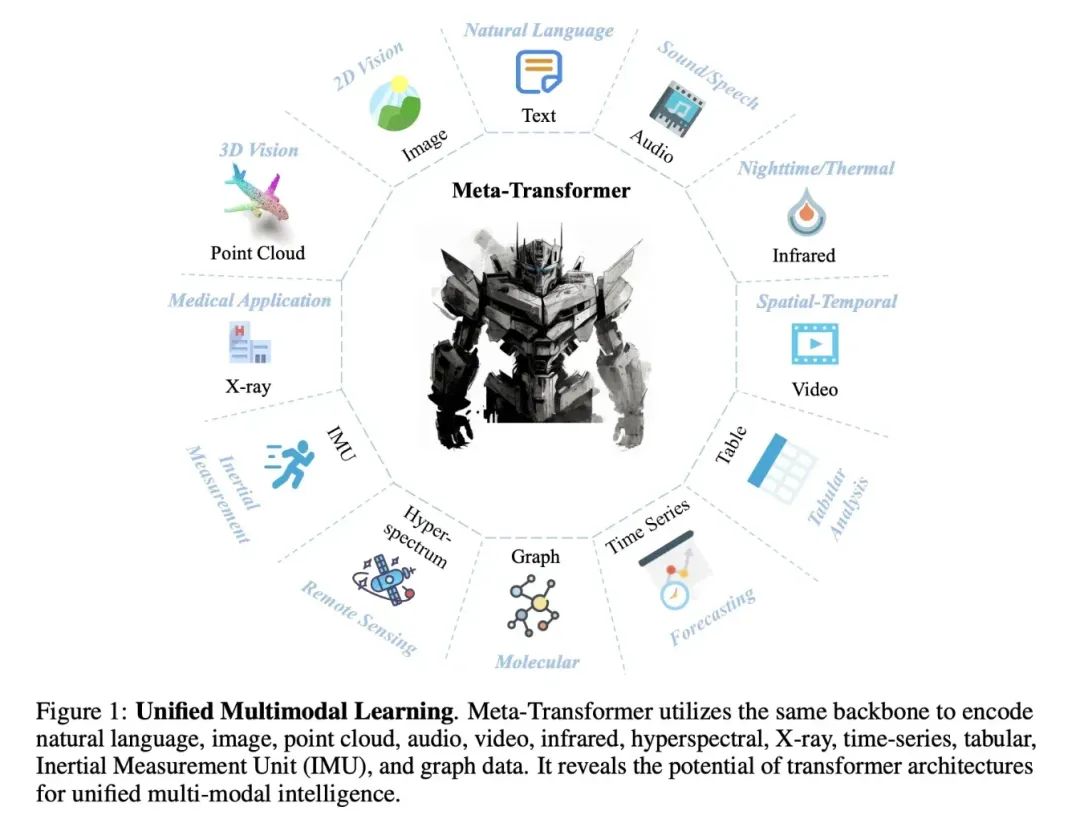

Meta-Transformer 野心就比较大了,同时考虑了 12 种模态。

它的主要思想是使用一个统一的框架来处理来自多种模态的数据,而无需为每种模态设计特定的模型或网络。通过将所有模态的数据映射到一个共享的 embedding 空间,并使用一个公共的编码器来提取特征。

-

统一的 Tokenization:通过设计特定的 Tokenization 策略,例如将图像分割成小块或将文本分割成词或子词,然后为每个块或词生成一个 token。这些 token 然后被映射到一个连续的向量空间,形成 token embedding;

-

模态共享的编码器:使用一个预训练的 Transformer 编码器,它的参数是冻结的。这个编码器可以处理来自不同模态的 token embedding(因为它们都在同一个共享的流形空间内);

-

任务特定的头部:这些头部通常由多层感知机(MLP)组成,并根据不同的模态和任务进行调整。

总结

看了这些多模态的研究后,多模态的研究做的事情主要是:

-

不同模态进行对齐

-

不同模态进行融合

-

指令微调促进人机交互,数据的质量可能比数量更重要

-

模型设计既要保证检索任务下的高效推理,又要能够进行多模态深度融合

-

进入大语言模型时代前,用更大的图像编码器一般是更有效的

-

进入大语言模型时代后,图文理解能力的强大可能来自于大语言模型的能力

-

进入大语言模型时代后,视觉优先仍然是值得探索的方向,但是训练大视觉模型向来是比较困难的

-

想要在多模态理解的基础上扩充多模态生成能力需要设计不同模态对应的解码器

-

理想的框架:多模态对齐+统一的编码器+统一的解码器,一举拿下多模态理解和生成

2941

2941

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?