随着大模型(如GPT-3、LLaMA、ChatGLM等)的崛起,如何高效微调(Fine-tuning)模型以适应具体任务成为开发者关注的核心问题。本文将深入探讨大模型微调的原理、方法、实战代码及避坑指南。

1. 什么是大模型微调?

大模型微调(Fine-tuning)指在预训练大模型(Pretrained Model)的基础上,通过少量领域特定数据对模型参数进行调整,使其适应下游任务(如文本分类、问答系统等)。与“从零训练”相比,微调能显著节省计算资源和时间成本。

为什么需要微调?

-

领域适配:预训练模型通常基于通用语料,缺乏垂直领域知识。

-

任务适配:将模型的“通用能力”迁移到具体任务(如情感分析)。

-

数据效率:仅需少量标注数据即可达到高性能。

2. 微调的核心方法

2.1 全参数微调(Full Fine-tuning)

-

原理:更新模型所有参数。

-

适用场景:计算资源充足,数据量较大。

-

缺点:显存占用高,易过拟合。

2.2 参数高效微调(Parameter-Efficient Fine-tuning, PEFT)

-

Adapter Tuning:在Transformer层中插入小型适配模块。

-

LoRA(Low-Rank Adaptation):通过低秩矩阵分解更新参数。

-

Prompt Tuning:调整输入提示(Prompt)而非模型参数。

-

优点:显存占用低,适合资源有限场景。

3. 实战:基于Hugging Face的BERT微调示例

以下以文本分类任务为例,展示全参数微调流程。

3.1 环境准备

3.2 加载模型与数据

3.3 数据预处理

3.4 训练配置

3.5 启动训练

3.6 模型评估

4. 微调中的常见问题与解决方案

4.1 过拟合

-

对策:增加数据增强、添加Dropout层、早停法(Early Stopping)。

-

示例代码(添加Dropout):

4.2 显存不足

-

对策:使用混合精度训练、梯度累积、LoRA微调。

-

修改训练参数:

4.3 灾难性遗忘(Catastrophic Forgetting)

-

对策:冻结部分层、使用更小的学习率。

-

冻结前N层示例:

5. 进阶工具推荐

-

PEFT库:实现LoRA、Adapter等高效微调(GitHub链接)

-

DeepSpeed:微软开发的分布式训练优化库

-

PyTorch Lightning:简化训练流程

6. 结语

大模型微调是释放预训练模型潜力的关键步骤。开发者需根据任务需求、数据规模、硬件条件灵活选择微调策略。未来,随着参数高效微调技术(PEFT)的成熟,大模型落地的门槛将进一步降低。

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

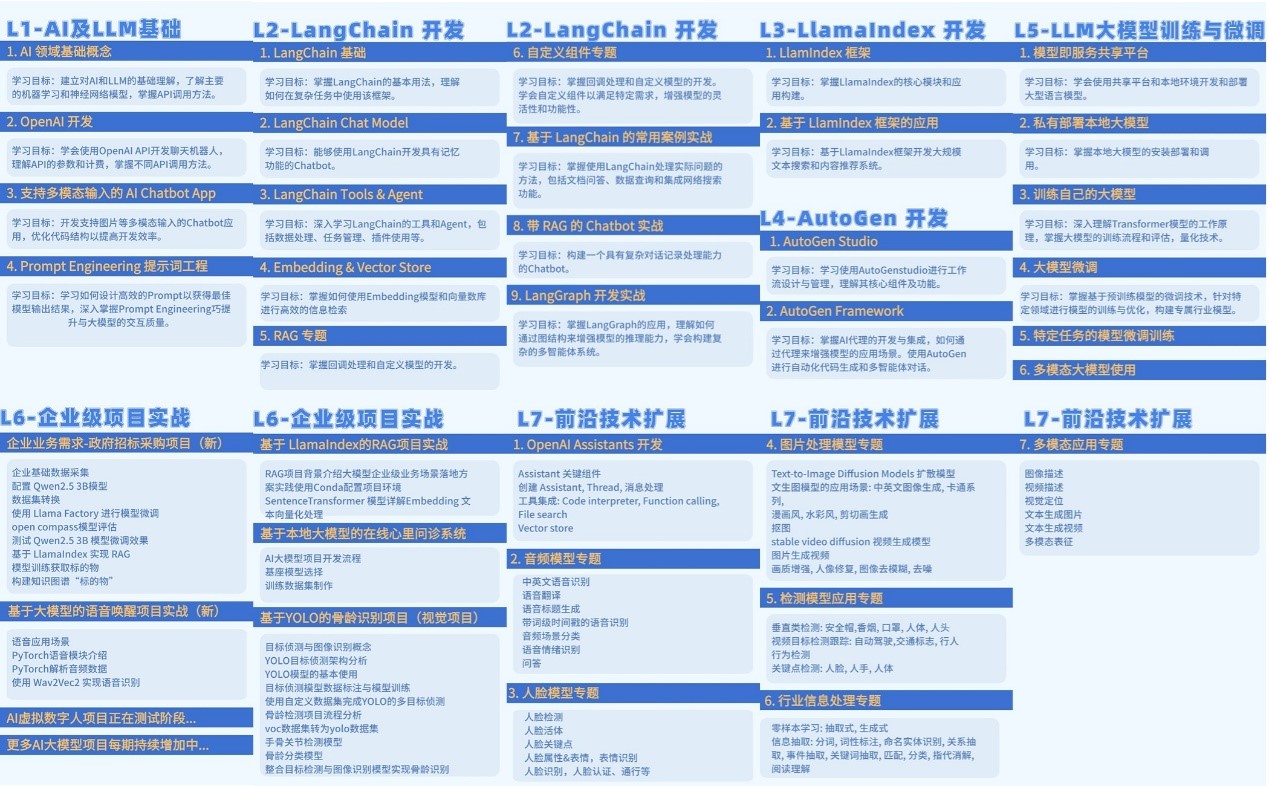

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型视频教程

对于很多自学或者没有基础的同学来说,这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

3. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

😝朋友们如果有需要的话,可以V扫描下方二维码联系领取~

608

608

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?