点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心技术交流群

后台回复【多传感器融合综述】获取图像/激光雷达/毫米波雷达融合综述等干货资料!

4D Radar在自动驾驶领域中越来越受关注,在价格和功能上都有比较大的竞争力,相关研究也逐渐open,今天为大家盘点下开源的4D Radar数据,为相关科学研究提供保障!

1Astyx

数据集链接:www.astyx.net

论文名称:Automotive Radar Dataset for Deep Learning Based 3D Object Detection

Astyx数据集是第一个公开的包含4D雷达点云的数据集,提出了一个基于雷达、激光雷达和摄像机数据的以雷达为中心的汽车数据集,用于3D物体检测。主要重点是向研究界提供高分辨率雷达数据,刺激使用雷达传感器数据的算法研究。为此,提供了用于物体检测的半自动生成和手动重新定义的3D地面真实数据。论文描述了生成此类数据集的完整过程,重点介绍了相应高分辨率雷达的一些主要功能,并通过在此数据集上显示基于深度学习的3D对象检测算法的结果,展示了其在3-5级自动驾驶应用中的使用。

由于手动标记是一项非常繁琐、缓慢和昂贵的任务,无法扩展到更大的数据集,因此自动预标记和手动重新定义是非常必要的。对于此任务,本文使用[16]的工作,基于深度学习的3D目标检测,并对低级传感器数据执行多传感器融合。为了尽量减少需要手动重新定义的标签数量,将此3D目标检测网络嵌入到基于不确定性采样的主动学习方法中,使用估计分数作为近似值(见图3)。为此,从网络最不确定其决策的自动预标记数据N帧中提取数据,通过手动微调进行校正,从而在下一轮训练和预标记中最大化网络的信息增益。

现阶段免费提供的最终数据集由500个同步帧(雷达、激光雷达、相机)组成,其中包含大约3000个非常精确标记的3D对象注释。尽管大多数对象都属于“汽车”类,但论文也提供了总共7类(公共汽车、汽车、自行车、摩托车、人、拖车、卡车)的少量真实数据。

gt数据注释包含每个对象的以下属性:

•3D位置(x、y、z)

•3D旋转(rx、y、rz)

•3D尺寸(w、l、h)

•类信息

•不确定性(位置、尺寸)

数据格式都是非专有的标准图像和点云格式,3D目标检测gt采用文本格式。如[7]所示,本文没有为目标检测算法的标准化评估和排序提供正式的基准测试套件,因为这将要求保留测试数据,以避免对评估测试集进行过度设置。这带来了一个有趣的问题,因为作者也在研究和开发基于这些数据的目标检测算法,这将是唯一能够完全控制gt真实数据的算法。图4显示了激光雷达和雷达传感器的点云密度分布,图5显示了不同类别的地面实况对象分布。在图7中展示了地面实况数据中汽车的示例性定向和空间分布。

2RADIal

数据集链接:https://github.com/valeoai/RADIal

论文链接:https://arxiv.org/pdf/2112.10646.pdf

雷达传感器凭借其对恶劣天气条件的鲁棒性和测量速度的能力,20多年来一直是汽车领域的一部分。汽车雷达自90年代后期开始生产。它们是自适应巡航控制、盲点检测和自动紧急制动功能的首选、最便宜的传感器。然而,它们的角度分辨率较差,这阻碍了它们在自动驾驶系统中的应用。事实上,此类系统需要高水平的安全性和鲁棒性,通常通过冗余机制实现。虽然通过融合多个模态改善了感测,但只有当每个传感器都达到足够和可比的性能时,整体组合才有效。高清晰度(HD)成像雷达已经出现以满足这些要求。通过使用密集的虚拟天线阵列,这些新传感器在方位角和仰角(分别为水平和垂直角位置)上实现了高角度分辨率,并产生了更密集的点云。最近在高清晰度(HD)成像雷达方面取得的进展已将角度分辨率降低到度以下,从而接近激光扫描性能。然而,高清雷达提供的数据量和估计角位置的计算成本仍然是一个挑战。本文提出了一种新的高清雷达感测模型FFT-RadNet,它消除了计算距离-方位-多普勒3D张量的开销,学习从距离-多普勒频谱恢复角度。FFTRadNet被训练来检测车辆和分割自由驾驶空间。在这两项任务上,它都与最新的基于雷达的模型竞争,同时需要更少的计算和内存。此外还收集并注释了来自同步汽车级传感器的2小时原始数据(相机、激光、高清雷达)在各种环境(城市街道、高速公路、乡村道路)中的应用。这个独特的数据集称之为RADIal,意为“雷达、激光雷达等”。

RADIal包括一套3个传感器(相机、激光扫描仪、高清雷达),并配有GPS和车辆的CAN轨迹,以原始格式记录25k个同步样本。(a) camera图像,投影激光点云为红色,雷达点云为靛蓝,车辆标注为橙色,自由驾驶空间注释为绿色;(b) 带有边界框注释的雷达功率谱;(c) 鸟瞰图中的自由驾驶空间标注,车辆标注橙色边界框,雷达点云标注靛蓝,激光点云标注红色;(d) 与雷达点云和激光点云叠加的笛卡尔坐标中的距离方位图;(e) GPS轨迹为红色,里程轨迹重建为绿色;

如下表所示,除相机外,所有传感器均为汽车级合格传感器。除此之外,还提供了GPS位置和车辆的完整CAN总线(包括里程表)。传感器信号以原始格式同时记录,无需任何信号预处理。对于高清雷达,原始信号是ADC。根据ADC数据,可以生成所有常规雷达表示:距离方位-多普勒张量、距离方位和距离多普勒视图或点云。RADIal包含约1-4分钟的91个序列,共2小时。这总计约为25k个同步帧,其中8252个标有9550辆车辆(详见附录A)。车辆注释由图像平面中的2D框以及到传感器的真实距离和多普勒值(相对径向速度)组成。雷达信号的注释很难实现,因为RD频谱表示对人眼没有意义。

3K-Radar

论文名称:K-Radar: 4D Radar Object Detection for Autonomous Driving in Various Weather Conditions

数据集链接:https://github.com/kaist-avelab/k-radar

不同于使用可见光带(384∼769太赫兹)和使用红外波段的激光雷达(361∼331太赫兹),雷达使用相对较长波长的无线电频带(77∼81GHz),导致在不利天气下的稳健测量。然而,与现有的相机和激光雷达数据集相比,现有的雷达数据集只包含相对较少的样本。这可能会阻碍基于雷达感知的复杂数据驱动深度学习技术的发展。此外,大多数现有雷达数据集仅提供3D雷达张量(3DRT)数据,该数据包含沿多普勒、距离和方位维度的功率测量。由于没有高程信息,因此从3DRT估计对象的3D边界框是一项挑战。本文介绍了KAIST雷达(K-Radar),这是一个新的大规模目标检测数据集和基准,它包含35K帧的4D雷达张量(4DRT)数据,以及沿多普勒、距离、方位和海拔维度的功率测量,以及仔细标注的道路上目标的3D边界框标签。

K-Radar包括各种道路结构(城市、郊区道路、小巷和高速公路)上的恶劣天气(雾、雨和雪)等具有挑战性的驾驶条件。除了4DRT之外,还提供经过仔细校准的高分辨率激光雷达、stereo相机和RTK-GPS的辅助测量。论文还提供了基于4DRT的目标检测基线神经网络(基线NN),并表明高度信息对于3D目标检测至关重要。通过将基线神经网络与基于激光雷达的类似结构的神经网络进行比较,证明了4D雷达对于恶劣天气条件是一种更为鲁棒的传感器。

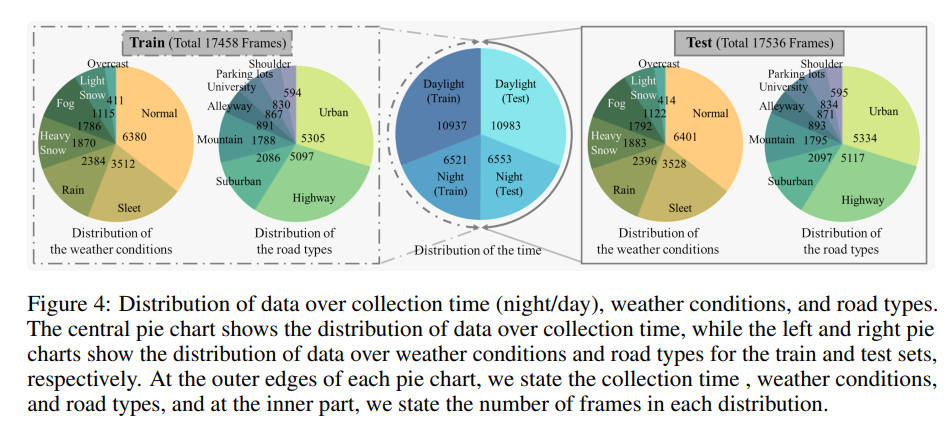

恶劣天气条件下的大部分画面是在韩国的江原道收集的,该省是全国年降雪量最高的省份。另一方面,带有城市环境的框架大多在韩国的大田收集。数据收集过程产生35K帧的多模态传感器测量值,构成K-Radar数据集。根据附录C中列出的标准将收集的数据分为几个类别。此外,本文将数据集划分为训练集和测试集,使每个条件以平衡的方式出现在两个集中,如图4所示,在距离自车辆120米的纵向半径和80米的横向半径范围内,道路上的物体(即轿车、公共汽车或卡车、行人、自行车和摩托车)有93.3K的3D边界框标签。请注意,只注释出现在正纵轴上的对象,即自我载体前面的对象。

图5展示了K-Radar数据集中的目标类别分布和距电子飞行器的目标距离,K-Radar可用于评估不同距离物体的3D目标检测网络的性能。

详细的数据集信息:

4TJ4DRadSet

论文名称:TJ4DRadSet: A 4D Radar Dataset for Autonomous Driving

论文链接:https://arxiv.org/abs/2204.13483

数据集链接:https://github.com/TJRadarLab/TJ4DRadSet

下一代高分辨率汽车雷达(4D雷达)可以提供额外的高程测量和更密集的点云,这在自动驾驶中具有巨大的3D感测潜力。本文介绍了一个名为TJ4DRadSet的数据集,该数据集包含用于自动驾驶研究的4D雷达点。数据集是在不同的驾驶场景中收集的,总共有7757个同步帧,共有44个连续序列,并用3D边界框和轨迹ID进行了很好的注释。我们为数据集提供基于4D雷达的3D物体检测基线,演示了深度学习方法对4D雷达点云的有效性。

对于自动驾驶车辆来说,高可靠性、低成本、高分辨率的感知模块是必不可少的。目前,感知模块主要使用相机、激光雷达和汽车雷达等传感器获取不同模式的环境信息。不可否认,相机和激光雷达易受恶劣条件的影响,如雨、雾和强光,其性能将随着逆境的增加而显著下降。相比之下,汽车雷达是必不可少的,因为它具有强大的鲁棒性和成本效益。由于方位分辨率低,传统的汽车雷达仅用于盲点检测、碰撞警告和其他驾驶辅助应用。新一代4D雷达的出现弥补了传统汽车雷达的低清晰度,并提供了高度测量,非常适合于高级自动驾驶应用。4D雷达的四个维度是距离、方位、高度和多普勒速度。它还提供了一些其他低级特征,如雷达截面(RCS)或信噪比(SNR)。

TJ4DRadSet的数据集是一个自动驾驶数据集,包含连续序列的4D雷达点云,并带有3D注释,它还提供了激光雷达、相机和GNSS的多模态完整信息。TJ4DRadSet包含40K帧的同步数据,其中7757帧,44个带有高质量注释3D边界框和轨迹的序列ID。3D注释系统使用联合多传感器注释和多轮手动检查。TJ4DRadSet涵盖各种道路条件,如高架道路、复杂交叉口、单向道路和城市道路。它还包括恶劣的照明条件,如强光和黑暗。该数据集适合于开发基于4D雷达的3D感知算法,以促进其在高级自主驾驶中的应用。

往期回顾

NVRadarNet:基于纯Radar的障碍物和可行驶区域检测(英伟达最新)

【自动驾驶之心】全栈技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多传感器融合、SLAM、光流估计、深度估计、轨迹预测、高精地图、规划控制、模型部署落地、自动驾驶仿真测试、硬件配置、AI求职交流等方向;

加入我们:自动驾驶之心技术交流群汇总!

自动驾驶之心【知识星球】

想要了解更多自动驾驶感知(分类、检测、分割、关键点、车道线、3D目标检测、多传感器融合、目标跟踪、光流估计、轨迹预测)、自动驾驶定位建图(SLAM、高精地图)、自动驾驶规划控制、领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球(三天内无条件退款),日常分享论文+代码,这里汇聚行业和学术界大佬,前沿技术方向尽在掌握中,期待交流!

6050

6050

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?