作者 | 计算机视觉工坊 编辑 | 计算机视觉工坊

点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

本文只做学术分享,如有侵权,联系删文

0. 这篇文章干了啥?

人类驾驶员主要依赖视觉信息来驾驶。他们视觉注意力的分布反映了经验丰富的驾驶员对当前交通场景的认知理解,特别是在具有碰撞风险的关键安全场景中。对于智能车辆而言,准确预测驾驶员的注意力至关重要,因为这有助于快速识别交通场景中的关键风险因素,并协助决策系统做出有效的避撞决策。

鉴于其重要的研究意义,已涌现出大量关于驾驶员注意力预测的研究。这些研究通常采用基本的编码器-解码器模型架构,以卷积神经网络(CNN)或Transformer作为核心组件。然而,当前注意力预测模型性能的提升主要归功于计算机视觉领域骨干网络的进步,却忽视了驾驶任务本身所需的认知机制分析。因此,这些模型尚未实现类似人类的驾驶员注意力预测。

在驾驶过程中,人类驾驶员必须实时处理复杂多变的交通信息,特别是在关键安全场景中。这一认知过程既涉及工作记忆也涉及长期记忆。工作记忆模块通过快速识别当前场景中的关键风险对象并评估其危险性,来迅速处理视觉信息。当潜在碰撞即将发生时,驾驶员会迅速从长期记忆中检索相关经验。这些过程共同帮助驾驶员形成情境意识,快速理解当前的交通状况,并根据积累的驾驶经验做出最优决策。

为了实现更人性化的驾驶员注意力预测,本文提出了一种自适应混合记忆融合(AHMF)模型,该模型明确地将工作记忆和长期记忆纳入驾驶员注意力预测中。此外,利用域适应技术,我们的模型在多个数据集上进行并行训练,有效地利用多样化的驾驶经验来丰富长期记忆。通过将场景中的特定危险刺激(由编码器作为工作记忆处理)与从长期记忆中检索的经验相结合,该模型可以做出最终的优化预测。我们在多个公共数据集上通过对比实验评估了我们的模型。结果表明,我们的模型在多个指标上均优于现有的最先进(SOTA)模型。

下面一起来阅读一下这项工作~

1. 论文信息

标题:AHMF: Adaptive Hybrid-Memory-Fusion Model for Driver Attention Prediction

作者:Dongyang Xu, Qingfan Wang, Ji Ma, Xiangyun Zeng, Lei Chen

机构:清华大学、北京大学、商汤

原文链接:https://arxiv.org/abs/2407.17442

2. 摘要

准确的驾驶员注意力预测可以为智能车辆理解交通场景和做出明智的驾驶决策提供重要的参考。尽管现有的驾驶员注意力预测研究通过引入先进的显著性检测技术提高了性能,但它们忽视了从认知科学角度分析驾驶任务以实现类人预测的机会。在驾驶过程中,驾驶员的工作记忆和长期记忆分别在场景理解和经验检索中发挥着至关重要的作用。它们共同构成了情境意识,有助于驾驶员快速理解当前的交通状况,并根据过去的驾驶经验做出最佳决策。为了明确整合这两种记忆,本文提出了一种自适应混合记忆融合(AHMF)驾驶员注意力预测模型,以实现更类人的预测。具体而言,该模型首先对当前场景中的特定危险刺激信息进行编码,以形成工作记忆。然后,它自适应地从长期记忆中检索相似的情境经验,以进行最终预测。利用域适应技术,该模型在多个数据集上进行并行训练,从而丰富了长期记忆模块中积累的驾驶经验。与现有模型相比,我们的模型在多个公共数据集上的各项指标上均表现出显著的改进,证明了在驾驶员注意力预测中整合混合记忆的有效性。

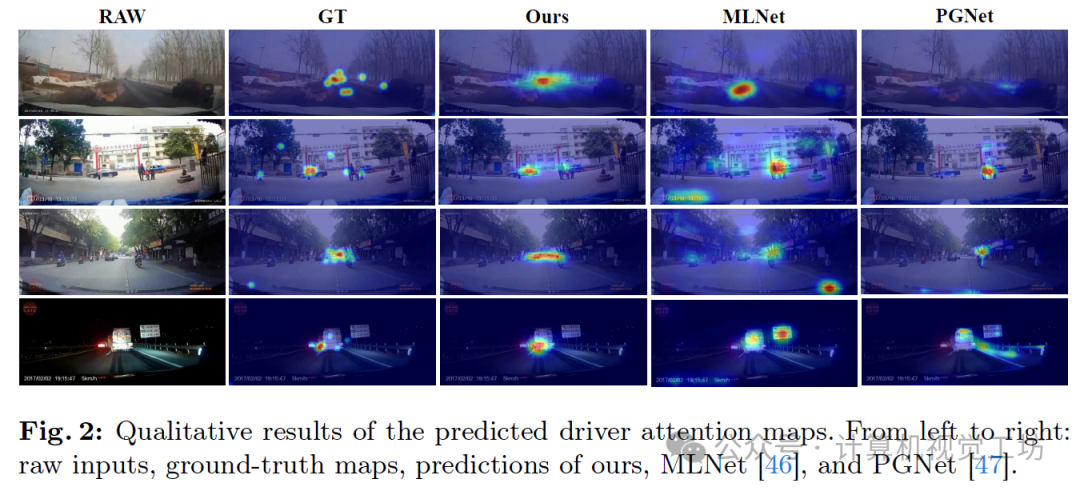

3. 效果展示

4. 主要贡献

本文的贡献如下:

我们从认知科学的角度,以与驾驶员对交通场景的理解紧密一致的方式预测驾驶员的视觉注意力。具体来说,该模型首先对当前场景中的特定危险刺激进行编码以形成工作记忆,然后将工作记忆与长期记忆相结合以产生最终的场景编码。

利用域适应技术,我们在多个数据集上实现了并行训练,从而增强了长期记忆模块中信息的多样性,并形成了全面的“驾驶经验”知识库,显著提高了模型的泛化能力。

实验表明,我们的模型在多个公共数据集上的多个指标上均达到了最先进的预测性能。

5. 基本原理是啥?

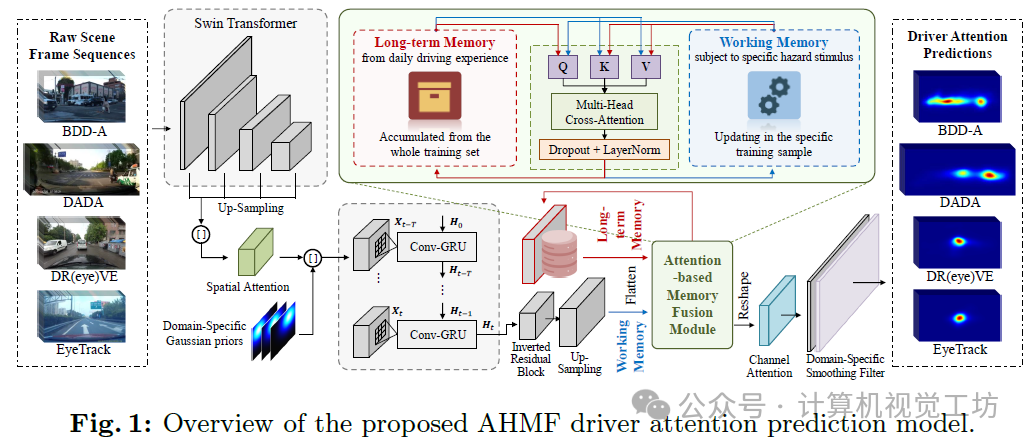

我们提出了一种新颖的自适应混合记忆融合(AHMF)驾驶员注意力预测模型,该模型明确结合了驾驶员的工作记忆和长期记忆,以实现类似人类的预测。图1展示了AHMF的概述,该模型包含两个核心模块,即时空工作记忆编码和基于注意力的混合记忆融合。此外,我们还引入了必要的领域特定模块,以丰富各种数据集累积的长期记忆。

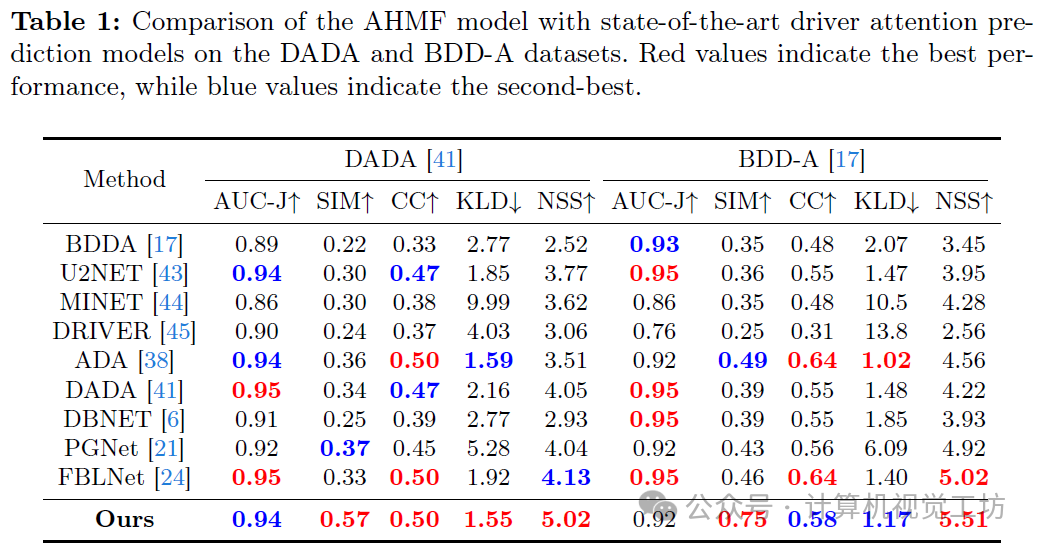

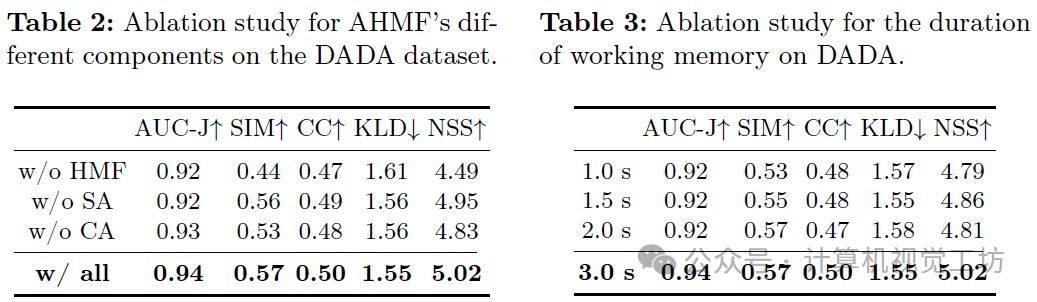

6. 实验结果

7. 总结 & 未来工作

在本文中,我们提出了一种新颖、更贴近人类的驾驶员注意力预测模型,该模型结合了工作记忆和长期记忆。

与现有方法不同,我们的方法显式地模拟了人类驾驶员在工作记忆中的场景理解和在长期记忆中的经验检索,以模仿他们在驾驶过程中定位视觉注意力时的情境感知机制。实验证明,所提出的记忆建模和融合方法显著提高了驾驶员注意力预测的性能。我们以非常直接的方式对这两种记忆进行了建模。未来应做出更多努力,通过认知科学与计算机视觉之间更深入的跨学科研究,找到更好的记忆建模方法。

对更多实验结果和文章细节感兴趣的读者,可以阅读一下论文原文~

投稿作者为『自动驾驶之心知识星球』特邀嘉宾,欢迎加入交流!重磅,自动驾驶之心科研论文辅导来啦,申博、CCF系列、SCI、EI、毕业论文、比赛辅导等多个方向,欢迎联系我们!

① 全网独家视频课程

BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、大模型与自动驾驶、Nerf、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

② 国内首个自动驾驶学习社区

国内最大最专业,近3000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型、端到端等,更有行业动态和岗位发布!欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦感知、定位、融合、规控、标定、端到端、仿真、产品经理、自动驾驶开发、自动标注与数据闭环多个方向,目前近60+技术交流群,欢迎加入!扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】全平台矩阵

118

118

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?