首先感谢B站UP主:Re_miniscence_,本篇文章总结来自于他,并添加了一些自己的理解。

该up的BB空间

1.随机变量

概率论中的知识,如用X表示一个随机事件,用p(X)表示概率。

2.随机过程

一组随机变量如St,St+1,St+2…作为一个整体研究,一组之间有很紧密的过程。随机过程X(t)是一组依赖于实参数t的随机变量,t一般具有时间的含义。随机过程{ X(t), t∈T }可能取值的全体所构成的集合称为此随机过程的状态空间,记作S

3.马尔可夫过程

具有马尔可夫性质的随机过程。它是一个无记忆的过程,随机状态序列S1,S2,S3…具有马尔可夫性质,马尔可夫性质即未来只与现在有关,而与过去无关,即S2只由S1决定,S3由S2决定,而S3不可能由S1决定。

马尔可夫过程是一个二元组

4.状态空间模型(HMM,kalman filter,particle filter)

即一条马尔可夫链再加上观测变量。

5.马尔可夫奖励过程

即马尔科夫链加上奖励。在马尔可夫过程引入奖励,才有了后面的决策,有了奖励才有了实现奖励最大化的决策。

奖励函数

s 是一个期望,对分布求均值。

6.马尔可夫决策过程(重点)

即马尔可夫链+奖励+行动。它是一个五元组,多了一个A,即行动。

用花体S代表状态集,St表示当前时刻的状态,同理花体A代表行动集合,花体R代表奖励集合。

动态特性:

第一个式子是动态特性,第二个式子是状态转移函数。

策略

策略用Π表示,有随机性策略和确定性策略,是给定状态的动作分布。

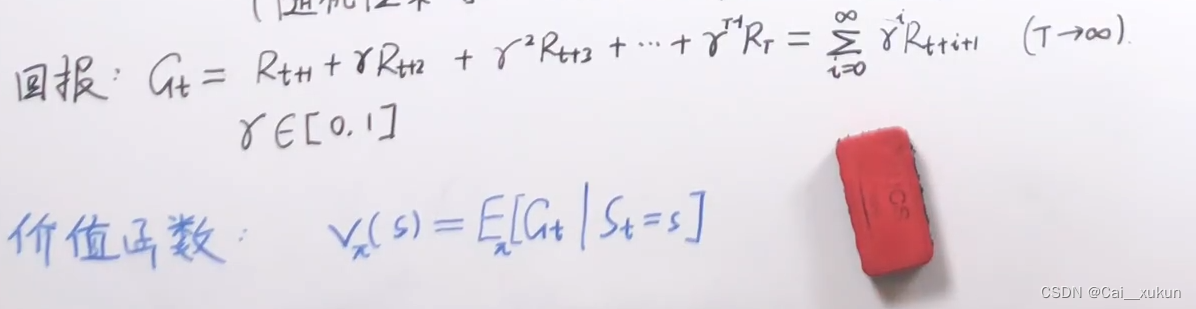

回报

γ为折扣因子,Gt为回报。因为后续发展是不确定的,如果等可能权值非常影响当前决策,所有未来的不确定系数是从折扣系数反应,同时未来是很长的,需要折扣系数来进行收敛。

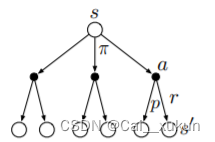

而由于每一个状态的每一个action都会对应不同的状态,如下图所示有六个Gt:

单纯的Gt是不能完整表示的,它只代表一条通路,所以引入价值函数来表示。

本文介绍了概率论中的随机变量和随机过程,特别是马尔可夫过程的基本概念,包括其无记忆性质。接着,讨论了状态空间模型如HMM和Kalman Filter,以及马尔可夫奖励过程在决策制定中的重要性,引入奖励函数和折扣因子。马尔可夫决策过程(MDP)作为核心概念,结合了马尔可夫链、奖励和行动,用于优化长期奖励的策略选择。动态特性和策略定义进一步阐述了MDP的决策制定过程。

本文介绍了概率论中的随机变量和随机过程,特别是马尔可夫过程的基本概念,包括其无记忆性质。接着,讨论了状态空间模型如HMM和Kalman Filter,以及马尔可夫奖励过程在决策制定中的重要性,引入奖励函数和折扣因子。马尔可夫决策过程(MDP)作为核心概念,结合了马尔可夫链、奖励和行动,用于优化长期奖励的策略选择。动态特性和策略定义进一步阐述了MDP的决策制定过程。

652

652

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?