论文笔记 | 【CVPR2023】OPE-SR: Orthogonal Position Encoding for Designing a Parameter-free Upsampling Module in Arbitrary-scale Image Super-Resolution

CVPR2023,总共有5篇任意超分。

找时间都读一读吧,咋任意超分已经这么火了捏。

目录

题目重点:使用正交位置编码的上采样模块,这个上采样模块是不需要参数的。做任意超分。

作者来自:天津大学、南洋理工、南京信息工程大学。

目前(2023.4.30)还没有人引用。

1 Review of LIIF

2 Motivation & Contribution

Motivation:

1.基于隐式神经表示(INR)【LIIF中的MLP】的上采样模块增加网络复杂性。

MLP与特征提取网络需要联合训练。

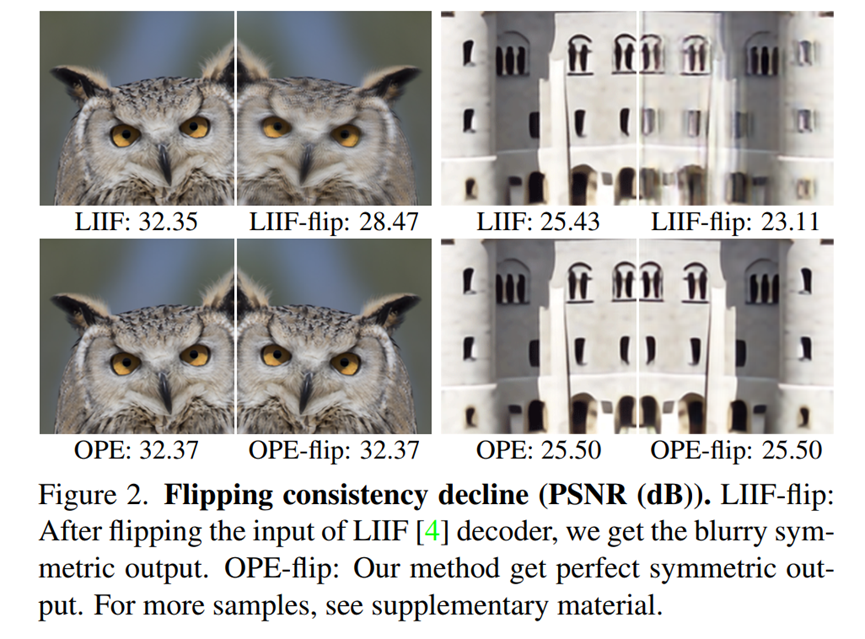

2.重建对MLP有依赖性,然而MLP在学习图像的对称性特征时存在局限性,导致翻转一致性下降(flipping consistency decline),具体表现为:特征图水平翻转后,目标图像变模糊。

解决方案:不使用MLP。

MLP是一个通用的函数逼近器,试图拟合一个从Feature map到HR图像的映射函数。那么这个映射函数,又可以使用一组解析解来求解。

因此文章使用2组正交基构建的一个大正交基,使用该正交基的线性组合用于拟合这个映射函数。在该基础上构建了OPE上采样模块,这是一个无参数的模块,简化了SR框架。

Contribution:

OPE编码+OPE模块+解决MLP翻转一致性问题+保持性能的同时减少计算和内存消耗

3 Method

个人感觉文章写得比较晦涩。有一些细节论文没有写得很清楚,我大致看了代码,如果没有讲清楚的再讨论罢。

一些数学推导我自己推了,但是就不详细展开了,只展开技术方面的部分。

为了方便理解,我转换一下讲述顺序。

3.1 正交基与OPE编码

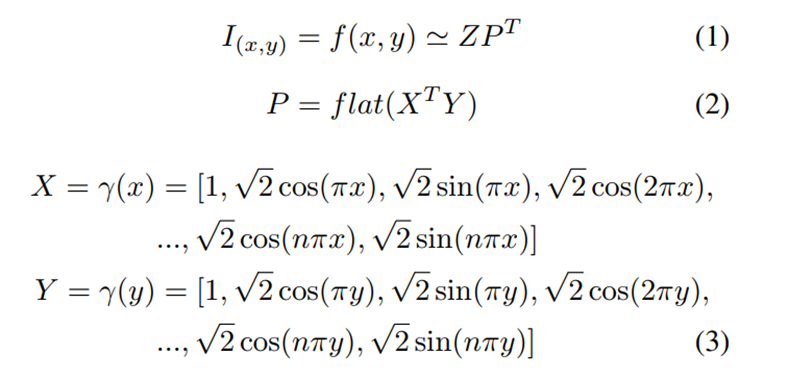

对于一个待超分的图像patch,它可以通过一个映射函数f,从LR映射到HR。

这个f函数接受输入x,y,映射到输出像素值。

现在我们希望用一组正交基来拟合这个映射。

正交基:

平面中的2个不重叠的向量,可以通过线性组合表示平面内任意一个向量,这两个向量称为一组基向量。如果这两个向量垂直(正交),就是一组正交基向量。扩展到三维,四维,n维,都可以成立。

向量本质也是一种映射,从一个点,映射到一个点。

希望用一组正交基,来拟合这个f映射,实际上也就是得到这个上采样的方式。只要正交基定了,就只需要确定前面的系数了。

正交基怎么确定?用一组(x,y)坐标确定。

首先它给出了一组基础的正交基γ,可以证明它是正交的。

GPT的答案:证明每两个向量内积都为零,并且每个向量都是单位向量。

我自己证过了,就不展开了。

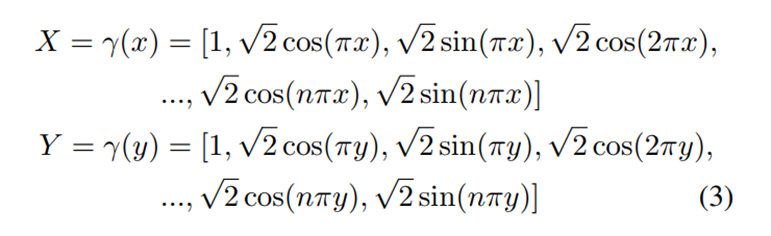

对于一个x,可以通过γ()函数确定出一组正交基,同样y也可以确定出一组正交基,记为X和Y,他们的维度都是(2n+1)。

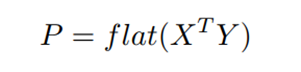

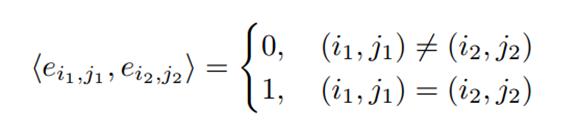

把X的转置和Y相乘,得到一个(2n+1)×(2n+1)的向量,展平(flatten),得到一个

(2n+1)^2的向量,记为P。

这个P依然是一个正交基,因为它满足其中的任意两两相乘都是0(现在的两两相乘,相当于以前的四个相乘。以前的两两相乘为零,两个0相乘依然为零);满足任意一个都是单位向量(相当于原来的两两相乘,两个单位三角函数向量相乘依然是单位向量)。

所以P可以认为是一组维度是(2n+1)^2的正交基。

或者用这个公式理解,把P中的任意一个量用eij表示,如果(i1,j1)≠(i2,j2),可以通过计算得出他们的乘机为0,就是正交。

理一下,对于一个坐标(x,y),可以确定2组小的正交基X和Y,进而确定一组大的正交基P,维度是(2n+1)^2。

这个P就是OPE编码的含义。

3.2 Pipeline

OPE有了,怎么做基于OPE编码的上采样模块?

一些铺垫。

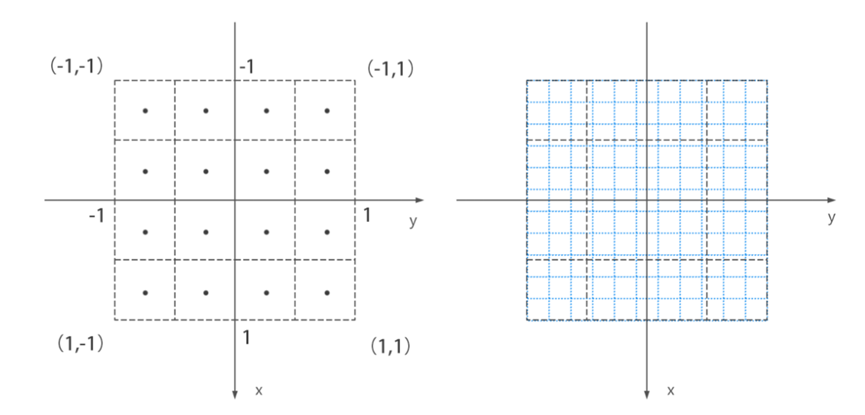

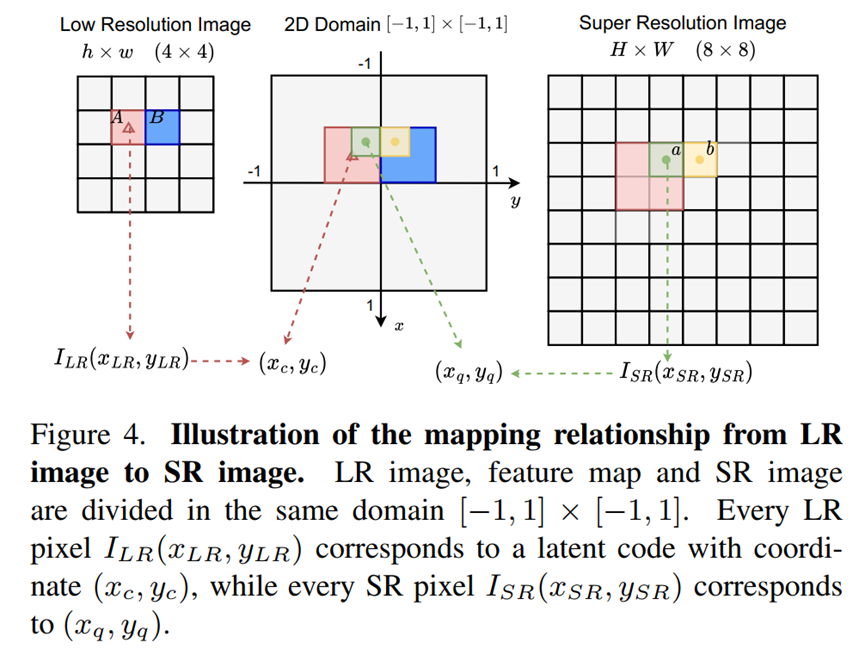

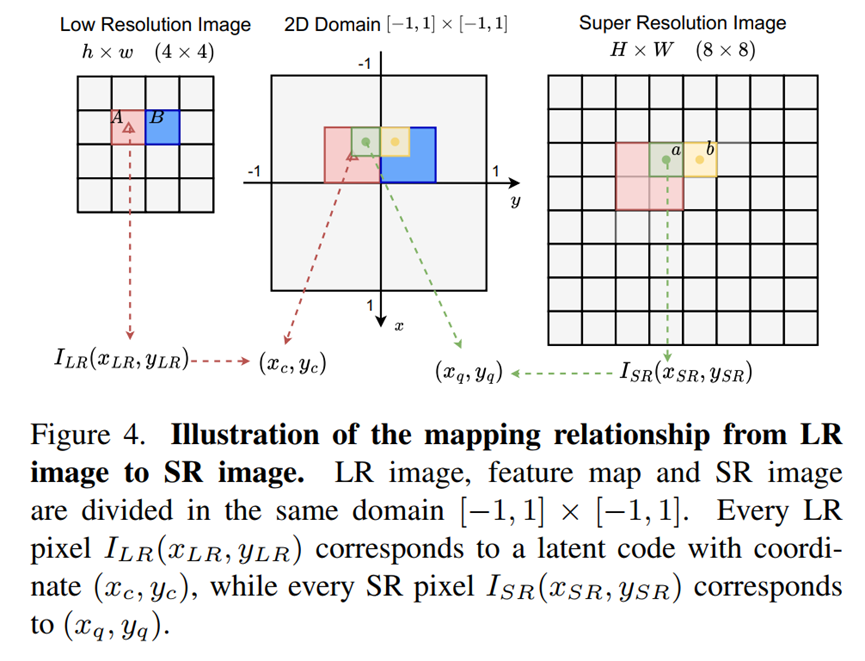

同样的,把LR和HR图片放到[-1,1]的坐标系里,切割成同样大小的块(44,88),每一块的中心点,可以对应到一个坐标。

LR:(xq,yq)

HR:(xq,yq)

LR坐标的作用:定位一组该位置的特征z*。

HR坐标的作用:定位一个要求的像素点值。

LR、HR坐标都参与相对坐标的计算。

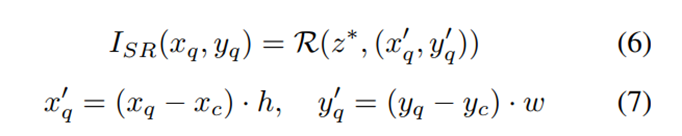

相对坐标的计算如公式7,两个坐标相减,按照h或者w的比例放大。

总体思路: 对于HR坐标(xq,yq),通过一个函数R,输入:对应特征z*,一对相对坐标,得出一个像素值。

这个函数R的意义就是,结合了OPE编码的上采样模块。

(加一个相对坐标计算的理解:(xq,yq)和(xq,yq)虽然分别是HR和LR坐标,但是都是在[-1, 1]范围内的,它们求差,是求在[-1, 1]的相对距离,hw之后就成了原来LR图像中的绝对距离了。)

看看它的计算流程。

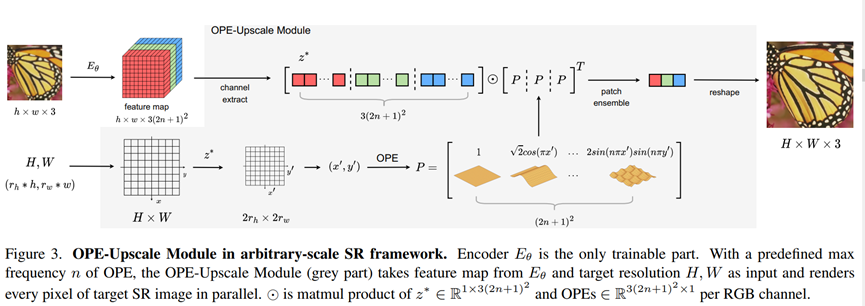

对于一张LR图片(h×w×3),通过Eθ,特征提取网络,提取出3(2n+1)2个通道的特征。这个E网络就是整个结构中,唯一需要训练的地方。

对于LR图像的总共hw个像素,每一个像素,都对应一个长度为3(2n+1)2的一维特征。

之后按照逐通道特征拆开,这样对于RGB三个通道,每个通道都有一个长度为(2n+1)2的特征。这些特征我们标注为Z。

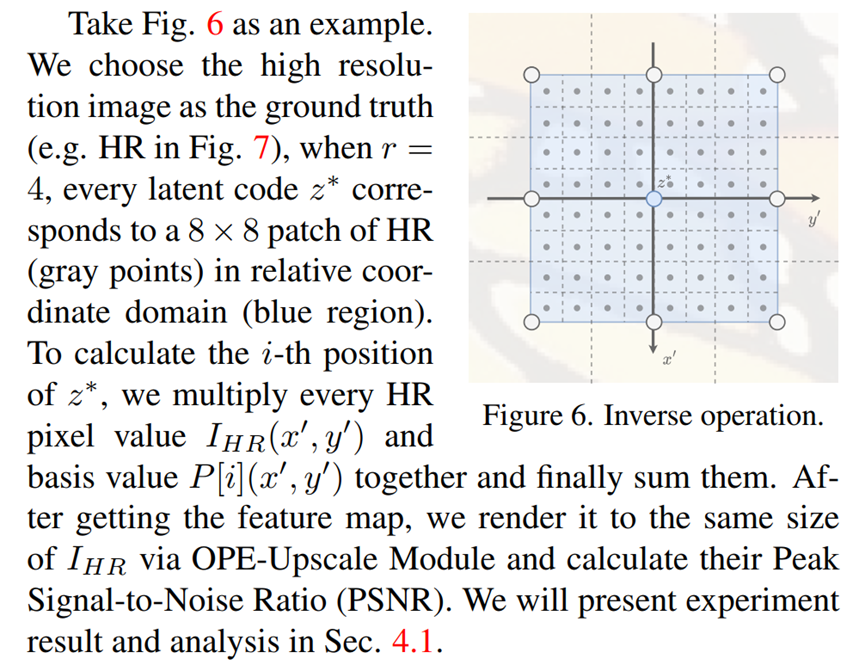

做好这些处理后,对于HW个HR图像中的,需要求像素值的像素位置(xq,yq),我们可以找到离他最近的一个LR图像的坐标(xc,yc),并且找到对应的一维特征Z,通过上面的操作拆分成3个通道。

(xq,yq)和(xc,yc)可以计算出一组相对坐标(x’, y’),进而通过X和Y,确定一组正交基P。P的大小恰好是(2n+1)2。

把特征Z作为系数,与正交基P相乘。三个通道分别与P相乘可以得到三个值,恰好作为一组三通道像素值,作为HR图像坐标(xq,yq)这个位置的像素的值。

上述操作重复HW遍,就得到一张HR图像。

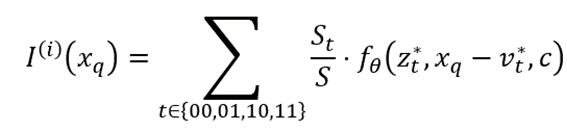

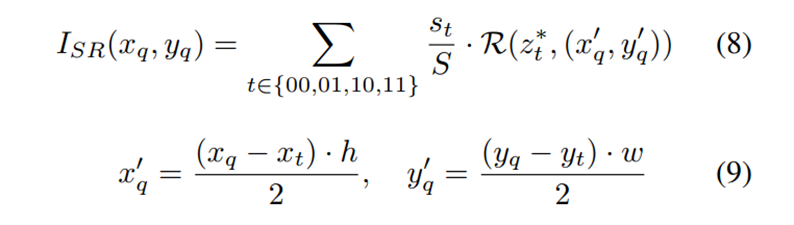

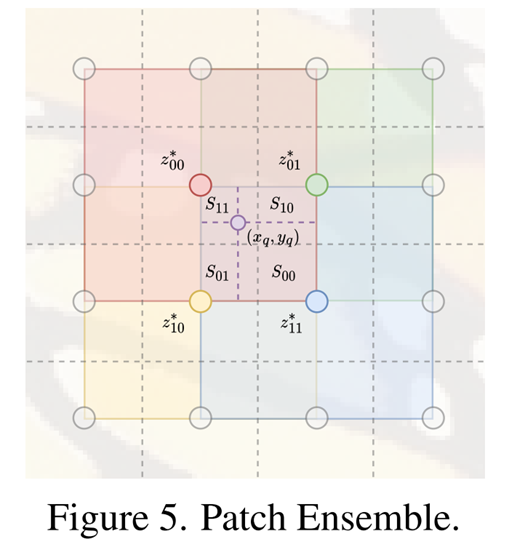

3.3 Patch ensemble

做一些调整。还是这张图。

上述方法存在不平滑的问题。举个例子,如果(xq,yq)从a移动到b,那么由HR坐标确定的离他最近的一个特征z会从A变成B。

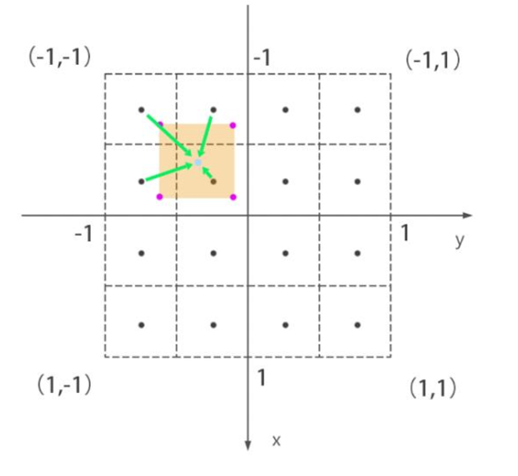

所以仿照LIIF,不止找他最近的1个点了。找4个点,用同样的方法求出来,然后加权。

加权方式和LIIF一样。

这个公式是不是很眼熟,其实操作一模一样。

另外xq’和yq’,也就是相对坐标的计算也/2了,这个地方为什么要/2我还没有很好的理解。

但可以知道的是,原来的范围是[-2h, 2h],现在控制到[-h, h],或许可解释性更强了。

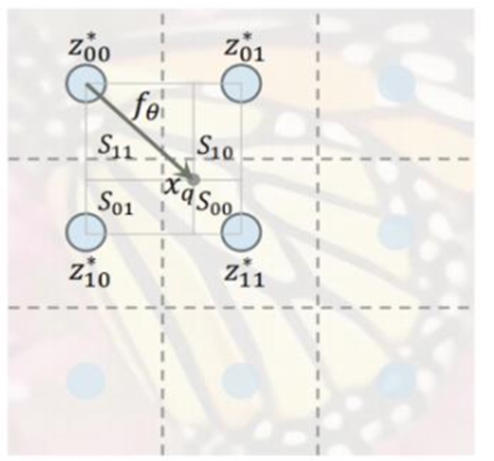

3.4 Selection of Max Frequency n

最后其实还有这一部分,还有这个图,但目前还没有看懂。如果有人看懂了可以交流下。

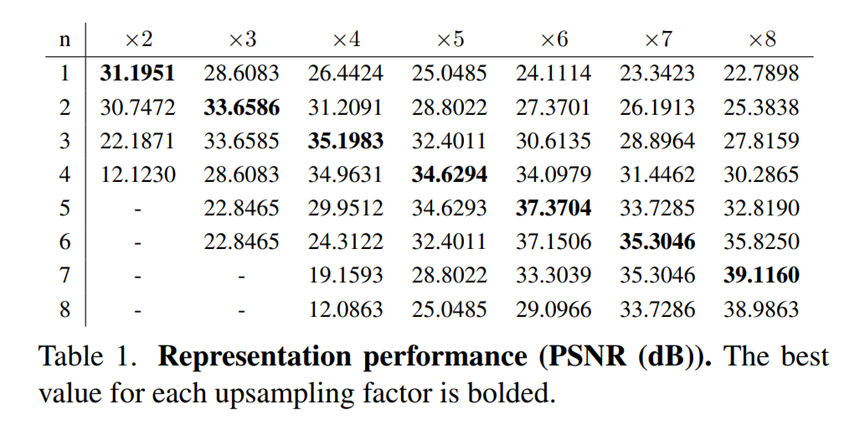

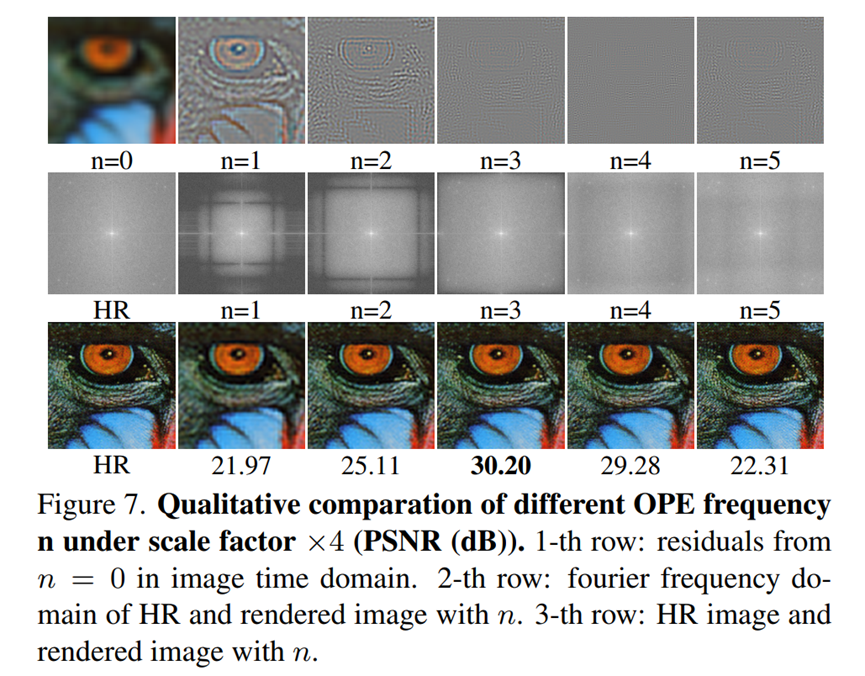

说下我浅显的理解。其实这部分是对n取多少,也就是傅里叶级数到多少的一个消融实验的解释,放到正文里来了而已。

文章应该是用这部分解释了消融实验是如何进行的。

按照本来的理解,消融实验就从头开始训练特征提取网络Eθ,得到同样的特征z*,然后变换n做上采样,得到的结果去计算PSNR就好了。

但是文章不。

或许是为了避免特征提取网络的误差,文章选择从GT图像,用类似积分的方法,在已知n的情况下,使用P反求投影Z,再用Z按照原来的上采样方法求SR图像,用SR和GT做PSNR等计算。

(讲的有点乱,我自己也还是迷惑,有时间再重看下哈)

4 Experiment

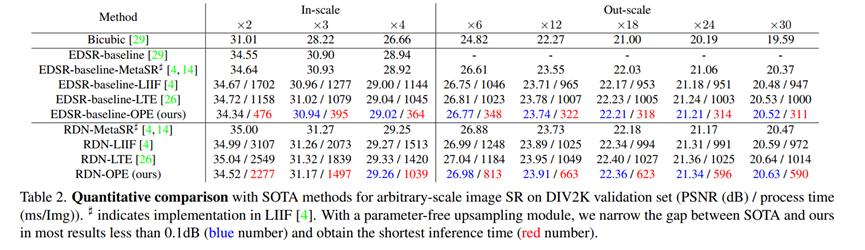

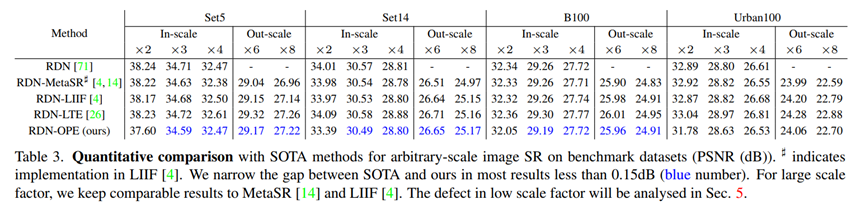

在验证集和测试集上的结果。

没有到SOTA,主打的是与SOTA的差距小于0.15dB,但是使用了最短的推理时间。

一些对比:

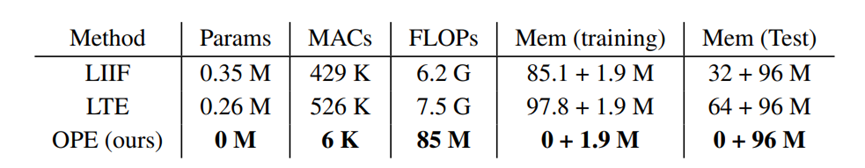

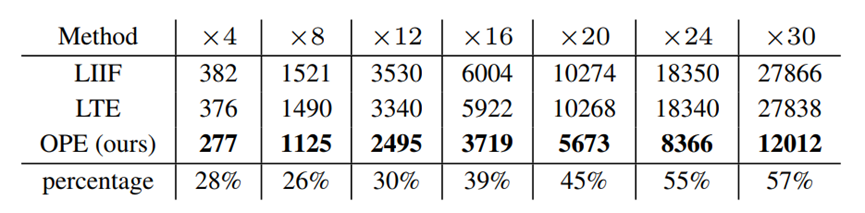

参数量、乘法加法运算次数、浮点数运算、内存消耗情况

上采样模块的推理时间:

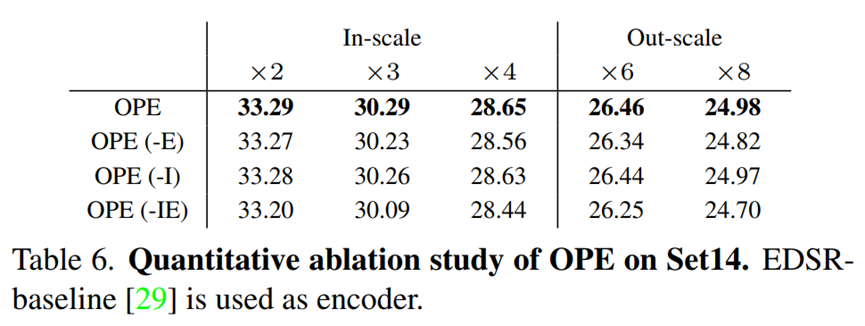

5 Ablation study

5.1 如何选择n?

N其实可以理解成,傅里叶变化中的频率。N越大,含有的高频信息越多,当然计算成本也更大,因为计算次数越多。

通过可视化发现,n过大会带来冗余的高频信息,使得图像看起来锐化。所以选择了n=3。

5.2 是否带patch ensemble

E:相对坐标域是否/2

I:4个最近点双线性插值

很神奇的是,相对坐标的/2这个增益竟然还不小。

4786

4786

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?