KAN学习笔记

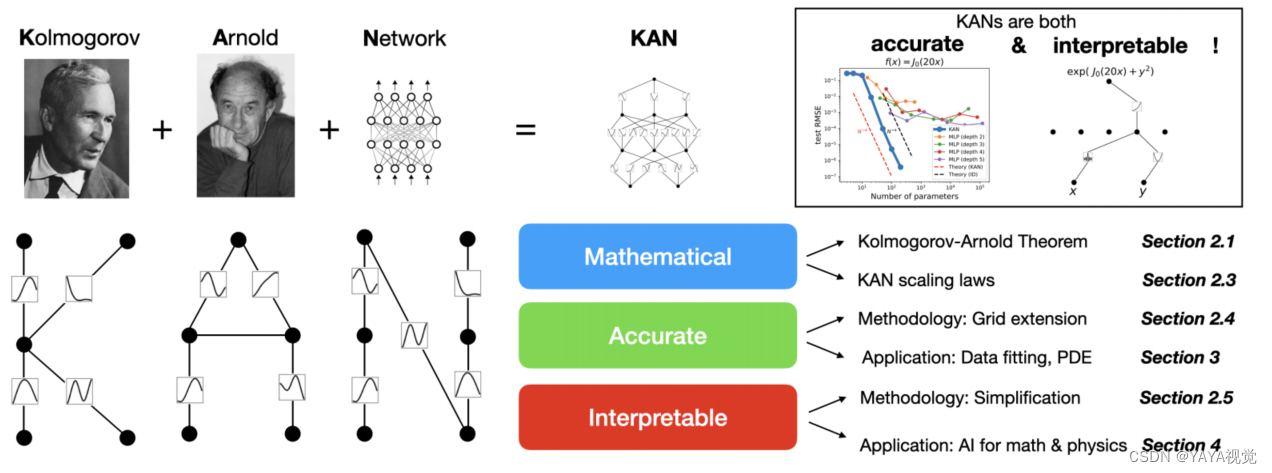

这篇论文介绍了一种新型的神经网络架构——Kolmogorov-Arnold Networks(KANs),它是由Kolmogorov-Arnold表示定理启发而来,**旨在作为多层感知器(MLPs)的有前途的替代品。KANs的核心特点是在网络的边缘(即权重)上拥有可学习的激活函数,而不是像传统的MLPs那样在节点(即神经元)上使用固定的激活函数。**这些激活函数由一元函数(univariate functions)组成,每个权重参数被一个作为样条(spline)参数化的一元函数所替代。论文展示了KANs在准确性和可解释性方面相较于MLPs的优势。

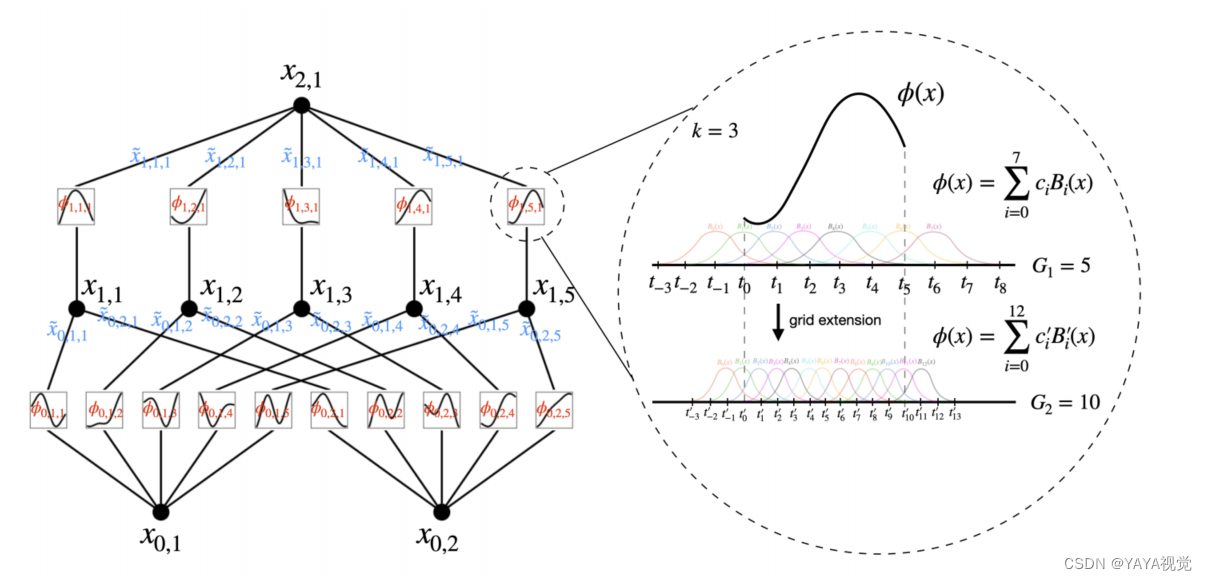

1.mlp在节点(“神经元”)上有固定的激活函数,而kan在边缘(“权重”)上有可学习的激活函数。kan根本没有线性权重——每个权重参数都被参数化为样条的单变量函数所取代。

2.KANs可以很好地学习组合结构和单变量函数。

1)无固定激活函数:与传统MLP在节点上使用固定的激活函数(如ReLU、Sigmoid等)不同,KAN模型的激活函数是可学习的,并且放置在网络的边缘(即权重)上。

2)激活函数的参数化:KAN中的每个激活函数由一个一元函数(univariate function)组成,这些函数被参数化为B样条(B-spline)曲线。这意味着每个权重参数不再是一个单一的数值,而是一个函数。

3.kan在数据拟合和PDE求解方面比mlp更准确。

4.如前所述,这样的网络被认为太简单,无法在实践中任意地用光滑样条近似任何函数!因此,我们将我们的KAN概括为更广泛和更深。目前还不清楚如何使KANs更深,因为Kolmogorov-Arnold表示对应于两层的KANs。据我们所知,目前还没有一个“一般化”版本的定理对应于更深层次的KANs。

本文介绍了Kolmogorov-ArnoldNetworks(KANs),一种新型神经网络架构,其独特之处在于在权重而非神经元上使用可学习的激活函数。KANs展示了在数据拟合和PDE求解方面的优势,但深度扩展面临挑战,因为现有的理论仅适用于两层结构。

本文介绍了Kolmogorov-ArnoldNetworks(KANs),一种新型神经网络架构,其独特之处在于在权重而非神经元上使用可学习的激活函数。KANs展示了在数据拟合和PDE求解方面的优势,但深度扩展面临挑战,因为现有的理论仅适用于两层结构。

2771

2771

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?