论文题目: Self-supervised Learning for Large-scale Item Recommendations

论文地址: https://dl.acm.org/doi/abs/10.1145/3459637.3481952

论文发表于: CIKM 2021

论文大体内容:

本文主要提出了SSL(Self-supervised Learning)框架,采用对比学习(Contrastive Learning)的方式用于推荐中召回模型的训练,使模型取得更好的效果。

Motivation:

自监督学习在CV和NLP领域取得很好的效果,那在推荐系统上是否也能取得好的收益呢,这正是本文在探索的。

Contribution:

①提出SSL框架,用于做触发;

②数据增强;

③离线实验取得效果;

④线上实验取得效果;

1. 自监督学习在CV和NLP领域比较常用,因为做起来也是很方便的。在CV领域,直接对图像进行旋转、裁剪等操作,就能进行数据增强;而在NLP领域,通过类似于word2vec的方式,mask掉句子中的某个词语,就能做到SSL,这种方法在BERT上效果显著。

2. 对于推荐系统来说,其数据会很稀疏,原因包括:

①数据分布是高倾斜度的,长尾分布,这样导致长尾item学习是不够充分的;

②用户反馈的缺失,只有模糊隐含的正反馈,不够细致化(2个like之间也是有区别的,1个是100%的like,另1个是80%的like);

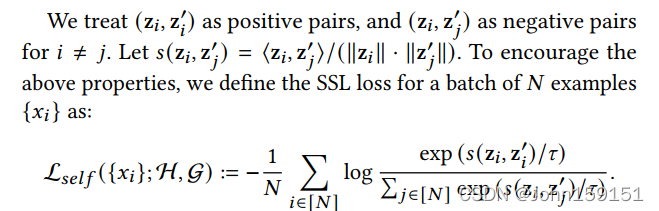

3. SSL框架如图所示,xi和xj经过2种数据增强的方法(h和g),得到yi、yi'、yj、yj',对应的embedding是zi、zi'、zj、zj',优化的方向是maximize(zi和zi'的相似度),minimize(zi和zj的相似度),minimize(zi和zj'的相似度)。Loss如下图。

4. Loss如下图。

Loss使用的是SimCLR《A Simple Framework for Contrastive Learning of Visual Representations》中提出的基于InfoNCE的变种,其中InfoNCE的详细推导见[3]。这个Loss的主要意思是一个batch的N个样本,zi与zi'是正样本对,maximize其相似度,而zi与zj'是正负样本对,minimize其相似度。

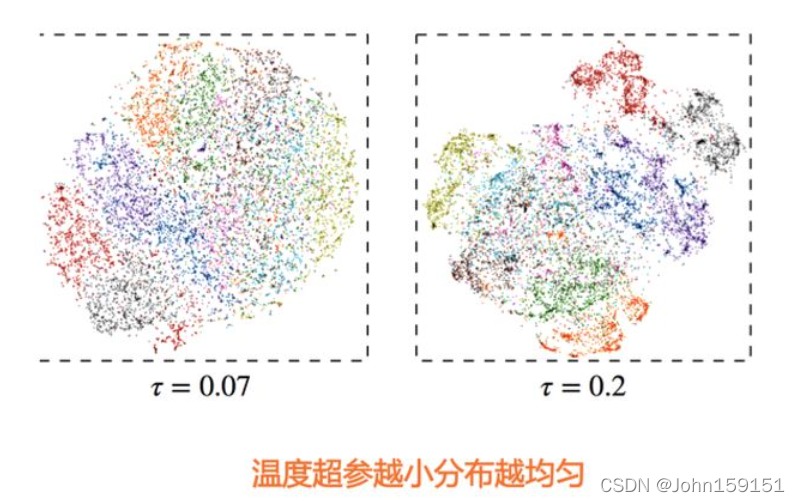

温度超参的特性[1]:温度超参越小,则更倾向把超球面上的局部密集结构推开打散,使得超球面上的数据整体分布更均匀。

5. 其中本文探索的数据增强方法包括:

①masking:将部分item特征mask,用默认embedding来替换;

②dropout:对于category特征,以一定概率mask某个value,比如年龄段,mask掉18-25的;

masking方式是100%的dropout。

6. 由于在含有高度相关的特征在两个样本里面,各自mask了1个,会导致模型容易不够鲁棒。本文为了考虑feature之间的相似度,对特征之间的互信息进行了预计算。

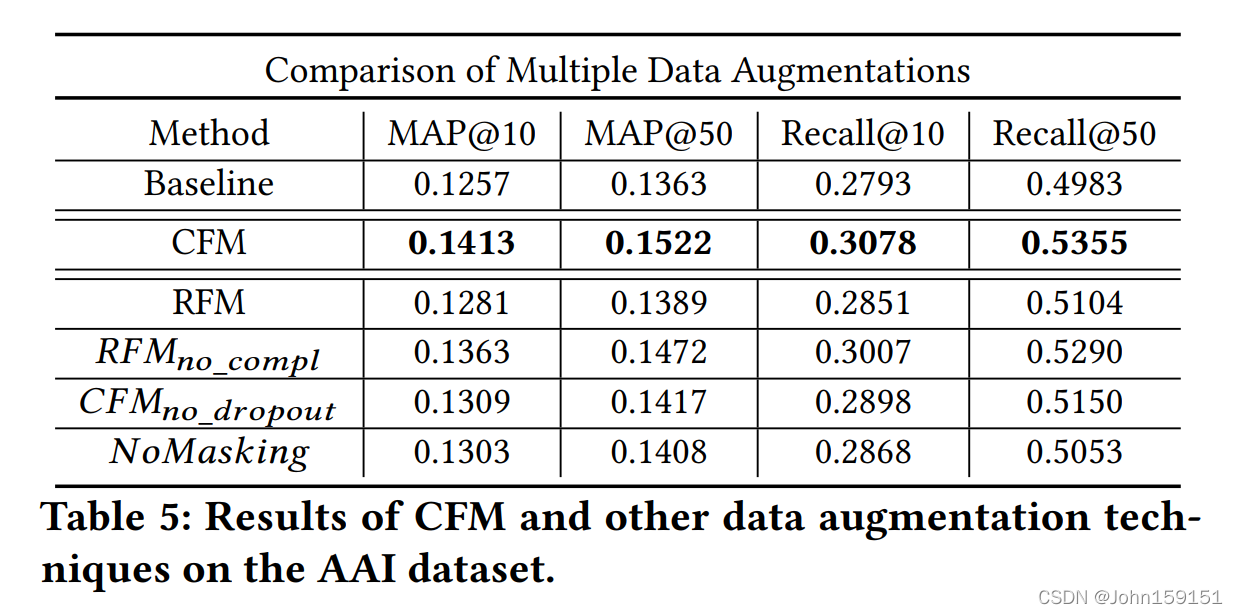

①RFM(Random Feature Masking),不考虑特征之间的相似度,随机进行数据增强;

②CFM(Correlated Feature Masking),本文提出的考虑特征之间相似度的数据增强做法,先预计算特征两两之间的互信息,然后随机出一个种子特征f_seed,按与f_seed的互信息排序,取前一半进行mask。

7. 联合学习

为了让SSL能提升监督学习的效果,所以本文将SSL的loss引入监督学习任务中,进行joint loss学习,整体的模型结构如下。

![]()

实验

8. 实验需要回答下面几个疑问点:

①SSL框架是否能提升推荐模型的效果?

②训练数据的数量对SSL的影响?

③SSL的参数敏感性分析?

④RFM与CFM的效果差别?

9. Dataset

①Wikipedia:链接预测问题;

②App-to-App Install (AAI):推荐相似的app;

10. Baseline

①双塔DNN;

②Feature Dropout (FD):在item塔进行feature dropout,没有联合学习;

③Spread-out Regularization (SO) :没有数据增强,有联合学习;

11. 实验结果

①SSL框架提升了模型的效果(Q1)

②只采样10%的训练数据来实验,SSL的相对提升效果更大(Q2)

③参数敏感性分析(Q3)

④CFM确实比RFM效果好不少(Q4)

⑤线上AB实验收益也是明显的

参考资料

[1] https://zhuanlan.zhihu.com/p/367290573

[2] https://www.zhihu.com/question/457751102/answer/2235342261

[3] https://zhuanlan.zhihu.com/p/334772391

以上均为个人见解,因本人水平有限,如发现有所错漏,敬请指出,谢谢!

736

736

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?