速读纪要

DatasetGAN:

一种自动生成大量高质量的语义分割图像数据集的过程,需要最少的人力。 仅需要少量标注的样本来训练decoder生成潜在空间剩下的部分, 从而产生一个无限的注释数据生成器。 生成的数据集接下来可以被用来训练任何计算机视觉架构。

标注成本是实现数据规模的瓶颈。

我们的目标是合成大型高质量的标签数据集,只需要标签少数的例子。

在我们的工作中,我们展示了最新的最先进的图像生成模型学习非常强大的潜在表示,可以用于复杂的像素级任务。

我们引入了DatasetGAN,它可以生成大量的高质量的语义分割图像数据集,需要最少的人力。

我们的方法的关键是观察到,经过训练来合成图像的GANs必须获得丰富的语义知识,才能呈现多样化和逼真的对象示例。

我们的关键观点是,训练一个成功的解码器只需要少量的标记图像,从而产生无限的注释数据集生成器。

因为我们只需要标记几个例子,所以我们非常详细地注释图像,并生成具有丰富对象和部分分割的数据集。

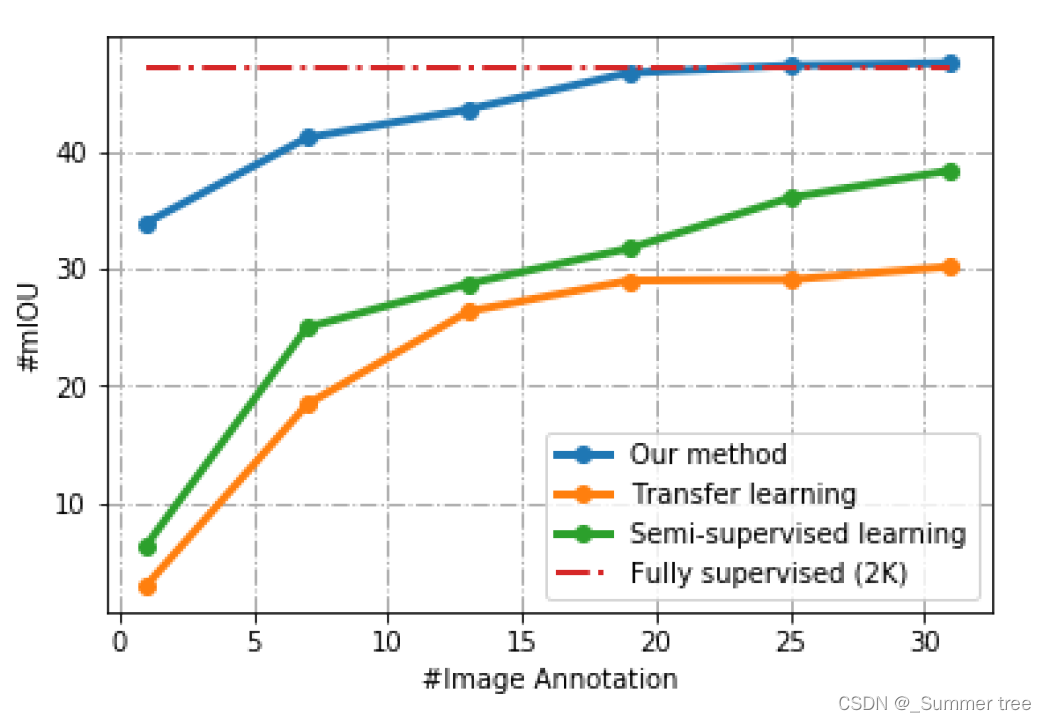

我们为7个图像分割任务生成了数据集,其中包括34个人脸部件和32个汽车部件的像素级标签。我们的方法显著优于所有半监督的基线,并且与完全监督的方法相当,尽管在某些情况下需要少两个数量级的注释数据。

在我们的工作中,我们展示了动画对象的3D重建,在那里我们利用我们的方法产生的详细部分标签。

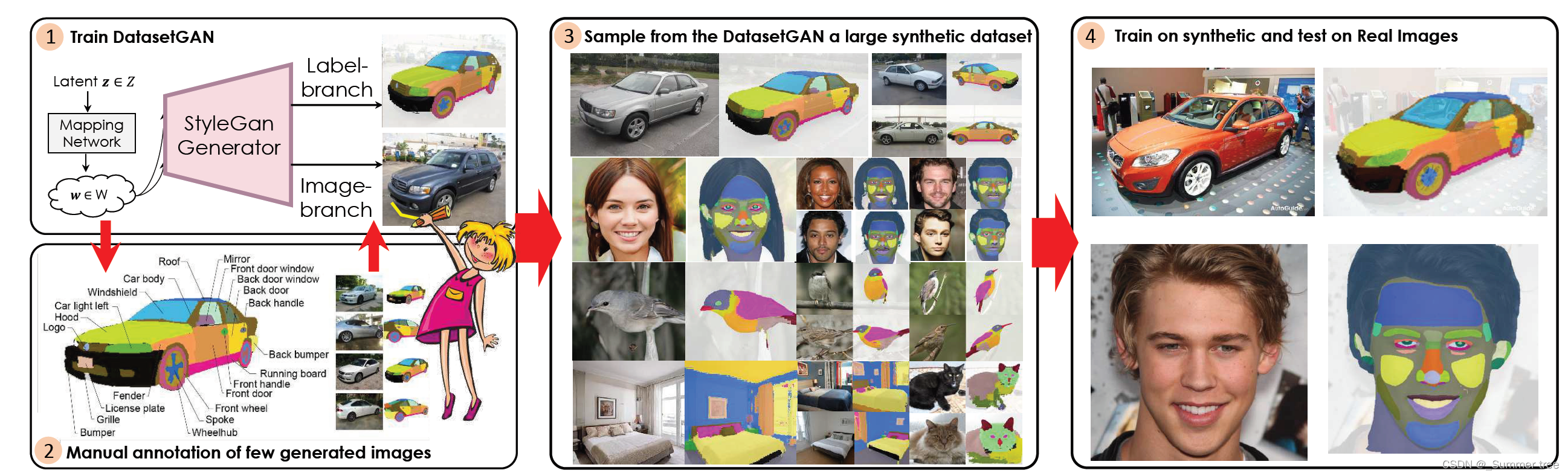

DATASETGAN合成图像注释对,可以生成具有详细像素级标签的大型高质量数据集。图显示了这4个步骤。(1,2).利用StyleGAN,只注释少量的合成图像。训练一个高效的分支来生成标签。(3).自动生成一个巨大的人工合成的标注图像数据集。(4).使用合成数据集训练您最喜欢的方法,并在真实图像上进行测试。

图2:DATASETGAN的总体架构。我们从StyleGAN上采样特征映射到最高分辨率,为合成图像上的所有像素构建像素级特征向量。然后训练MLP分类器的集合,将像素特征向量中的语义知识解释到其部件标签中。

图2:DATASETGAN的总体架构。我们从StyleGAN上采样特征映射到最高分辨率,为合成图像上的所有像素构建像素级特征向量。然后训练MLP分类器的集合,将像素特征向量中的语义知识解释到其部件标签中。

图3“: 小型人类标注的人脸和汽车数据集。大多数用于语义分割的数据集(MS-COCO [33], ADE [56], cityscape[11])都太大了,用户无法检查每一个训练图像。在这个图中,我们展示了所有标记的人脸(a-c)和汽车(d-f)分割训练示例。a)显示了一个分割掩码和相关标签的例子,b)显示了训练图像的完整集合(GAN样本),c)显示了标注的部分列表和数据集中的实例数。一个有趣的事实是,请注意,单个图像中的标签比数据集中的图像要多。

图3“: 小型人类标注的人脸和汽车数据集。大多数用于语义分割的数据集(MS-COCO [33], ADE [56], cityscape[11])都太大了,用户无法检查每一个训练图像。在这个图中,我们展示了所有标记的人脸(a-c)和汽车(d-f)分割训练示例。a)显示了一个分割掩码和相关标签的例子,b)显示了训练图像的完整集合(GAN样本),c)显示了标注的部分列表和数据集中的实例数。一个有趣的事实是,请注意,单个图像中的标签比数据集中的图像要多。

图4:来自DATASETGAN的人脸和汽车的合成图像和标签的例子。StyleGAN骨干用1024张1024分辨率的CelebA-HQ (faces)图像和512张384分辨率的LSUN CAR (cars)图像进行训练。DATASETGAN用16个带注释的例子进行训练。 // 这个带注释 是什么标签呢?

图5:来自DATASETGAN的鸟、猫、卧室的合成图像和标签的例子。StyleGAN在NABirds(10241024张图片)、LSUN CAT(256256张图片)和LSUN Bedroom(256256张图片)上接受训练。DATASETGAN在30只注释过的鸟类样本、30只猫和40间卧室中接受训练。

图6:训练示例的数量与mIOU我们比较基准上的ADE-Car- 12测试集。红色虚线表示完全监督方法,它利用了来自ADE20k的2.6k训练示例。 // mIOU 是什么?

Method

The key insight of DATASETGAN is that generativemodels such as GANs that are trained to synthesize highlyrealistic images must acquire semantic knowledge in theirhigh dimensional latent space.

DATASET-GAN aims to utilize these powerful properties of imageGANs. Intuitively, if a human provides a labeling corre-sponding to one latent code, we expect to be able to effec-tively propagate this labeling across the GAN’s latent space.

Specifically, we synthesize a small num-ber of images by utilizing a GAN architecture, StyleGANin our paper, and record their corresponding latent featuremaps.

By sampling latent codeszand passing eachthrough the entire architecture, we have an infinite datasetgenerator!

这个视频讲解还不错: https://www.bilibili.com/video/av502581865/

介绍DatasetGAN,一种利用GAN生成高质量语义分割图像数据集的方法,仅需少量标注样本即可训练出强大的模型,显著降低标注成本。适用于人脸、汽车等多场景。

介绍DatasetGAN,一种利用GAN生成高质量语义分割图像数据集的方法,仅需少量标注样本即可训练出强大的模型,显著降低标注成本。适用于人脸、汽车等多场景。

747

747

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?