每月都有大量 AI 框架涌入市场,你是否感到不知所措?你并不孤单。随着人工智能重塑技术格局,选择正确的 AI 框架对于工程师和开发人员来说至关重要。从构建简单的聊天机器人到开发复杂的语言模型,这些框架是现代 AI 应用程序的基础。

无论您使用的是生成式 AI 模型还是实现大型语言模型 (LLM),掌握正确的工具都可以成就或毁掉您的项目。我们分析并汇编了 2025 年真正值得您花时间的七个最重要的 AI 框架 - 从久经考验的 TensorFlow 到 LangChain 和 LlamaIndex 等新兴参与者。

让我们排除干扰,集中精力于那些能为您的学习投资带来最大回报的框架。

TensorFlow

TensorFlow 是 Google 对 AI 框架生态系统的强大贡献,为研究和生产的机器学习应用程序提供了一个全面的平台。

TensorFlow 主要特性和功能

从本质上讲,TensorFlow 提供了一组强大的功能,使其成为 AI 开发的首选:

- 架构灵活:支持CPU和GPU计算无缝切换

- 可视化工具:TensorBoard 支持详细的模型检查和调试

- 生产就绪:跨移动、边缘和云平台部署模型

- 社区支持:丰富的文档和活跃的开发者社区

- 预先训练的模型:访问大量可立即使用的模型库

TensorFlow 实施最佳实践

有效实施 TensorFlow 需要遵循既定的最佳实践。当您将代码重构为更小、更易于管理的函数并使用 @tf.function 修饰最大的计算块以获得最佳性能时,该框架效果最佳。对于模型开发,利用 Keras API 进行高级模型构建,同时在需要时保持对低级 TensorFlow 操作的访问。

该框架本身是开源的,因此对于初创公司和企业来说都是具有成本效益的。资源包括全面的文档、预先训练的模型和通过 TensorFlow Hub 提供的数据集,从而实现 AI 解决方案的快速开发和部署。

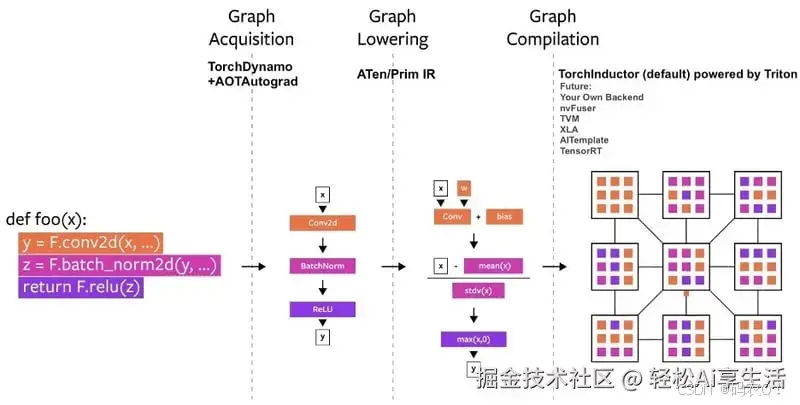

PyTorch

Meta AI 的 PyTorch 以其直观的设计和动态计算能力彻底改变了 AI 框架格局,受到研究人员和开发人员的喜爱。

PyTorch 架构和组件

PyTorch 的架构以其动态计算图系统(称为 Autograd)为中心,该系统可在开发阶段实现实时模型调整。该框架的核心组件包括:

- 张量运算:利用 GPU 加速的高级数学计算

- 神经网络模块:预建和可定制的网络层

- 优化器:用于模型训练的复杂算法

- 数据实用程序:高效的数据加载和预处理工具

PyTorch 开发工作流程

PyTorch 中的开发过程遵循自然的 Pythonic 方法,简化了 AI 模型的创建。典型的工作流程包括:

数据准备

- 将输入数据转换为 PyTorch 张量

- 创建自定义数据集和数据加载器

- 应用必要的预处理转换

模型开发

- 使用 torch.nn 定义网络架构

- 实现前向传递计算

- 配置损失函数和优化器

该框架受益于通过论坛、全面文档和 Meta AI 研究团队的定期更新提供的广泛社区支持。对于企业用户,PyTorch Enterprise 提供增强的功能和专用支持渠道,确保在生产环境中可靠部署。

该框架与 Python 的科学计算生态系统(包括 NumPy 和 Pandas)无缝集成,使其特别适合开发生成式 AI 模型和大型语言模型 (LLM)。它在处理动态计算图方面的灵活性使其成为 Hugging Face 和 LangChain 等许多现代 AI 框架的基础。

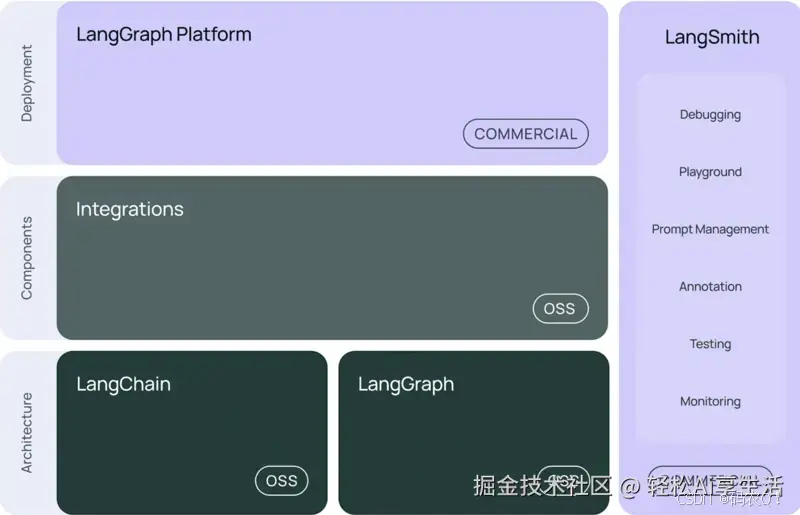

LangChain

LangChain 彻底改变了开发人员利用大型语言模型功能的方式,成为一个突破性的 AI 框架,弥合了复杂的 LLM 功能与实际应用之间的差距。

LangChain 框架概述

LangChain 以其模块化架构和专为生成式 AI 开发设计的全套工具脱颖而出。该框架的核心优势包括:

- 及时管理和优化

- 数据增强生成

- 自主决策代理

- 情境保留的记忆系统

- 广泛的集成能力

这些组件无缝协作,使开发人员能够创建复杂的应用程序,而不会受到复杂基础设施管理的困扰。

LangChain 集成技术

该框架擅长通过其统一的接口连接各种数据源和服务。集成功能涵盖:

外部数据源

- 文档存储库

- 矢量数据库

- API 端点

开发工具

- 版本控制系统

- 监控平台

- 部署服务

为了优化成本,开发人员可以实施多种策略:

- 利用缓存机制处理频繁查询

- 尽可能批量调用 API

- 监控使用模式以实现有效的资源分配

该框架的成本效益通过其丰富的文档、广泛的社区支持和持续的更新得到增强,确保开发人员在构建尖端 AI 应用程序的同时能够最大化他们的投资。

Hugging Face

Hugging Face Transformers 库处于人工智能民主化的前沿,通过其全面的工具和模型生态系统,让全球开发人员能够使用先进的自然语言处理。

Hugging Face 核心功能

该框架的优势在于其跨人工智能多个领域的多功能功能。核心功能包括:

- 预先训练的模型中心拥有数千个可立即使用的模型

- 与 PyTorch 和 TensorFlow 无缝集成

- 高级标记和预处理工具

- 内置对迁移学习的支持

- 全面的文档和社区资源

Hugging Face 实现指南

实现 Hugging Face Transformers 遵循一种简单的方法,可以实现快速开发。该过程从模型选择开始,然后通过微调和部署进行扩展。为了获得最佳结果,开发人员应专注于利用 AutoClass 系统,该系统可自动处理模型架构细节并在不同模型类型之间提供一致的接口。

该框架擅长通过其管道架构处理任务,允许开发人员以最少的代码实现复杂的 NLP 操作。这包括从基本文本分类到高级生成式 AI 应用程序的所有内容。

该框架提供本地和云部署选项,成本根据计算要求和模型复杂性而有所不同。企业用户可以从 SSO 支持、审计日志和专用基础设施选项等附加功能中受益。

对于在生产环境中工作的开发人员,Hugging Face 提供推理端点,直接从 Hub 提供专用且可自动扩展的基础设施。这确保了可靠的性能,同时通过优化资源利用率保持了成本效益。

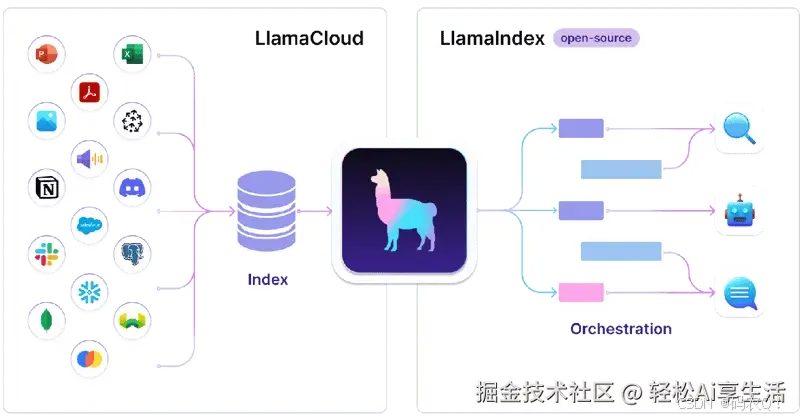

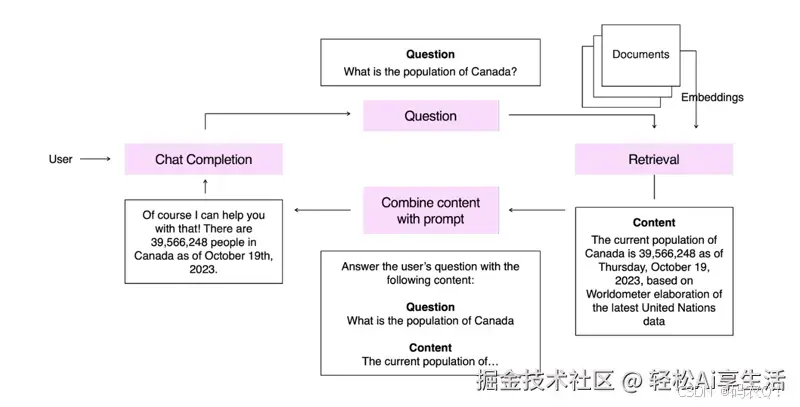

LlamaIndex

LlamaIndex 旨在弥补数据与大型语言模型之间的差距,它作为一个强大的数据框架出现,改变了开发人员构建情境感知型 AI 应用程序的方式。这个创新框架专门通过 LLM 使各种数据源可访问和可查询。

LlamaIndex 特性和功能

该框架的架构以其复杂的数据处理和检索功能为中心:

- 用于多源集成的数据连接器(LlamaHub)

- 高级文档操作(插入、删除、更新)

- 多文档合成功能

- 用于查询引擎选择的路由器功能

- 矢量存储集成和 ChatGPT 插件支持

- OpenAI 函数调用 API 兼容性

LlamaIndex 开发过程

LlamaIndex 中的开发工作流程采用两阶段方法,可优化数据处理和查询。在数据处理阶段,框架将知识库划分为可管理的块,并存储为“节点”对象,这对于处理 LLM 的令牌限制至关重要。

查询过程包括:

- 节点集合:根据查询上下文收集相关数据

- 响应综合:使用 LLM 集成生成上下文丰富的答案

- 聊天引擎实现:通过数据实现持续对话

成本优化策略包括实现令牌预测器,用于估算索引构建和查询阶段的费用。该框架提供了内置工具(如 TokenCountingHandler 回调和 MockLLM 实现),以帮助开发人员有效地管理和预测令牌使用情况。

对于企业部署,LlamaIndex 提供高级功能,例如假设文档嵌入和与各种向量存储的集成,使组织能够扩展其 AI 框架实施,同时保持成本效率。

OpenAI 框架

OpenAI 准备框架 (OPF) 开创了负责任的 AI 开发前沿,为安全和道德的 AI 框架实施树立了新标准。这个综合系统将强大的安全协议与尖端开发工具相结合,确保 AI 部署的创新性和责任感。

OpenAI 框架组件

OPF 的架构围绕其核心安全和开发组件展开,经过精心设计,旨在管理和减轻 AI 系统中的风险。关键要素包括:

- 风险评估综合评价体系

- 综合网络安全措施

- 安全咨询小组 (SAG) 监督

- 负责任的扩展策略实施

- 先进的监测和测试协议

该框架强调模型自主性中的人类监督,为人工智能操作建立明确的阈值,同时保持最佳性能水平。

OpenAI实施战略

实施遵循注重安全性和效率的结构化方法。该过程从全面的风险评估开始,并通过定期的安全演习和红队演习继续部署。该框架集成了改进人工智能算法的技术解决方案以及系统部署控制的程序操作。

准备团队推动技术实施,同时与安全咨询小组合作,确保符合道德准则。这种双重方法既保证了技术卓越性,又保证了负责任的发展。

成本优化策略包括:

- 通过仪表板监控代币使用情况

- 使用阈值和通知的实施

- 根据任务需求进行战略模型选择

该框架的按使用量付费系统允许灵活扩展,成本根据模型选择和使用模式而变化。语言 API 按每个令牌定价,而图像生成模型则遵循基于分辨率的定价。这种结构使组织能够在访问强大的生成式 AI 功能的同时保持成本效益。

对于企业部署,OpenAI 提供全面的支持选项,包括自定义数据保留窗口和增强的安全功能。该框架的集成功能扩展到各种开发环境,既支持研究计划,也支持生产规模的应用程序。

微软 JARVIS

微软在 AI 框架领域的最新创新带来了 JARVIS,这是一个突破性的系统,它通过智能控制器架构协调多个 AI 模型。这种独特的方法改变了开发人员利用人工智能开发复杂应用程序的方式。

JARVIS 平台概述

从本质上讲,JARVIS 是一个协作系统,利用 ChatGPT 作为其主要控制器,与 Hugging Face 生态系统中的众多专家模型进行协调。该平台的独特功能包括:

- 多模态处理能力

- 实时 Web 访问集成

- 先进的任务规划系统

- 跨模型协作

- 全面的 API 支持

- 智能资源管理

该框架的架构实现了不同AI模型之间的无缝交互,可以执行单一模型无法独立实现的复杂任务。

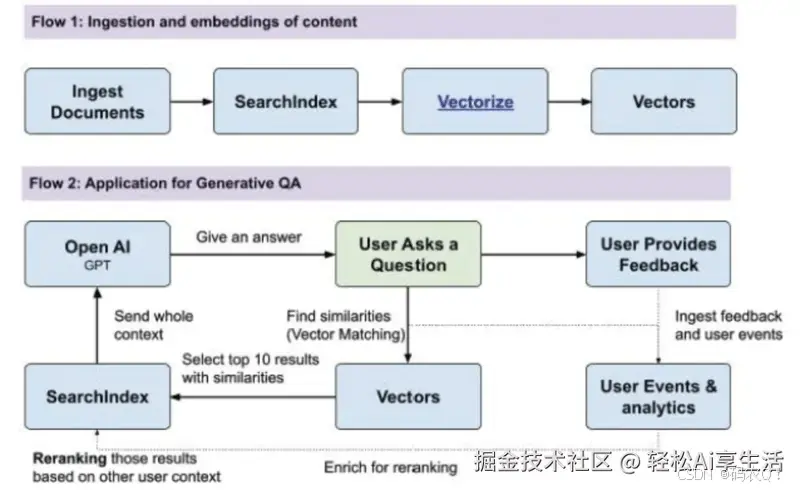

JARVIS 开发工作流程

开发过程遵循复杂的四阶段工作流程,可优化任务执行和资源利用率:

- 任务规划:ChatGPT 分析用户请求并将其分解为可管理的子任务

- 模型选择:从Hugging Face中智能选择合适的专家模型

- 任务执行:通过实时监控协调执行选定的模型

- 响应整合:将结果综合整合为连贯的输出

这种结构化方法可确保有效处理复杂查询,同时保持高准确性和性能水平。

资源需求根据部署选项而变化:

- 最低配置:16GB VRAM,100GB 存储空间

- 标准设置:64GB RAM(推荐用于 Jetson AGX Orin)

- 云部署:灵活的扩展选项

该框架支持本地和基于云的部署模型,精简配置需要最少的本地资源,同时通过 HuggingFace 推理端点保持对核心功能的访问。

对于企业实施,JARVIS 提供高级功能,包括自定义模型集成、专用支持渠道和专业部署选项。该平台的资源管理系统在保持成本效益的同时优化了性能,使其适用于研究和生产环境。

SingleStore 数据平台

SingleStore 是一个功能强大的数据平台,旨在加速 AI 和机器学习应用程序的开发。它将关系数据库的功能与数据仓库的速度相结合,可对大型数据集进行无缝实时分析。SingleStore 的架构支持高吞吐量事务和复杂查询,是处理多种数据类型的数据工程师的理想选择。

它能够处理结构化和非结构化数据,使 AI 从业者能够构建需要即时获取洞察的强大应用程序。借助自动扩展和集成机器学习功能等功能,SingleStore 可帮助团队更快地进行创新并提供有效的 AI 解决方案。

结论

掌握这七个 AI 框架可让开发人员站在人工智能开发的前沿。每个框架都有不同的用途 - TensorFlow 和 PyTorch 在深度学习方面表现出色,LangChain 和 LlamaIndex 简化了 LLM 应用程序,而 Hugging Face、OpenAI 和 Microsoft JARVIS 则在自然语言处理和多模式 AI 方面突破了界限。

智能框架选择取决于特定的项目要求。TensorFlow 适用于生产就绪型应用程序,PyTorch 在研究环境中大放异彩,而 LangChain 等较新的框架则提供用于构建 LLM 驱动的应用程序的专门功能。

这些框架持续快速发展,定期更新引入新特性和功能。要想在 AI 开发中取得成功,就需要紧跟这些变化,同时牢牢掌握基本概念。

不要试图同时掌握所有框架,而是从符合您当前项目需求的框架开始。这种专注的方法有助于培养实践专业知识,同时为随着需求的扩大探索其他框架奠定基础。

912

912

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?