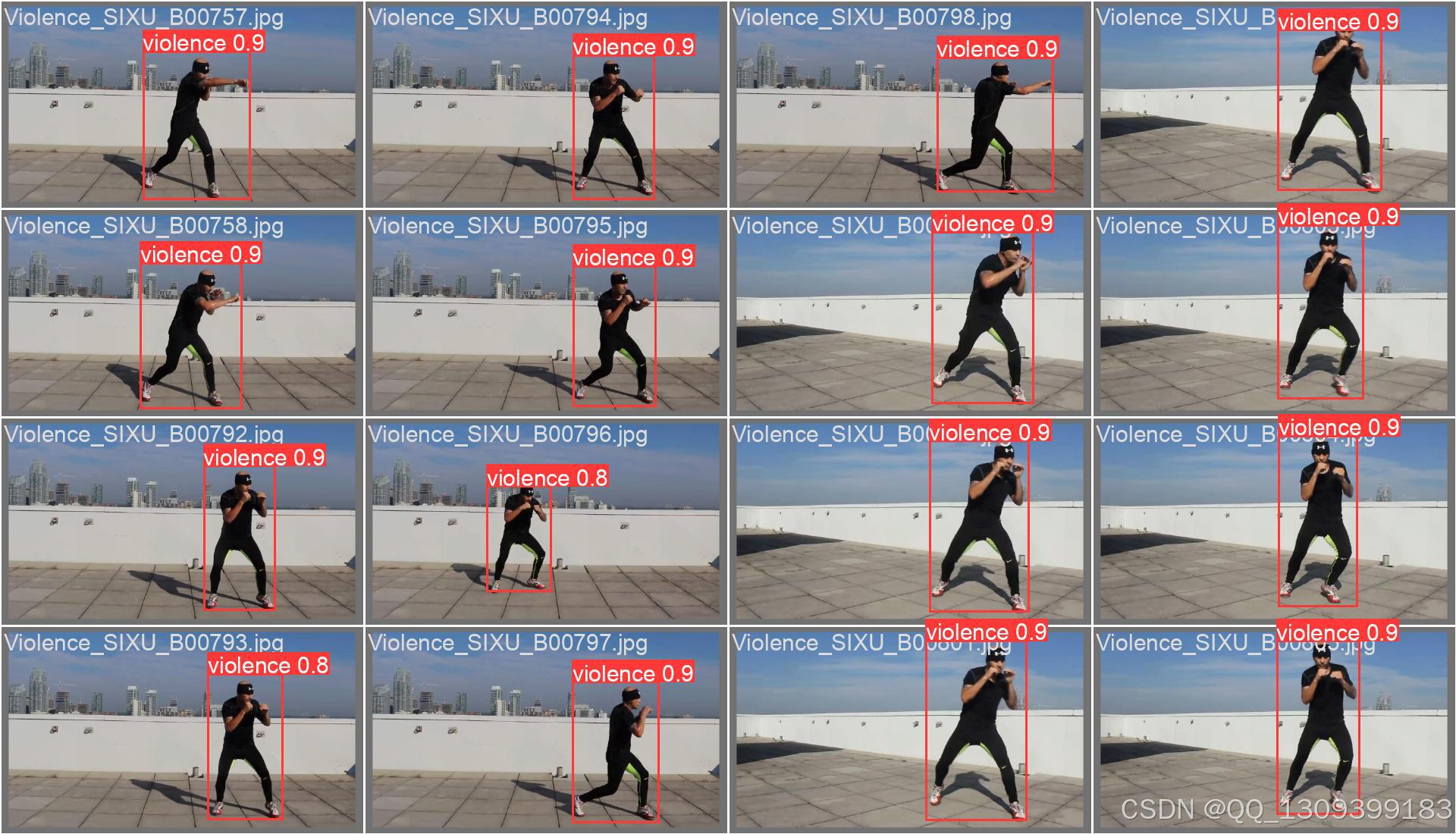

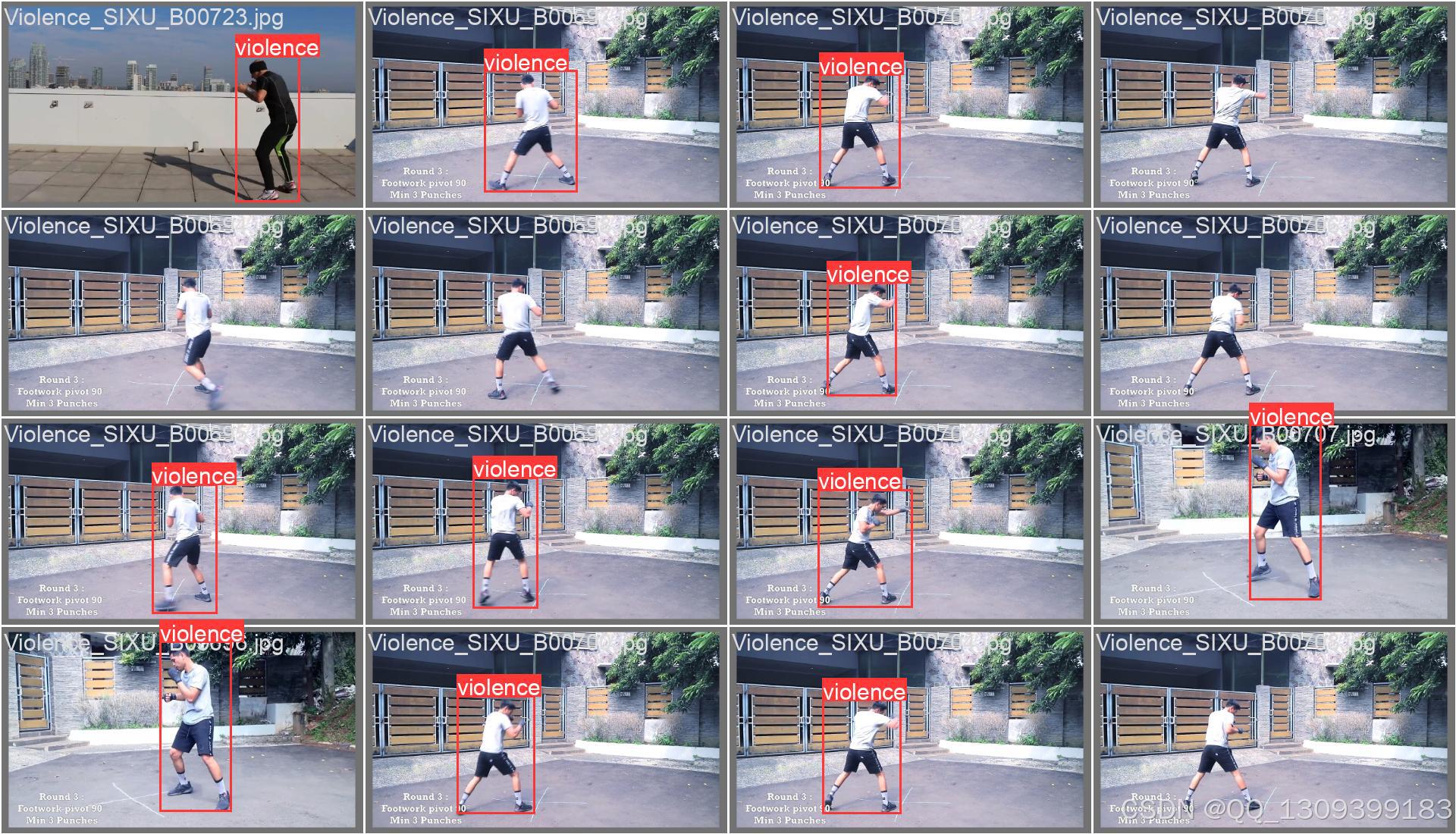

YOLOv8在打架斗殴检测中的应用与实现

随着人工智能技术的快速发展,基于深度学习的视频行为分析在安防领域扮演着越来越重要的角色。打架斗殴等暴力行为的实时检测对公共安全具有重要意义,而YOLOv8(You Only Look Once Version 8)作为目标检测领域的前沿模型,凭借其高精度、高速度和多场景适应能力,成为实现这一任务的核心技术之一。本文将从技术原理、应用场景、实现难点及解决方案等角度,系统介绍YOLOv8在打架斗殴检测中的应用。

一、YOLOv8的技术特点与改进

YOLOv8是Ultralytics团队在2023年推出的最新版本目标检测模型,继承了YOLO系列“单阶段检测”的设计理念,通过端到端的方式直接输出目标的位置和类别。相较于前代版本(如YOLOv5、YOLOv7),其核心改进包括:

- 更高效的网络结构:采用CSPNet与PANet结合的Backbone,增强特征提取能力;

- 动态标签分配策略:通过Task-Aligned Assigner优化正负样本分配,提升小目标检测精度;

- 多尺度特征融合:新增的SPPF模块(Spatial Pyramid Pooling-Fast)在减少计算量的同时提升感受野;

- 轻量化设计:支持模型剪裁和量化,适应不同硬件部署需求。

这些特性使其在复杂场景下仍能保持每秒超过100帧(FPS)的实时检测速度,同时精度(mAP)提升约5-10%,为动态行为的快速捕捉提供了技术保障。

二、打架斗殴检测的技术挑战与应对

将YOLOv8应用于暴力行为检测需解决以下核心问题:

1. 行为动态性与模糊性

打架动作通常具有快速变化、肢体交叠的特点,传统检测模型易漏检或误判。解决方案:

- 时序特征增强:结合YOLOv8与LSTM或3D卷积网络,提取连续帧的时空关联特征;

- 关键姿态检测:通过OpenPose等工具提取人体骨骼关键点,辅助识别挥拳、踢打等典型动作。

2. 复杂场景干扰

监控场景中光照变化、遮挡、人群密集等问题可能影响检测效果。应对策略:

- 数据增强:在训练集中加入模拟低光照、运动模糊、遮挡的合成数据;

- 注意力机制:在YOLOv8的Head部分引入CBAM(Convolutional Block Attention Module),强化关键区域特征。

3. 行为分类的语义鸿沟

区分“正常肢体接触”与“暴力行为”需要更高层次的语义理解。解决方法:

- 多模态融合:结合音频特征(如喊叫声)与视觉特征联合训练;

- 知识蒸馏:利用预训练的暴力行为分类模型(如SlowFast)指导YOLOv8分类头优化。

三、YOLOv8打架斗殴检测的实现流程

1. 数据准备与标注

- 数据集构建:收集公开数据集(如Surveillance Fight Dataset)及实际监控视频,覆盖不同视角、光照条件;

- 标注规范:采用视频级标签(打架/非打架)与帧级边界框标注结合,标注目标包括多人肢体接触区域、手持武器等。

2. 模型训练与优化

- 迁移学习:基于COCO预训练权重进行微调,初始学习率设为0.01,采用Cosine衰减策略;

- 损失函数改进:将原CIoU损失替换为SIoU(Soft Intersection over Union),提升遮挡场景下的定位精度;

- 难例挖掘:针对误检率高的样本(如拥抱、搬运物品)进行针对性数据增强。

3. 部署与实时推理

- 模型压缩:使用TensorRT对YOLOv8进行FP16量化,模型体积缩小至原始大小的40%;

- 边缘计算:在Jetson AGX Xavier等设备上实现1080p视频流实时处理,延迟低于50ms;

- 报警联动:检测到打架事件后自动触发声音报警、视频存储与位置推送。

四、应用场景与局限性

1. 典型应用场景

- 公共场所监控:车站、广场等区域的实时暴力预警;

- 校园安全管理:识别学生群体冲突并通知安保人员;

- 监狱与司法系统:监测囚犯异常行为,预防群体事件。

2. 现存挑战

- 伦理与隐私争议:需平衡公共安全与个人隐私保护;

- 跨场景泛化能力:模型在夜间、雨雾等极端环境下性能下降;

- 行为预判不足:现有技术难以在冲突爆发前识别潜在风险。

五、未来发展方向

- 多模态融合检测:结合红外传感器、雷达等非视觉数据提升鲁棒性;

- 轻量化-精度平衡:通过神经架构搜索(NAS)设计专用轻量模型;

- 因果推理机制:引入图神经网络(GNN)分析行为因果关系,实现早期预警。

结语

YOLOv8为打架斗殴检测提供了高效的技术框架,但其实际落地仍需解决算法精度、计算资源、伦理规范等多维度问题。随着Transformer架构、联邦学习等新技术的引入,未来的暴力行为检测系统将朝着更智能、更人性化的方向演进,为构建智慧安防生态提供核心支撑。

9236

9236

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?