声明:文章是从本人公众号中复制而来,因此,想最新最快了解各类智能优化算法及其改进的朋友,可关注我的公众号:强盛机器学习,不定期会有很多免费代码分享~

目录

足球队训练算法(Football team training algorithm,FTTA)是一种新型的元启发式算法(智能优化算法),灵感来自高水平足球训练班中球员的行为。该成果由Zhirui Tian等人于2024年发表在SCI人工智能一区顶刊Expert Systems With Applications上。

由于发表时间较短,谷歌学术上还没人引用!你先用,你就是创新!

原理简介

足球团队训练算法(FTTA)是通过模拟高水平足球训练课上球员的行为来实现的。通常,足球训练课分为三个部分:集体训练、小组训练和个人额外训练。具体行为和公式如下:

一、集体训练

训练开始时,球员们将在教练的指导下进行集体训练,教练将首先通过一系列测试(体能功能)让球员们了解自己的水平。然后球员们会根据自己的水平制定自己的集体训练计划。我们将玩家分为四种不同类型:追随者、发现者、思考者和波动者。在每次迭代中,玩家都会随机更改自己的类型。

(1)追随者

追随者是当前最佳玩家的狂热追随者,他在每个维度上都朝着最佳玩家努力,希望达到当前最佳玩家水平,但由于力量的限制,往往每个维度都只能随机移动到最佳玩家。方程式如下:

![]()

其中当前最佳玩家被定义为Fkbest,其中k是迭代次数,Fkbestj是其在维度j上的值;当前玩家定义为Fki;i是其玩家数量,Fkij是其在维度j上的值,Fkijnew是玩家在训练后在维度j的状态。

(2)发现者

发现者比追随者更理性。他们不仅看到了最好的球员,也看到了最差的球员,所以他们不仅朝着最好的球员努力,而且尽最大努力避免成为最糟糕的球员。方程式如下:

其中当前最差的玩家被定义为Fkworst,k是迭代次数,其中FkWorstj是其在维度j中的值。Fkijnew是玩家在训练后在维度j上的状态。

(3)思考者

思考者比他们面前的人更警觉,他们直接看到了最好的玩家和最差的玩家之间的差距,并努力达到每个维度的差距,方程如下:

在维度j中,FkBestj-FkWorstj是当前最佳玩家和最差玩家之间的差向量,k是迭代次数。

(4)波动者

波动性拒绝向任何人学习,他们自己训练,所以状态会有一定的波动。当然,随着训练次数的增加(迭代次数)。玩家状态的波动会越来越小,我们将玩家状态的变化定义如下:

![]()

其中,t(k)是一个具有t分布的随机数,其自由度为当前迭代次数,随着自由度的增加,t分布接近中间值(0)的概率越来越高,两端的分布逐渐减小,将越来越接近正态分布。因此,随着迭代次数的增加,波动程度会越来越小,并逐渐从全局搜索变为局部搜索。

该阶段原理解释图如下:

二、小组训练

集体训练结束后,足球训练过程已进入小组训练阶段,教练根据球员的特点将球员分为四类(每个维度都是一个特征值):前锋、中场、后卫和守门员。在分组训练中,我们使用MGEM自适应聚类方法(MixGaussEM),通过聚类方法模拟教练员的行为,并根据其自身特点将人群分为四类。具体的分类形式如下:

作者设置了一个阈值:团队人数(Teamnumber⩾2),这是每组中的最小人数。作者假设,如果组的数量小于这个值,则无法实施组训练。一旦发生这种情况,教练们将进行第二次分组,采用均匀随机分组的策略,将球员随机均匀地分为四组。

教练完成分组后,球员将与小组中的其他球员进行学习或交流。我们将群体训练定义为三种状态:最优学习、随机学习和随机交流。我们将学习概率定义为pstudy,通信概率为pcomm,玩家将在每次迭代中随机选择状态。

(1)最优学习

在每个维度中,玩家都有一定的概率直接学习小组中最好的玩家的能力值。公式定义如下:

其中Fk-teaml-Best是组l中最好的玩家,k是迭代次数,teaml代表组l,Fk-teaml-Best-j是组l的最好玩家的j维,Fk-teaml-ij-new是玩家在最优学习后在j维中的状态。

(2)随机学习

在每个维度中,玩家都有一定的概率直接学习组中任意随机玩家的能力值。公式定义如下:

其中Fk-teaml-Random是组l中的随机玩家,k是迭代次数,teaml表示组l,Fk-teaml-Random-j是组l的随机玩家的j维,Fk-teaml-ij-new是随机学习后玩家在j维中的状态。

(3)随机交流

在训练中,学习只是其中的一部分,而两个球员之间的交流对于能力的提高更为重要。在每个维度中,玩家都有一定的概率与小组中的任何玩家进行交流。

当rand⩽pcomm时,公式定义如下:

其中Fk,teamlRandom是l组中的一个随机玩家,k是迭代次数,teaml-代表l组,Fk,TEAmlRandom,j是l组随机玩家的j维,两个玩家在j维中交换了他们的能力。Randn是一个正态分布的随机数,乘以(1+Randn)表示两个玩家对他人能力的理解。

当rand>pcomm时,公式定义如下:

(4)随机误差

我们假设,在小组训练过程中,有一定的概率会出现错误,即他们不小心学会了他人其他维度的内容。出现这种情况的可能性很低,但这是真实和客观的。我们将错误概率定义为perror。

该阶段原理解释图如下:

三、个人额外训练

小组训练结束后,有必要重新计算新的体能值,并用更好的体能值代替较差的体能值来更新球员的状态。更新后,教练会选择最好的球员,让他练习,让他变得更好,这样他才能更好地带动他人的训练状态,训练公式如下:

柯西和高斯联合变异用于描述个人额外训练,k是迭代次数。之所以选择高斯柯西分布,是因为在训练的早期阶段,每个人的水平通常都不高,所以最好的球员获得更大提升的概率更大,此时柯西分布函数占据了很大的比例,可以有效地为球员提供大范围的提升,这有利于全球搜索。随着迭代次数的增加,玩家能力的提升变得越来越困难,此时高斯分布占比较大的比例,玩家的晋升范围逐渐减小,更有利于局部搜索。

算法流程和伪代码

为了使大家更好的理解,这边给出算法流程和伪代码,非常清晰!

如果实在看不懂,不用担心,可以看下代码,再结合上文公式理解就一目了然了!

性能测评

原文作者采用CEC2005和CEC2020两组测试函数对算法进行评价,并用于优化变分模分解(VMD),以提高数据去噪效果,从而提出了一种新的基于FTTA的混合风速预测系统。

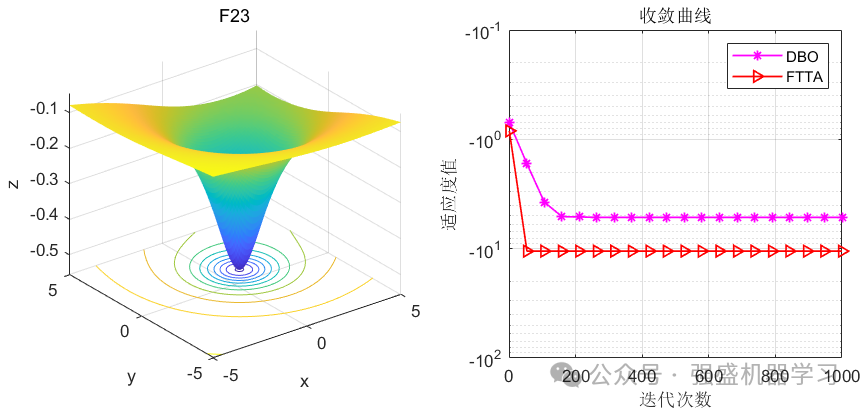

这边为了方便大家对比与理解,采用23个标准测试函数,即CEC2005,并与近年来非常火热的蜣螂优化算法DBO进行对比,这边展示5个测试函数的图~

可以看到,FTTA的效果还是非常不错的!性能极佳,在大部分函数上都超过了最近非常火热的蜣螂优化算法DBO,收敛速度也非常快,大家应用到各类预测、优化问题中是一个非常好的选择~

参考文献

[1]Tian Z, Gai M. Football team training algorithm: A novel sport-inspired meta-heuristic optimization algorithm for global optimization[J]. Expert Systems with Applications, 2024, 245: 123088.

完整代码

如果需要免费获得图中的完整测试代码,只需点击下方小卡片,后台回复关键字,不区分大小写:

FTTA

也可点击小卡片,后台回复个人需求定制FTTA优化模型(看到秒回):

1.回归/时序/分类预测类:SVM、LSSVM、ELM、KELM、HKELM、DELM、RELM、DHKELM、RF、LSTM、BiLSTM、GRU、BiGRU、PNN、CNN、BP、XGBoost、TCN、BiTCN、ESN等等均可~

2.组合预测类:CNN/TCN/BiTCN/DBN/Adaboost结合SVM/RVM/ELM/LSTM/BiLSTM/GRU/BiGRU/Attention机制类等均可(可任意搭配非常新颖)~

3.分解类:EMD、EEMD、VMD、REMD、FEEMD、CEEMDAN、ICEEMDAN、SVMD等分解模型均可~

4.其他:机器人路径规划、无人机三维路径规划、DBSCAN聚类、VRPTW路径优化、微电网优化、无线传感器覆盖优化、故障诊断等等均可~

5.原创改进优化算法(适合需要创新的同学):2024年的FTTA、NRBO、CPO、WOA等任意优化算法均可,保证测试函数效果!

1510

1510

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?