placeholder使用的时候和前面的variable不同的是在session运行阶段,需要给placeholder提供数据,利用feed_dict的字典结构给placeholdr变量“喂数据”。

import tensorflow as tf

#placeholder 传入值 运行结果时给它一个输入值,与feed_dict绑定

input1=tf.placeholder(tf.float32)

input2=tf.placeholder(tf.float32)

output=tf.multiply(input1,input2)

with tf.Session() as sess:

print(sess.run(output,feed_dict={input1:[7.0],input2:[2.0]}))结果:

[14.]tf.nn.relu tf.nn.relu6 tf.nn.crelu tf.nn.elu tf.nn.softplus tf.nn.softsign tf.nn.dropout tf.nn.bias_add tf.sigmoid tf.tanh

sigmoid:

tanh函数:

relu函数:

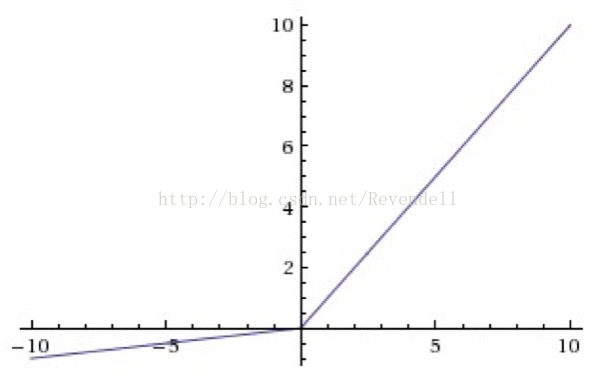

leaky relu函数:

ReLU 中当 x<0 时,函数值为 0。而 Leaky ReLU 则是给出一个很小的负数梯度值,比如 0.01。

344

344

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?