一、微调概述

微调(Fine-tuning)是将预训练大模型(如BERT、GPT-4)适配到特定领域或任务的核心技术。通过在小规模垂直数据上调整模型参数,微调可显著提升模型在目标场景中的性能,同时避免从头训练的高成本。例如,医疗领域的BioBERT在PubMed数据微调后,实体识别F1值提升12.3%。

核心价值:

数据效率:仅需1%-10%的原始训练数据(如ChatGPT医疗对话微调仅需5万条样本);

计算经济性:参数高效微调(PEFT)技术可减少90%显存占用(如QLoRA微调LLaMA-65B仅需48GB显存);

领域适配性:金融风控模型微调后欺诈检测准确率从85%提升至96%。

微调类型:

| 类型 | 代表方法 | 参数量调整比例 | 典型场景 |

|---|---|---|---|

| 全参数微调 | Fine-tuning | 100% | 数据充足、任务复杂 |

| 参数高效微调 | LoRA、Adapter | 0.1%-5% | 资源受限、快速迭代 |

| 提示微调 | Prompt Tuning | <0.01% | 零样本/少样本迁移 |

二、技术架构

1.全参数微调(Full Fine-tuning)

流程设计:

数据准备:领域数据增强(如回译、实体替换)

参数更新:解冻全部或部分层(如BERT微调仅解冻最后3层)

学习率策略:分层学习率(底层LR=1e-5,顶层LR=1e-4)

2.参数高效微调(PEFT)

LoRA(Low-Rank Adaptation):

原理:在Transformer层注入低秩矩阵(秩r=8)

优势:参数量减少98%(70B模型仅需1.4B可训练参数),精度损失<1%

Adapter:

结构:在FFN层后插入瓶颈结构(如768→64→768)

性能:SQuAD问答任务F1值达88.5(原始BERT为88.4)

3.提示微调(Prompt Tuning)

软提示(Soft Prompts):

可学习前缀:为输入添加50个可训练Token(如“Translate English to French: {text}”)

性能对比:在SuperGLUE基准上,Prompt Tuning比传统微调高3.2分

硬提示工程:

规则模板:人工设计提示词(如“Answer based on medical knowledge: {question}”)

自动化生成:AutoPrompt通过梯度搜索生成最优提示

# 使用Hugging Face PEFT库实现LoRA微调

from peft import LoraConfig, get_peft_model

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-2-7b")

lora_config = LoraConfig(

r=8,

lora_alpha=32,

target_modules=["q_proj", "v_proj"],

lora_dropout=0.05

)

model = get_peft_model(model, lora_config)

model.print_trainable_parameters() # 输出:trainable params: 0.2%

三、关键技术实现:平衡性能与效率

1.动态参数冻结

层选择性解冻:

底层冻结(保留通用特征),顶层微调(适配具体任务)

实验表明,解冻最后10%层可保留95%原始能力

梯度掩码:

对敏感参数(如位置编码)固定梯度更新,防止过拟合

2.多任务联合微调

损失函数加权:

分类任务(交叉熵) + 生成任务(困惑度)联合优化

权重动态调整(如任务不确定度加权)

知识蒸馏:

教师模型(全参数微调)指导学生模型(PEFT),F1值差距<2%

3.分布式微调框架

ZeRO-3优化:

参数分片、梯度分片、优化器状态分片(支持千亿模型单机微调)

混合精度训练:

FP16梯度通信 + BF16计算,吞吐量提升2倍(NVIDIA H100)

主流工具库对比:

| 工具库 | 核心功能 | 优势场景 |

|---|---|---|

| Hugging Face PEFT | LoRA、Adapter、Prompt Tuning | 开源模型高效微调 |

| DeepSpeed | ZeRO-3、梯度检查点 | 超大规模模型训练 |

| TensorFlow Extended (TFX) | 数据流水线、模型验证 | 企业级生产部署 |

四、未来前景

1.自动化微调(Auto-Finetuning)

超参数搜索:

贝叶斯优化自动选择学习率、批次大小(时间成本减少80%)

神经架构搜索(NAS)动态调整微调层数

提示词自动生成:

ChatGPT生成领域相关提示模板,人工干预减少90%

2.通用微调接口

统一任务格式:

文本、图像、语音任务转换为“输入-输出”标准化接口

例如,NVIDIA NeMo支持跨模态统一微调框架

多模态适配器:

Flamingo-Adapter支持图文交错输入,VQA任务准确率提升15%

3.边缘设备部署

4-bit量化微调:

QLoRA技术实现低精度训练(RTX 4090部署70B模型)

微型化模型:

TinyLlama(1.1B参数)在手机端实现实时对话(延迟<200ms)

要么驾驭AI,要么被AI碾碎

当DeepSeek大模型能写出比80%人类更专业的行业报告,当AI画师的作品横扫国际艺术大赛,这场变革早已不是“狼来了”的寓言。2025年的你,每一个逃避学习的决定,都在为未来失业通知书签名。

记住:在AI时代,没有稳定的工作,只有稳定的能力。今天你读的每一篇技术文档,调试的每一个模型参数,都是在为未来的自己铸造诺亚方舟的船票。

1.AI大模型学习路线汇总

L1阶段-AI及LLM基础

L2阶段-LangChain开发

L3阶段-LlamaIndex开发

L4阶段-AutoGen开发

L5阶段-LLM大模型训练与微调

L6阶段-企业级项目实战

L7阶段-前沿技术扩展

2.AI大模型PDF书籍合集

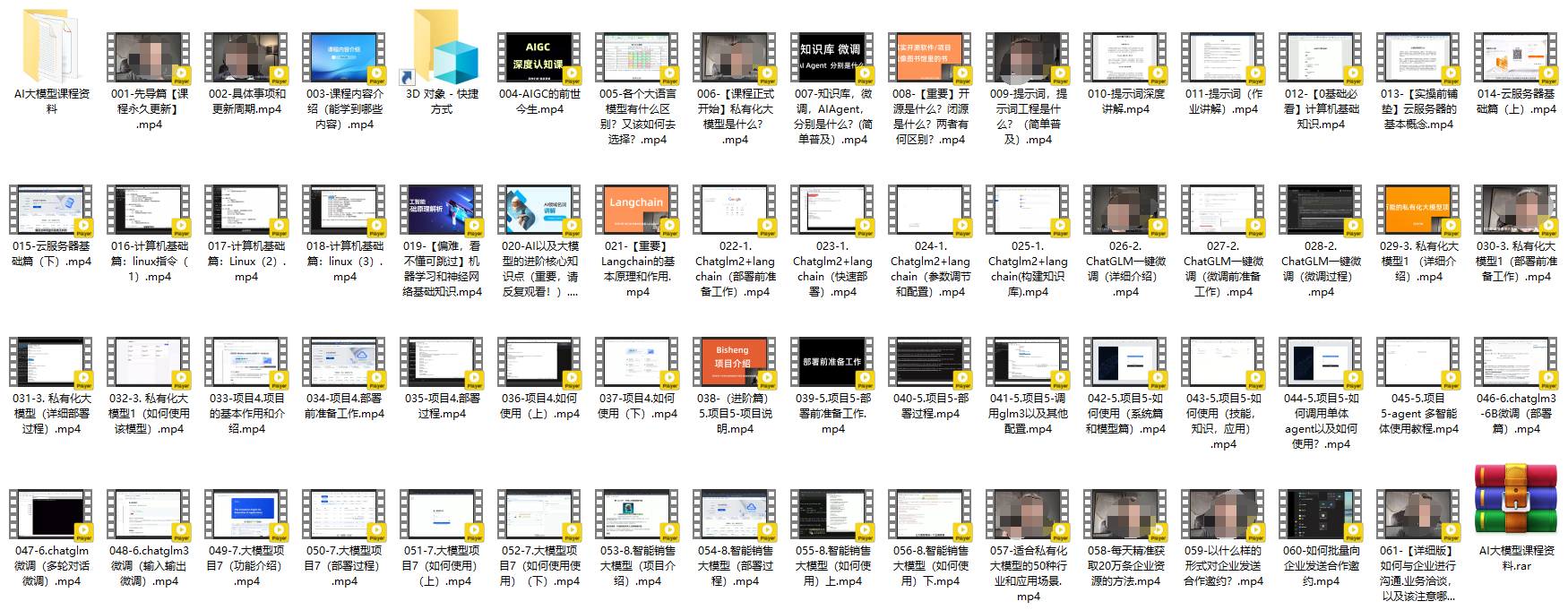

3.AI大模型视频合集

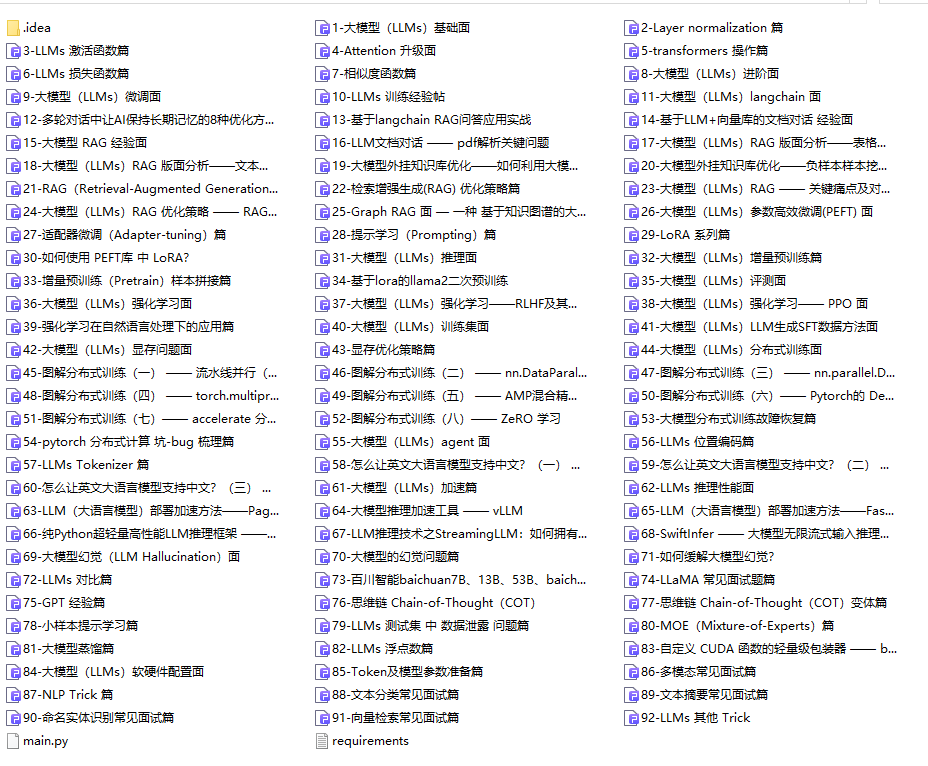

4.LLM面试题和面经合集

5.AI大模型商业化落地方案

📣朋友们如果有需要的话,可以V扫描下方二维码联系领取~

1240

1240

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?