Attention U-Net:学习在哪里寻找胰腺

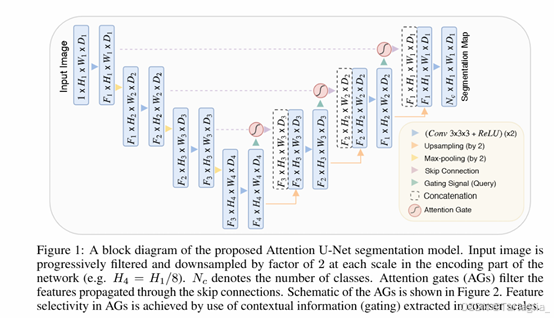

本文核心:本文提出AG模型,然后整合到U-net架构中,形成Attention U-net架构。AG模型是基于网格的门控;应用于医学成像任务的前馈 CNN 模型中软注意力技术;对标准U-net模型的扩展。

摘要

AG:本文提出了一种用于医学成像的新型注意力门(AG)模型

- 该模型可以自动学习聚焦于不同形状和大小的目标结构。

- 使用 AG 训练的模型隐式学习抑制输入图像中的不相关区域,同时突出显示对特定任务有用的显着特征。这使得能够消除在级联卷积神经网络(CNN)中使用显式外部组织/器官定位模块的必要性。

- AG 可以轻松集成到标准 CNN 架构(例如 U-Net 模型)中,以最小的计算开销,同时提高模型灵敏度和预测精度。

所提出的 Attention U-Net 架构在两个大型 CT 腹部数据集上进行了评估,用于多类图像分割。 实验结果表明,AG 持续提高了 U-Net 在不同数据集和训练规模上的预测性能,同时保持了计算效率。

1.介绍

背景

由于大量医学图像的手动密集标记是一项繁琐且容易出错的任务,因此自动医学图像分割在 图像分析界得到了广泛的研究。需要准确可靠的解决方案来提高临床工作流程效率并通过快 速自动提取定量测量结果来支持决策。

随着卷积神经网络(CNN)的出现,在自动化医学图像分析任务中可以实现接近放射科医生水平的性能,包括心脏 MR 分割和癌性肺结节检测。高表示能力、快速推理和滤波器共享特性使 CNN 成为图像分割事实上的标准。全卷积网络(FCN)和U-Net是两种常用的架构。

存在问题

当目标器官在形状和大小方面表现出较大的患者间差异时,这些架构依赖于多级级联CNN。级联框架提取感兴趣区域 (ROI) 并对该特定 ROI 进行密集预测,会导致计算资源和模型参数的过度和冗余使用,例如:级联内的所有模型都会重复提取类似的低级特征。级联架构应用领域包括心脏MRI、心脏CT、腹部CT分割和肺部CT结节检测。

解决办法

为了解决这个普遍问题,本文提出了一个简单而有效的解决方案,即注意力门(AG)。

- 具有 AG 的 CNN 模型可以按照类似于 FCN 模型训练的标准方式从头开始训练,AG 会自动学习聚焦于目标而无需额外监督的结构。

- 在测试时,注意力门会即时隐式生成软区域建议,并突出显示对特定任务有用的显着特征,并且它们不会引入显着的计算开销,也不需要像多模型框架那样需要大量模型参数。

- 作为回报,所提出的 AG 通过抑制不相关区域中的特征激活来提高密集标签预测的模型灵敏度和准确性。这样可以消除使用外部器官定位模型的必要性,同时保持高预测精度。

类似的注意力机制已经被提出用于自然图像分类和字幕来执行自适应特征池,其中模型预测仅以选定图像区域的子集为条件。在本文中,概括了这种设计并提出了基于图像网格的门控,该门控允许注意力系数特定于局部区域。

此外,该方法可用于基于注意力的密集预测。本文演示了 AG 在标准 U-Net 架构(Attention U-Net)中的实现,并将其应用于医学图像,然后选择具有挑战性的 CT 胰腺分割问题来提供实验证据。由于组织对比度低以及器官形状和大小的巨大变化,这个问题构成了一项艰巨的任务。本文根据两个常用基准评估:TCIA 胰腺 CT -82和多类腹部 CT -150。结果表明,AG 持续提高了不同数据集和训练规模的预测准确性,同时无需多个 CNN 模型即可实现最先进的性能。

1.1相关工作

CT 胰腺分割

验证级联CNN必要性

腹部 CT 胰腺分割的早期工作使用统计形状模型或多图谱技术,尤其图集方法

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2519

2519

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?