Domain Generalization: A Survey

文章连接:Domain Generalization: A survey

另一篇综述:

文章目录

摘要

对分布外(OOD)数据的泛化是人类的一种自然能力,但机器很难复制。这是因为大多数学习算法强烈依赖于源/目标数据的i.i.d假设,而在实践中由于域移位而经常违反这一假设。领域泛化(DG)旨在通过只使用源数据进行模型学习来实现面向对象的泛化。在过去的十年里,DG的研究取得了很大的进展,产生了广泛的方法,例如,基于领域对齐、元学习、数据增强或集成学习的方法;DG在计算机视觉、语音识别、自然语言处理、医学成像和强化学习等多个应用领域也得到了研究。在本文中,首次提供了一个全面的文献综述,以总结过去十年的发展。具体来说,我们首先通过正式定义DG并将其与其他相关领域(如领域适应和迁移学习)联系起来来介绍背景。然后,我们对现有的方法和理论进行了全面的回顾。最后,我们对本次调查进行了总结,并对未来的研究方向进行了展望和讨论。

引言

如果一个图像分类器是在照片图像上训练的,它能在素描图像上工作吗?如果使用城市图像训练的汽车探测器在农村环境中进行测试呢?是否有可能部署在雨雪天气条件下使用阳光图像训练的语义分割模型?使用一个病人的心电图数据训练的健康状态分类器可以用来诊断另一个病人的健康状态吗?所有这些问题的答案取决于机器学习模型如何处理一个常见问题,即域转移问题。该问题是指一组训练(源)数据与一组测试(目标)数据之间的分布移位[1],[2],[3],[4],[5]。

大多数统计学习算法强烈依赖于一个过于简化的假设,即源数据和目标数据是独立且同分布的(i.i.d),而忽略了分布外(OOD)的情况在实践中经常遇到。这意味着它们在设计时没有考虑到领域转移问题,因此,仅使用源数据训练的学习代理通常会在OOD目标领域上遭受显著的性能下降。

领域转移问题严重阻碍了机器学习模型的大规模部署。有人可能会好奇,深度神经网络的最新进展[6],[7],被称为深度学习[8],可以缓解这个问题。[2],[9],[10]的研究表明,深度学习模型的性能在OOD数据集上显著下降,即使数据生成过程中只有很小的变化。这突出了一个事实,即迄今为止深度学习取得的成功在很大程度上是由大规模带注释的数据集(如ImageNet[11])的监督学习驱动的——同样依赖于i.i.d.假设。

在许多应用程序中,在部署模型之前很难获得目标数据,甚至未知目标数据。例如,在生物医学应用中,不同患者的数据之间会发生域移位,提前收集每个新患者的数据是不切实际的[19];在交通场景语义分割中,不可能采集所有不同场景和所有可能天气条件下的数据[20];在处理数据流时,还要求模型具有内在的可泛化性[21]。

为了克服域移位问题,以及目标数据的缺失,引入了域泛化(DG)问题[22]。具体来说,DG的目标是使用来自单个或多个相关但来自不同的源域的数据来学习模型,这样模型可以很好地推广到任何OOD目标域。

自2011年Blanchard等人[22]首次正式引入以来,已经开发了大量方法来解决OOD泛化问题[23],[24],[25],[26],[27],[28],[29],[30]。这包括基于对齐域不变表示学习的源域分布的方法[31],[32],通过元学习[33],[34]在训练过程中使模型暴露于域移位,以及通过域合成增加数据[35],[36]等等。从应用的角度来看,DG不仅在计算机视觉领域如物体识别[37]、[38]、语义分割[20]、[39]和行人的再识别[23]、[35]中得到了研究,而且在其他领域如语音识别[40]、自然语言处理[34]、医学成像[41]、[42]、强化学习[23]等方面也得到了研究。

在本次调查中,我们旨在提供及时而全面的文献综述,主要从技术角度总结过去十年发展的学习算法,并为未来的研究方向提供见解。

2 背景

2.1 领域泛化简史

域泛化(DG)问题最初是由Blanchard等人[22]作为机器学习问题正式提出的,而术语域泛化后来由Muandet等人[19]创造。与其他相关的学习问题(如领域适应或迁移学习)不同,DG考虑了在模型学习过程中目标数据不可访问的场景。在[22]中,DG背后的动机源于一种称为流式细胞术数据自动门控的医学应用。目标是设计算法,使患者血液样本中基于不同性质的细胞分类过程自动化,例如,区分淋巴细胞和非淋巴细胞。这种技术对于促进对患者健康状况的诊断至关重要,因为手动门控非常耗时,并且需要特定领域的专业知识。然而,由于不同患者数据之间的分布转移,使用历史患者数据学习的分类器不能推广到新患者,同时,收集新数据进行模型微调是不切实际的,从而激发了DG问题的研究。

在计算机视觉领域,Torralba和Efros[43]所做的一项开创性工作引起了对跨域泛化问题的关注。他们使用六个流行的基准数据集对目标识别模型的跨数据集泛化性能进行了彻底的调查。他们的发现表明,难以避免的数据集偏差可能导致较差的泛化性能。例如,如[43]所示,在Caltech101[44]上训练的人分类器在LabelMe[45]上获得了非常低的准确率(11.8%),尽管其相同数据集的性能接近完美(99.6%)。随后[43],Khosla等[46]针对分类和检测任务中的跨数据集泛化问题,提出了基于支持向量机(support vector machine, SVM)分类器学习领域特定的偏置向量和领域不可知的权重向量。

2.2 问题定义

我们首先介绍一些将在整个调查中使用的符号。设

X

\mathcal{X}

X 为输入(特征)空间,

Y

\mathcal{Y}

Y 为目标(标签)空间,将域定义为

X

×

Y

\mathcal{X}\times \mathcal{Y}

X×Y 上的联合分布

P

X

Y

P_{XY}

PXY。对于特定的域

P

X

Y

P_{XY}

PXY,我们称

P

X

P_{X}

PX为

X

X

X 上的边际分布,

P

Y

∣

X

P_{Y|X}

PY∣X为给定 X 的 Y 的后验分布,

P

X

∣

Y

P_{X|Y}

PX∣Y为给定

Y

Y

Y 的

X

X

X 的类条件分布。

在DG的背景下,我们可以访问 K 个相似但不同的源域

S

=

{

S

k

=

{

(

x

(

k

)

,

y

(

k

)

)

}

k

=

1

K

}

S=\{S_k=\{(x^{(k)}, y^{(k)})\}_{k=1}^K\}

S={Sk={(x(k),y(k))}k=1K}与联合分布

P

X

Y

(

k

)

P_{XY}^{(k)}

PXY(k) 相关联,

P

X

Y

(

k

)

≠

P

X

Y

(

k

′

)

,

k

≠

k

′

,

k

,

k

′

∈

{

1

,

.

.

.

,

K

}

P_{XY}^{(k)}\neq P_{XY}^{(k^{'})},k\neq k^{'}, k,k^{'}\in \{1,..., K\}

PXY(k)=PXY(k′),k=k′,k,k′∈{1,...,K}。DG的目标是学习一个仅使用源域数据的预测模型

f

:

X

→

Y

f:\mathcal{X}→\mathcal{Y}

f:X→Y,从而使未知目标域

T

=

x

T

T= {x^T}

T=xT上的预测误差最小化。目标域

T

T

T 对应的联合分布用

P

X

Y

T

P_{XY}^T

PXYT表示。同时

P

X

Y

(

k

)

≠

P

X

Y

T

,

∀

k

∈

{

1

,

.

.

.

,

K

}

P_{XY}^{(k)}\neq P_{XY}^{T}, \forall k\in \{1,..., K\}

PXY(k)=PXYT,∀k∈{1,...,K}.

多源DG。通常在两种不同的环境下研究DG,即多源DG和单源DG。大多数研究都致力于多源设置,即假设存在多个不同但相关的域(即K > 1)。如[22]所述,研究DG的最初动机是利用多源数据来学习对不同边际分布不变的表示。这是有意义的,因为在没有访问目标数据的情况下,源学习模型很难很好地泛化。因此,使用多个域允许模型发现跨源域的稳定模式,从而更好地推广到不可见的域。

单一DG。相比之下,单源设置假设训练数据是同质的,即它们是从单个域(K = 1)中采样的。这个问题与OOD鲁棒性的主题密切相关[9],[47],[48],研究图像损坏下的模型鲁棒性。从本质上讲,单源DG方法不需要域标签来学习,因此它们也适用于多源场景。事实上,大多数能够解决单源DG的现有方法并没有将自己区分为单源或多源方法,而是一种更通用的OOD泛化解决方案,实验涵盖了单源和多源数据集[49],[50],[51],[52]。

2.3 数据集和应用

DG在计算机视觉、语音识别、医学成像等多个应用领域得到了广泛的研究。表1总结了基于不同应用程序的常用数据集。下面我们将简要讨论它们的基础知识。

手写数字识别。常用数字数据集包括MNIST [54]、MNIST-M [15]、SVHN [55]、和SYN[15]。通常,这些数据集在字体样式、笔画颜色和背景方面有所不同。MNIST包含手写数字的图像。MNIST- m将MNIST的图像与随机色块混合在一起。SVHN包含街景房号图像,而SYN是合成数据集。图1a给出了一些示例图像。旋转也被用来合成域移[53]。

目标识别。一直是DG中最常见的任务,其中领域转移在不同领域之间存在很大差异数据集。在VLCS[56]和Office-31[12]中,域漂移主要是由环境或视点的变化引起的。如图1b所示,VLCS中的场景因城市和农村地区而异,并且视点通常偏向于侧面视图或非规范视图。图像样式的变化也被广泛研究,例如PACS37、OfficeHome[59]、DomainNet[60]和ImageNetSketch[51]。其他类型的领域转移包括合成虚拟现实[56]、人为破坏[9]和数据源[67]。

动作识别。学习一般化表示对于视频理解也很重要,比如动作识别。IXMAS[68]被广泛用作跨视角动作识别基准[31],[94],它包含从五个不同视角收集的动作视频。除了视图更改之外,不同的主题或环境(如室内与室外)也可以创建域转移并导致模型失败。

语义分割。对自动驾驶至关重要。尽管深度神经网络在这项任务上已经取得了很大的进步,但在将训练好的深度模型部署到新场景(如新城市或未知天气条件)时,性能仍然远远不能令人满意[95]。由于收集涵盖所有可能场景的数据是不切实际的,因此DG在促进语义分割系统的大规模部署方面至关重要。SYNTHIA数据集[72]包含不同天气条件下不同位置的合成图像。从GTA5[74]到cityscape[75]等真实图像数据集的泛化也得到了广泛的研究[96]。

人员重新识别(重新id)。在安全和监控应用中起着关键作用。Person re-ID本质上是一个实例检索任务,旨在匹配不相交的摄像机视图(每个视图都被视为一个不同的域)中的人员。re-ID中的大多数现有方法[97]、[98]、[99]、[100]、[101]都集中在相同的数据集设置上,即在同一组相机视图上进行训练和测试,性能几乎达到饱和。最近,跨数据集re-ID[102],[103],[104]引起了广泛关注:目标是将模型从源摄像机视图推广到未见的目标摄像机视图,这是一种更具挑战性但更现实的设置。在图像分辨率、视点、光照条件、背景等方面,往往会发生域移。

人脸识别。近年来在深度学习的推动下取得了重大进展[105],[106],[107]。然而,一些研究[78]表明,即使在MS-Celeb-1M[108]等大规模数据集上训练的深度模型,在部署到具有以前未见过的域的新数据集时,性能也会大幅下降,例如低分辨率[109]、[110]、[111]、光照/遮挡/头部姿势的大变化[112]、[113]、[114]或完全不同的视点[115]。

人脸抗欺骗。旨在防止人脸识别系统受到使用假人脸的攻击[116],如打印的照片、视频或3D面具。传统的人脸防欺骗方法没有考虑到分布移位,使其容易受到看不见的攻击类型[117]。没有专门为这项任务设计的DG数据集。一种常见的做法是将几个人脸抗欺骗数据集结合起来进行模型训练,并对一个看不见的数据集进行评估,例如使用casia mfsd[79]、oulunpu[80]和MSU-MFSD [81]源和Idiap重放攻击[82]为目标。

语音识别。由于人们说话的方式不同(例如音调或音高不同),因此很自然地将每个说话者视为一个域[40]。常用的数据集是Google Speech Command[83],它由1888个域(speaker)和大约65000个样本组成。

情绪的分类。是自然语言处理中研究的一个常见任务,其目的是将文本中的观点分类为积极或消极(因此是一个二元分类问题)[34]。亚马逊评论[84]包含四类(领域)产品的评论:书籍、DVD、电子产品和厨房用具。

WILDS基准。最近被引入,目的是研究野外面临的分布转移[85]。该基准总共包含10个数据集,涵盖了广泛的模式识别任务,如动物分类、癌症检测、分子分类和卫星成像。表1显示了DG社区常用的三个WILDS数据集[118],[119], [120].

医学成像。DG对医学成像也至关重要,其中域移位通常与临床中心或患者的变化有关[42],[121]。两种常用的医学成像数据集是多位点前列腺MRI分割[42]和胸部x射线[89],每个数据集都包含来自多个临床中心的数据,这些数据都是由不同的扫描仪或采集方案引起的域偏移。

强化学习(RL)。与监督学习或无监督学习相比,强化学习的模式截然不同:强化学习的目标是通过与环境的持续互动来最大化获得的奖励。强化学习中的泛化一直是一个关键问题,因为在训练环境中学习的智能体或策略经常会出现过拟合,因此对未知环境的泛化能力很差[92],[122],[123],[124]。强化学习中的领域转移主要与环境变化有关,例如不同的场景、状态甚至奖励。有大量的工作集中在提高强化学习的泛化。我们建议读者参考[125],以获得关于泛化强化学习主题的更全面的调查。

2.4 验证

DG算法的评估通常遵循leave-one - domain out规则[37]:给定至少包含两个不同域的数据集,其中一个或多个被用作模型训练的源域,而其余的被视为目标域;从源领域学习的模型直接在目标领域中进行测试,而不需要任何形式的适应。研究了两种问题:单源和多源DG。值得注意的是,一些数据集包含标签移位,这意味着标签之间来源和目标的空间变化(称为异质DG[38])。例如,在人员重新识别问题中,培训和测试之间的身份不同;在这种情况下,源学习表示直接用于图像匹配。

评价指标。通常采用两个指标,即平均和最差情况下的性能。前者关注搁置域的平均性能,这在大多数域转移场景中使用。相比之下,后者侧重于在搁置域中表现最差的域,这通常用于子种群的情况shift[126],并已被因果推理界[127]以及WILDS基准中的一些数据集广泛采用[85]。

模型的选择。关注选择哪个模型(检查点)、架构或超参数进行评估,最近被[128]确定为评估管道中的关键步骤。如文献[128]所述,有三个模型选择标准:1)训练域验证,它提供了一个训练数据子集用于模型选择;ii) Leaveone-domain-out验证,保留一个源域用于模型选择;iii)测试域验证(oracle),它使用测试域数据的随机子集执行模型选择。如[128]所示,最后一个标准会导致过于乐观或悲观的结果,因此应谨慎使用。来自[128]的另一个重要教训是,当使用更大的神经网络和对超参数的广泛搜索时,专门设计的DG方法通常与普通模型(称为经验风险最小化)表现相似。因此,建议未来的评估应涵盖不同的神经网络架构,并确保使用相同的模型选择标准进行比较。

2.5 相关主题

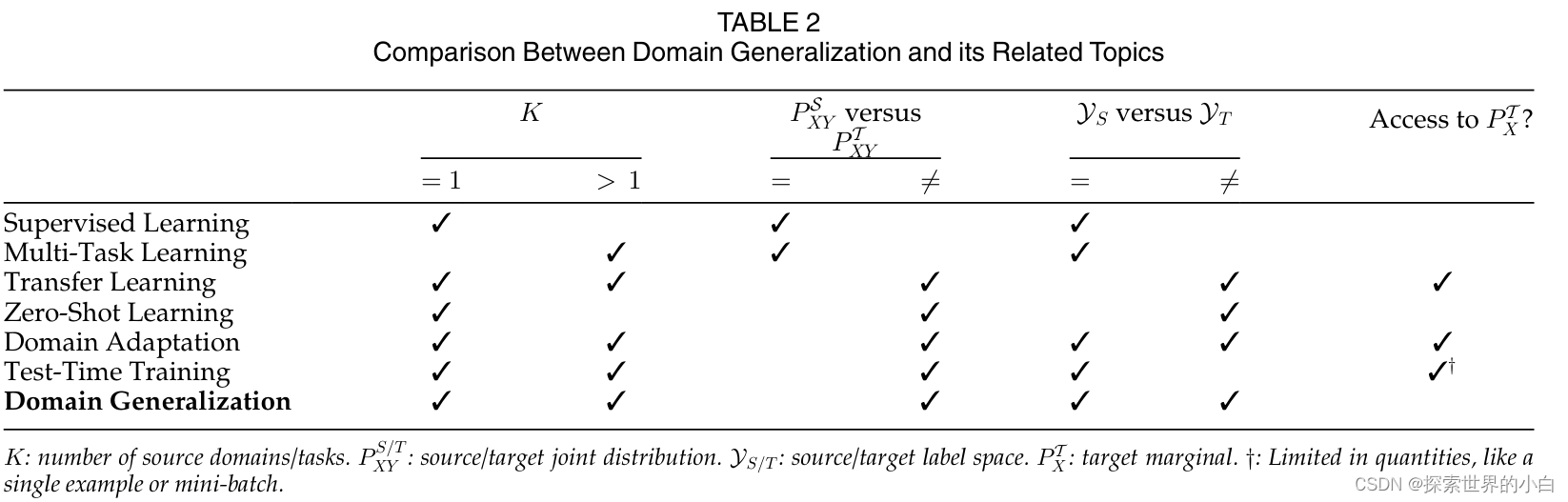

在本节中,我们将讨论DG及其相关主题之间的关系,并澄清它们之间的差异。见表2。

**监督学习(SL)**通常旨在通过最小化以下风险来学习输入-输出映射

E

(

x

,

y

)

∼

P

^

X

Y

l

(

f

(

x

)

,

y

)

\mathbb{E}_{(x,y)\sim \hat{P}_{XY}}l(f(x),y)

E(x,y)∼P^XYl(f(x),y),其中

P

^

X

Y

\hat{P}_{XY}

P^XY 表示经验分布,而不是实际数据分布

P

X

Y

P_{XY}

PXY,这是无法获得的。我们希望,一旦损失最小化,学习到的模型可以很好地处理从

P

X

Y

P_{XY}

PXY 生成的数据,而

P

X

Y

P_{XY}

PXY 严重依赖于i.i.d假设。SL和DG的关键区别在于,后者的训练和测试数据来自不同的分布,因此违反了i.i.d假设。DG在实际应用中可以说是一个更实际的设置[43]。

多任务学习(MTL)。MTL的目标是使用单个模型同时学习多个相关任务(K > 1)[129],[130],[131],[132],[133]。如表2所示,MTL的目标是使模型在训练模型的同一组任务上表现良好(

Y

S

=

Y

T

\mathcal{Y}_S=\mathcal{Y}_T

YS=YT),而DG的目标是将模型推广到不可见的数据分布(

P

X

Y

S

≠

P

X

Y

T

P_{XY}^S\neq P_{XY}^T

PXYS=PXYT)。尽管在此背景下问题的角度不同,MTL范式已经在一些DG方法中被利用,特别是那些基于自监督学习的DG方法[49],[134],[135]。直观地说,MTL受益于参数共享带来的正则化效应[129],这可能部分解释了为什么MTL范式适用于DG。

迁移学习(TL)。旨在将从一个(或多个)问题/领域/任务中学到的知识转移到不同但相关的问题/领域/任务中[136]。当代深度学习中一个著名的TL例子是微调:首先在大规模数据集上预训练深度神经网络,例如用于视觉模型的ImageNet[11]或用于语言模型的BooksCorpus [137];然后在下游任务中对它们进行微调[138]。鉴于预训练的深度特征具有高度可转移性,如几项研究[139],[140]所示,最近的一些DG作品[141],[142]研究了如何在从源合成数据中学习新知识时保留通过大规模预训练学习到的可转移特征,以用于合成到实际应用。如表2所示,TL和DG的一个关键区别在于是否使用目标数据。在TL中,目标数据需要用于新的下游任务的模型微调,而在DG中,我们假设无法访问目标数据,因此更关注模型泛化。然而,TL 和 DG 有一些相似之处:TL 和 DG 中的目标分布与源分布不同;在标签空间方面,TL主要关注不相交的标签空间,而DG则同时考虑两种情况,即齐次DG的相同标签空间和异构DG的不相交标签空间。

零射击学习(ZSL)。与DG相关,因为这两个问题的目标都是处理看不见的分布。不同的是,除了广义ZSL[146]在测试时同时考虑新旧类外,ZSL中的分布移位主要是由标签空间变化[143]、[144]、[145]引起的,即

P

Y

S

≠

P

Y

T

P_{Y}^S\neq P_{Y}^T

PYS=PYT,因为任务是识别新类;而在DG中,域移位主要是由协变量移位引起的[19],即只有边际分布发生变化(

P

X

S

≠

P

X

T

P_{X}^S\neq P_{X}^T

PXS=PXT)为了识别ZSL中看不见的类,一种常见的做法是学习输入图像空间和属性空间之间的映射[148],因为标签空间在训练数据和测试数据之间是不相交的。有趣的是,在DG中,属性也被用于学习域泛化表示[149]。

域适应(DA)。是最接近DG的话题,在文献中得到了广泛的研究[13],[14],[15],[16], [17], [95], [150], [151], [152], [153].DA 和 DG旨在解决在新的测试环境中遇到的领域转移问题(例如,

P

X

Y

S

≠

P

X

Y

T

P_{XY}^S\neq P_{XY}^T

PXYS=PXYT)。不同的是,DA 假设稀疏标记[154]或未标记[150]的目标数据可用于模型自适应,因此可以访问边际

P

X

T

P_{X}^T

PXT。尽管存在不同的 DA 变体,其中一些方法在训练过程中不明确使用目标数据,例如zero-shot DA[155]利用与任务无关但与目标领域相关的数据(相当于访问边缘),但其主要思想保持不变,即:利用公开与目标域相关信息的其他数据。如表2所示,DA 研究与 DG 有一些共性,如单源 DA [150]和多源DA [60],以及异构 DA [17]、[156]、[157]、[158]。

测试时间训练(TTT)。也称为测试时间适应[159],模糊了DA和DG之间的界限。如表2所示,TTT与DA和DG都相关,因为TTT也处理域移位问题。一方面,TTT(大部分)与无源 DA (source-free DA)相似[160],两者都假设模型训练后源数据不可访问。另一方面,TTT与 DA 的不同之处在于,只有单个[161]或小批量[162]测试数据用于模型调优,这通常以在线方式完成[163],当然,没有人工监督。值得一提的是,TTT社区使用的数据集与DG中的数据集有很大重叠,如CIFAR-C[9]和ImageNet-C[9]。在性能方面,TTT可能优于DG[162],因为它使用测试数据进行参数更新,但仅限于部署设备具有足够计算能力的场景。此外,如果调优时间太长,TTT可能不适合实时应用程序。

3 方法:综述

在过去的十年中,已经提出了许多领域泛化(DG)方法,尽管有些方法不明确要求域标签进行学习,因此也适用于单源DG,但大多数方法都是针对多源DG设计的。在本节中,我们根据其方法和设计背后的动机将现有的DG方法分为几组。在每个小组中,我们进一步讨论了不同的变体,并指出是否需要领域标签来学习区分它们的用途——那些需要领域标签的只能应用于多源DG,而那些不需要领域标签的既适用于单源DG,也适用于多源DG。有关概述,请参见表3。

3.1 域对齐

大多数现有的DG方法属于领域对齐的范畴[19],[31],[32],[117],[169],[172],其中心思想是最小化源域之间的差异,以学习域不变表示(见图2)。动机很简单:对源域移动不变的特征也应该对任何未知的目标域移动具有鲁棒性。域对齐在许多DG应用中得到了应用,如物体识别[32]、[53]、动作识别[31]、人脸防欺骗[117]、[178]和医学成像分析[173]、[180]。域对齐方法需要域标签。

为了测量分布之间的距离,从而实现对齐,我们可以借用各种各样的统计距离度量,例如简单的l2距离、f-散度或更复杂的Wasserstein距离[217]。然而,设计一种有效的领域对齐方法是一项重要的任务,因为需要考虑对齐什么以及如何对齐。在接下来的章节中,我们将从这两个方面分析现有的基于对齐的DG方法。

3.1.1 对齐什么

回想一下,一个域是由一个联合分布P(X, Y)建模的(背景见2.2节),我们可以将其分解为

P

(

X

,

Y

)

=

P

(

Y

∣

X

)

P

(

X

)

=

P

(

X

∣

Y

)

P

(

Y

)

P(X,Y)=P(Y|X)P(X)=P(X|Y)P(Y)

P(X,Y)=P(Y∣X)P(X)=P(X∣Y)P(Y)DG中一个常见的假设是,分布移位只发生在边缘P(X),而后验P(YIX)保持相对稳定[19]。因此,许多域对齐方法都集中在对齐源域的边缘分布上[19]、[31]、[164]、[165]。

从因果学习的角度来看[218],只有当

X

X

X 是

Y

Y

Y 的原因时,对

P

(

X

)

P(X)

P(X) 进行对齐才有效。在这种情况下,

P

(

Y

∣

X

)

P(Y|X)

P(Y∣X) 不与

P

(

X

)

P(X)

P(X) 耦合,因此当

P

(

X

)

P(X)

P(X) 变化时保持稳定。然而,也有可能

Y

Y

Y 是

X

X

X 的原因,因此

P

(

X

)

P(X)

P(X) 的移位也会影响

P

(

Y

∣

X

)

P(Y|X)

P(Y∣X)。因此,一些领域对齐方法[32]、[166]、[168]提出,假设

P

(

Y

)

P(Y)

P(Y) 不变,转而对齐类条件

P

(

X

∣

Y

)

P(X|Y)

P(X∣Y)。例如,Li等人[166]通过最小化所有类的跨源域的类条件分布的方差来学习特征变换。为了允许

P

(

Y

)

P(Y)

P(Y) 随

P

(

X

∣

Y

)

P(X|Y)

P(X∣Y) 而变化,即异质DG, Hu等[168]通过去除边际分布的最小化约束,放宽了[166]中的假设,并提出了几种差异度量来学习可推广的特征。

由于后验

P

(

Y

∣

X

)

P(Y|X)

P(Y∣X) 是我们在测试时需要的,Wang等人[172]引入了假设不变表示,这是通过通过Kullback-Leibler (KL)散度直接对齐每个类内的后验而获得的,而不考虑域。

3.1.1 如何对齐

在上一节讨论了要对齐的内容之后,这里我们转向DG文献中用于分布对齐的确切技术。

最小化矩。矩是用于测量分布的参数,例如在总体上计算的均值(一阶矩)和方差(二阶矩)。因此,为了实现源域之间的不变性,可以带着目标学习映射函数(例如,一个简单的投影矩阵[165]或一个由深度神经网络建模的复杂非线性函数[167])通过方差[19],[164]或均值和方差[165],[166],[167],[168]来最小化源域之间变换后的特征的矩。

最大限度地减少对比损失。是减少分布不匹配的另一种选择[169],[170],[171],它考虑了语义标签。这里有两个关键的设计原则。第一个是关于如何构建锚组、正样本组(与锚相同的类别,但来自不同的领域)和负样本组(与锚不同的类别)。第二个是关于距离函数的公式(例如,使用

l

2

l_2

l2[169]或softmax[171])。目标是把锚和积极的群体拉到一起,而把锚和消极的群体推开。

最小化KL散度。作为一种常用的分布散度度量,KL散度也被用于区域比对[172],[173]。在[172]中,每个类中的领域不可知论后验通过KL散度对齐。在[173]中,KL散度用于强制所有源域特征与高斯分布对齐。

最小化最大平均差异(MMD)。MMD距离[219]通过首先将实例映射到再现核希尔伯特空间(RKHS),然后测量两个概率分布之间的散度根据它们的平均值计算距离。Li等人[31]利用自编码器架构最小化了隐藏层特征上源域分布之间的MMD距离,同时通过对抗性学习迫使特征分布与先验分布相似[220]。

Domain-Adversarial学习。与MMD等显式距离度量不同,对抗性学习[220]通过极大极小二人博弈来表述分布最小化问题。最初由Goodfellow等人[220]提出,使用对抗学习来训练生成模型,该模型将随机噪声作为输入并生成逼真的图像。这是通过学习鉴别器来区分真实图像和生成的假图像(即最小化二进制分类损失),同时鼓励生成器欺骗鉴别器(即最大化二进制分类损失)来实现的。特别是,[220]中的作者从理论上证明了生成对抗学习等同于最小化真实分布与生成分布之间的Jensen-Shannon散度。因此,使用对抗性学习进行分布对齐是很自然的,在对齐源-目标分布的域适应领域已经进行了广泛的研究[15],[221],[222],[223]。

在DG中,在源域之间进行对抗性学习,以学习在新域中工作的源域不可知特征[32],[117],[174],[175],[176]。简单地说,学习目标是使特征混淆一个域鉴别器,它可以被实现为一个多类域鉴别器[177],[179],[180],或者一个基于每个域的二元域鉴别器[32],[117]。通常,学习步骤在特征生成器和域鉴别器之间交替进行[32]。然而,可以通过使用梯度反转层[15]来翻转从域鉴别器反向传播的梯度的符号[178]来简化过程以实现单步更新。

为了增强领域对齐,研究人员还将领域对抗学习与显式距离度量(如矩最小化[174])或一些正则化约束(如熵[181])相结合。

多任务学习。也探索了域对齐[53],[206]。与直接最小化分布散度不同,MTL通过参数共享来促进通用特征的学习[129]。这很容易理解:为了同时处理不同的任务,功能必须足够通用。在[53]中作者提出了一种去噪自动编码器架构(后来在[206]中采用),其中编码器是共享的,但解码器被分成特定领域的分支,每个分支连接到重建任务。该模型的训练有两个目标,一个是自域重构,另一个是跨域重构,目的是使隐藏的表征尽可能的通用。

区域对齐仍然是DG研究的一个热门方向。这一观点在领域适应(domain adaptation, DA)文献中也得到了广泛的研究[15]、[16]、[151]、[224]、[225],但理论支持较为严谨[3]。特别是[3]中引入的DA理论表明,最小化源与目标之间的分布分歧对于降低目标误差的上界有着巨大的影响。然而,在DG中,我们不能访问目标数据,因此,只在源域之间执行对齐。这不可避免地提出了一个问题,即学习到的对源域移位不变的表示是否保证推广到目标数据中不可见的域移位。为了解决这个问题,人们可以专注于发展新的理论来解释源域的对齐如何提高不可见域的泛化。

3.2 元学习

元学习是一个快速发展的领域,应用于许多机器学习和计算机视觉问题[33],[42],[94],[103],[226]。元学习也被称为“从学习到学习”,它旨在从相关任务中抽取的片段中学习,以有利于未来的学习(参见[227]关于元学习的全面调查)。与DG最相关的元学习论文是MAML[226],它将训练数据分为元训练集和元测试集,并使用元训练集以这种方式训练模型以提高元测试集上的性能。MAML风格的训练通常涉及通过更新基本模型进行二阶微分,因此对大型神经网络模型提出了效率和内存消耗问题[227]。在[226]中,MAML被用于参数初始化,即学习一个离目标任务的解只有几个梯度步长的初始化状态。

将元学习应用于DG的动机是使模型在训练过程中暴露于领域转移,并希望模型能够更好地处理未知领域的领域转移。现有的元学习DG方法只能应用于提供了领域标签的多源DG。

有两个组件需要仔细设计,即情节和元表示。具体来说,情节构建关注的是如何使用可用的样本构建每个情节,而元表示则回答了元学习的问题。

情节建设。大多数现有的元学习为基础DG 方法 [34]、[38]、[42]、[103]、[104]、[121]、[182]、[183]、[184]采用了[33]中提出的学习范式,这是第一个将元学习应用于DG的方法。具体来说,将源域划分为不重叠的元源域和元目标域来模拟域的移动。学习目标是使用元源域更新模型,以减少元目标域上的测试错误的方式,这通常通过双层优化来实现。如图3所示。

元表示是[227]中定义的一个术语,用于表示元学习的模型参数。大多数深度学习方法对整个神经网络模型进行元学习[33],[121],[182]。Balaji等人[34]提出对正则化参数进行元学习。在[183]中,随机神经网络被元学习来处理不确定性。在[42]中,一个MRI分割模型是元学习的,以及两个形状感知损失,以确保分割结果的紧凑性和平滑性。批归一化层在[103],[104],[184]中进行了元学习,以应对CNN特征统计中的训练-测试差异。

总的来说,元学习是一个很有前途的研究方向,因为它不仅在DG中有效,而且在诸如few-shot分类[226]、目标检测[228]和图像生成[229]等广泛的应用中也很有效。然而,DG中的元学习仍然存在与领域对齐相同的问题——只有在源领域移动(由元源和元目标领域模拟)下,才学习到表示的鲁棒性。如果源域在多样性方面受到限制,这个问题可能会更加严重。从最近的研究[35]、[205]中可以观察到,基于直接增强源训练数据的方法,无论是元学习方法还是领域对齐方法,其表现都不如直接增强源训练数据的方法——这个主题将在后面讨论。人们可以通过将元学习和领域对齐结合起来,来缓解元学习中的泛化问题。此外,还可以通过在元表示、元优化器和/或元目标方面设计新的元学习算法来取得进展。

3.3 数据增强

数据增强一直是一种常用的做法,用于规范机器学习模型的训练,以避免过度拟合并提高泛化[230],这对于过度参数化的深度神经网络尤为重要。数据扩充的基本思想是用新的(A(x), y)对扩充原始的(x, y)对,其中A(-)表示一个转换,它通常是保持标签的。毫不奇怪,考虑到数据增强的优势,它在DG中得到了广泛的研究,其中A(-)通常被视为模拟域移位的一种方式,A(-)的设计是性能的关键。

根据A(-)的表述方式,数据增强方法一般分为四类。图4为概述。下面我们将提供更详细的评论,其中对抗性梯度分为任务-对抗梯度和领域-对抗梯度;基于模型的增强进一步分为三个子组:随机增强网络、现成的风格迁移模型和可学习的增强网络。

图像转换。这种方法利用了传统的图像变换,如随机翻转、旋转和颜色增强。图5显示了转换的一些效果。虽然在学习过程中使用图像变换不需要域标签,但变换的选择通常是针对特定问题的。例如,对于以图像样式变化为主要域移的目标识别,可以选择与颜色强度变化更相关的变换,如图5中的亮度、对比度和日照。为了避免人工选择,可以设计一种搜索机制来搜索最适合目标问题的最优转换集。例如[39],作者提出了一种基于进化的搜索算法,并使用最坏情况公式使变换后的图像尽可能偏离原始图像的分布。还可以根据特定的下游任务选择转换。例如,[78]通过合成降低图像分辨率、添加遮挡和改变头部姿势等有意义的变化,解决了人脸识别中普遍存在的特征学习问题。

传统的图像变换已被证明在处理医学图像的域移方面非常有效[186]。[187],[188]。这是有道理的,因为图像转换可以很好地模拟由设备相关的域移位引起的颜色和几何变化,例如在不同的医疗中心使用不同类型的扫描仪。然而,在某些应用程序中,图像转换可能受到限制,因为它们可能导致标签移位,例如数字识别或光学字符识别,其中水平/垂直翻转操作是不可行的。因此,应该仔细选择转换,以免与下游任务发生冲突。

Task-Adversarial梯度。受对抗性攻击[231],[232]的启发,几种数据增强方法基于使用从任务分类器获得的对抗性梯度对输入图像进行扰动[73],[189],[190]。通过这样做,原始数据分布得到了扩展,从而允许模型学习更多可推广的特征。虽然这种类型的方法通常是为处理单源DG而开发的,但这种想法也可以直接应用于多源场景。

Domain-Adversarial梯度。当涉及到提供领域标签的多源DG时,可以利用领域对抗梯度来合成领域不可知论图像。例如,[40]训练了一个域分类器,并使用其对抗梯度对输入图像进行扰动。直观地说,通过学习与领域无关的图像,任务模型可以学习更多的领域不变模式。

由于基于对抗性梯度的扰动被有意设计成视觉上难以察觉的[231],基于对抗性梯度的方法经常被批评为无法模拟现实世界的域移,这比盐和胡椒噪声复杂得多[36]。此外,这些方法的计算成本通常会翻倍,因为向前和向后传递需要计算两次,这可能会给大型神经网络带来严重的效率问题。下面我们将讨论基于模型的方法,这些方法使用神经网络来制定转换A(-),并且可以产生更多样化的视觉效果。

随机增强网络。RandConv[191]基于使用随机初始化的单层卷积神经网络将输入图像转换为“新域”的思想。由于每次迭代的权值都是从高斯分布中随机采样的,并且不进行学习,因此变换后的图像主要包含随机的颜色畸变,这些颜色畸变不包含有意义的变化,在传递给任务网络之前最好与原始图像混合。

现成的风格转移模型。利用风格迁移[233]的进步,几种DG方法[29]、[192]、[193]使用现成的风格迁移模型(如AdaIN[233])来表示A(-),其本质上是将图像从一个源域映射到另一个源域以进行数据增强。与其在源域之间传递图像样式,不如利用外部样式来进一步丰富源训练数据[20]。虽然这些方法不需要训练风格转换组件,但它们仍然需要域标签来进行域翻译。

可学习增强网络。这组方法旨在学习增强神经网络来合成新的领域[35],[36],[194]。在[36]、[194]中,通过最大化相对于图像生成器的领域分类损失来生成与领域无关的图像。在[35],伪新颖域的合成是通过最大化原始图像和合成图像之间通过最优传输[217]测量的每个源域的域距离来实现的。

基于功能的增强。尽管上述可学习的增强模型已经显示出令人鼓舞的结果,但它们的效率是一个主要问题,因为它们需要训练大量的图像到图像的翻译模型。另一项研究侧重于特征级增强[23],[28],[147]。MixStyle[23],[28]通过在不同域的实例之间混合CNN特征统计来实现风格增强。在[147]中,Mixup[234]被用于在像素和特征空间中混合不同域的实例。

3.4 集成学习

作为机器学习研究中一个被广泛研究的主题,集成学习[235]通常使用不同初始化权值或使用不同训练数据分割来学习同一模型的多个副本,并使用它们的集成进行预测。这种简单的技术已被证明在提高单个模型在广泛应用中的性能方面非常有效[6],[7],[236]。

Exemplar-SVMs。是SVM分类器的集合,每个分类器使用一个正实例和所有负实例学习[237]。由于此类样例支持向量机的集合在[237]中对目标检测任务表现出优异的泛化性能,Xu等人[195]将样例支持向量机扩展到DG。特别是,给定一个测试样本,给出最高预测分数(因此更有信心)的 topk 样本分类器被选择用于集成预测。[196]、[197]也对DG的这种学习范例分类器的想法进行了研究。

特定领域神经网络。由于cnn擅长判别特征学习[7],因此用基于cnn的模型代替手工设计的SVM分类器进行集成学习是很自然的。一种常见的做法是学习特定于领域的神经网络,每个神经网络专攻一个源领域[61],[198]。与其为每个源域学习一个独立的CNN[198],不如在源域之间共享一些浅层[61],这些浅层捕获了通用特征[139],这样更有效,也更有意义。另一个问题是如何计算预测。可以简单地使用所有具有相同权重的个体的集合预测平均值(例如,[61],[199])。或者,也可以采用加权平均,其中权重由源域分类器估计,例如,旨在衡量目标样本与每个源域的相似度[201]。此外,权重可以用来确定最自信的候选者,其输出将用于最终预测[200]。

特定于域的批处理规范化。在批处理归一化(batch normalization, BN)[238]中,统计数据在训练过程中被实时计算,它们的移动平均值被存储在缓冲区中进行推理。由于统计数据通常在不同的源域中有所不同,因此有人可能会认为混合多个源域的统计数据不利于学习可泛化表示。一个解决方案是使用域特定 BNs[202],[204],每个源域一个bn,用于收集特定域的统计信息。这相当于构建特定于领域的分类器,但除了规范化层之外,模型的大多数部分都具有参数共享。这种设计后来在[41]中被用于处理MRI分割。在[203]中,使用测试数据的实例级特征统计与源域BN统计之间的距离作为权重来聚合特定领域的预测。

权重平均。将训练过程中不同时间步长的模型权值进行汇总,在测试时形成单一模型[239]。与需要训练多个模型(或模型部件)的显式集成学习不同,加权平均是一种更有效的解决方案,因为模型只需要训练一次。在[205]中,作者证明了权值平均可以极大地提高域移位下的模型鲁棒性。事实上,这种技术与许多其他DG方法是正交的,可以作为后处理方法应用,以进一步提高DG性能。

3.5 自监督学习

自监督学习通常被称为使用从数据本身生成的自由标签进行学习(参见[242])。自我监督学习的综合调查)。在计算机视觉中,这可以通过教授模型来预测应用于图像数据的变换来实现,例如补丁洗牌图像的洗牌顺序[240]或旋转度[241]。如图6所示。

那么为什么自我监督学习可以提高DG呢?一个直观的解释是,解决借口任务允许模型学习通用特征,而不管目标任务是什么,从而减少对特定领域偏差的过度拟合[49]。自监督学习的一个明显优势是,它可以应用于单源和多源场景,而不需要任何领域标签。

单一借口任务。除了使用标准的分类损失外,Carlucci等人[49]还教神经网络解决Jigsaw puzzles问题[240],希望网络能够学习到更具有跨域泛化性的规律。类似地,Wang等人[134]使用拼图解决任务作为内在监督,以及使用度量学习实现的外在监督。对DG的重建也进行了研究,例如学习一个自动编码器来重建图像像素/特征[53],[206]。

多重借口任务。也可以将多个借口任务结合起来。在[50]中,作者结合了两个借口任务,即解决拼图和预测旋转。在[135]中,三个借口任务组合在一起,即重建Gabor滤波器的响应、预测旋转和预测特征聚类分配[243]。总体而言,使用多个借口任务比使用单个借口任务表现更好,如[50]所示。

目前,这些基于自监督学习的DG方法仅在目标识别任务上进行了评估。目前尚不清楚它们是否适用于更广泛的OOD泛化任务,这将是未来工作中有趣的研究。另一个问题是,一般来说,现有的借口任务没有一个是普遍的,借口任务的选择是针对具体问题的。例如,当目标域位移与旋转相关时,使用旋转预测任务学习的模型会捕获旋转敏感信息,不利于泛化。

最近最先进的自监督学习方法[244],[245]大多是基于对比学习和数据增强的结合。关键思想是将经历不同变换(例如,随机翻转和颜色失真)的相同实例(图像)拉到一起,同时推开不同的实例来学习实例感知表示。与预测变换(如旋转)不同,对比学习旨在学习变换不变的表示。未来的工作可以探索通过对比学习获得的不变性是否能更好地适应OOD数据。

3.6 学习解纠缠表征

而不是强迫整个模型或特征是领域不变的,这是具有挑战性的,可以通过允许某些部分是特定于领域的来放松这个约束,本质上是学习解纠缠的表示。属于这一类的现有方法要么基于分解[37],[46],[207],[208],要么基于生成建模[209],[210],两者都需要域标签来进行特征解纠缠。

分解。实现解纠缠表示学习的一种直观方法是将模型分解为两部分,一部分是特定于领域的,另一部分是不可知的。Khosla等人[46]基于支持向量机,将分类器分解为特定于领域的偏差和领域不可知的权重,在处理未知领域时只保留后者。该方法后来被扩展到神经网络[37]。还可以设计特定于领域的模块,如[207],其中特定于领域的二进制掩码被施加在最终特征向量上,以区分特定于领域和领域不变的组件。另一种解决方案是对模型的权重矩阵应用低秩分解,以识别更具泛化性的共同特征[208]。

生成建模。一直是学习解纠缠表征的有力工具[246]。在[209]中,使用变分自编码器(VAE)分别学习类、域和对象的三个独立潜子空间。在[210]中,以对抗的方式学习了两个独立的编码器,分别捕获身份和领域信息,用于跨域人脸防欺骗。

3.7 正则化策略

一些方法侧重于基于启发式设计的正则化策略。Wang等人[51]认为,可泛化特征应该捕捉物体的全局结构/形状,而不是依赖于局部斑块/纹理,因此提出了抑制辅助斑块cnn的预测能力(最大化其分类误差),实现为1x1卷积层的堆栈。出于类似的动机,Huang等人[52]用大梯度迭代地掩盖了过于主导的特征,从而迫使模型更多地依赖于剩余的特征。这些方法不需要领域标签来学习,并且与其他DG方法(如基于领域对齐[117]、[169]和数据增强[23]、[35]、[39])是正交的。因此,人们可以将它们结合起来以提高实践中的表现。

3.8 强化学习

强化学习(RL)中的领域转移不仅发生在视觉外观(颜色/风格变化等),还发生在其他方面,如动态(过渡函数)或奖励(例如,重力/摩擦变化)[125]。对于视觉域转移,上述调查的许多DG方法似乎适用于强化学习,例如数据增强方法[23],[214],但对于后者则不适用,因为后者需要更具体的问题设计。下面我们将简要讨论一些为强化学习开发的代表性泛化方法。更全面的调查请参考[125]。

数据增加。主要思想是增强发送给RL代理的视觉信号,使其更具域泛化性。一种常见的方法是使用保持标签的转换[123],[211],[212],如颜色抖动或切出[247]。还可以实现领域随机化的概念[213],通过计算机模拟器[213]或随机神经网络[214]等视觉上随机化环境。当使用卷积神经网络时,可以采用3.3节中讨论的MixStyle[23]方法在特征空间中创建“新颖”域。

自监督。将强化学习与不需要手动标签的自监督学习相结合,也被探索过。一般的方法是用辅助损耗来增强RL模型。例如,Yarats等人[215]提出了基于自编码器的重构损失;Laskin等[216]将强化学习与无监督对比学习损失相结合。

4 理论

与已经提出了大量具有理论保证的学习边界的领域自适应不同[248],由于缺乏目标数据,限制领域泛化(DG)的风险是具有挑战性的。尽管如此,已经做出了一些尝试来解决这个问题,本节将简要介绍这些尝试。

大多数现有的理论研究都受限于特定的模型类别,如核方法[5]、[19]、[168]、[249],或者有很强的假设,不能简单地应用于更广泛的DG方法。在[173]中,假定所有可能域(包括源域和目标域)的潜在特征空间具有线性依赖关系,这意味着每个域是其他域的线性组合。基于线性相关假设,提出了一种秩正则化方法,并将其与分布对齐方法相结合。在[175]中,假设源域形成一个凸包,因此最小化源域内的最大成对距离将导致凸包中任意两个域之间的距离减小。在[250]中,DG被投入到一个在线游戏中,其中玩家(模型)最小化对手在每个时间步呈现的“新”分布的风险。在[251]中,研究了与“真正的”OOD泛化密切相关的代理度量。

最近,有一些新兴的研究[252],[253]旨在为DG提供更通用的界限,更宽松的假设。在[252]中,特征分布由两个项量化:i)测量跨域特征表示稳定性的变异项;Ii)一个信息性术语,表示特征表示的区别性(即,它们用于区分不同类别的程度)。然后,不可见域上的误差由基于变化项的展开函数限定,受制于使用信息量项测量的特征表示的可学习性。

在[253]中,泛化差距以模型的Rademacher复杂度为界,这表明具有强正则化的较低模型复杂度可以提高未见域的泛化——这与[128]中的发现相一致:适当正则化的经验风险最小化与留一个域的交叉验证是一个强大的DG基线。

5 未来研究方向

到目前为止,我们已经在第2节中介绍了域泛化(DG)的背景知识——了解了DG是什么,以及在不同的设置/数据集下如何评估DG——并在第3节中介绍了过去十年中开发的现有方法。自然会产生以下问题:i) DG解决了吗?ii)如果不是,我们离解DG还有多远?

答案当然是否定的——dg是一个非常具有挑战性的问题,而且远未得到解决。在本节中,我们将分享对未来研究方向的一些见解,指出目前研究中缺失的地方,并讨论值得进一步探索的地方。具体来说,我们从三个角度讨论了潜在的方向:模型(第5.1节)、学习(第5.2节)和基准(第5.3节)。

5.1 模型架构

动态的架构。作为特征检测器的卷积神经网络(CNN)的权值在从源域学习后通常是固定的。这可能会导致CNN模型的表征能力局限于可见域,而当不可见域的图像统计数据显著不同时,其泛化能力很差。一个潜在的解决方案是开发动态架构[254],例如,将权重设置在输入[255]上。关键是使神经网络的参数(部分或全部)依赖于输入的同时保证模型的大小不会太大而损害效率。动态架构,如动态过滤网络[255]和条件卷积[256],在分类和分割等通用视觉识别任务上已经被证明是有效的。看看这种灵活的体系结构是否可以用于处理DG中的域转移,这将是一件有趣的事情。

自适应规范化图层。归一化层[238],[257],[258]已经成为当代神经网络的核心构建块。根据[259],不同归一化层的一般公式可以写成y +β,其中μ和λ分别表示均值和方差;Y和ß分别是可学习的缩放参数和移位参数。通常,(μ,σ)是在训练过程中实时计算的,但使用它们的移动平均线保存在缓冲区中进行推理。无论它们是在每个实例内计算还是基于小批量计算,它们都只能表示训练数据的分布。仿射变换参数,即y和β,也只学习源数据。因此,在不可见的测试数据中,不能保证归一化层的参数在域移位下工作良好。研究如何使这些参数适应看不见的域将是一个有前途的方向[260]。

5.2 学习

没有领域标签的学习。大多数现有方法在其模型中利用域标签。然而,在现实应用中,域标签可能难以获得,例如,从互联网抓取的网络图像是由具有任意域特征的任意用户获取的,因此域标签极难定义[197]。在缺少领域标签的情况下,许多性能最高的DG方法不再可行或性能下降[118]。虽然这个主题在过去已经被研究过(例如,[23],[177],[261]),但是能够处理缺乏领域标签的方法仍然很少,并且与利用领域标签的方法没有竞争力。考虑到没有领域标签的学习更有效和可扩展,我们鼓励未来更多的工作来解决这个主题。我们还建议未来的工作使用领域标签来评估没有适当领域标签的功能能力(如果适用的话),就像在[118]中所做的随机分组实验一样。

学习合成新领域。增加源域的多样性可以大大提高DG的性能。这在最近的一项研究[262]中也得到了证实,作者强调了拥有不同的训练分布对分布外(OOD)泛化的重要性。然而,在实践中,收集涵盖所有可能领域的训练数据是不可能的。因此,学习合成新的领域可能是一个潜在的解决方案。虽然这一想法已经在最近的几个DG作品中进行了粗略的探讨[23],[35],但结果仍有很大的改进空间。

避免学习捷径。快速学习可以解释为学习“简单”表示的问题,这些表示可以在训练数据上表现良好,但与任务无关[263]。例如,给定区分的任务在混合了不同颜色的数字之间,神经网络在训练过程中可能会偏向于识别颜色而不是数字形状,从而导致对未见数据的泛化能力差[264]。由于每个源域通常包含自己的特定于域的偏差,因此在DG中的多源数据上可能会加剧这种问题。因此,当任务是区分来自不同领域的实例时,DG模型可以简单地学习记忆特定于领域的偏差,例如图像样式[37]。DG中的捷径学习问题一直被忽视。

因果表征学习。目前,在DG以及许多其他领域中,用于表示学习的常用管道是通过从边缘分布P(X)中采样数据来学习映射P(YIX),目的是匹配联合分布P(X,Y)= P(YIX)P(X)(通常通过最大似然优化)。然而,事实证明,学习到的表征缺乏适应OOD数据的能力[265]。一个潜在的解决方案是对潜在的因果变量进行建模(例如,通过自动编码器[265]),这些变量不能直接观察到,但在分布移位下更加稳定和健壮。这与因果表示学习的主题密切相关,这是机器学习社区的最新趋势[266]。

利用附带信息。副信息(有时称为元数据)通常用于提高模式识别系统的性能。例如,从RGB- d传感器获得的深度信息可以与RGB图像一起使用,以提高性能。例如,通用对象检测[267]或人类检测[268]。在DG中,有一些作品利用了侧信息,如属性标签[149]或对象分割掩码[269]。在属性方面,它们可以更一般化,因为它们捕获了中低层次的视觉线索,如颜色、形状和条纹,这些线索在不同的物体之间共享,对域偏差不太敏感[149]。值得注意的是,属性已被广泛用于零射击学习,以识别未见过的类[143],[148]。相比之下,为识别而学习的特征通常过于特定于对象,例如在顶层CNN特征中发现的狗耳朵和人脸[270],这些特征更有可能捕获领域偏差,因此在任务之间的可转移性较差[139]。

转移学习。最近的一些研究[141]、[142]关注了在设计从合成到实际应用的DG方法时的迁移学习视角。给定一个在大型真实数据集(如ImageNet[11])上预训练的模型,其主要目标是从合成数据中学习对下游任务有用的新知识,同时维护预训练中获得的真实图像上的知识。这种设置与学习无遗忘(LwF)密切相关[271]。特别是,[141]中使用的一种技术借鉴了LwF[271],即最小化新模型输出与旧模型输出之间的差异,以避免消除预训练的知识。综合到真实的迁移学习是一个现实可行的环境,但在这方面的研究对于DG来说却很少。

半监督域泛化。大多数现有的DG研究假设从每个源域收集数据是完全标注的,因此所提出的方法纯粹基于监督学习,无法处理未标记的数据。然而,在实践中,由于标注成本高,标记数据的大小很可能受到限制,但收集大量未标记的数据要容易得多,成本也低得多。这导致了一种更现实和实用的设置,称为半监督域泛化[28],[29],[272],最近引起了DG社区的关注。在[29]中,将伪标签分配给未标记的源数据,并使用现成的样式转移模型来扩展域空间。在[28]中,特征统计数据混合在标记和伪标记的源数据之间,以增强数据。由于设计数据高效,但可泛化的学习系统对于实际应用至关重要,我们认为半监督域泛化值得研究未来的工作。

开放域泛化。是最近引入的一个问题设置[27],其中模型从具有不同标签集(有重叠)的异构源域学习,并部署在不可见的域中,以识别已知类,同时能够拒绝未知类。该问题设置与现有的异构DG[35][94]有关,但侧重于分类应用,并强调检测(拒绝)未知类的能力,这在开放集识别中经常被研究[273]。在[27]中,提出了Mixup[234]的一种变体,用于特征和标签级别的数据增强,并使用置信度阈值来拒绝可能属于未知类别的测试样本。

5.3 基准

增量学习+ DG。大多数现有的DG研究都隐含地假设源域是固定的,并且模型只需要学习一次。然而,在实践中,源域很可能是增量引入的,因此需要增量学习[274]。例如,在跨数据集的人物再识别中,我们可能只访问两个数据集,例如,Market1501[76]和DukeMTMC-reID[77],但后来另一个数据集进来了,例如,CUHK03[275],它将源数据集的数量从两个增加到三个。在这种情况下,需要解决几个问题,例如i)如何在新数据集上有效地微调模型,而不使用所有可用的数据集从头开始训练,ii)如何确保模型不会过度拟合新数据集并忘记以前学过的知识,以及iii)新数据集对目标域上的DG性能是有利还是有害。

异构域移位。目前的DG数据集主要包含同质域偏移,即源-源偏移和源-目标偏移高度相关。例如,在PACS[37]上,源-源域移位和源-目标域移位都与图像样式的变化有关;在旋转的MNIST上[53],旋转是引起域移位的唯一原因。然而,在现实场景中,目标域位移是不可预测的,并且不太可能与源域位移相关,例如,源域可能是照片,艺术和素描,但目标域可能是图像新颖的观点;或者源域包含具有不同旋转的数字图像,但目标域图像可能具有不同的字体样式或背景。这种设置,我们称之为异构域转移,从未被提出,但对实际应用至关重要。

6 结论

领域泛化已经研究了十多年,在不同的应用领域中,文献中开发了许多方法。鉴于领域泛化对人工智能发展的重要性,有必要弄清楚:1)这个主题与领域自适应等邻近领域的关系;2)领域泛化通常是如何评估和基准的;3)领域泛化的进展是什么。这项及时的最新调查回答了这些问题,我们希望它能激励未来的工作来推进这一领域。

本文对领域泛化(DG)进行全面综述。DG旨在用源数据学习模型以实现面向对象的泛化,以克服域移位问题。文中介绍了DG背景、常用方法,如域对齐、元学习等,探讨了相关理论,并从模型架构、学习、基准三个角度展望未来研究方向,强调其对人工智能发展的重要性。

本文对领域泛化(DG)进行全面综述。DG旨在用源数据学习模型以实现面向对象的泛化,以克服域移位问题。文中介绍了DG背景、常用方法,如域对齐、元学习等,探讨了相关理论,并从模型架构、学习、基准三个角度展望未来研究方向,强调其对人工智能发展的重要性。

4811

4811

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?