前段时间技术同事完成了对中小模型的测试验证。分别测试了 RTX 5000 Ada和RTX 5880 Ada 显卡运行 DeepSeek 7B/14B/32B 等模型的并发性能与部署效率。

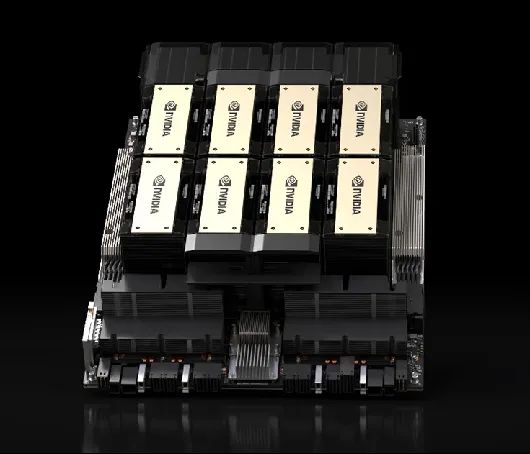

近期我们针对 DeepSeek 满血版 671B 进行了并发性能的测试,搭载的是 8张 NVIDIA H20(单卡显存141GB)的服务器,我们来看看测试结果。

测试版本:

DeepSeek-R1 671B

测试框架:vllm

测试环境:

GPU:H20*8(单卡141GB,共1128GB)

CPU:英特尔 至强® Platinum 8480+ *2

内存:2T DDR5 硬盘:3.84TB

测试数据仅供参考:

我们在压力并发测试中分别测试了 2 种常见的使用场景:

1、问答对话场景

特点:直接回答用户提出的问题,通常基于预定义的规则、知识库或简单检索。

测试结果:

并发数在80以内,吞吐率可以达到>9 tokens/s,在简单对话场景的表现优秀。

2、模拟RAG场景

特点:结合检索外部知识库与生成模型,动态生成精准、上下文相关的答案。

测试结果:

基本可以满足32个并发,吞吐率>6 tokens/s。可以流畅地对海量文档和数据库进行检索并输出内容。

测试小结

-

对话问答场景:基本可以满足 80 个并发。当并发数<80 时,Tokens/s>9。

-

模拟RAG场景:基本可以满足 32 个并发。当并发数<32 时,Tokens/s>6。

-

后端服务稳定运行,配合前端实际使用体验效果优秀,延迟很低。

综上所述,使用8卡H20配置进行 DeepSeek 671B 的满血版本地化部署,能够很好地应对企业高并发的实际使用场景,想用671B的建议直接上!

1088

1088

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?