来源:https://blog.csdn.net/qq_41204464/article/details/115387812

作者:一颗小树X@CSDN(已授权)

编辑:3D视觉开发者社区

前言

双目立体视觉,由两个摄像头组成,像人的眼睛能看到三维的物体,获取物体长度、宽度信息,和深度的信息;单目视觉获取二维的物体信息,即长度、宽度。

1)双目摄像头

双目摄像头示意图(ORBBEC® Gemini 3D传感摄像头是一款基于双目结构光3D成像技术的近距离高精度的嵌入式模组):

2)双目相机基线

基线越大,测量范围越远;基线越小,测量范围越近。

建议:

(1)基线距离是工作距离的08-2.2倍时测量误差比较小;

(2)双目立体视觉的结构对称时,测量系统的误差比较小,精度也比较高。

(3)两台相机的有效焦距∫越大,视场越小,视觉测量系统的测量精度越高(即采用长焦距镜头容易获得较高的测量精度)

3)打开双目摄像头

在OpenCV用使用双目摄像头,包括:打开单目摄像头、设置摄像头参数、拍照、录制视频。

环境编程语言:Python3 主要依赖库:OpenCV3.x 或 OpenCV4.x

双目同步摄像头,两个镜头共用一个设备ID,左右摄像机同一频率。这款摄像头分辨率支持2560*960或以上。

思路流程:

1、由于两个镜头共用一个设备ID,打开摄像头时使用cv2.VideoCapture()函数,只需打开一次。区别有的双目摄像头是左右镜头各用一个设备ID,需要打开两次cv2.VideoCapture(0),cv2.VideoCapture(1)。

2、双目摄像头的总分辨率是由左右镜头组成的,比如:左右摄像机总分辨率1280x480;分割为左相机640x480、右相机640x480

为了方便理解画了张草图;图中的“原点”是图像像素坐标系的原点。

3、分割后,左相机的分辨率:高度 0:480、宽度 0:640

右相机的分辨率:高度 0:480、宽度 640:1280

4、转换为代码后

# 读取摄像头数据

ret, frame = camera.read()

#裁剪坐标为[y0:y1, x0:x1] HEIGHT * WIDTH

left_frame = frame[0:480, 0:640]

right_frame = frame[0:480, 640:1280]

cv2.imshow("left", left_frame)

cv2.imshow("right", right_frame)

源代码:

举个栗子:打开分辨率1280x480的双目摄像头

# -*- coding: utf-8 -*-

import cv2

import time

AUTO = False # 自动拍照,或手动按s键拍照

INTERVAL = 2 # 自动拍照间隔

cv2.namedWindow("left")

cv2.namedWindow("right")

camera = cv2.VideoCapture(0)

# 设置分辨率 左右摄像机同一频率,同一设备ID;左右摄像机总分辨率1280x480;分割为两个640x480、640x480

camera.set(cv2.CAP_PROP_FRAME_WIDTH,1280)

camera.set(cv2.CAP_PROP_FRAME_HEIGHT,480)

counter = 0

utc = time.time()

folder = "./SaveImage/" # 拍照文件目录

def shot(pos, frame):

global counter

path = folder + pos + "_" + str(counter) + ".jpg"

cv2.imwrite(path, frame)

print("snapshot saved into: " + path)

while True:

ret, frame = camera.read()

# 裁剪坐标为[y0:y1, x0:x1] HEIGHT*WIDTH

left_frame = frame[0:480, 0:640]

right_frame = frame[0:480, 640:1280]

cv2.imshow("left", left_frame)

cv2.imshow("right", right_frame)

now = time.time()

if AUTO and now - utc >= INTERVAL:

shot("left", left_frame)

shot("right", right_frame)

counter += 1

utc = now

key = cv2.waitKey(1)

if key == ord("q"):

break

elif key == ord("s"):

shot("left", left_frame)

shot("right", right_frame)

counter += 1

camera.release()

cv2.destroyWindow("left")

cv2.destroyWindow("right")

补充理解:

OpenCV有VideoCapture()函数,能用来定义“摄像头”对象,0表示第一个摄像头(一般是电脑内置的摄像头);如果有两个摄像头,第二个摄像头则对应VideoCapture(1)。

在while循环中使用“摄像头对象”的read()函数一帧一帧地读取摄像头画面数据。

imshow函数是显示摄像头的某帧画面;cv2.waitKey(1)是等待1ms,如果期间检测到了键盘输入q,则退出while循环。

效果:

4)双目测距

原理:

通过对两幅图像视差的计算,直接对图像所拍摄到的范围进行距离测量,无需判断前方出现的是什么类型的障碍物。

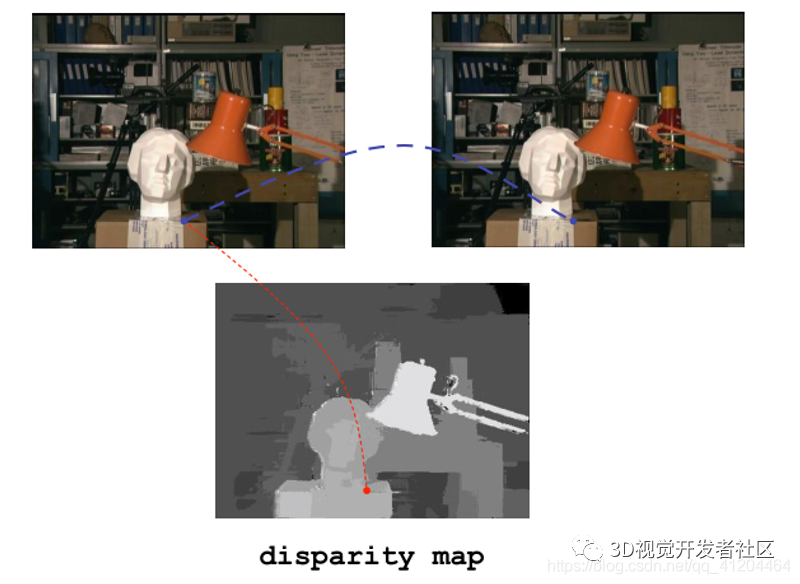

视差disparity:

首先看一组视觉图:左相机图和右相机图不是完全一致的,通过计算两者的差值,形成视差,生成视差图(也叫:深度图)

视差是同一个空间点在两个相机成像中对应的x坐标的差值;

它可以通过编码成灰度图来反映出距离的远近,离镜头越近的灰度越亮;

我们观察一下,看到台灯在前面,离双目相机比较近,在灰度图呈现比较亮;摄影机及支架在后方,离双目相机比较远,在灰度图呈现比较暗。

补充理解:

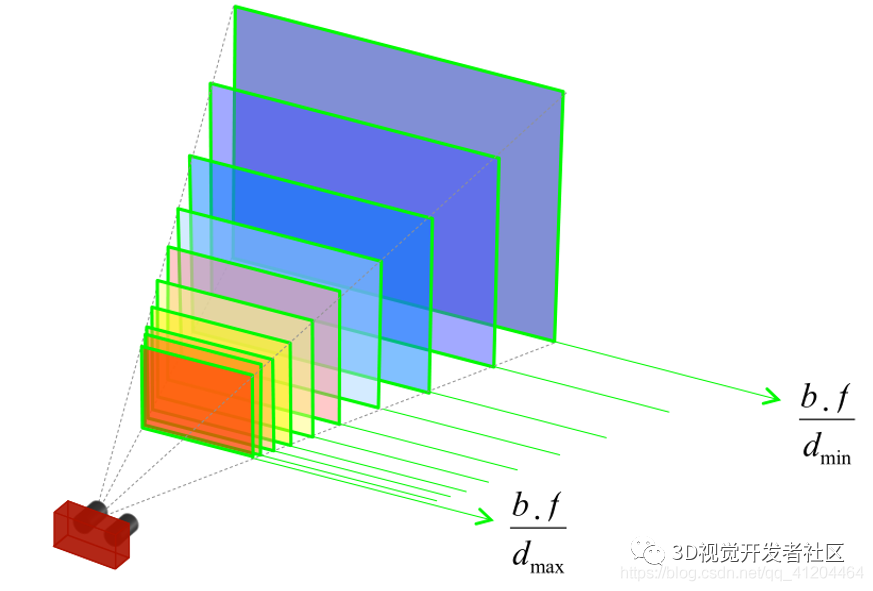

由立体视觉系统测量的深度被离散成平行平面 (每个视差值一个对应一个平面)

给定具有基线 b 和焦距 f 的立体装备, 系统的距离场受视差范围[dmin ,dmax]的约束。

极线约束:

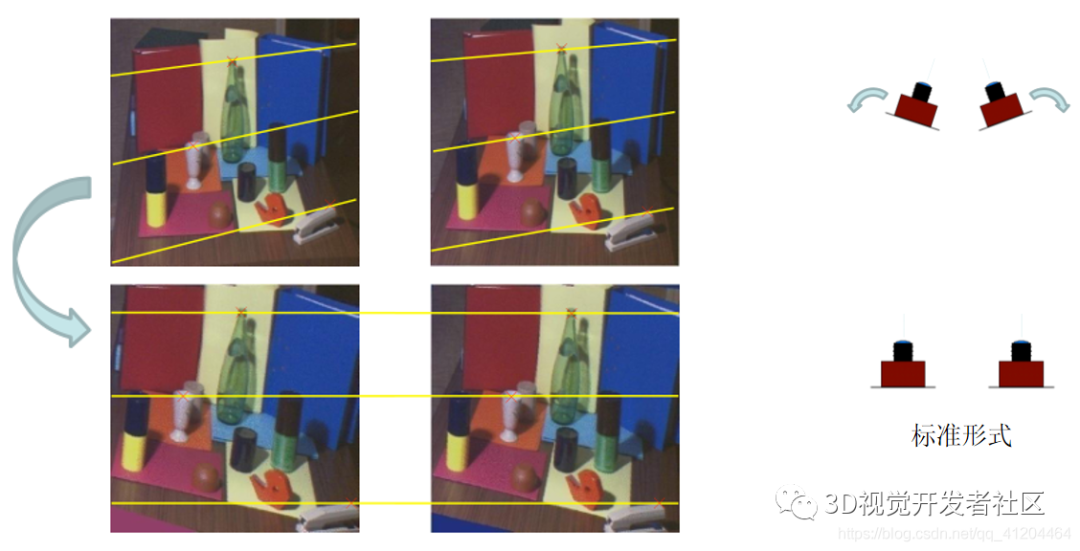

极线约束(Epipolar Constraint)是指当空间点在两幅图像上分别成像时,已知左图投影点p1,那么对应右图投影点p2一定在相对于p1的极线上,这样可以极大的缩小匹配范围。

标准形式的双目摄像头,左右相机对齐,焦距相同。

如果不是标准形式的双目摄像头呢?哦,它是是这样的:(需要 极线校正/立体校正)

极线校正/立体校正

双目测距流程:

a.双目标定

主要是获取内参(左摄像头内参+右摄像头内参)、外参(左右摄像头之间平移向量+旋转矩阵)

标定过程:

b.双目矫正

消除镜头变形,将立体相机对转换为标准形式

c.立体匹配

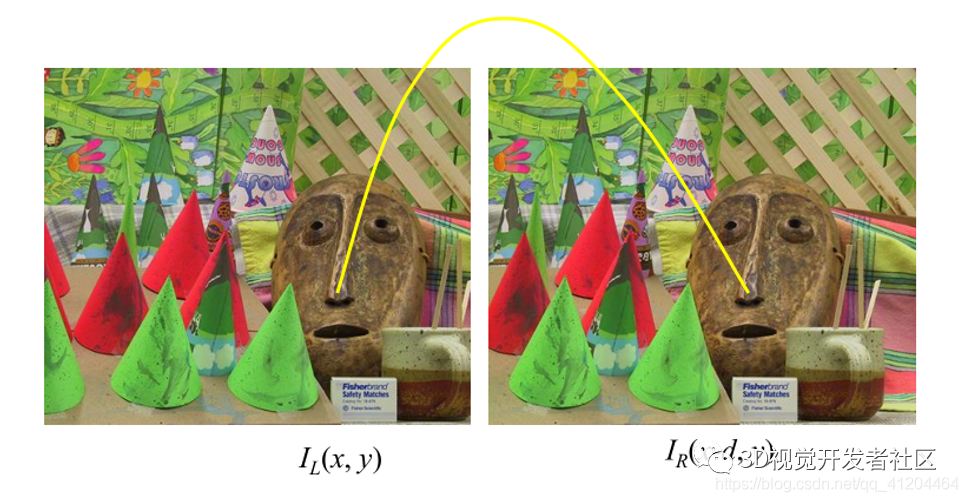

寻找左右相机对应的点(同源点)

d.双目测距(三角测量)

给定视差图、基线和焦距,通过三角计算在3D中对应的位置

双目测距原理

e.测距效果

彩蛋:双目立体匹配(重点)

立体匹配是双目立体视觉中比较重要的一环,往往这里做研究和优化。

a.立体匹配流程

b.匹配代价计算

代价函数用于计算左、右图中两个像素之间的匹配代价(cost)。cost越大,表示这两个像素为对应点的可能性越低。

常用代价函数

AD/BT

AD+Gradient

Census transform

SAD/SSD

NCC

AD+Census

CNN

c.立体匹配

端到端视差计算网络

Disp-Net (2016)

GC-Net (2017)

iRestNet (2018)

PSM-Net (2018)

Stereo-Net (2018)

GA-Net (2019)

EdgeStereo (2020)

立体视觉方法评测网站

ETH3D https://www.eth3d.net/

Kitti Stereo http://www.cvlibs.net/datasets/kitti/eval_scene_flow.php?benchmark=stereo

Middlebury Stereo 3.0 https://vision.middlebury.edu/stereo/eval3/

双目测距总结

优势:

(1)成本比单目系统要高,但尚处于可接受范围内,并且与激光雷达等方案相比成本较低;

(2)没有识别率的限制,因为从原理上无需先进行识别再进行测算,而是对所有障碍物直接进行测量;

(3)直接利用视差计算距离,精度比单目高;

(4)无需维护样本数据库,因为对于双目没有样本的概念。

难点:

(1)计算量大,对计算单元的性能要求高,这使得双目系统的产品化、小型化的难度较;(芯片或FPGA)

(2)双目的配准效果,直接影响到测距的准确性;

(3)对环境光照非常敏感;(光照角度、光照强度)

(4)不适用于单调缺乏纹理的场景;(天空、白墙、沙漠)

(5)相机基线限制了测量范围。(基线越大,测量范围越远;基线越小,测量范围越近)

参考文献

1)[Wang 2015] Wang W, Yan J, Xu N, et al. Real-time high-quality stereo vision system in FPGA. IEEE Transactions on Circuitsand Systems for Video Technology, 2015, 25(10): 1696-1708.2)

2)[Kim 2016] K.-R. Kim and C.-S. Kim. Adaptive smoothness constraints for efficient stereo matching using texture and edgeinformation. ICIP 2016.

3)[Zbontar 2016] Zbontar J, LeCun Y. Stereo matching by training a convolutional neural network to compare image patches.Journal of Machine Learning Research, 2016.

4)[Park 2017] Park H, Lee K M. Look wider to match image patches with convolutional neural networks. IEEE Signal ProcessingLetters, 2017.

5)Leonid Keselman, et al. Intel R RealSenseTM Stereoscopic Depth Cameras. CVPRW. 2017.

6)立体匹配算法原理与应用.奥比研究院.徐玉华

7)基于双目视觉的空间非合作目标姿态测量技术研究.颜坤

8)https://www.bilibili.com/video/BV1ka4y1L7xT?from=search&seid=5727123941116684431

9)https://blog.csdn.net/u011808673/article/details/90641589 10)https://www.cnblogs.com/polly333/p/5130375.html

本文仅做学术分享,如有侵权,请联系删文。

下载1

在「3D视觉工坊」公众号后台回复:3D视觉,即可下载 3D视觉相关资料干货,涉及相机标定、三维重建、立体视觉、SLAM、深度学习、点云后处理、多视图几何等方向。

下载2

在「3D视觉工坊」公众号后台回复:3D视觉github资源汇总,即可下载包括结构光、标定源码、缺陷检测源码、深度估计与深度补全源码、点云处理相关源码、立体匹配源码、单目、双目3D检测、基于点云的3D检测、6D姿态估计源码汇总等。

下载3

在「3D视觉工坊」公众号后台回复:相机标定,即可下载独家相机标定学习课件与视频网址;后台回复:立体匹配,即可下载独家立体匹配学习课件与视频网址。

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、orb-slam3等视频课程)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近2000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~

7106

7106

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?