前言

以往的研究主要集中在通过增加检索文档的数量或长度来扩展检索增强生成(RAG)中检索到的知识。然而,仅增加知识量而不提供进一步的指导存在一定的局限性。

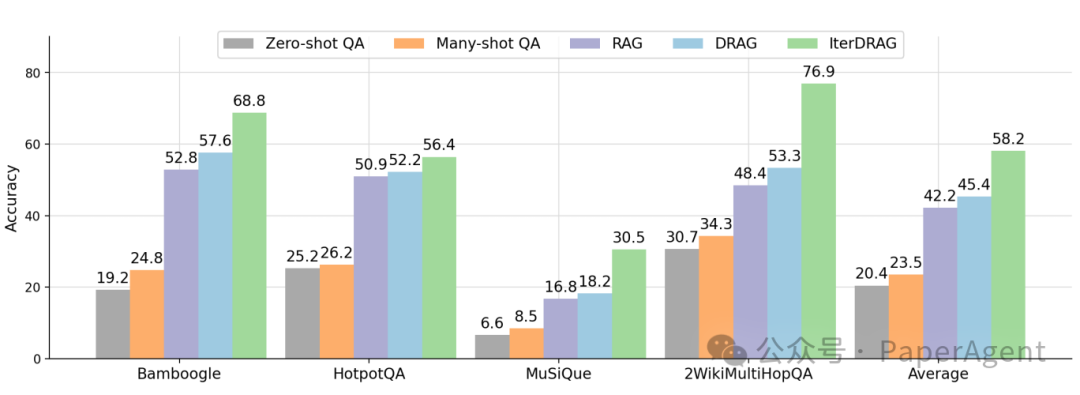

为此,Google DeepMind研究了RAG在**推理计算扩展(Inference Scaling)情况下的性能,特别是当上下文很长时。通过应用最优配置,在长上下文LLMs上扩展推理计算可以实现高达58.9%**的性能提升。

用于RAG的推理扩展策略

为了衡量推理计算,定义了有效上下文长度,即在LLM生成最终答案之前所有迭代中的输入token总数。对于大多数只调用LLM一次的方法,有效上下文长度等同于提示中的输入token数量,并受到LLM的上下文窗口限制。对于迭代调用LLM的方法,有效上下文长度可以通过策略无限扩展。

目标是理解RAG性能如何随着推理计算的扩展而变化。为此,引入了两种扩展策略:示范基础RAG(DRAG)和迭代示范基础RAG(IterDRAG)。

DRAG与IterDRAG的对比。IterDRAG将输入查询分解为子查询并回答它们,以提高最终答案的准确性。在测试时,IterDRAG通过多个推理步骤来扩展计算,分解复杂查询并检索文档。

-

示范基础RAG(DRAG):DRAG利用上下文学习,通过直接从扩展的输入上下文中生成答案来利用LLMs的长上下文能力。DRAG在输入提示中整合了文档和上下文示例,使得模型能够在单次推理请求中生成对输入查询的答案。

-

迭代示范基础RAG(IterDRAG):为了处理复杂的多跳查询,IterDRAG通过将查询分解为更简单的子查询来处理。对于每个子查询,执行检索以收集额外的上下文信息,然后用于生成中间答案。在所有子查询解决后,检索到的上下文、子查询及其答案被组合以合成最终答案。

RAG性能和推理计算扩摸

接下来重点研究揭示RAG性能与推理计算规模之间的关系,并尝试预测在不同计算约束下达到最佳性能的推理参数配置。

固定预算下的最佳性能:

对于固定的有效上下文长度预算,通过枚举不同的推理参数配置(如检索文档的数量、上下文示例的数量、生成迭代的次数)来找到最优平均指标。

最优配置的具体示例:

-

在某个特定的最大有效上下文长度限制下,选择一个特定的文档数量,比如100篇文档。 Lmax

-

确定在输入提示中使用多少个上下文示例,例如20个示例。

-

对于IterDRAG,可能决定在最终生成答案之前进行最多5次的迭代。

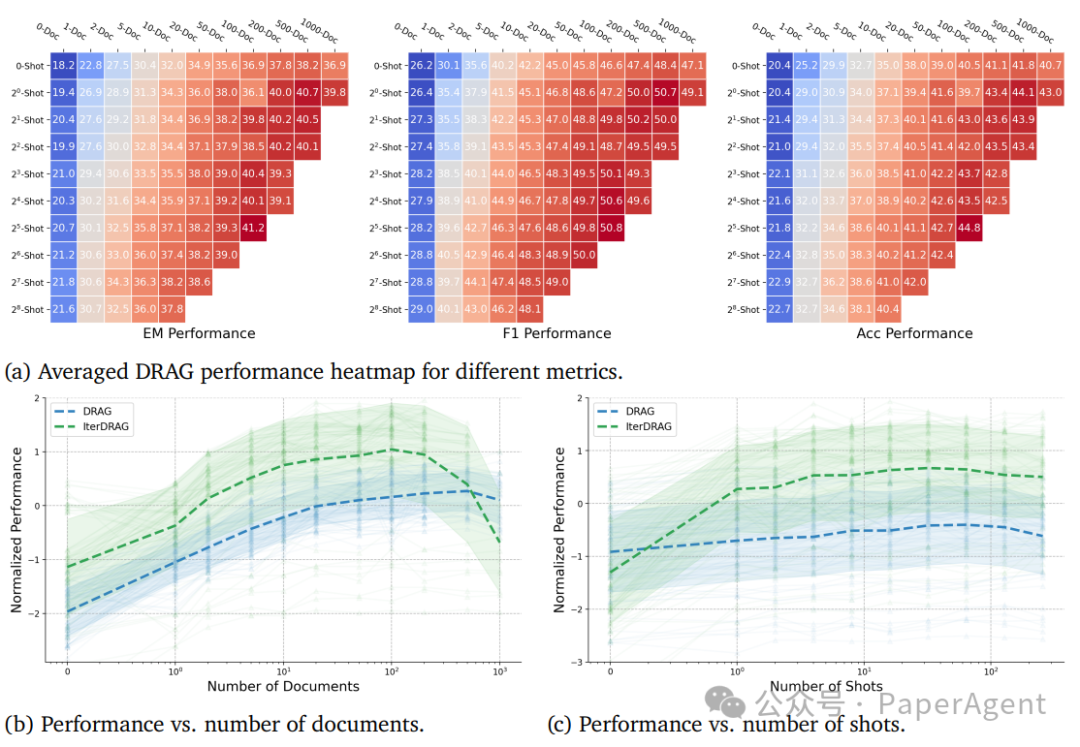

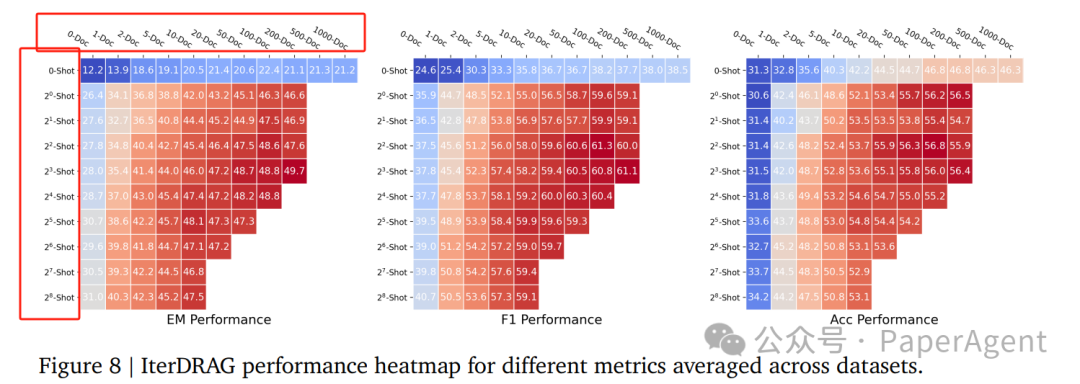

RAG性能随文档数量和上下文示例的变化而变化**。**(a)报告了跨数据集的平均指标值,而在(b)和(c)中,每条线代表在逐渐增加文档/示例的一致配置下的标准化性能。

整体性能:

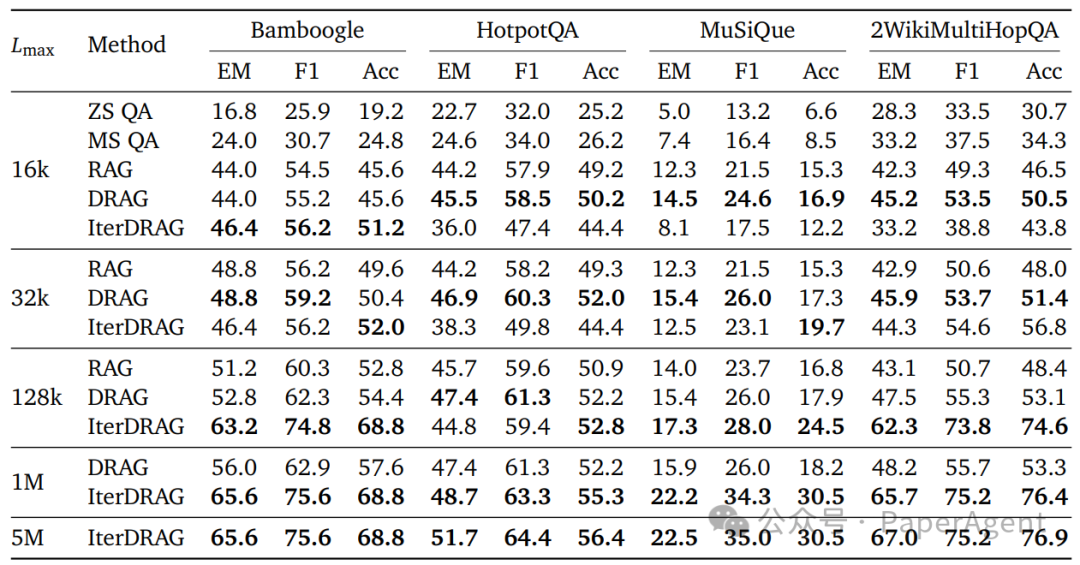

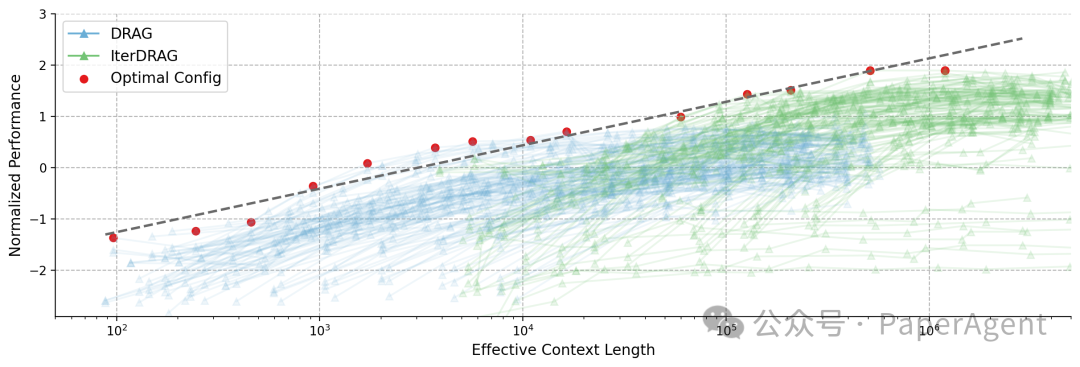

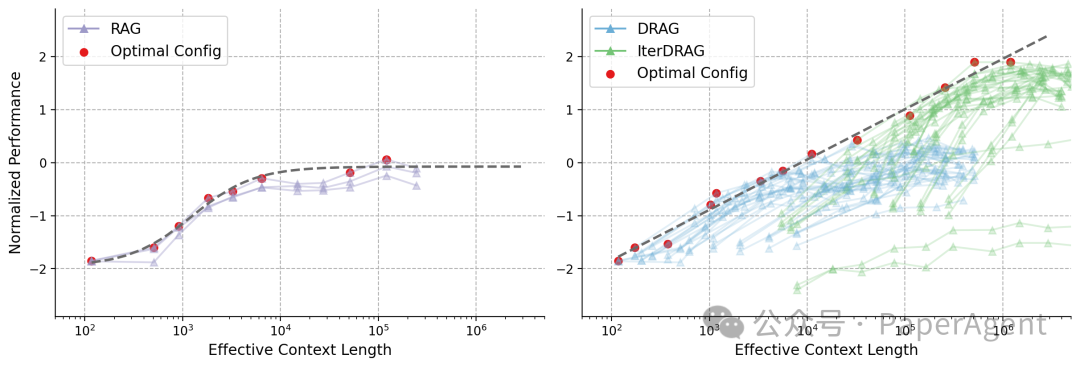

通过扩展最大有效上下文长度,DRAG和IterDRAG的性能一致地提升,表明增加计算预算对RAG性能是有益的。

特别地,IterDRAG在更长的有效上下文长度下(例如超过128k tokens)展现了比DRAG更有效的扩展。

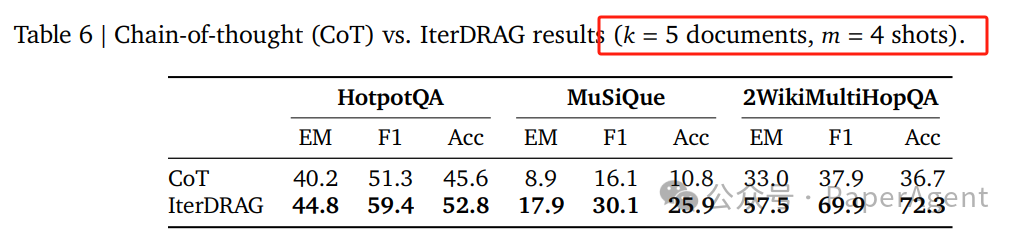

不同方法在不同最大有效上下文长度 LmaxLmax(即所有迭代中的输入token总数)下的最佳性能。ZS QA和MS QA分别指one shot QA和many shot QA。对于不随 LmaxLmax 增加而进一步扩展的方法。将每个 LmaxLmax 的最佳结果加粗显示。

RAG的推理扩展法则:

通过分析不同有效上下文长度下的性能变化,提出了RAG性能随着推理计算规模的增加而近乎线性提升的观察结果,这被称为RAG的推理扩展法则。

-

线性关系: RAG性能随着推理计算规模的增加而近乎线性提升,这种关系被称为RAG的推理扩展法则。

-

IterDRAG的扩展性: 对于超过10^5个token的上下文长度,IterDRAG通过交替检索和迭代生成继续有效扩展。

-

性能增益递减: 当有效上下文长度超过1M个token时,最优性能的增益逐渐减少,这可能归因于长上下文建模的局限性。

跨数据集的标准化性能与有效上下文长度的对比。每条线代表一个固定的配置,通过改变文档数量来进行缩放。红点表示最优配置,虚线显示拟合结果。观察到的最优性能可以通过与有效上下文长度的线性关系来近似。

MuSiQue上标准化性能与有效上下文长度的对比。每条线代表一个固定的配置,通过调****整文档数量来进行缩放。红点和虚线代表最优配置及其拟合结果。标准RAG在104104个token时早早达到平稳状态,相比之下,DRAG和IterDRAG随着有效上下文长度的增长显示出近乎线性的提升。

**使用不同方法评估Gemini 1.5 Flash的准确率:**零-shot QA、多-shot QA、RAG(带有最佳数量的文档)、DRAG和IterDRAG在基准QA数据集上的表现。通过扩展推理计算(最多5M个token),DRAG持续优于基线,而IterDRAG通过交错检索和迭代生成改进了DRAG。

最后的最后

感谢你们的阅读和喜欢,我收藏了很多技术干货,可以共享给喜欢我文章的朋友们,如果你肯花时间沉下心去学习,它们一定能帮到你。

因为这个行业不同于其他行业,知识体系实在是过于庞大,知识更新也非常快。作为一个普通人,无法全部学完,所以我们在提升技术的时候,首先需要明确一个目标,然后制定好完整的计划,同时找到好的学习方法,这样才能更快的提升自己。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1557

1557

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?