目录

摘要

基于用户-物品图的推荐表示学习已经从使用单一 ID 或交互历史发展到利用高阶邻居。这导致了图卷积网络(GCNs)在推荐方面的成功,如 PinSage 和 LightGCN。尽管具有有效性,但我们认为它们存在两个局限性:(1)高阶节点对表示学习的影响更大,使低阶(长尾)项目的推荐恶化;(2)由于邻域聚集方案进一步扩大了观测边缘的影响,表征容易受到噪声相互作用的影响。

在这项工作中,我们探索了用户项图的自监督学习,以提高GCNs推荐的准确性和鲁棒性。其思想是用一个辅助的自监督任务来补充经典的推荐监督任务,通过自我区分来加强节点表示学习。具体来说,我们生成一个节点的多个视图,最大限度地提高同一节点的不同视图与其他节点的一致性。我们设计了三个操作符来生成视图——节点丢弃、边丢弃和随机游走——它们以不同的方式改变图的结构。我们将这种新的学习范式称为自监督图学习(SGL),并在最先进的LightGCN模型上实现它。通过理论分析,我们发现SGL具有自动挖掘难负样本的能力。在三个基准数据集上的实证研究证明了SGL的有效性,它提高了推荐的准确性,特别是在长尾项目上,以及对交互噪声的鲁棒性。我们的实现可以在https://github.com/wujcan/SGL上获得。

总结:使用节点丢弃、边丢弃和随机游走三种策略改变图结构,使用辅助的自监督任务训练以增强节点表示,进而增强推荐效果。最终表明,该方法在长尾项目上,以及应对交互噪声上,有良好的表现。

引言

基于用户-物品二部图推荐的表征表示学习已经从使用单一ID或交互历史演变到利用高阶邻居学习。基于这个思想,图卷积网络(graph convolution networks,GCNs)在推荐系统中取得了巨大成功。例如PinSage,LightGCN。尽管基于GCN的方法取到了不错的效果,但我们认为这些方法仍然受到了一些限制:

- 监督信号稀疏(数据稀疏):目前大多数推荐学习任务都是基于监督学习的范式,其中监督信号一般指用户和物品的交互数据。然而这些交互数据通常来说是异常稀疏的,不足以学习高质量的表征。

- 倾斜的数据分布(幂律分布):推荐系统的交互数据通常呈现幂律分布,其中长尾部分low-degree的物品节点缺乏监督信号。然而,high-degree的物品节点在邻居聚合和监督学习损失中占据了主导地位,对表征学习影响更大。因此,基于GCNs的方法倾斜于high-degree物品节点,牺牲了low-degree物品推荐的性能。

- 交互噪音:用户提供的交互大多数是隐式的(clicks,views),而不是显式的(ratings,likes,dislikes)。因此,收集到的交互通常包含噪声,如用户误点击了一个物品。而GCNs中的邻居聚合操作则会加大这些交互噪音的影响,使得模型训练更容易受到交互噪音的影响。

本文意在探索自监督学习(Self-supervised Learning, SSL)在用户-物品二部图上的应用,辅助推荐模型训练学习,应用self-discrimination来学习更加鲁棒的节点表征。具体来说,通过基于图结构的数据增强来生成一个节点的多个视图,最大化同一节点不同视图间(正样本对)的一致性(agreement)以及最小化不同节点视图间(负样本对)的一致性。本文设计了三张数据增强操作 —— node dropout, edge dropout, and random walk,并将这种新的学习范式称为Self-supervised Graph Learning(SGL)自监督图学习。下面章节将会具体介绍SGL。

总结:在该段提出了使用GCN来做推荐的三个问题,分别是数据稀疏问题、长尾问题、交互噪音影响节点表示问题,并提出了解决策略。

预备知识

总结:该部分讲了 GCN 如何用在推荐上,如何学习节点的表示。以及讲解了监督学习的 loss 使用的是 BPR loss。

方法

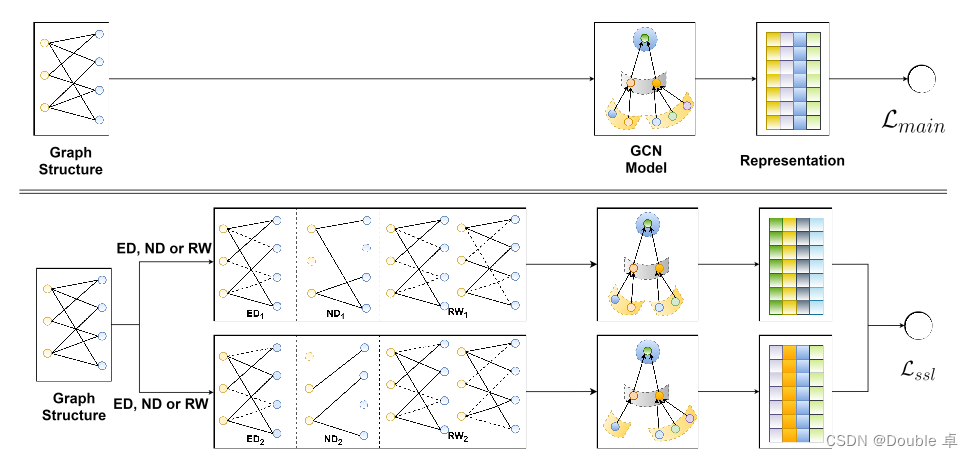

本节将定义自监督图学习(Self-supervise Graph Learning, SGL)范式,作为监督学习任务的补充,实验证明非常有效。图1展示了SGL的流程,简单来说,自监督学习任务从输入数据之间的关联构建监督信号。

下面,我将介绍如何对图结构进行数据增强生成多个视图,然后基于生成的表征进行对比学习来建立自监督学习(Self-supervised Learning, SSL)任务,之后SSL与基于GCN的方法结合进行多任务学习,随后,我将从梯度的角度对SSL进行理论分析,解析SSL与难负样本挖掘的关联,最后我将简单分析一下模型时间复杂度。

3.1 图结构数据增强

使用节点丢失(对节点有概率的丢失)、边丢失(对边有概率的丢失)和随机游走

3.2 对比学习

总结:对比学习的学习目标是将同一节点不同视图学习一致性,不同节点不同视图强化差异性。

3.3 多任务学习

3.4 理论分析

为什么 SGL 的效果好?

因为 SGL 具有挖掘难负样本的能力,难负样本对梯度下降进行了有效的指导。

实验(待补充)

结论(待补充)

1558

1558

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?