文章目录

📑前言

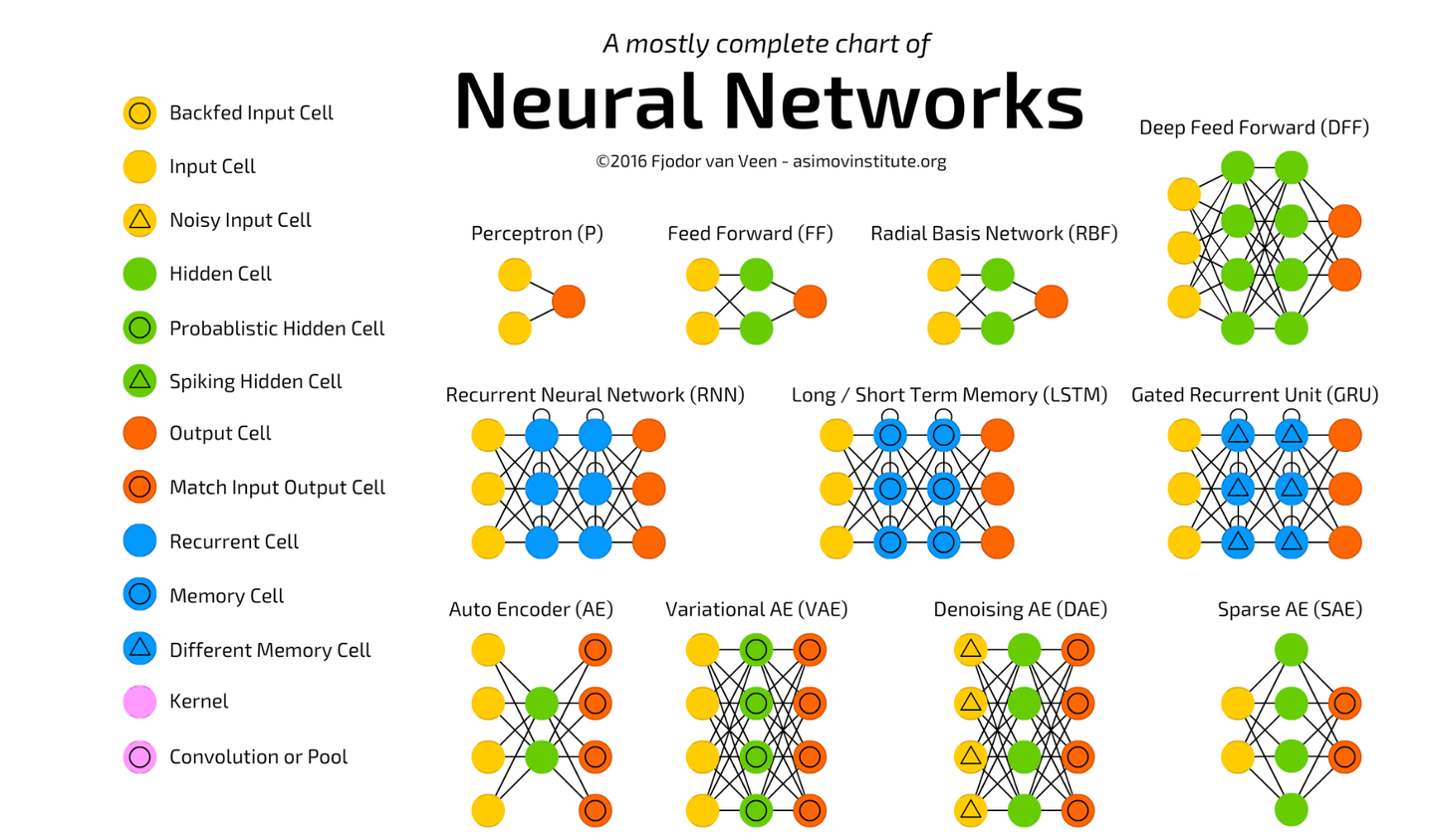

在人工智能和深度学习领域,生成对抗网络(GAN)固然引人注目,但还有许多其他的重要模型也在推动技术的发展和应用。其中,自编码器(Autoencoder)与变分自编码器(VAE)、图神经网络(GNN)、以及Transformer模型都是深度学习领域的核心模型,具有广泛的应用和深远的影响。本文将深入探讨这些模型的基本概念、工作原理及其应用。

一、自编码器与变分自编码器(VAE)

1.1 自编码器的基本概念

自编码器是一种无监督学习模型,通过将输入数据编码为低维表示(编码过程),再从低维表示重建输入数据(解码过程),实现对数据的特征提取和降维。自编码器由两个主要部分组成:

- 编码器(Encoder):将输入数据转换为低维的隐空间表示。

- 解码器(Decoder):从隐空间表示重建输入数据。

自编码器的目标是最小化输入数据与重建数据之间的差异,通常使用均方误差(MSE)作为损失函数。

1.2 自编码器的应用

自编码器广泛应用于数据降维、特征提取、异常检测、去噪、图像生成等领域。例如:

- 数据降维:自编码器可以将高维数据映射到低维空间,从而降低数据维度,提高后续任务(如分类、聚类)的效率。

- 异常检测:通过比较输入数据和重建数据的差异,自编码器可以检测出异常样本。

- 图像去噪:自编码器可以从噪声图像中学习到无噪声的表示,从而实现图像去噪。

1.3 变分自编码器(VAE)

变分自编码器(Variational Autoencoder, VAE)是自编码器的一种变体,通过引入概率生成模型和变分推断技术,使模型能够生成多样性更高、更逼真的数据。VAE在编码器和解码器之间加入了正则化项,使隐空间表示具有连续性和良好的结构。

VAE的关键特性包括:

- 隐空间的连续性:通过正则化项,VAE的隐空间表示是连续的,可以实现平滑的数据生成。

- 生成模型:VAE可以生成新的数据样本,具有很高的多样性。

VAE广泛应用于图像生成、文本生成、数据增强等领域,特别是在需要生成多样性数据的任务中表现优异。

二、图神经网络(GNN)

2.1 图神经网络的基本概念

图神经网络(Graph Neural Networks, GNNs)是一类专门处理图结构数据的神经网络模型。图是一种强大的数据结构,由节点(Nodes)和边(Edges)组成,用于表示实体及其关系。在许多实际应用中,如社交网络、生物网络、推荐系统等,数据天然具有图结构。

GNN的核心思想是通过消息传递机制(Message Passing)在图中传播和聚合节点的特征,从而学习节点的表示。每个节点通过与邻居节点交换信息,逐层更新自己的特征表示。

2.2 GNN的工作原理

GNN的主要步骤包括:

- 特征初始化:每个节点的特征向量初始化为输入特征。

- 消息传递:每个节点从其邻居节点接收信息,并结合自身特征进行更新。

- 特征更新:通过聚合邻居节点的信息,更新节点的特征表示。

GNN的常见变体包括图卷积网络(GCN)、图注意网络(GAT)、图嵌入网络(GraphSAGE)等。

2.3 GNN的应用

GNN在许多领域有广泛的应用,包括但不限于:

- 社交网络分析:在社交网络中,GNN可以用于节点分类、边预测、社区发现等任务。

- 推荐系统:GNN可以捕捉用户和物品之间的关系,用于个性化推荐。

- 生物信息学:在蛋白质结构预测、药物发现等任务中,GNN可以用于建模分子和蛋白质的图结构。

三、Transformer模型及其应用

3.1 Transformer模型的基本概念

Transformer模型由Vaswani等人在2017年提出,最初应用于自然语言处理(NLP)任务,如机器翻译。与传统的循环神经网络(RNN)和卷积神经网络(CNN)不同,Transformer完全基于注意力机制(Attention Mechanism),能够并行处理序列数据,大大提高了训练效率和效果。

Transformer的核心组件包括:

- 自注意力机制(Self-Attention):通过计算输入序列中各元素之间的相关性,自注意力机制能够捕捉全局信息。

- 多头注意力机制(Multi-Head Attention):通过多个注意力头并行计算,提高模型的表示能力。

- 前馈神经网络(Feed-Forward Neural Network):在每个注意力层之后,使用前馈神经网络进行特征转换。

3.2 Transformer模型的应用

Transformer模型在自然语言处理领域取得了巨大成功,其变体BERT、GPT、T5等模型在多个NLP任务中达到了最先进的性能。以下是一些典型应用:

- 机器翻译:Transformer模型在机器翻译任务中表现出色,可以实现高质量的语言翻译。

- 文本生成:通过训练语言模型,Transformer可以生成连贯且有意义的文本内容。

- 文本分类:Transformer模型可以用于情感分析、主题分类等文本分类任务。

- 问答系统:基于Transformer的问答系统可以在给定上下文的情况下,回答用户提出的问题。

3.3 Transformer在其他领域的应用

除了自然语言处理,Transformer模型在计算机视觉、语音处理等领域也展现了强大的能力。例如:

- 图像分类:Vision Transformer(ViT)模型将图像分割成小块,通过Transformer进行处理,实现了优异的图像分类效果。

- 语音识别:Transformer模型在语音识别任务中可以捕捉长时间依赖关系,提高语音识别的准确率。

四、小结

自编码器(Autoencoder)与变分自编码器(VAE)、图神经网络(GNN)、Transformer模型是深度学习领域的重要模型,具有广泛的应用和深远的影响。自编码器通过特征提取和降维,实现了对数据的高效表示和重建;GNN通过处理图结构数据,揭示了复杂网络中的关系和模式;Transformer模型通过注意力机制,实现了对序列数据的高效处理,在自然语言处理等领域取得了突破性进展。

7926

7926

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?