GRU(门控循环单元)、CNN-GRU(卷积神经网络结合GRU)、TCN-GRU(时间卷积网络结合GRU)以及TCN_GRU_Attention(时间卷积网络、GRU结合注意力机制)的原理和结构的详细介绍。

| 代码获取戳此:GRU合集(GRU、CNN-GRU、TCN-GRU、TCN_GRU_Attention) |

1. GRU(门控循环单元)

原理

GRU是一种特殊的循环神经网络(RNN)单元,旨在解决标准RNN在处理长序列时出现的梯度消失和梯度爆炸问题。GRU通过引入两个门控机制(更新门和重置门)来控制信息的流动,从而能够捕获长期依赖关系。

结构

GRU单元的结构主要包含以下部分:

- 重置门(Reset Gate):决定如何将新的输入信息与前一时刻的状态信息结合,以产生候选状态。

- 更新门(Update Gate):决定如何结合当前时刻的候选状态和前一时刻的隐藏状态,以产生当前时刻的隐藏状态。

- 候选状态(Candidate State):基于重置门和前一时刻的隐藏状态,结合当前输入,产生一个新的候选状态。

- 隐藏状态(Hidden State):基于更新门和候选状态,结合前一时刻的隐藏状态,产生当前时刻的隐藏状态。

2. CNN-GRU

原理

CNN-GRU是将卷积神经网络(CNN)和GRU结合起来的模型。CNN用于从原始输入数据中提取局部空间特征,而GRU则用于处理这些特征之间的时序关系。这种结合使得模型能够同时捕获数据的空间和时间特征。

结构

CNN-GRU的结构主要包括两部分:

- CNN部分:负责从原始输入数据中提取局部空间特征。这通常通过多个卷积层、池化层和激活函数实现。

- GRU部分:接收CNN输出的特征图作为输入,并处理这些特征图之间的时序关系。GRU的输出可以用于各种任务,如分类、回归或序列生成。

3. TCN-GRU

原理

TCN-GRU是将时间卷积网络(TCN)和GRU结合起来的模型。TCN通过卷积操作和因果卷积来捕获序列中的长期依赖关系,而GRU则进一步处理这些依赖关系并产生最终的输出。这种结合使得模型能够同时利用卷积网络的并行计算能力和循环网络的记忆能力。

结构

TCN-GRU的结构主要包括两部分:

- TCN部分:负责从原始序列数据中提取长期依赖关系。TCN使用一维卷积层和因果卷积来确保信息只能沿时间方向向前传播。此外,TCN还常常使用空洞卷积(也称为膨胀卷积)来增加感受野的大小。

- GRU部分:接收TCN输出的特征序列作为输入,并处理这些特征序列之间的时序关系。GRU的输出可以用于各种任务,如时间序列预测、自然语言处理等。

4. TCN_GRU_Attention

原理

TCN_GRU_Attention是在TCN-GRU的基础上引入了注意力机制的模型。注意力机制允许模型在处理序列数据时关注重要的部分而忽略不相关的部分,从而提高模型的性能。

结构

TCN_GRU_Attention的结构在TCN-GRU的基础上增加了注意力层:

- TCN部分和GRU部分:与TCN-GRU相同,分别负责从原始序列数据中提取长期依赖关系和处理这些依赖关系。

- 注意力层:接收GRU输出的特征序列作为输入,并计算每个特征的重要性权重。这些权重用于对特征序列进行重新加权,以便模型能够关注重要的部分而忽略不相关的部分。最后,加权后的特征序列被用于产生最终的输出。

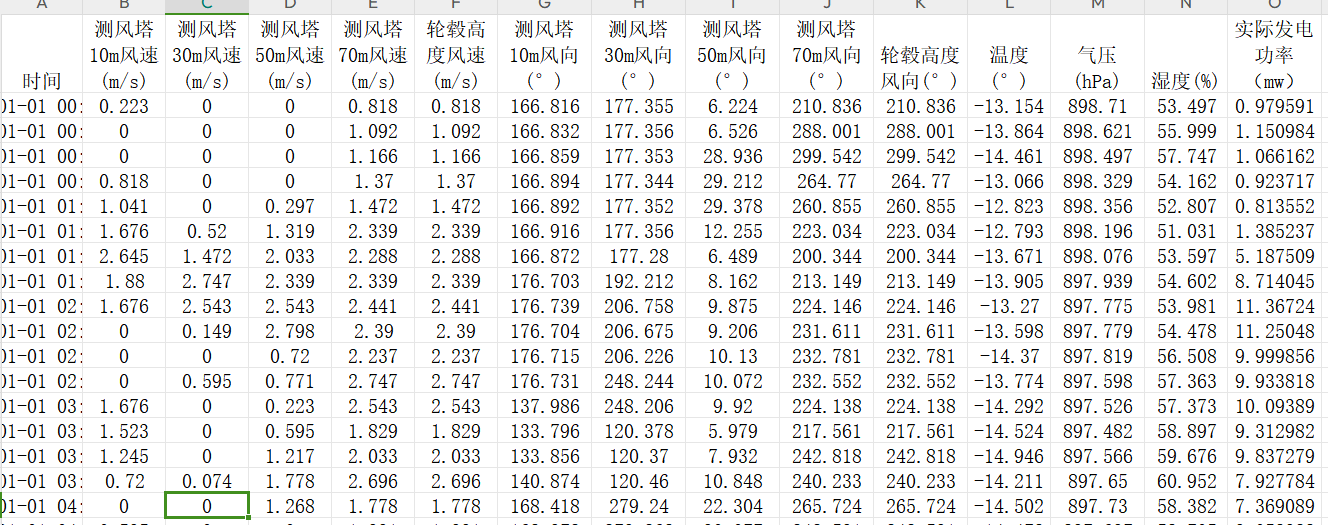

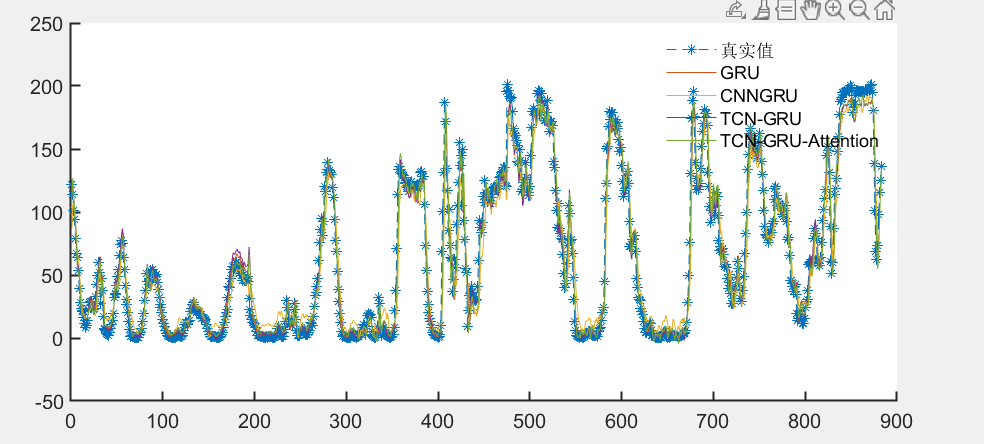

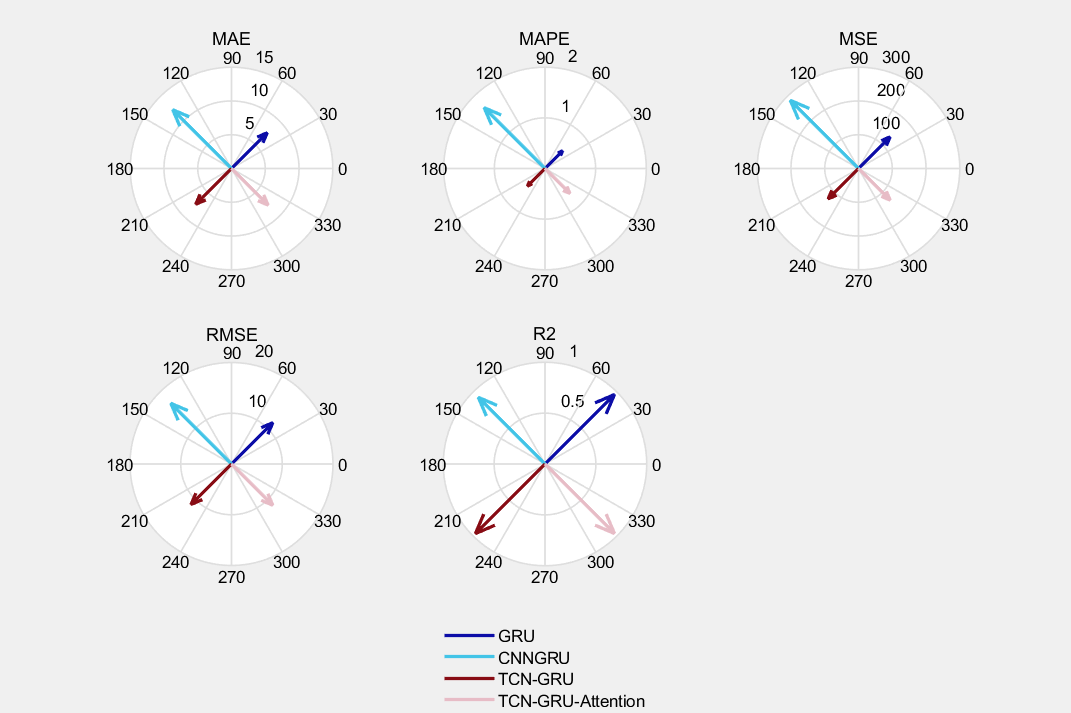

基于风电预测数据集进行效果对比:

预测效果对比:

975

975

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?