大模型(LLM)是一种人工智能模型,旨在理解和生成人类语言。它们在大量的文本数据上进行训练,可以执行广泛的任务,包括文本总结、翻译、情感分析等等。LLM的特点是规模庞大,包含数十亿的参数,帮助它们学习语言数据中的复杂模式。这些模型通常基于深度学习架构,如转化器,这有助于它们在各种NLP任务上取得令人印象深刻的表现。

2022年底,OpenAI 推出的基于 GPT-3.5 的大型语言模型 ChatGPT,由于其优秀的表现,ChatGPT 及其背后的大型语言模型迅速成为人工智能领域的热门话题,吸引了广大科研人员和开发者的关注和参与。

本周精选了5篇LLM领域的优秀论文,为了方便大家阅读,只列出了论文标题、AMiner AI综述等信息,如果感兴趣可点击查看原文,PC端数据同步(收藏即可在PC端查看),每日新论文也可登录小程序查看。

如果想要对某篇论文进行深入对话,可以直接复制论文链接到浏览器上或者直达AMiner AI页面:

https://www.aminer.cn/chat/g/explain?f=cs

1.LLM2Vec: Large Language Models Are Secretly Powerful Text Encoders

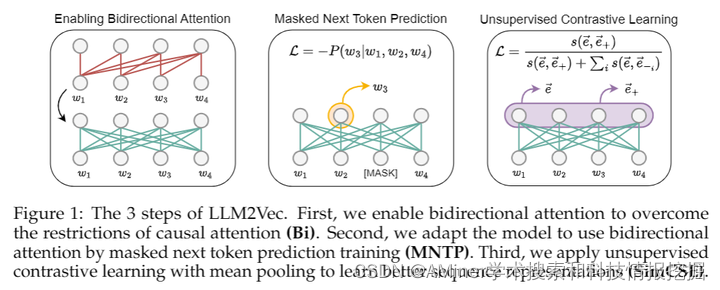

这篇文章指出,尽管大型仅解码器语言模型(LLMs)在当今大多数自然语言处理任务和基准测试中是最先进的模型,但社区对这些模型在需要丰富上下文化表示的文本嵌入任务上的采用却较为缓慢。该研究引入了一种简单的无监督方法LLM2Vec,它可以将任何仅解码的LLM转换成强大的文本编码器。LLM2Vec包含三个简单步骤:1) 启用双向注意力,2) 遮蔽下一个标记预测,3) 无监督对比学习。作者通过将LLM2Vec应用于3个流行的LLM,这些LLM的参数范围从13亿到70亿,并在英语单词级别和序列级别任务上评估了转换后的模型。在单词级别的任务上,LLM2Vec显著超越了仅编码器模型,并在大规模文本嵌入基准测试(MTEB)上达到了新的无监督最先进性能。此外,当将LLM2Vec与有监督的对比学习结合使用时,在仅使用公开可用数据训练的模型中,在MTEB上实现了最先进的性能。作者通过强有力的实证结果和广泛的分析表明,LLM可以有效地以一种参数高效的方式转换成通用文本编码器,无需昂贵的适应或合成GPT-4生成的数据。

链接:https://www.aminer.cn/pub/6615f2ab13fb2c6cf6dc7675/?f=cs

2.Elephants Never Forget: Memorization and Learning of Tabular Data in Large Language Models

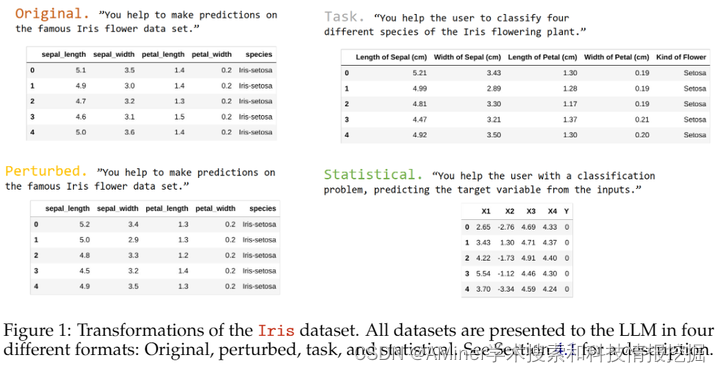

本文关注于大型语言模型(LLM)在处理表格数据时,数据污染和记忆问题的关键问题。作者引入了多种不同的技术手段来评估语言模型在训练过程中是否接触过表格数据集。研究揭示了LLM模型已经逐字逐句记忆了许多流行的表格数据集。接下来,作者比较了模型在训练过程中看到的和在训练后发布的数据集上的少样本学习表现。研究发现,LLM在训练时看到的数据集上表现更好,这表明记忆可能导致过拟合。同时,LLM在新数据集上表现出了非 trivial 的性能,并且对数据转换表现出出奇地坚韧。然后,作者研究了LLM的现场统计学习能力,结果表明在没有微调的情况下,这种能力是有限的。这表明模型在少样本新数据集上的表现很大程度上得益于其世界知识。总的来说,本文强调了在预训练阶段测试LLM是否看到过评估数据集的重要性。作者将开发的曝光测试作为tabmemcheck Python包提供,以供研究者和开发者使用。

链接:https://www.aminer.cn/pub/6615f2ab13fb2c6cf6dc7731/?f=cs

3.Language Model Evolution: An Iterated Learning Perspective

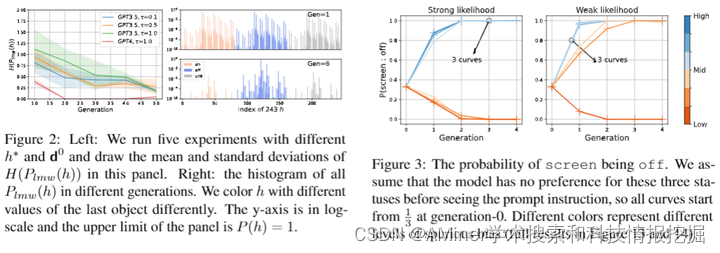

随着大规模语言模型(LLM)的广泛应用,预计这些模型之间的迭代互动将增加。最近在多轮自我改进方法方面的进步允许LLM为后续模型的训练生成新示例。同时,涉及自动化互动的多智能体LLM系统也越来越突出。因此,无论是在短期还是长期,LLM可能会积极地参与到一种进化过程中。作者将LLM的行为与人类文化的进化进行类比,因为后者是认知科学家研究了几十年的课题。他们采用了一种称为迭代学习(IL)的贝叶斯框架,该框架阐明了在人类文化进化过程中如何放大微妙的偏见,以此来解释LLM的一些行为。本文概述了在贝叶斯-IL框架中代理行为的关键特征,包括由各种LLM实验验证的支持预测。这个理论框架可能有助于更有效地预测和指导LLM的进化,使之朝向期望的方向。

链接:https://www.aminer.cn/pub/6614a0e313fb2c6cf6f80daa/?f=cs

4.Chinese Tiny LLM: Pretraining a Chinese-Centric Large Language Model

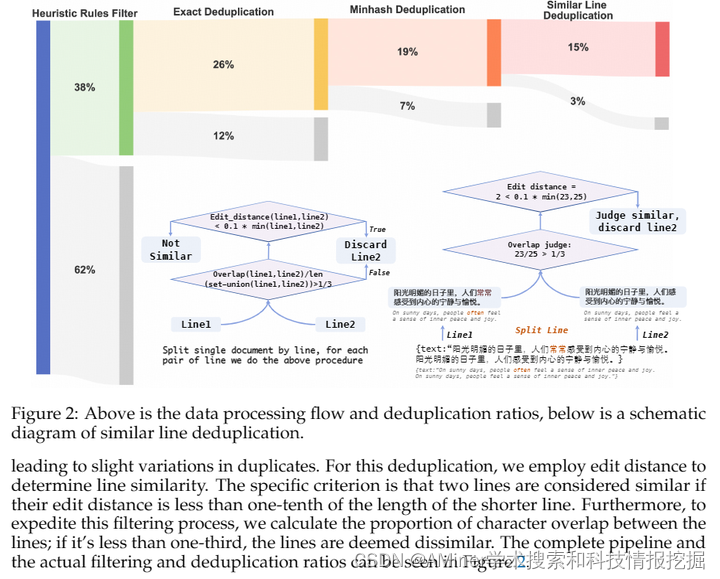

本文介绍了CT-LLM,一个以中文为中心的大型语言模型(LLM),它代表了在开发LLM时优先考虑中文语言的关键转变。CT-LLM从零开始独特地启动,与传统方法不同,它主要包含中文文本数据,并利用了1200亿个标记的大型语料库,包括800亿个中文标记,300亿个英文标记和100亿个代码标记。这种战略性的组合使模型在理解和处理中文方面具有卓越的技能,通过校准技术进一步提高。在CHC-Bench上展示出出色的性能,CT-LLM在中文语言任务上表现出色,并在SFT中展示了它在英文方面的熟练程度。这项研究挑战了主要在英文语料库上训练LLM,然后将它们适应到其他语言的现有范式,为LLM训练方法提供了更广阔的视野。通过开源训练中文LLM的全过程,包括详细的数据处理过程以及获得的巨大适当预训练中文语料库(MAP-CC),精心选择的多学科中文难题基准(CHC-Bench)和2B大小的中文Tiny LLM(CT-LLM),我们旨在促进学术界和行业进一步的探索和创新,为更包容和多功能的语言模型铺平道路。

链接:https://www.aminer.cn/pub/66134f3b13fb2c6cf6d7950f/?f=cs

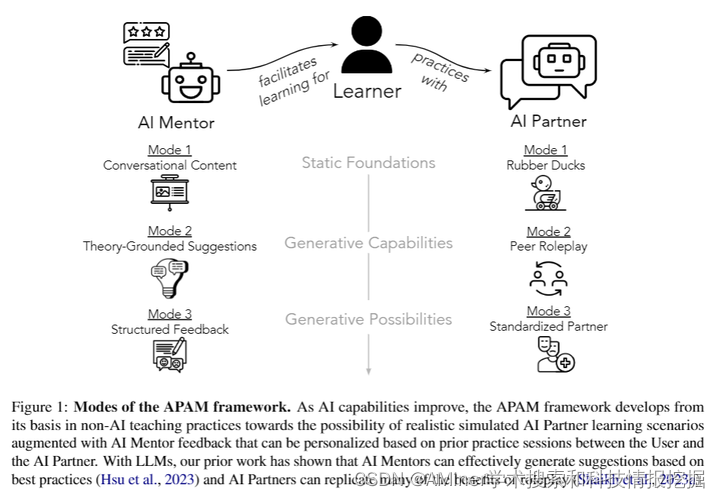

5.Social Skill Training with Large Language Models

这篇论文探讨了如何通过大型语言模型来培训社交技能。人们在工作和个人生活中有效沟通和成功的社交技能,如冲突解决,至关重要。然而,对于大多数人来说,社交技能的实践环境通常是遥不可及的。本文提出了一个解决方案,通过一个通用的框架利用大型语言模型进行社交技能培训。作者提出了一种将体验式学习与现实实践和个性化反馈相结合的AI Partner,AI Mentor框架。最终,这篇论文呼吁跨学科创新,以解决劳动力发展和社会平等的更广泛影响。

链接:https://www.aminer.cn/pub/66134f3b13fb2c6cf6d79539/?f=cs

AMiner AI入口:

https://www.aminer.cn/chat/g/explain?f=cs

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?