点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信号:CVer2233,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

转载自:PaperWeekly

IC-Light论文的分数从均分9分(8/8/10/10)成功rebuttal到均分满分10分(10/10/10/10)。全满分!太强了!据Amusi了解到,这是ICLR 近5年来首个全满分论文(假设这个分数能保持到中稿通知)。

引言

在当今数字图像处理的背景下,图像照明编辑成为了一个重要且充满挑战的领域。传统的计算机图形学方法通常依赖于物理照明模型来模拟图像的外观,这种方法强调了光源与物体之间的相互作用与反射。

然而,随着深度学习和生成模型的发展,基于扩散的图像生成方法逐渐成为处理照明编辑问题的新兴手段。这些方法不仅可以应对更为复杂的“野外”照明效果,还能在图像中灵活地生成各种光照变化,如反向照明、边缘光源、光晕效果等。通过这些技术,艺术家和设计师能够在保持一致的照明条件下修改前景或背景,进而提升视觉内容的创作和操控能力。

尽管基于扩散的照明编辑方法展示了巨大潜力,进行大规模训练并利用强大的模型架构仍然面临诸多挑战。尤其是在处理多样和复杂的数据集时,如何保持模型的期望行为,确保其能够实现准确的照明操作而不是偏离到无序的随机行为,就显得尤为重要。

数据集的增大及多样性是一个双刃剑,它往往会导致学习目标的模糊和不确定性,使教导模型学习到照明的映射变得困难。为了应对这些挑战,本文提出了一种新的方法——一致光传输(IC-Light),通过物理原理确保在修改图像照明的同时保持其内在属性不变。

论文标题:

Scaling In-the-Wild Training for Diffusion-based Illumination Harmonization and Editing by Imposing Consistent Light Transport

代码:https://github.com/lllyasviel/IC-Light

论文地址:

https://openreview.net/forum?id=u1cQYxRI1H

一致光传输的核心思想是,通过确保物体在不同照明条件下的外观的线性叠加与其在混合照明条件下的外观保持一致,从而为模型提供一个强有力的物理约束。

这种一致性不仅支持模型在超过 1000 万张多样化样本上进行稳定的可扩展训练,也为图像的内在属性保持提供了保障。这种方法的有效性和灵活性使得其在多种数据来源的处理上具备广泛的应用潜力,包括真实照明阶段、渲染样本以及合成的野外数据。

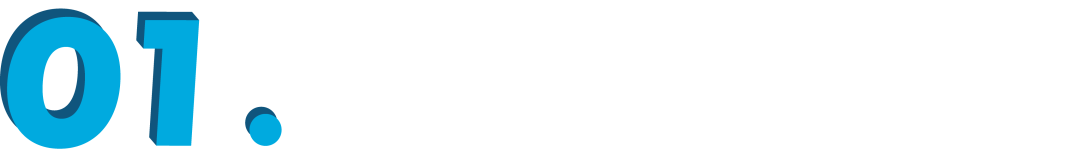

▲ 用户为对象图像和照明描述提供输入,我们的方法生成相应的对象外观和背景。

通过大量的实验证明,IC-Light 方法在降低不确定性、减轻材料不匹配和反射色改变等伪影方面表现出色。这些进展为照明编辑的工业应用提供了坚实基础,预示着基于扩散的图像生成技术在创意领域的无限可能。

相关工作

在过去十年中,基于深度学习的图像照明编辑方法逐渐成熟,这些方法不仅改进了传统计算机图形学技术,还利用神经网络学习复杂的照明模型。

研究者们首先利用深度神经网络从光阶段数据中提取先验知识(Sun et al., 2019),随后有研究针对神经网络的能力进行了增强,使用物理先验进行训练(Nestmeyer et al., 2020)。此外,Pandey et al. (2021) 利用高动态范围(HDR)照明图来训练重照明模型,显式优化 Phong 模型的先验。

近年来,扩散模型在图像生成和操控方面展现出了巨大的潜力(Dhariwal & Nichol, 2021;Ho et al., 2020)。这些模型能够有效地处理图像编辑任务(Ho & Salimans, 2021),并基于文本生成高质量的图像(Rombach et al., 2022)。例如,Relightful Harmonization(Ren et al., 2024)方法将前景照明的操控与背景条件相结合,成功实现了照明的调整。

类似的,DilightNet(Zeng et al., 2024)、FlashTex(Deng et al., 2024)和Neural Gaffer(Jin et al., 2024)等方法主要基于三维渲染数据进行物体外观操控。

除了基于深度学习的模型,传统的计算机图形学技术仍然在照明编辑界占据重要地位。许多研究(Dorsey et al., 1995;Debevec et al., 2000)展示了如何在图像渲染中准确模拟照明效果,包括光源类型和背景影响等因素。这些研究为本研究提供了理论基础,使得结合扩散模型和物理背景的照明编辑变得可行。

尽管已有大量研究在图像照明编辑领域取得了显著进展,但这些方法仍存在一定的局限性,如在复杂场景中保持内在属性(如反射率和细致的图像细节)的能力较弱。

本研究将通过一致光传输(IC-Light)的方法进行扩展和完善,以确保照明操控精准且不影响图像的其他内在属性。这一方法的提出不仅填补了现有研究的空白,也为未来的图像编辑技术发展提供了新的视角和思路。

方法论

在本节中,研究团队提出了一种称为一致光传输(IC-Light)的方法,旨在处理图像的照明编辑问题。该方法基于光传输的物理原理,确保在修改图像照明时能够保留图像的内在属性,例如反照率(albedo)和细节。

3.1 一致光传输的原理一致光传输的核心理念是,物体在不同照明条件下的外观线性混合,总体上能够与在混合照明条件下的外观保持一致。即对于给定的任意外观 和关联的环境照明 ,存在一个矩阵 使得:

这里, 可以视为数据格式中的 。

这种线性关系阐明了根据不同光源条件下物体外观的混合表现与在合成照明下的外观是等效的。这一现象得到现实世界测量的验证(例如,Haeberli, 1992)。通过这种观点,研究者能够确保模型在训练过程中只修改图像的照明,而不改变其内在属性,进而引入了一致性损失函数来保持这种线性关系:

其中, 是一组掩膜,表示在该区域有效,仅在有光照的部分计算一致性损失, 是一个可学习的多层感知机(MLP),旨在替代总和项。

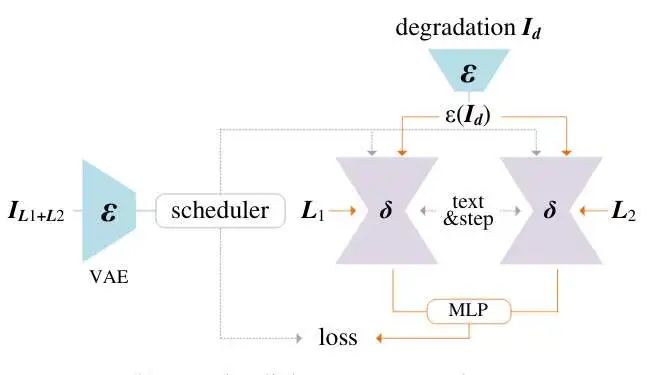

3.2 方法流程

研究团队的训练目标结合了两个主要的损失函数:一个是基础图像重采样损失 和一致性损失 的加权组合。最终的学习目标可以写成:

在这一目标中,使用的默认为权重设置为 和 。

通过实施上述一致光传输约束,模型不仅能驰骋于光照编辑的各类任务,还能在进行图像内容生成时较好地保持细节和内在属性。关键的一点是,模型在随机选择不同的环境光源时,依然能够保持对变换前后的色彩、亮度以及细节的控制。

在图 3 中,以图 [3-(a)] 作为基础,仅使用标准的图像条件扩散模型进行照明学习,并与图 [3-(b)] 中的光传输一致性实施方案进行对比,可以看出在保持图像细节的同时更为有利于生成一致性的光照效果。

▲ 学习目标

通过这种方法,IC-Light 实现了更稳定的训练表现,能够处理大规模、复杂的和噪声数据,确保模型可以广泛应用于真实场景的照明编辑。

实验设计

本节详细描述了实验的设置、数据来源以及模型训练的细节。研究团队旨在通过大规模数据集采集和优化算法的应用,以测量一致光传输(IC-Light)方法在照明编辑中的表现。

4.1 数据来源

在本研究中,数据集主要来源于以下几个部分:

野外图像数据:通过在大约 5000 万张图像中进行筛选,最终选择了 6 百万张图像来进行训练。这一过程涉及到与“美丽照明”、“光线”和“照明”等关键词的 CLIP 视觉相似性比较,确保所选图像具有较高的照明质量。

3D 渲染数据:使用 Objaverse 数据集进行渲染,采取了一种基于图像的渲染管线以提高速度,最终形成约 400 万张图像。

光阶段数据:从多个光阶段数据集中提取,汇总了 20,000 个光阶段样本。这些数据被预处理成统一格式,以便训练模型时使用。

通过整合来自不同来源的数据,研究团队确保模型能够接触到多样化的照明场景,进而提升模型的泛化能力。

4.2 优化算法和模型训练

模型训练过程中,研究团队使用 AdamW 优化器,并设置学习率为 1e-5。预训练好的 Stable Diffusion 模型包括 SD 1.5、SDXL 和 Flux.1.0-dev。训练过程在 8台 H100 80GB NVLink GPU 上进行,最大化批处理大小以提高训练效率。

此外,针对每个模型的训练时长也被精确记录:

SD 1.5 模型训练耗时约 100 小时。

SDXL 模型首先在 512 分辨率下训练 80 小时,然后在 1024 分辨率下微调 60 小时。

对于 Flux 模型,采用了多阶段的训练策略,为了应对模型的复杂性,研究团队分别训练了双流和单流部分,并对部分梯度图进行了冻结。

4.3 数据集平衡

为确保训练效果,研究团队在训练早期采用调度概率来平衡各数据集的贡献。具体来说,通过调整初期阶段野外图像数据和 3D 渲染数据的出现概率为 0.5,而光阶段数据的出现概率为 0.0。在经过 10 万次迭代后,随着训练的深入,光阶段数据的出现概率逐步增加到 0.3,确保在最终模型中包含一定比例的高质量光阶段数据。

这种动态调整的方式,使得模型不仅能在初期获得对多种数据来源的理解,同时在后期也能够借助高质量的数据提升最终性能。

在模型训练过程中,核心损失函数的形式如下:

其中, 表示综合损失, 和 分别对应于基础图像条件扩散模型的损失和一致光传输的损失函数。

4.5 实验流程图

如下图所示,研究团队在训练过程中融合了数据来源与模型架构,以确保输出的图像保持内在属性的一致性:

▲ Dataset collection

通过以上详细的实验设计,研究团队旨在验证一致光传输方法在大规模、多样化图像照明编辑中的有效性,期望该方法能够为后续的实际应用奠定坚实基础。

实验结果与讨论

本节将呈现对比实验的结果,展示提出的方法在光照编辑任务中的优势与局限性。通过定量指标与定性结果的综合分析,旨在探讨影响模型表现的关键因素。

5.1 实验结果

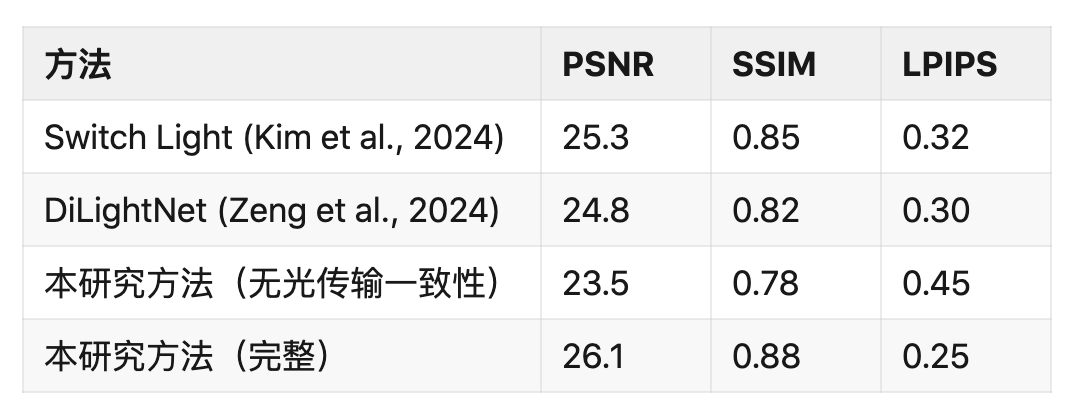

采用多种评价指标对模型表现进行量化评估,包括峰值信噪比(PSNR)、结构相似性指数(SSIM)以及学习感知图像块相似性(LPIPS)等。这些指标用于量化模型在生成图像上的保真度和视觉质量。表 1 展示了不同实验组的定量评估结果。

▲ 表1: 定量测试的评估结果

如表中所示,完整的方法在所有指标上均表现出色,尤其在 LPIPS 指标上,表明其生成的图像具有优越的感知质量。相比之下,仅依赖 3D 渲染数据训练的模型在 PSNR 上表现最佳,但显然存在评估偏差。

5.2 定性结果

除了定量结果外,定性分析也显示了所提出方法的优势。通过与其他现有方法的视觉比较,如图 6 所示,本研究的方法在处理复杂阴影和光照变化上表现出更强的鲁棒性。具体来说,生成的图像更好地保留了原始图像中的细节与色彩,尤其是在光源及材质变化的场景中。

▲ 图6: 视觉比较。这一图展示了本研究方法与其他方法在处理光照情况下的表现。

5.3 影响因素分析

在实验过程中,模型表现受多个因素的影响,特别是在数据源丰富性和训练目标一致性上。通过消除在野外的图像增广数据,模型的泛化能力显著下降。例如,在处理复杂图像(如肖像照片)时,模型往往不能正确渲染附加的物体(如帽子),非常明显的色彩失真。

同样,当去除光传输一致性约束时,模型在生成一致的光照和保持内在属性(如反射率)方面的能力显著下降。在此情况下,图像中不同颜色的差异可能消失,并因色彩饱和度的问题出现明显的视效缺陷。

结合以上定量与定性分析,投射式光传输一致性与多样的训练数据源结合使用,是确保模型在各种光照情况下表现优越的关键因素。

结论

在本研究中,作者提出了一种名为一致光传输(IC-Light)的方法,以扩展基于扩散的照明编辑模型的训练。通过利用物理原理,IC-Light确保了在进行图像照明操控的同时,图像的内在属性如反射率和细节得以保持。

多项实验证明,这一方法不仅提高了模型在多样化照明环境中的鲁棒性和表现,还有效降低了由于在训练过程中数据的复杂性和噪声带来的不确定性。

综上所述,一致光传输方法在照明编辑领域展示了显著的潜力和应用价值。它使得在处理超过一千万张的多样化样本时,模型仍然能保持较高的精确度与一致性,大幅提升了生成结果的视觉质量。

特别是在处理复杂背景或艺术性照明效果时,这一方法显示出了独特的优势。未来的研究方向可能包括进一步提升模型的泛化能力,并探索将其应用于实时图像处理和更加复杂的视觉生成任务。

此外,研究者计划通过引入更多种类的输入和优化算法,进一步改善模型在不同光照条件下的表现,以实现更加自适应、高效的照明编辑。在此过程中,期待 IC-Light 方法能够更进一步地推动图像生成与编辑技术的发展,并为视觉内容的创造提供创新工具和手段。

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!

ECCV 2024 论文和代码下载

在CVer公众号后台回复:ECCV2024,即可下载ECCV 2024论文和代码开源的论文合集CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba、多模态和扩散模型交流群成立

扫描下方二维码,或者添加微信号:CVer2233,即可添加CVer小助手微信,便可申请加入CVer-Mamba、多模态学习或者扩散模型微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba、多模态学习或者扩散模型+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer2233,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集上万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请赞和在看

1580

1580

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?