之前我们已经大概学习了用线性回归(Linear Regression)来解决一些预测问题,详见:

1.《机器学习笔记01:线性回归(Linear Regression)和梯度下降(Gradient Decent)》

2.《机器学习笔记02:多元线性回归、梯度下降和Normal equation》

3.《机器学习笔记03:Normal equation及其与梯度下降的比较》

面对一些类似回归问题,我们可以通过线性回归方法来拟合一个函数,以此来预测数据,但它的输出是连续的。有时候呢,我们需要一种方法给出一个判定结果,例如”同意(agree)”、”不同意(disagree)”。、下面呢就是关于这个方法的新内容,叫做分类(Classification)问题。又例如,如果我们需要预测一辆汽车是好的还是坏的,只有两种结果:好、坏。这种输出为0或者1的问题,就叫做分类问题,而我们对应与此种问题所采用的方法即是逻辑回归(Logistic regression)。

1.分类及其表示(Classification and Representation)

i.分类(Classification)

首先来看看分类(Classification)问题,在第一段中已经简单介绍了什么是分类问题,下面再来举几个例子:

| Examples | Purposes |

|---|---|

| Spam / Not Spam? | |

| Online Transaction | Fraudulent (Yes / No?) |

| Tumor | Malignant / Benign? |

第一个例子是判断垃圾邮件,对一封邮件,我们需要判断它是否为垃圾邮件;第二个例子是在线交易,我们需要判断这个交易是否有欺诈的嫌疑;最后一个例子是肿瘤评估,我们需要对一个病人的病情进行综合分析,来判断肿瘤是恶性的还是良性的。

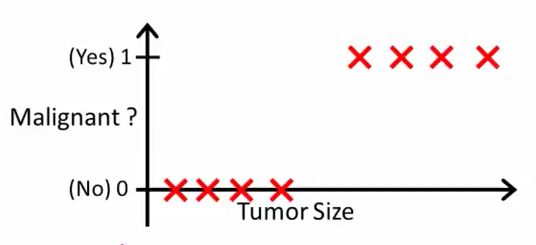

详细地,我们以肿瘤评估为例。我们有如下图所示的一些样本,其横坐标表示肿瘤的大小,纵坐标表示性态(良性还是恶性):

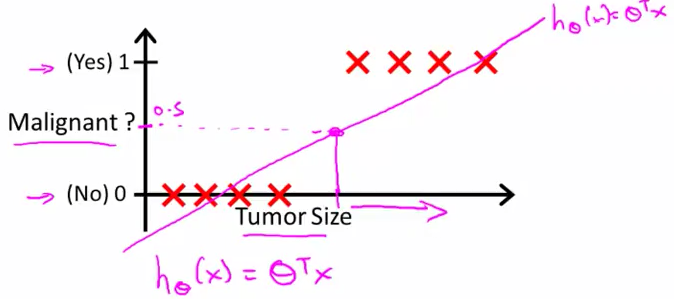

假设我们用一条直线 hθ(x)=θTX 来拟合这些数据,其图像可能大致如下:

如上图所示, hθ(x) 为紫色的直线,如果我们选择 0.5 作为一个基准点来判断一个肿瘤是良性还是恶性的:

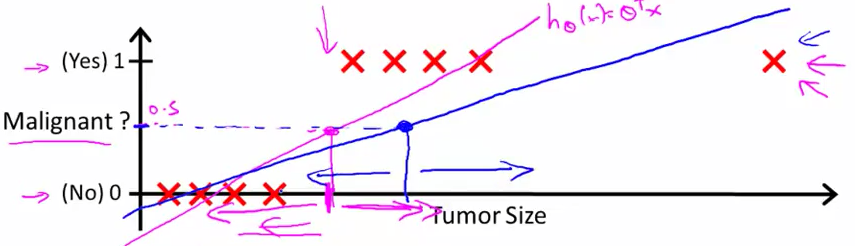

如上图所示,我们增加了一组数据,通过 线性回归(Linear Regression)得到了一条蓝色的直线,但是其看起有点不那么理想,例如有几个恶性肿瘤,也会被分类为良性肿瘤。所以,在分类问题中, 线性回归通常不是一个很好的办法。所以我们需要使用 逻辑回归(Logistic regression)来解决分类问题。逻辑回归是一个 分类算法(classification algorithm)在逻辑回归中,我们要求 0≤hθ(x)≤1 ,下面我们就来看看逻辑回归的假设函数。

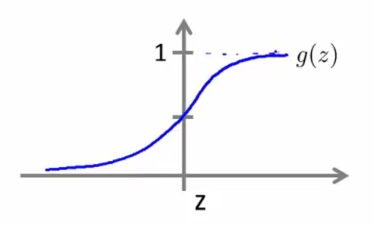

ii.假设函数(Hypothesis)

上面我们提到了,在只有两种结果的分类问题中,它的输出不是 0 即是

其与 y 轴的交点为

现在我们来看一下逻辑回归(Logistic regression)的假设函数的具体意义是什么。

这里的函数 hθ(x) 代表的是关于输入 x ,使得

假设有两个特征:

即给定参数 θ ,关于输入 x ,使得

iii.决策边界(Decision Boundary)

前面提到了 hθ(x)=P(y=1|x;θ) ,那什么时候 hθ(x) 的值为 1 ,什么时候为

当 z≥0 时, hθ(x)≥0.5 ,当 z<0 时, hθ(x)<0.5 。即对于 hθ(x)=g(θTX)≥0.5 ,有 θTX≥0 ;同理,对于 hθ(x)=g(θTX)<0.5 ,有 θTX<0 。

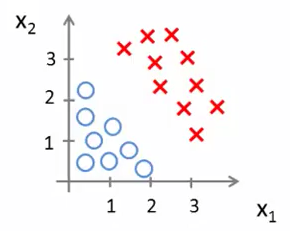

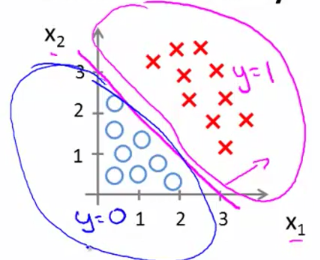

现在我们就来看看决策边界(Decision boundary)的具体内容,假如我们有如图所示的样本集合:

同时假设, 假设函数(hypothesis function)为 hθ(x)=g(θ0+θ1x1+θ2x2) ,并假设 θ0=−3,θ1=θ2=1 。所以此时有:

根据高中就学过的线性规划知识,为与直线右上方的点都能满足不等式 −3+x1+x2≥0 ,即满足 z≥0 。而这条直线就是所谓的 决策边界(Decision boundary)。同时需要指出的是,这条直线只跟参数 θ 有关,跟样本集无关。

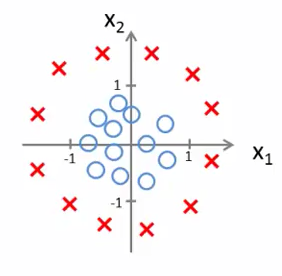

再来看看非线性的情况,样本集如下:

若假设函数为 hθ(x)=g(θ0+θ1x1+θ2x2+θ3x21+θ4x22) ,假设

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?