©作者 | 卫岚宁,赵欢,贺志强

论文标题:

Designing the Topology of Graph Neural Networks: A Novel Feature Fusion Perspective

论文链接:

https://arxiv.org/pdf/2112.14531.pdf

代码链接:

https://github.com/AutoML-Research/F2GNN

该论文已经被国际顶级数据挖掘会议 WebConf 2022 (CCF-A)接收,欢迎大家关注。如有任何问题,欢迎联系 weilanning18z@ict.ac.cn。该论文第一作者卫岚宁是第四范式的研究实习生。

简介

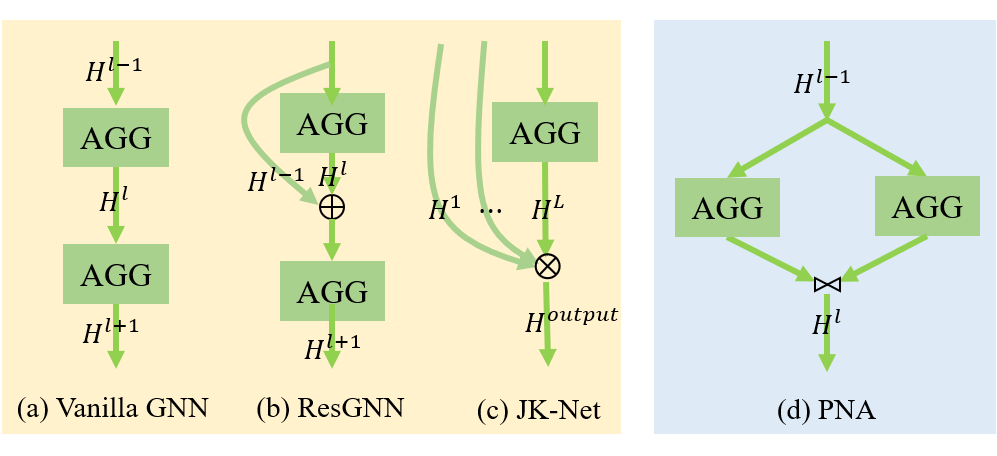

近年来 GNN(Graph Neural Network)成为工业界和学术界非常热门的一个研究方向。GNN 设计中有两个重要维度需要考虑,即 aggregation operation 设计和拓扑结构(topology)设计。目前大家多关注在前者上,对于后者,通常采用堆叠的方式,即一个 GNN 通常由 aggregation operation 堆叠而成,通过这样的方式 GNN 可以触及更高阶的邻居节点,进而获得 higher-level 的特征。但是随着模型层数加深,很容易出现 over-smoothing 的问题,即相连节点的特征可区分性降低,模型效果下降。

一部分方案通过增加 skip-connection 的方式来改善这一点。除了堆叠方式之外,仍有部分方案尝试用多分支的形式来构建 GNN,这类方案能够充分挖掘 local neighbor 的信息,但是因其每层中聚合操作过多,在获取 higher-level 特征上需要更多的计算资源。因此,在设计图神经网络的拓扑结构时一个重要的目标便是整合这两类方案并扬长避短。

▲ 图1:两种拓扑结构设计示意图。左侧为基于堆叠的模式,右侧为基于多分支的模式。

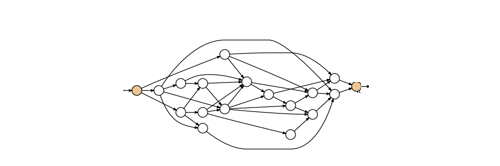

但是如今并没有图神经网络拓扑结构设计的系统性方案。一般来说,一个神经网络的设计结构可以用 computational graph 来表示,如下图所示,其中节点代表了操作,有向边把这些操作相连构成了神经网络的拓扑结构。在 GNN 中,这些边可以解释为对于不同阶特征的使用。除此之外,和 CNN 中不同,GNN 中会引入各类 fusion strategy,通过整合这些不同阶的信息来提升模型性能 [1][2][4],即现有的图神经网络拓扑结构之间的差异是由特征选择和特征融合方案导致的。

▲ 图2:computational graph示意图[3]

基于上述,我们设计一个特征融合框架(feature fusion framework)并用特征选择和特征融合策略来统一现有的拓扑结构设计,因此上述的拓扑结构设计目标就转换为如何设计特征选择和特征融合策略来扬长避短。考虑到现有的图数据的多样性,GNN 在不同的数据上表现各有优劣,因此我们引入 NAS(neural architecture search)来自适应的设计拓扑结构。基于特征融合框架,我们设计了新的搜索空间(search space),并基于这个搜索空间改进了搜索算法。

在本文中,我们提出了新的方案 F2GNN(Feature Fusion GNN)从特征融合的视角来设计图神经网络的拓扑结构,我们在八个数据集上做了实验,其中包括五个同配图(homophily)和三个异配图(heterophily),结果显示自动化设计拓扑结构可以改善 GNN 的性能并且能够规避两类设计方案的劣势,尤其是 over-smoothing 的问题。

背景介绍

现有的 GNN 通常是基于堆叠聚合操作得到,但是随着堆叠层数的加深,实验发现模型的效果在逐渐降低,究其原因是不断聚合导致相邻节点的特征过度平滑,区分性降低。为了解决这个问题并提高模型效果,一些方案通过增加跳跃连接(skip-connection)的方式引入了 GNN 浅层的区分性高的特征,比如 JKNet [4] 和 DAGNN [5] 在 GNN 最后整合所有层的输出,GCNII [6] 则是通过跳跃连接在每一层中都引入原始特征,ResGCN [7] 和 DenseGCN [7] 中的跳跃连接设计则是参考了 ResNet 中的残差连接和 DenseNet 中的密集连接。

除了上述堆叠操作构建 GNN 之外,一部分方案转向多分支的思路,即一层中多个分支并列计算。比如 MixHop [8],一层中三个分支用到了不同阶的邻居

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2677

2677

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?