保姆教程:快速简单免费用DeepSeek + Cherry Studio 搭建本地私域知识库

目录:

一、快速入门

什么是知识库和解决什么问题?

二、搭建步骤概览

三、CherryStudio下载和安装

3.1. CherryStudio下载

3.2. CherryStudio安装

四、CherryStudio 通过硅基流动 集成DeepSeek

4.1. 注册硅基流动账号

4.2. 生成API密钥

4.3. 在CherryStudio中配置siliconflow的 API密钥

五、私域知识库搭建

5.1. 添加DeepSeek模型和Embedding模型

5.2. 创建知识库

5.3. 添加知识库文件

5.4. 使用本地知识库对话

六、本地知识库和联网功能共用的对话

6.1 注册 Tavily 获取 API.

6.2 CherryStudio界面打开联网支持

七、应用其他各种智能体对话

一、介绍

知识库用于帮助用户或系统快速查找和获取相关知识。可以解决大模型撰造知识和幻觉的问题。

举个栗子:

大模型就像一个学生,而知识库系统就是一本字典。

当学生遇到不懂的问题时,他可以翻开字典查找相关的解释,然后再根据字典里的内容回答问题。这样,学生不仅能回答得更准确,还能避免“瞎编”答案。

那么,当大模型遇到不懂的问题时,他也可以查字典。

二、搭建步骤概览

搭建本地知识库:

第一步:使用Cherry Studio可视化集成工具。

第二步:使用硅基流动部署云端DeepSeek模型和Embedding模型。(本地化DeepSeek模型对个人工作场景没有实际意义)

第三步:关联和构建本地知识库,应用调试。

三、CherryStudio下载和安装

3.1. CherryStudio下载

3.2. CherryStudio安装

可以选择安装路径。

四、CherryStudio 通过硅基流动 集成DeepSeek

4.1. 注册硅基流动账号

注册地址:https://cloud.siliconflow.cn/i/jH2AWAkI

此处为邀请码注册,可以免费获得2000万Tokens:

也可扫码注册:硅基流动siliconflow

4.2. 生成API密钥

登陆后在左侧边栏选“API密钥”,点右上角“新建API密钥”复制密钥到单独文本。

4.3. 在CherryStudio中配置siliconflow的 API密钥:

打开刚才安装的CherryStudio

点“设置”——中间“硅基流动”——左边“API密钥”——“检查”(API地址为自动填充)

对话框中选择deepseek-ai/DeepSeek-R1模型,选好后点击右上角“检查”

连接成功。记得打开右上角开关。

五、私域知识库搭建

5.1. 添加DeepSeek模型和Embedding模型

点击设置界面右边底部的“管理按钮”,在模型管理服务中查找模型,点击“全部”默认就能看到需要的模型;

这里我们可以有多种选择,图例上选择了“deepseek-ai/DeepSeek-R1-Distill-Llama-70B”点击右侧“+”变成“-”;

另外一个必须选择的模型是“BAAI/bge-m3”点击右侧“+”变成“-”;

选择BAAI/bge-m3后回到上一设置界面,点击后面设置图标检查 模型类型为“嵌入”

至此设置完毕。

5.2. 创建知识库

在 CherryStudio 工具栏,点击知识库图标;

点击“添加”,开始添加知识库;

输入知识库的名称,在嵌入模型中选择 BAAI/bge-m3模型,完成创建。

5.3. 添加知识库文件,支持文件、文件夹、网址和网站、笔记等,添加文件会自动向量化

5.4. 体验对话

选择界面左侧对话图框——选择界面上方图标选择模型——这里我们可以选择DeepSeek-R1模型,即可开展对话。

5.4. 使用本地知识库对话

对话框中选择知识库图标,选择相应知识库,可多选。

下图为基于本地知识库的对话,

六、本地知识库和联网功能共用的对话

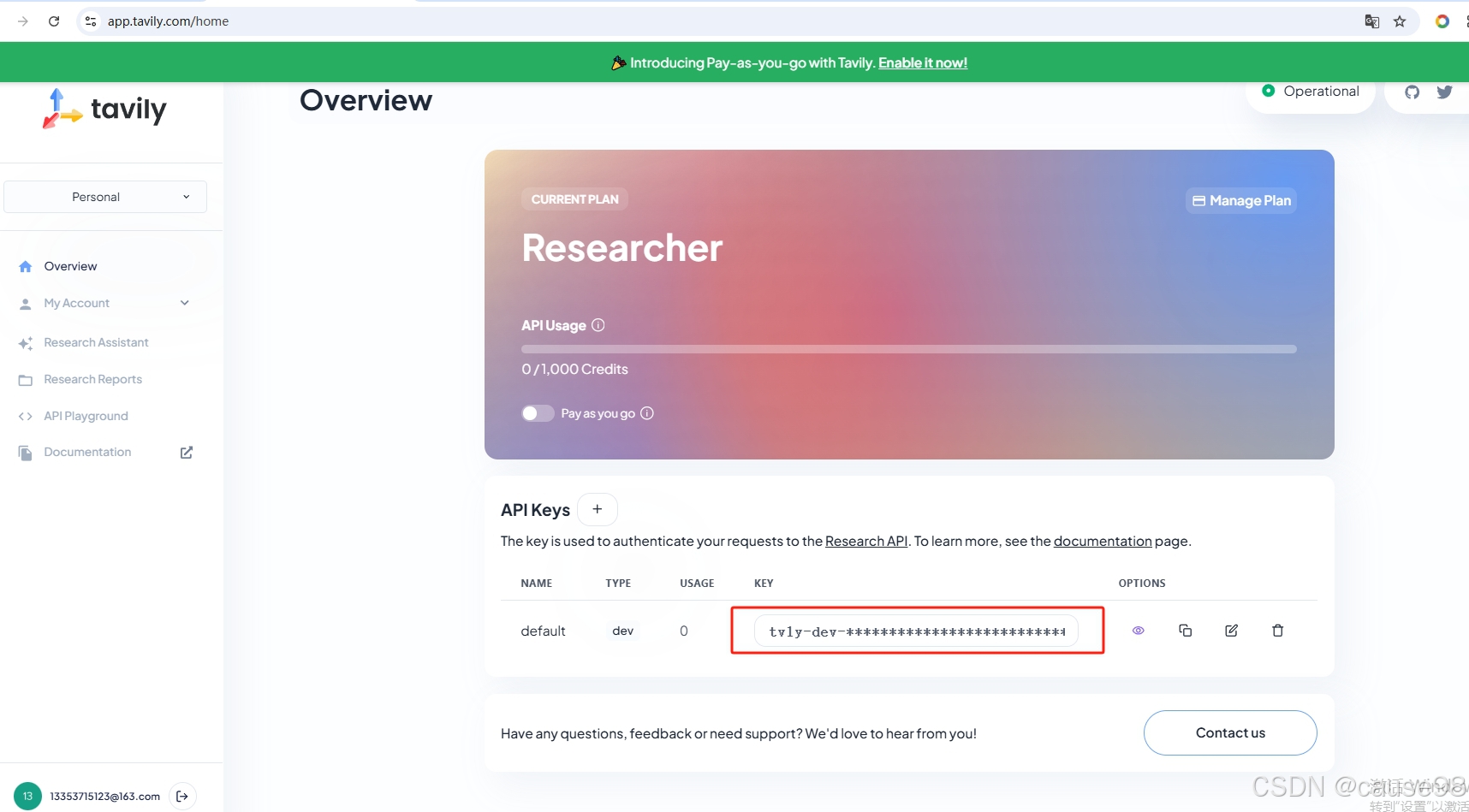

6.1 注册 Tavily 获取 API.

点击 sign up 注册,点击 log in 登录,

登录后首页 获取API Keys

6.2 CherryStudio界面打开联网支持,点击后软件会要求填入 tavily 的API Keys

或者在界面设置——网络搜索里填入tavily 的API Keys

设置完成,可体验本地知识库+联网对话。

七、应用其他各种智能体对话

硅基流动提供了多种预设过的智能体对话,界面选择智能体图标——智能体类型——具体的智能体。

添加到助手

对话中选择智能体——选择模型(也可用系统嵌入),即可开展对话。

2365

2365

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?