来源:学术头条

撰文:田小婷

前言

当前,关于“超人”人工智能(superhuman artificial intelligence)的讨论正变得愈发热烈。然而,或许只需要一点点“对抗性攻击”,那些可以轻松击败人类冠军的 AI 系统(如 AlphaGo、KataGo 等),便会变得不堪一击。

而且,这种脆弱性不仅限于围棋 AI,也可能扩展到 ChatGPT 等聊天机器人背后的大语言模型。更关键的是,这一问题很难消除。

日前,来自 FAR AI 和麻省理工学院(MIT)的研究团队在一项研究中揭示了 AI 本身的这一脆弱性。他们表示,想要构建始终优于人类智能水平的、鲁棒性很强的 AI 系统,可能比我们想象得要更加困难。

相关研究论文以 “Can Go AIs be adversarially robust?” 为题,已发表在预印本网站 arXiv 上,尚未经过同行评审。

伊利诺伊大学计算机科学家 Huan Zhang 指出:“这篇论文为如何实现建立人们可以信任的、强大的真实世界 AI 智能体这一宏伟目标打了一个大大的问号。”

MIT 计算机科学家 Stephen Casper 也表示:“这项研究提供了一些迄今为止最有力的证据,证明让高级 AI 模型按照预期方式鲁棒地运行是很困难的。”

AI “围棋冠军”不堪一击

棋类游戏一直以来都是人类智力的重要考验,近年来也被作为 AI 系统智能化水平的“试金石”。在围棋中,两名玩家轮流将黑白棋子放在网格上,包围和吃掉对方的棋子。

此前,围棋 AI 系统 KataGo 因击败顶级人类棋手的能力而广受瞩目,随着人们对 AI 是否能真正超越人类智能的不断质疑,KataGo 也成为人类和一些 AI 系统不断挑战的对象。

早在 2022 年,研究团队便通过训练对抗性 AI 机器人,发现尽管这些机器人总体上不是优秀的围棋选手,但它们能够找到并利用 KataGo 的特定弱点,经常性地击败 KataGo。此外,人类也可以理解机器人的这些伎俩,并用来击败 KataGo。

这究竟是一次偶然,还是这项研究成果揭示了 KataGo 的根本弱点,进而揭示了其他看似具有超人能力的 AI 系统的根本弱点?

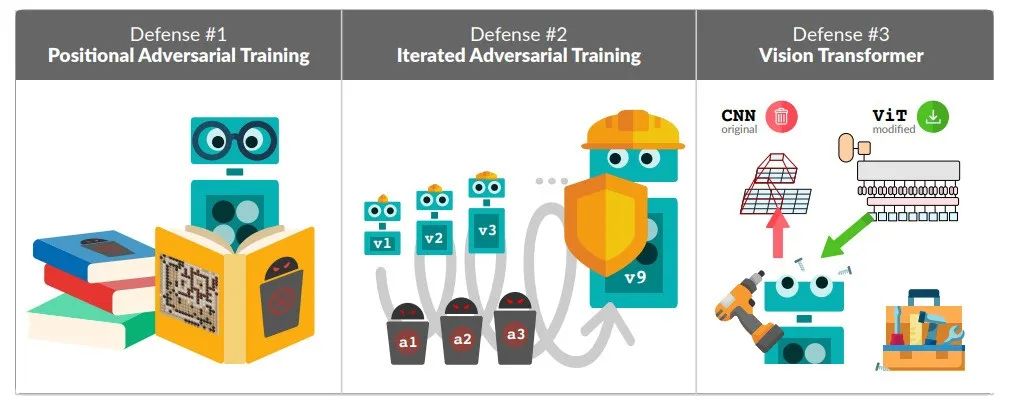

为了验证这一猜想研究,他们使用对抗机器人测试了围棋 AI 遭受此类攻击的三种防御方法——位置对抗性训练、迭代对抗性训练以及更改网络架构,这些方法分别针对 KataGo 的已知漏洞进行了不同层面的改进与防御。

图|围棋对抗性攻击的三种防御策略,左图:位置对抗性训练;中间:迭代对抗性训练;右图:用视觉 Transformer(ViT)替代卷积神经网络的训练(来源:论文)

第一种防御方法是 KataGo 开发人员在 2022 年攻击事件后已经部署的方法,与 KataGo 自学围棋的方法类似,他们给 KataGo 提供攻击所涉及的棋盘位置示例,让它自己下棋,来学习如何应对这些位置。他们发现,即使是这种升级版的 KataGo,对抗型机器人也能学会击败它,胜率高达 91%。

他们尝试的第二个防御策略是迭代对抗性训练,该方法模拟了一个持续的 “军备竞赛”,在对抗性训练中不断引入新的攻击和防御策略。针对对抗机器人训练一个版本的 KataGo,然后对更新后的 KataGo 训练攻击者,如此反复九次。尽管这种方法在一定程度上提升了 KataGo 的防御能力,但仍未能完全解决适应性攻击的问题,对手不断发现新的漏洞,最后一个升级的对抗性机器人在 81% 的情况下击败了 KataGo。

研究表明,这些防御方法均未能起到有效作用,对抗性机器人依然能够找到 KataGo 的漏洞,并击败它们。具体来说,位置对抗性训练的 KataGo 在面对一种 “送二收一” 的策略时表现不佳,而迭代对抗性训练的 KataGo 则容易受到 “打吃” 攻击。

考虑到 KataGo 是基于卷积神经网络(CNN)设计的计算模型,研究人员怀疑,卷积神经网络可能过于关注局部细节,而忽略了全局路径。于是,在第三种防御策略中,他们使用视觉 Transformer(ViT)替代卷积神经网络,从零开始训练了一个新的围棋 AI,在一定程度上改变了 AI 的学习模式,但仍无法完全消除循环攻击的脆弱性,在 78% 的情况下还是被击败了。

对此,最早开发出 KataGo 的纽约计算机科学家 David Wu 指出:“强大的围棋 AI 在平均表现上是超人类的,但在最糟糕的情况下并非如此。”

实现“超人”人工智能?没那么简单

这项研究揭示了顶级围棋 AI 系统在对抗性策略下的脆弱性,对整个 AI 领域的安全性和可靠性提出了新的挑战。尽管 KataGo 在平均表现上优于人类,但从它在最坏情况下表现出的缺陷可以看出,构建真正稳定的 AI 系统依然任重道远。

研究人员通过三种针对围棋对抗性攻击的防御方法增加了 KataGo 的攻击难度,然而这些措施并未完全实现防御攻击,总能被以远少于训练对抗性 AI 所需的计算量成功攻击,这些防御措施的稳定性也没有达到人类的水平。

尽管如此,研究人员发现应对固定攻击的计算量较低,说明通过对大量攻击训练,围棋 AI 系统或许可以实现完全防御。

为实现这一目标,研究团队提出了两条互补方法:一是通过开发新的攻击算法来扩大攻击语料库,降低训练攻击方所需的计算量;二是通过提高对抗训练的样本效率,使被攻击方能够从有限的对抗策略中进行泛化。

此外,除了对抗训练之外,还有其他可以提高 AI 系统稳定性的方法,例如多智能体强化学习方案可能自动发现和消除循环攻击策略,或者通过改变威胁模型使用在线或有状态防御,动态更新模型。

研究结果表明,人类在构建稳定的 AI 系统方面仍然存在重大障碍,如果在围棋 AI 这一明确且封闭的领域无法实现鲁棒性,那么在更开放的现实世界应用中实现这一目标将更加困难。为了安全构建 AI 系统,未来的先进系统必须在设计之初就具备内在的鲁棒性。

这项研究不仅在围棋 AI 领域具有重要意义,也对其他“超人”人工智能应用领域提出了系统性研究的建议,尽管防御措施可以在一定程度上提高 AI 系统的鲁棒性,但要完全消除对抗性攻击的威胁仍然非常困难。

参考资料:

https://www.nature.com/articles/d41586-024-02218-7

https://arxiv.org/abs/2406.12843

https://goattack.far.ai/

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)大脑研究计划,构建互联网(城市)大脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。每日推荐范围未来科技发展趋势的学习型文章。目前线上平台已收藏上千篇精华前沿科技文章和报告。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”

543

543

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?