膨胀卷积论文笔记

原文地址:Understanding Convolution for Semantic Segmentation

Abstract

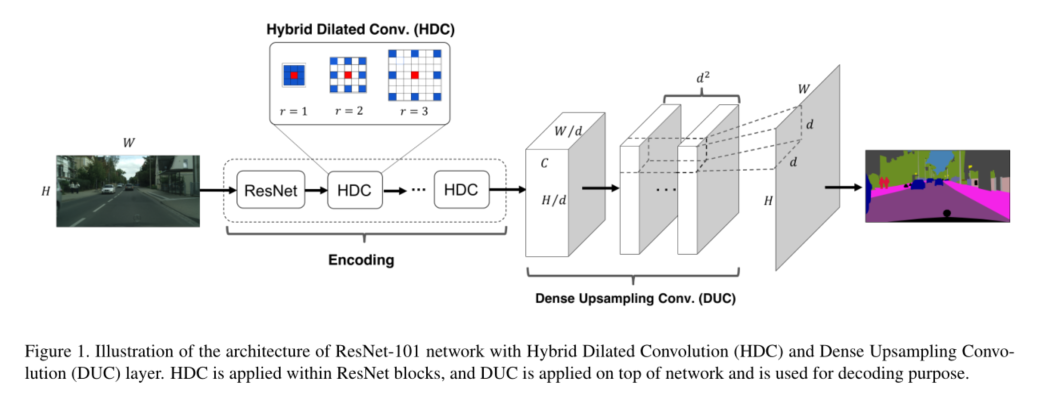

深度学习的最新进展,尤其是深度卷积神经网络(CNN),已经导致了语义分割系统的显著改进。在这里,我们展示了如何通过操作卷积相关操作来改进像素级语义分割,这些操作具有理论和实用价值。首先,我们设计了密集上采样卷积(DUC)来生成像素级预测,它能够捕获和解码双线性上采样中通常缺失的更详细信息。其次,我们在编码阶段提出了一种混合膨胀卷积(HDC)框架。该框架1)有效地扩大了网络的感受野(RF),以聚集全球信息;2) 缓解了我们所说的标准扩大卷积运算造成的**“网格问题”**。我们在Cityscapes数据集上彻底评估了我们的方法,并在提交时在测试集中取得了80.1%mIOU的最新结果。我们还实现了基蒂道路评估基准和PASCAL VOC2012分段任务的总体技术水平。我们的源代码可以在 https://github.com/TuSimple/TuSimple-DUC

1. Introduction

语义分割的目的是为图像中的每个像素指定一个分类标签,这在图像理解和自动驾驶系统中起着重要作用。深度卷积神经网络(CNN)模型[17,26,13]最近的成功使像素语义分割任务取得了显著进展,这得益于丰富的层次特征和端到端的可训练框架[21,31,29,20,18,3]。大多数最先进的语义切分系统有三个关键组成部分:1)一个全卷积神经网络(FCN),首先在[21]中介绍,将最后几个完全连接的层按卷积层重新放置,以进行有效的端到端学习和推理,可以接受任意大小的输入(这种方法是在VGG中首次提出);2) 条件随机场(CRF),用于捕获图像中的局部和长期相关性,以优化预测图;3) 膨胀卷积(或空洞卷积),用于提高中间特征映射的分辨率,以便在保持相同计算成本的同时生成更准确的预测。

注:条件随机场(Conditional Random Fields, 以下简称CRF)是给定一组输入序列条件下另一组输出序列的条件概率分布模型,在自然语言处理中得到了广泛应用。

自[21]引入FCN以来,对全监督语义切分系统的改进通常集中在两个方面:第一,应用更深层次的FCN模型。当16层VGG-16模型[26]被101层ResNet-101[13]模型[3]取代时,PASCAL VOC2012数据集[8]上的平均交叉过度联合(mIoU)分数显著增加;使用152层ResNet-152模型可以进一步改进[28]。这种趋势与这些模型在ILSVRC[23]对象分类任务中的性能一致,因为更深层次的网络通常可以对更复杂的表示进行建模,并学习更具辨别力的特征,从而更好地区分类别。第二,让CRF更强大。这包括应用完全连接的成对CRF[16]作为后处理步骤[3],通过近似其平均场推断步骤[31,20,18]将CRF集成到网络中,以实现端到端训练,并将附加信息纳入CRF中,如边缘[15]和对象检测[1]。

我们正在从另一个角度进一步改进语义分割:解码(从中间特征映射到输出标签映射)和编码(从输入图像到特征映射)的卷积运算。在解码中,大多数最先进的语义分段系统只是使用双线性上采样(在CRF阶段之前)来获得输出标签映射[18,20,3]。双线性上采样是不可学习的,可能会丢失细节。受图像超分辨率研究[25]的启发,我们提出了一种称为稠密上采样卷积法的方法 dense upsampling convolution(DUC),该方法非常容易实现,可以达到像素级精度:而不是试图立即恢复全分辨率标签图,我们学习了一系列放大滤波器,将缩小后的特征映射放大到所需大小的最终密集特征映射。DUC通过支持端到端的训练自然符合FCN框架,并且它显著增加了城市景观数据集[5]上像素级语义分割的mIOU,尤其是在相对较小的对象上。

对于编码部分,膨胀卷积最近变得很流行[3,29,28,32],因为它通过在卷积核中插入“孔”来保持网络的分辨率和接收场,从而消除了降采样的需要(通过最大池或步进卷积)。然而,当前的膨胀卷积框架存在一个固有的问题,我们将其称为**“网格化”(棋盘效应):由于卷积核中的两个像素之间填充了零,该核的感受野仅覆盖棋盘格图案的区域——仅对非零值的位置进行采样,从而丢失一些相邻信息。当扩张率增加时,问题会变得更糟,通常在感受野较大的更高层:卷积核太稀疏,无法覆盖任何局部信息,因为非零值相距太远。构成固定像素的信息总是来自其预定义的网格模式,因此会丢失大量信息。在这里,我们提出了一个简单的hybrid dilation convolution**(HDC)框架,作为解决这个问题的第一次尝试:我们没有对相同的空间分辨率使用相同的膨胀率,而是使用一系列的膨胀率,并以与ResNet-101中的“块”相同的方式串行连接它们[13]。我们表明,HDC有助于网络缓解网格问题。此外,选择合适的rates可以有效地增加感受野的大小,并提高相对较大物体的精确度。

我们设计了DUC和HDC,使卷积运算更好地满足像素级语义分割的需要。技术细节见下文第3节。结合条件随机场(CRF)的后处理,我们证明了该方法在城市景观像素级语义标记任务、KITTI道路估计基准和PASCAL VOC2012分割任务上达到了最先进的性能。

2. Related Work

Decoding of Feature Representation:

在像素语义分割任务中,输出标签映射与输入图像的大小相同。由于CNN中的最大池运算或跨步卷积运算,网络最后几层的特征图的大小不可避免地会减少采样。已经提出了多种方法来解码从下采样feature map到feature map的精确信息。通常使用双线性插值[18,20,3],因为它速度快且记忆效率高。另一种流行的方法称为反卷积(转置卷积),在这种方法中,使用池化步骤中存储的池化开关进行解耦操作,以恢复特征可视化所需的信息[30]。在[21]中,解码阶段添加了一个反卷积层,以使用中间层的叠加特征图生成预测结果。在[7]中,多个反卷积层用于从多个属性生成椅子、桌子或汽车(多尺度)。Noh等人[22]利用反卷积层作为卷积层的镜像版本(编码-解码结构对称),在“反池化”步骤中使用存储的池位置。[22]表明,粗到细的目标结构,对于恢复精细的详细信息至关重要,可以沿着反卷积层的传播重建。Fischer等人[9]使用了类似的镜像结构,但结合了来自多个反卷积层的信息,并进行了上采样以进行最终预测。

Dilated Convolution:

膨胀卷积(或空洞卷积)最初是在**小波分解算法[**14]中发展起来的。膨胀卷积的主要思想是在卷积核的像素之间插入“孔”(零),以提高图像分辨率,从而实现深层CNN中的密集特征提取。在语义切分框架中,膨胀卷积也被用来扩大卷积核的范围。Yu&Koltun[29]使用膨胀率不断增加的序列化层来实现上下文聚合,而[3]设计了一个“Atrus spatial pyramid pooling(ASPP)”方案,通过并行放置多个膨胀的卷积层来捕获多尺度对象和上下文信息。最近,膨胀卷积被应用于更广泛的任务,如目标检测[6]、光流[24]和音频生成[27]。

3. Our Approach

3.1. Dense Upsampling Convolution (DUC)

实现该部分操作的代码如下:

# Base Network

res = get_resnet_hdc(bn_use_global_stats=bn_use_global_stats)

# ASPP

aspp_list = list()

for i in range(aspp_num):

pad = ((i + 1) * aspp_stride, (i + 1) * aspp_stride)

dilate = pad

conv_aspp=mx.symbol.Convolution(data=res, num_filter=cell_cap * label_num, kernel=(3, 3), pad=pad,

dilate=dilate, name=('fc1_%s_c%d' % (exp, i)), workspace=8192)

aspp_list.append(conv_aspp)

# 这是是ASPP模块输出作像素和

summ = mx.symbol.ElementWiseSum(*aspp_list, name=('fc1_%s' % exp))

# Reshape操作

cls_score_reshape = mx.symbol.Reshape(data=summ, shape=(0, label_num, -1), name='cls_score_reshape')

# Reshape完后直接送到Softmax

cls = mx.symbol.SoftmaxOutput(data=cls_score_reshape, multi_output=True,

normalization='valid', use_ignore=True, ignore_label=ignore_label, name='seg_loss')

return cls

可以看到reshape操作传入的是shape=( 0 , label_num,−1 ) (0, label_num, -1)(0,label_num,−1) MXNet中0代表保持不变,-1表示推断~.

ASPP出来的数据形式为(N,channel,h,w)经过reshape甩成了(N,label_num,-1),即把每类的分类结果拍成向量形式。

原文链接:https://blog.csdn.net/u011974639/article/details/79460893

假设输入图像具有高度H、宽度W和颜色通道C,像素级语义分割的目标是生成一个大小为H×W的标签映射,其中每个像素用一个类别标签进行标记。将图像输入深度FCN后,在进行预测之前,在最后一层获得尺寸为h×w×c的特征图,其中h=H/d,w=W/d,d为下采样因子。DUC不是执行双线性上采样(这是不可学习的),也不是使用反褶积网络(如[22]中所述),在卷积运算之前,必须在“反池化”步骤中填充零,而是直接在特征映射上应用卷积运算,以获得密集像素级预测映射。图1描述了我们的网络的架构和DUC层。

DUC操作都是关于卷积的,这是在维度 h × w × c h×w×c h×w×c的ResNet的特征图上执行,以获得维度 h × w × ( d 2 × L ) h×w×(d^2×L) h×w×(d2×L)的输出特征图(这里是使用 d 2 × L d^2 \times L d2×L 个3x3卷积核扫描得到 d 2 × L d^2 \times L d2×L 个feature map),其中L是语义分割任务中的类总数。因此,密集卷积的每一层都在学习每个像素的预测。然后,使用softmax层将输出特征映射重塑为 H × W × L H×W×L H×W×L,并应用像素级argmax操作符来获得最终的标签映射。在实践中,可能不需要“重塑”操作,因为feature map可以直接映射为要输入softmax层的向量。DUC的关键思想是将整个feature map划分为相等的** d 2 d^2 d2子部分,这些子部分的高度和宽度与引入的feature map相同。也就是说,我们将整个标签映射转换为具有多个通道的较小标签映射。这种转换允许我们直接在输入特征映射和输出标签映射**之间应用卷积运算,而无需在反卷积网络中插入额外的值(“取消池化”操作)。

由于DUC是可学习的,因此它能够捕获和恢复双线性插值操作中通常缺失的精细详细信息。例如,如果网络的下采样率为1/16,而对象的长度或宽度小于16像素(例如极或远处的人),则双线性上采样很可能无法恢复该对象。同时,必须对相应的训练标签进行降采样,以与输出维度相对应,这将导致详细信息的丢失。另一方面,在原始分辨率下执行DUC的预测,从而实现像素级解码。此外,DUC操作可以自然地集成到FCN框架中,并使整个编码和解码过程端到端可训练。

3.2. Hybrid Dilated Convolution (HDC)

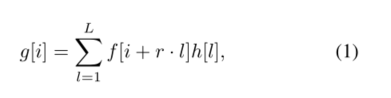

在一维中,扩张卷积定义为:

其中f[i]是输入信号,g[i]是输出信号,h[l]表示长度为l的滤波器,r对应于我们用来采样f[i]的膨胀率。在标准卷积中,r=1。

在语义分割系统中,二维扩展卷积是通过在卷积核的每个像素之间插入“孔”(零)来构造的。对于大小为k×k的卷积核,得到的扩张滤波器的大小为$k_{d} × × ×k_{d} , 其 中 ,其中 ,其中k_{d} $=k+(k−1) ·(r−1). 扩张卷积用于通过替换最大池运算或跨步卷积层来保持FCN中特征图的高分辨率,同时保持相应层的感受野(或[3]中的“视野”)。例如,如果ResNet-101中的卷积层的步长s=2,则该步长重置为1以消除下采样,并且对于后续层的所有卷积核,膨胀率r设置为2。该过程迭代地应用于所有具有下采样操作的层,因此输出层中的特征映射可以保持与输入层相同的分辨率。然而,在实践中,扩展卷积通常应用于已经降采样的特征图,以实现合理的效率/精度权衡[3]。

然而,在上述扩展卷积框架中存在一个理论问题,我们称之为“网格化”(图2):对于扩展卷积层l中的像素p,对像素p有贡献的信息来自层l中附近的$k_{d} × × ×k_{d} 区 域 − 1 以 p 为 中 心 。 由 于 扩 展 卷 积 在 卷 积 核 中 引 入 了 零 , 因 此 参 与 计 算 的 实 际 像 素 区域− 1以p为中心。由于扩展卷积在卷积核中引入了零,因此参与计算的实际像素 区域−1以p为中心。由于扩展卷积在卷积核中引入了零,因此参与计算的实际像素k_{d} × × ×k_{d} 区 域 的 计 算 结 果 仅 为 k × k , 间 隙 为 r − 1. 他 们 之 间 。 如 果 k = 3 , r = 2 , 则 该 区 域 25 个 像 素 中 只 有 9 个 用 于 计 算 ( 图 2 ( a ) ) 。 由 于 所 有 层 都 具 有 相 等 的 扩 张 率 r , 那 么 对 于 顶 部 扩 张 卷 积 层 区域的计算结果仅为k×k,间隙为r− 1.他们之间。如果k=3,r=2,则该区域25个像素中只有9个用于计算(图2(a))。由于所有层都具有相等的扩张率r,那么对于顶部扩张卷积层 区域的计算结果仅为k×k,间隙为r−1.他们之间。如果k=3,r=2,则该区域25个像素中只有9个用于计算(图2(a))。由于所有层都具有相等的扩张率r,那么对于顶部扩张卷积层l_{top} 中 的 像 素 p , 有 助 于 计 算 p 值 的 最 大 可 能 位 置 数 为 中的像素p,有助于计算p值的最大可能位置数为 中的像素p,有助于计算p值的最大可能位置数为(w{'}×h{‘})/r2$,其中$w{’},h^{'}$分别是底部扩张卷积层的宽度和高度。因此,像素p只能以棋盘格式查看信息,并且丢失了大部分信息(当r=2时至少75%)。当r由于额外的下采样操作而在更高层变大时,来自输入的样本可能非常稀疏,这可能不利于学习,因为1)局部信息完全缺失;2) 这些信息在大范围内可能是无关的。网格效应的另一个结果是,l层附近r×r区域中的像素从完全不同的“网格”集合接收信息,这可能会损害局部信息的一致性。 (棋盘效应的原因和影响因素)

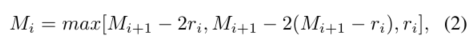

在这里,我们提出了一个简单的解决方案-混合扩张卷积(HDC),以解决这个理论问题。假设我们有N个核大小为K×K的卷积层,其膨胀率为[ r 1 , . . . , r 2 , . . . , r n r_{1},...,r_{2},...,r_{n} r1,...,r2,...,rn],HDC的目标是让一系列卷积运算的RF的最终大小完全覆盖一个正方形区域,没有任何孔或缺失边。我们将“两个非零值之间的最大距离”定义为 :

M n = r n M_n=r_n Mn=rn。设计目标是让$M_2≤k 例 如 , 对 于 内 核 大 小 K = 3 , r = [ 1 , 2 , 5 ] 模 式 的 作 用 相 当 于 例如,对于内核大小K=3,r=[1,2,5]模式的作用相当于 例如,对于内核大小K=3,r=[1,2,5]模式的作用相当于M_2=2 ; 然 而 , r = [ 1 , 2 , 9 ] 模 式 并 不 适 用 于 ;然而,r=[1,2,9]模式并不适用于 ;然而,r=[1,2,9]模式并不适用于M_2=5$。实际上,我们没有在下采样发生后对所有层使用相同的膨胀率,而是对每一层使用不同的膨胀率。在我们的网络中,扩张率的分配遵循锯齿波式的启发:许多层被组合在一起,形成扩张率不断增加的波的“上升沿”,下一组重复相同的模式。例如,对于扩张率r=2的所有层,我们将3个后续层作为一个组,并将其扩张率分别更改为1、2和3。通过这样做,顶层可以在与原始配置相同的区域(图2(b))中从更大范围的像素访问信息。这一过程在所有层中重复,从而使顶层的感受野保持不变。

4. Experiments and Results

我们报告了我们在三个具有挑战性的语义分割数据集上的实验和结果:城市景观[5]、用于道路估计的KITTI数据集[10]和PASCAL VOC2012[8]。我们使用在ImageNet数据集上预训练过的ResNet-101或ResNet-152网络作为所有模型的起点。输出层包含根据数据集(包括背景,如果适用)分类的语义类别的数量。我们使用类别上每个像素的交叉熵误差。然后在输出地图的所有像素位置上求和,我们使用标准随机梯度下降(SGD)优化该目标函数。我们使用MXNet[4]在NVIDIA TITAN X GPU上培训和评估我们的所有模型。

4.1. Cityscapes Dataset

Cityscapes数据集是一个大型数据集,主要关注城市街道场景的语义理解。该数据集包含5000幅图像,其中包含50个城市、不同季节、不同场景布局和背景的精细注释。数据集标注了30个类别,其中19个类别用于培训和评估(其他类别被忽略)。训练、验证和测试集分别包含2975、500和1525张精细图像。另外还提供了20000张带有粗略(多边形)注释的图像,但仅用于培训

4.1.1 Baseline Model

我们使用DeepLab-V2[3]ResNet-101框架来训练我们的基线模型。具体地说,该网络的下采样率为8,并且对res4b和res5b块分别应用速率为2和4的扩展卷积。在网络顶部添加了一个扩展率为6、12、18和24的ASPP模块,以提取多尺度上下文信息。与原始图像的大小相比,预测图和训练标签的下采样系数为8,并使用双线性上采样来获得最终预测。由于Cityscapes数据集中的图像大小为1024×2048,这太大,无法放入GPU内存中,因此我们将每个图像划分为12个800×800块,部分重叠,从而将训练集增加到35700个图像。这种数据增强策略是为了确保可以访问图像中的所有区域。这是对随机种植的一种改进,在随机种植中,附近的地区可能会被反复访问。

我们使用小块大小为544×544(从800×800小块中随机裁剪)且批量大小为12的小批量SGD,使用多个GPU来训练网络。初始学习速率设置为 2.5 × 1 0 − 4 2.5×10^{−4} 2.5×10−4,并应用power=0.9的“poly”学习率(如[3])。重量衰减设置为 5 × 1 0 − 4 5×10^{−4} 5×10−4动量为0.9。该网络经过20个时代的培训,在验证集上实现了72.3%的mIoU。

4.1.2 Dense Upsampling Convolution (DUC)

我们检查了DUC对基线网络的影响。在DUC中,我们唯一要改变的是顶部卷积层的形状。例如,如果在基线模型中,顶层卷积层的维数是68×68×19(19是类数),那么对于具有DUC的网络,同一层的维数将是68×68×( r 2 r^2 r2×19),其中r是网络的总下采样率(在这种情况下,r=8)。然后将预测图重塑为544×544×19的大小。与基线模型相比,DUC将引入额外的参数,但仅限于最顶层的卷积层。我们以与基线模型相同的方式对20个时期的ResNet DUC网络进行训练,并在验证集上实现了74.3%的平均IOU,与基线模型相比增加了2%。ResNet DUC结果的可视化以及与基线模型的比较如图3所示

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-nNiDTafQ-1650612425101)(D:/Typora_img/image-20220422142104387.png)]

从图3中,我们可以清楚地看到,DUC对于识别小物体非常有帮助,例如杆子、交通灯和交通标志。与我们的直觉一致,像素级密集上采样可以恢复双线性插值通常忽略的详细信息。

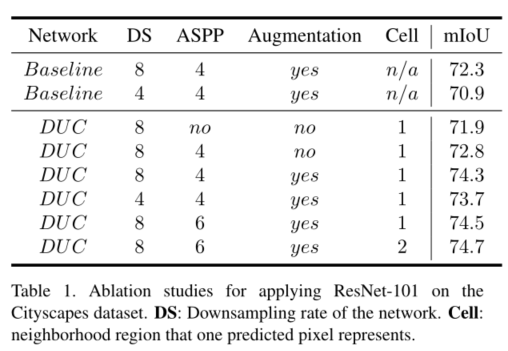

Ablation Studies

我们研究了网络的不同设置对性能的影响。具体来说,我们检查:1)网络的下采样率,它控制中间特征图的分辨率;2) 是否应用ASPP模块,以及模块中的并行路径数;3) 是否进行12倍的数据扩充;4)cell大小,它决定了一个预测像素投影到的邻域区域(cell × cell))的大小。像素级DUC应使用cell=1;然而,由于ground-truth 标签通常无法达到像素级精度,我们也尝试在实验中使用cell=2。从表1可以看出,减小下采样率会降低精度。此外,由于特征图的分辨率不断提高,这也显著提高了计算成本。ASPP通常有助于提高性能,将ASPP通道从4个增加到6个(扩张率从6个增加到36个,间隔6个)会产生**0.2%的提升。数据扩充有助于实现另外1.5%**的改进。与cell=1相比,使用cell=2可以产生稍好的性能,并且通过将最后一个卷积层的通道减少4倍,有助于降低计算成本。

Bigger Patch Size

由于设置cell=2可以降低用于网络训练的GPU内存成本,因此我们探讨了补丁大小对性能的影响。我们的假设是,由于原始图像都是1024×2048,因此应该使用尽可能大的补丁对网络进行训练,以便聚集可能有助于学习的局部细节和全局上下文信息。因此,我们将补丁大小设置为880×880,并将训练中使用的4个GPU中的每个GPU的批量大小设置为1。由于补丁大小超过了之前12倍数据增强框架中的最大尺寸(800×800),我们采用了一种新的7倍数据增强策略:在原始图像中设置七个中心位置,其中x=512,y={256,512,…,1792};对于每个中心位置,通过在以每个中心为中心的160×160矩形区域内随机设置其中心,获得880×880面片。此策略确保我们可以对图像中的所有区域(包括边缘)进行采样。使用更大补丁大小的训练可以将性能提升到75.7%,比之前的最佳值提高1%结果

Compared with Deconvolution(对比常规的反卷积方法效果)

我们将我们的DUC模型与反卷积进行比较,反卷积还包括学习上采样。特别是,我们比较了

1)从预测图(8)到原始分辨率的直接反褶积;

2) 先使用2的上采样因子,然后使用d为4的上采样因子进行反卷积。

我们设计的deconv网络的参数数量与DUC大致相同。我们使用ResNet-DUC-biger-patch模型来训练网络。上述两种模型实现的mIOU分别为75.1%和75.0%,低于ResNet-DUC模型(75.7%mIOU)。

Conditional Random Fields (CRFs)(添加CRF优化)

作为FCN的后处理步骤,全连接的CRF[16]被广泛用于提高语义分割质量[3]。我们遵循[3]中所示的CRF的形成过程。我们对验证集上的参数进行网格搜索,并对所有模型使用 σ α = 15 、 σ β = 3 、 σ γ = 1 、 w 1 = 3 和 w 2 = 3 σ_α=15、σ_β=3、σ_γ=1、w_1=3和w_2=3 σα=15、σβ=3、σγ=1、w1=3和w2=3。将CRF应用到我们最好的ResNet DUC模型中,产生了76.7%的mIoU,比不使用CRF的模型提高了1%。

4.1.3 Hybrid Dilated Convolution (HDC)

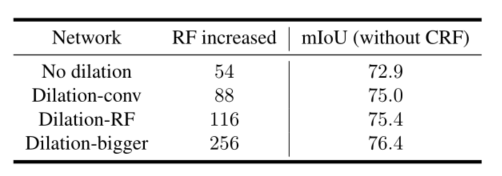

我们使用最好的101层ResNet DUC模型作为应用HDC的起点。具体来说,我们对HDC模块的几种变体进行了实验:

1)无膨胀:对于所有包含膨胀的ResNet块,我们使其膨胀率r=1(无膨胀)。

2)常规膨胀卷积:对于所有包含Digilation的块,我们将每2个块分组在一起,第一个块的r=2,第二个块的r=1。

3)膨胀率RF:对于包含23个膨胀率r=2的块的res4b模块,我们将每3个块分组,并将它们的膨胀率分别更改为1、2和3。在最后两个分组,我们保持r=2。对于包含3个膨胀率r=4的块的res5b模块,我们将它们分别更改为3、4和5。

4)最大网络膨胀卷积:对于res4b模块,我们将每4个块分组,并将它们的放大率分别更改为1、2、5和9。最后3个分组的rate分别为1、2和5。对于res5b模块,我们将膨胀率设置为5、9和17。

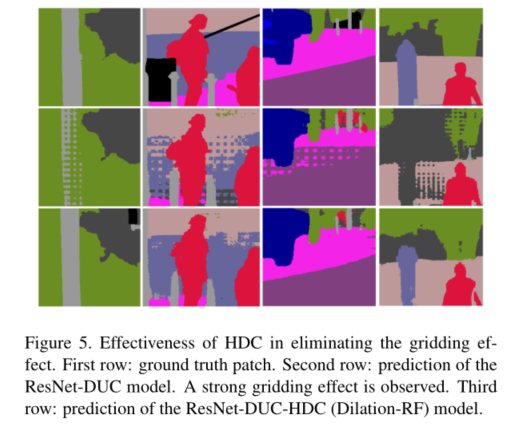

结果总结在表2中。我们可以看到,增加感受野的大小通常会产生更高的准确性。图5说明了ResNetDUC HDC模型在消除网格效应方面的有效性。可视化结果如图4所示。我们可以看到,我们最好的ResNet-DUC-HDC模型在相对较大的对象上表现得特别好。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-5KSzTBfU-1650612425102)(D:/Typora_img/image-20220422144201506.png)]

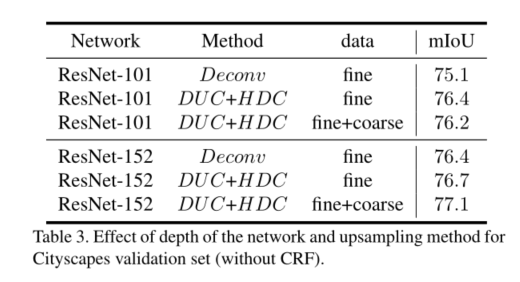

Deeper Networks

我们还尝试将基于ResNet-101的模型替换为ResNet-152网络,该网络比ResNet-101更深,在ILSVRC图像分类任务中获得更好的性能[13]。 由于网络的差异,我们首先训练ResNet-152网络学习10个时代的所有批处理规范化(BN)层中的参数,并通过为另外20个时代固定这些BN参数来继续微调网络。结果汇总在表3中。我们可以看到,使用更深层次的ResNet-152模型通常比ResNet-101模型产生更好的性能。

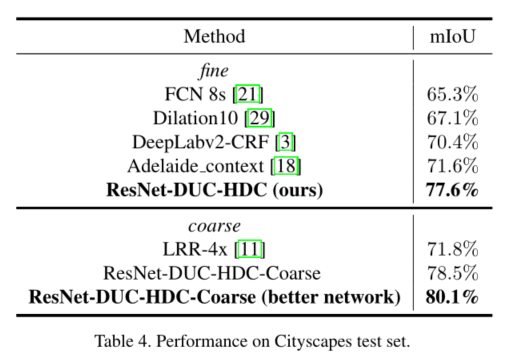

4.1.4 Test Set Results

表4总结了我们在城市景观测试集上的结果。对于仅使用精细标签训练的模型,以及使用精细和粗略标签组合训练的模型,有单独的条目。我们的ResNet DUC HDC模型仅使用精细数据即可实现77.6%的mIoU。添加粗略数据有助于我们实现78.5%的mIoU。

此外,受VGG网络设计[26]的启发,由于单个5×5卷积层可分解为两个相邻的3×3卷积层,以增加网络的表现力,同时保持感受野大小,因此我们将原始ResNet-101网络中的7×7卷积层替换为三个3×3卷积层。通过重新训练更新后的网络,我们使用单一模型在测试集上实现了80.1%的mIoU,无需CRF后处理。我们的结果在提交时在Cityscapes数据集上实现了最先进的性能。与Chen等人[3]的强基线相比,我们显著提高了mIoU(9.7%),这证明了我们方法的有效性。

4.2. KITTI Road Segmentation

Dataset

KITTI道路分割任务包含三种不同类型道路场景的图像,包括289张训练图像和290张测试图像。目标是确定图像中的每个像素是否为道路。由于训练图像的数量有限,使用基于神经网络的方法很有挑战性。为了避免过度拟合,我们从训练图像中以100像素的步幅裁剪320×320像素的补丁,并在训练期间使用从ImageNet预训练的ResNet101 DUC模型。其他训练设置与城市景观实验相同。我们没有将CRF应用于后处理。

Results

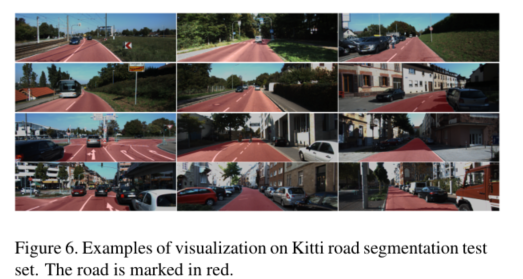

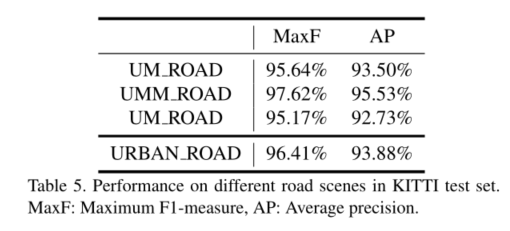

我们在提交时实现了最先进的结果,无需使用任何有关立体声、激光点和GPS的附加信息。具体而言,我们的模型在所有子类别的城市未标记(UU道路)、城市多标记(UMM道路)和整体类别城市道路的子类别中达到了最高的F1测量值,在提交本文时,在所有三个子类别和整体类别中达到了最高的平均精度。可视化结果的示例如图6所示。详细结果如表5-1所示。

4.3. PASCAL VOC2012 dataset

Dataset

PASCAL VOC2012分割基准包含1464个训练图像、1449个验证图像和1456个测试图像。使用[12]提供的额外注释,训练集被扩充为10582图像。该数据集有20个前景对象类别和1个带有像素级注释的背景类。

Results

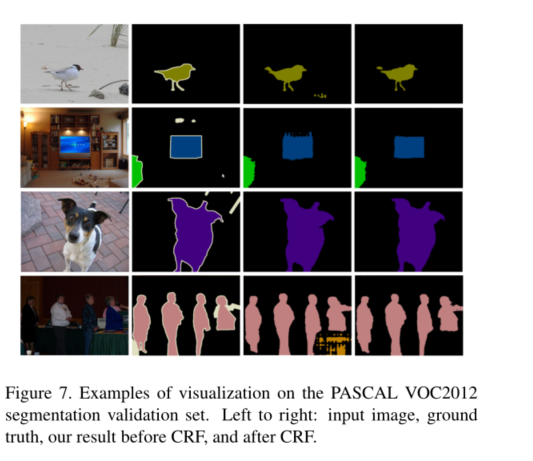

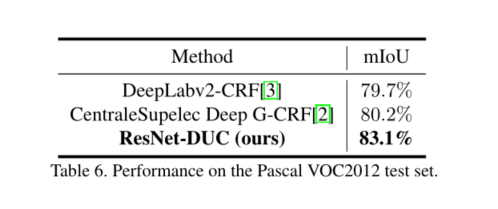

我们首先使用增强VOC2012训练集和MS-COCO数据集[19]的组合对我们的152层ResNet DUC模型进行预训练,然后使用增强VOC2012训练集对预训练网络进行微调。在整个训练过程中,我们使用大小为512×512(零填充)的补丁。所有其他训练策略与城市景观实验相同。我们使用单个模型在测试集上实现了83.1%的mIOU,无需任何模型集成或多尺度测试,这是提交时性能最好的方法。详细结果如表6所示,可视化结果如图7所示。

5. Conclusion

我们提出了简单而有效的卷积运算来改进语义分割系统。我们设计了一种新的dense upsampling convolution(DUC)运算来实现特征图上的像素级预测,并设计了dense upsampling convolution(HDC)来解决网格问题,有效地扩大了网络的感受野。实验结果证明了该框架在各种语义分割任务中的有效性。

参考:https://www.cnblogs.com/ansang/p/9003513.html

https://blog.csdn.net/u011974639/article/details/79460893

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?