大模型微调技术在短时间内迅速发展,迎来了爆火,各种微调包括LoRA的多个版本迭代、增量学习、蒸馏技术和开源模型的理解等技术层出不穷。

这些技术能够向模型输入更多信息,优化特定功能,使其适应特定任务或领域,是大模型er必须掌握的重要技能。

为了让大家跟上领域前沿,我整理了32种前沿微调技术,并提供了参考论文和源码,涵盖_指令微调_、_模型对齐_和_模型推理_等方面。

模型指令微调

【选取一部分参数更新】

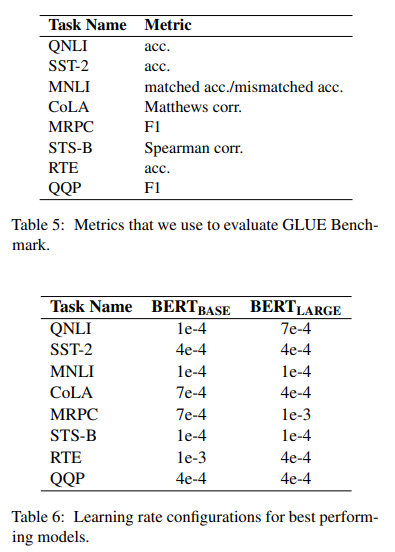

1.BitFit: Simple Parameter-efficient Fine-tuning or Transformer-based Masked Language-models

简述:该文介绍了BitFit,这是一种稀疏微调方法,其中只修改模型的偏差项(或其子集)。作者发现,对于中小型训练数据,在预训练的BERT模型上应用BitFit与对整个模型的微调相比有时甚至更好。对于较大的数据,该方法与其他稀疏微调方法具有竞争力。

【增加额外参数】

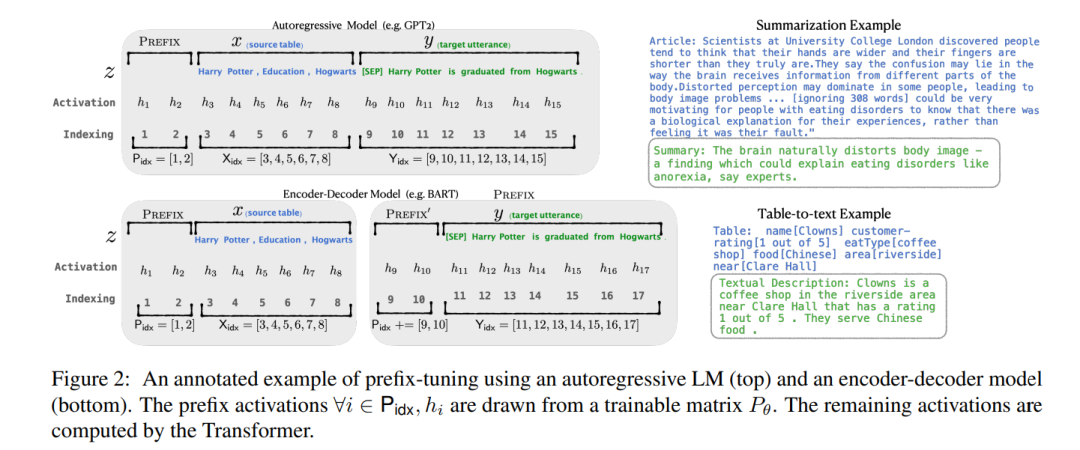

2.Prefix-Tuning Optimizing Continuous Prompts for Generation

简述:该文提出了预调优,这是一种用于自然语言生成任务的轻量级微调替代方案,它可以保持语言模型参数的frozen,优化一个小的连续任务特定向量(称为预调优)。预调试从提示中汲取灵感,允许后续tokens像“虚拟tokens”一样参与预调试。

作者对GPT-2进行预调优,以生成表到文本,并对BART进行摘要。通过仅学习0.1%的参数,预调优在全数据设置中获得了可比的性能,在低数据设置中优于微调。

【引入重参数化】

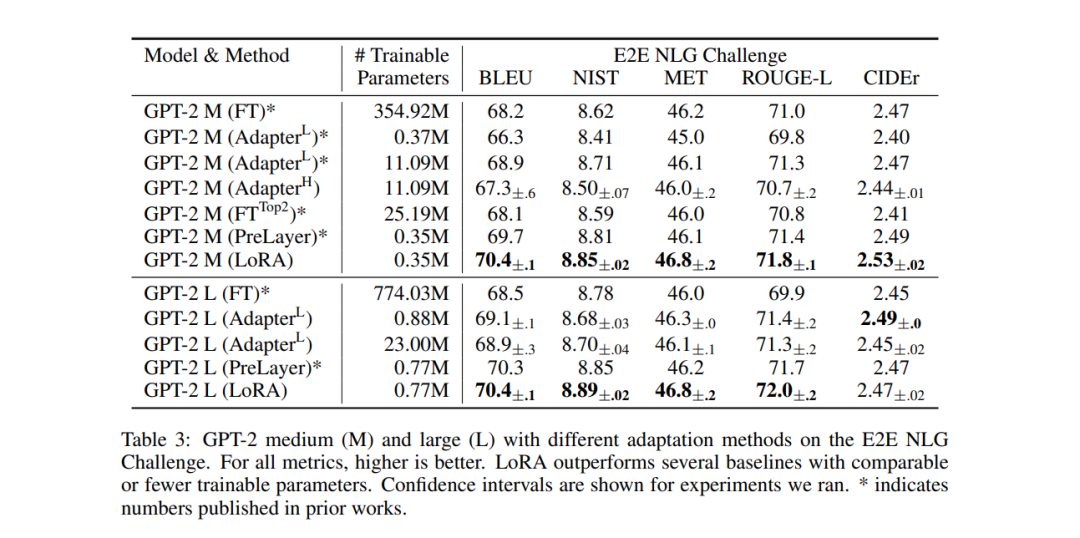

3.LoRA: Low-Rank Adaptation Of Large Language Models

简述:该文提出了低秩自适应,即LoRA,它冻结预训练的模型权重,并将可训练的秩分解矩阵注入Transformer架构的每一层,从而大大减少了下游任务的可训练参数数量。

LoRA在RoBERTa、DeBERTa、GPT-2和GPT-3上的模型质量与微调不相上下或者更好,并且它具有更少的可训练参数、更高的训练吞吐量。

【混合高效微调】

4.Towards A Unified View Of Parameter-Efficient Transfer Learning

简述:该文分解了最先进的参数有效迁移学习方法的设计,并提出了一个统一的框架,在它们之间建立联系。

具体来说,作者将它们重新定义为对预训练模型中特定隐藏状态的修改,并定义一组不同方法变化的设计维度,例如计算修改的函数和应用修改的位置。

该框架能够在不同的方法之间传递设计元素,这些方法比以前的方法调整更少的参数,同时更有效。

模型对齐

【基于强化学习的方法】

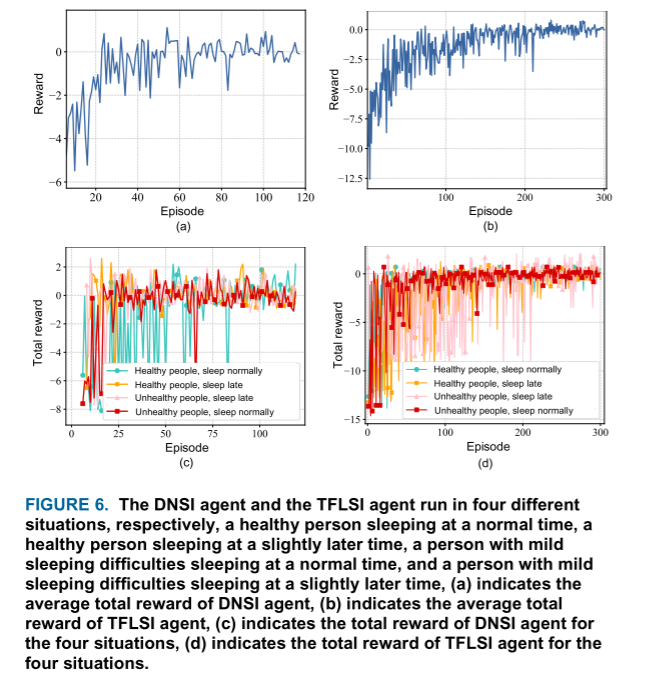

1.RLSF: Multimodal Sleep Improvement Algorithm based Reinforcement Learning

简述:针对白噪声lite对睡眠质量的影响,该文提出了一种基于强化学习的time-frequency相关多模式睡眠增强框架(RLSF),这是一种包括硬件和软件的闭环反馈睡眠改善框架。

具体来说,是通过脑电传感器的输入来馈送个体的睡眠状态进行学习,并逐步训练agent以适应睡眠习惯。

【基于语义学习的方法】

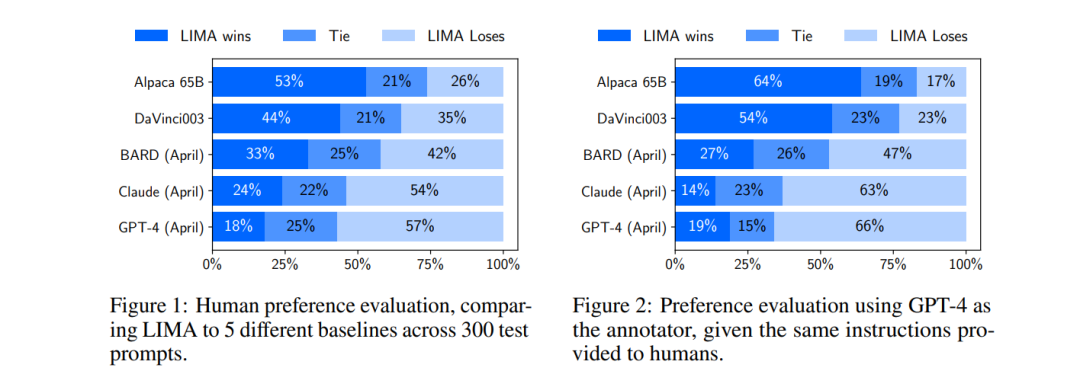

2.LIMA: Less Is More for Alignment

简述:LIMA是一个65B参数的LLaMa语言模型,在没有任何强化学习或人类偏好建模的情况下,仅对1000个精心策划的提示和响应进行了标准监督损失的微调。

LIMA表现出了非常强大的性能,仅从训练数据中的少数几个例子中就学会了遵循特定的响应格式,包括从计划行程到推测替代历史的复杂查询。此外,该模型倾向于很好地推广到训练数据中没有出现的、看不见的任务上。

模型推理

【Post-training Quantization】

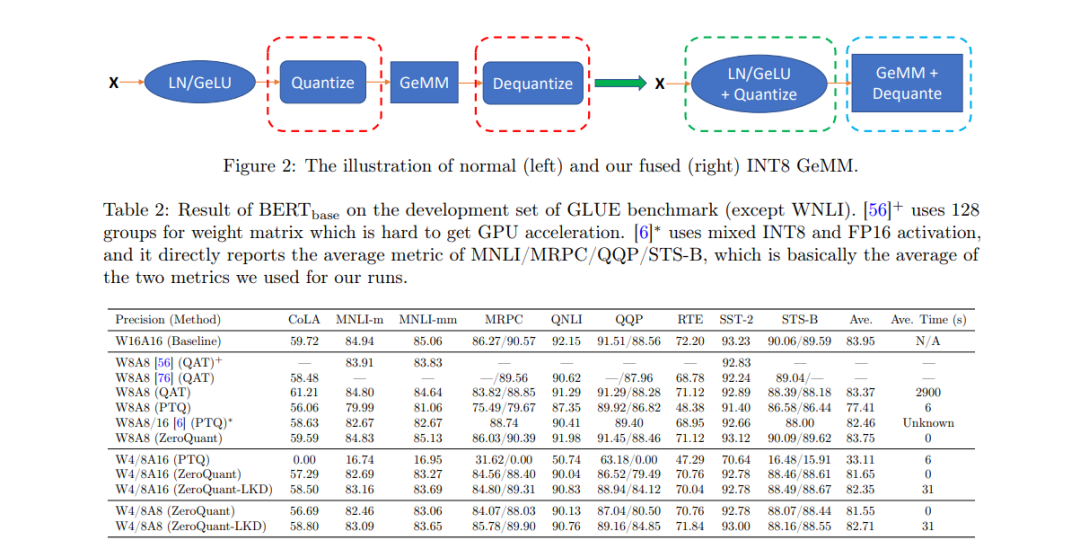

1.ZeroQuant: Efficient and Affordable Post-Training Quantization for Large-Scale Transformers

简述:该文提出了一种高效且经济的训练后量化方法来压缩基于Transformer的大型模型,称为ZeroQuant。

ZeroQuant是一个端到端的量化和推理pipeline,有三个主要组件:

(1)用于权重和激活的fine-grained hardware-friendly量化方案;

(2)一种新的可负担的逐层知识提取算法(LKD);

(3) 高度优化的量化系统后端支持,以消除量化/去量化开销。

对于BERT和GPT-3型模型,ZeroQuant可以以无成本的方式将权重和激活的精度降低到INT8,并且精度影响最小。

【量化感知训练】

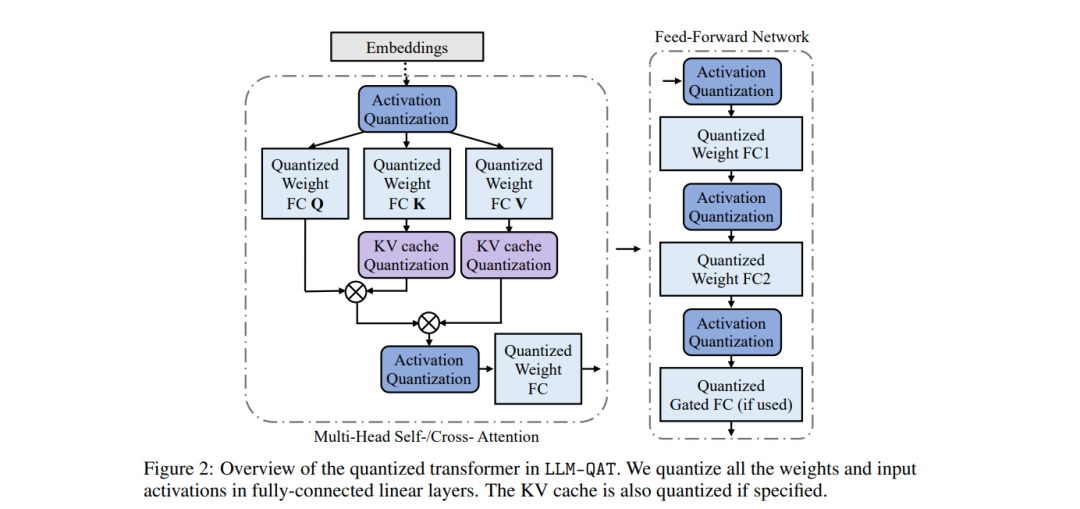

2.LLM-QAT: Data-Free Quantization Aware Training for Large Language Models

简述:该文提出了一种无数据提取方法,该方法利用了预训练模型产生的生成,更好地保留了原始输出分布,并允许量化任何独立于其训练数据的生成模型,类似于训练后量化方法。

除了量化权重和激活,作者还量化了KV cache,这对于提高吞吐量和支持当前模型大小下的长序列依赖性至关重要。

【Prunning】

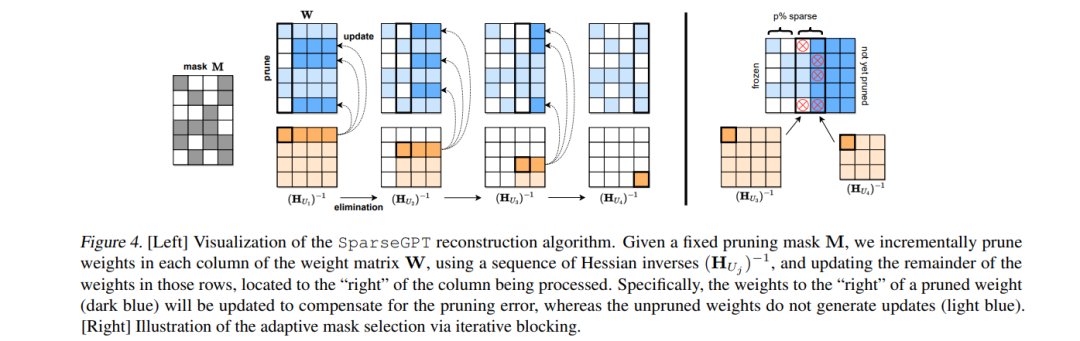

3.SparseGPT: Massive Language Models Can be Accurately Pruned in One-Shot

简述:该文表明,大规模generative pretrained transformer(GPT)族模型可以在一次迭代中修剪到至少50%的稀疏性,而无需任何再训练,精度损失最小。

这是通过一种名为SparseGPT的方法实现的,该方法专门设计用于在大规模GPT家族模型上高效准确地工作。

【knowledge Distillation】

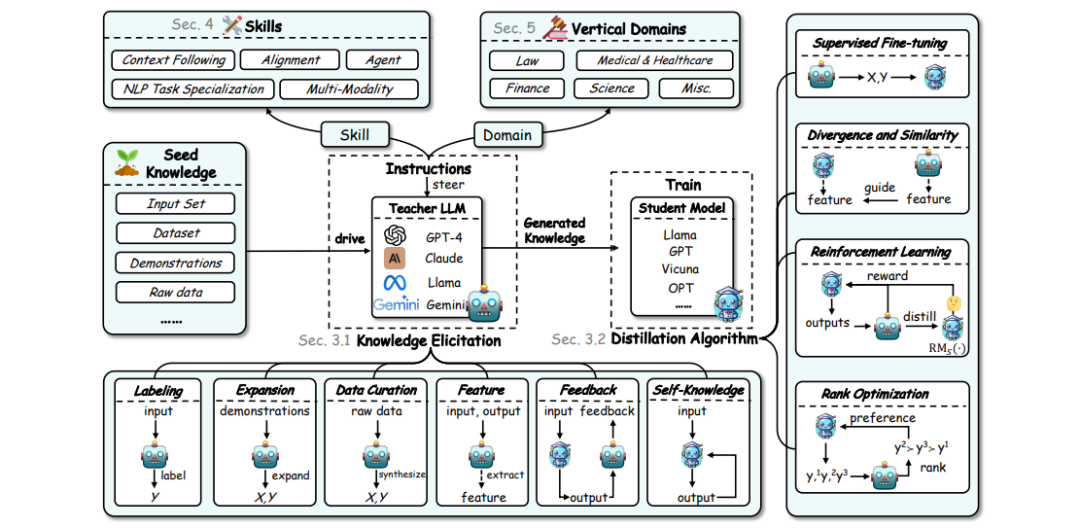

4.A Survey on Knowledge Distillation of LargeLanguage Models

简述:该文对KD在LLM领域中的作用进行了全面的调查,强调了它在向小型模型传授先进知识方面的关键作用,以及它在模型压缩和自我改进中的实用性。

该调查围绕三个基本支柱精心构建:算法、技能和垂直化——对KD机制、特定认知能力的增强及其在不同领域的实际意义进行了全面的研究。

至关重要的是,该调查揭示了数据增强(DA)和KD之间复杂的相互作用,说明了DA如何在KD框架内成为一种强大的paradigm,以提高LLM的性能。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

本文转自 https://blog.csdn.net/python122_/article/details/140708635?spm=1001.2014.3001.5501,如有侵权,请联系删除。

9674

9674

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?