📌 友情提示:

本文内容由银河易创AI(https://ai.eaigx.com)创作平台的gpt-4o-mini模型生成,旨在提供技术参考与灵感启发。文中观点或代码示例需结合实际情况验证,建议读者通过官方文档或实践进一步确认其准确性。

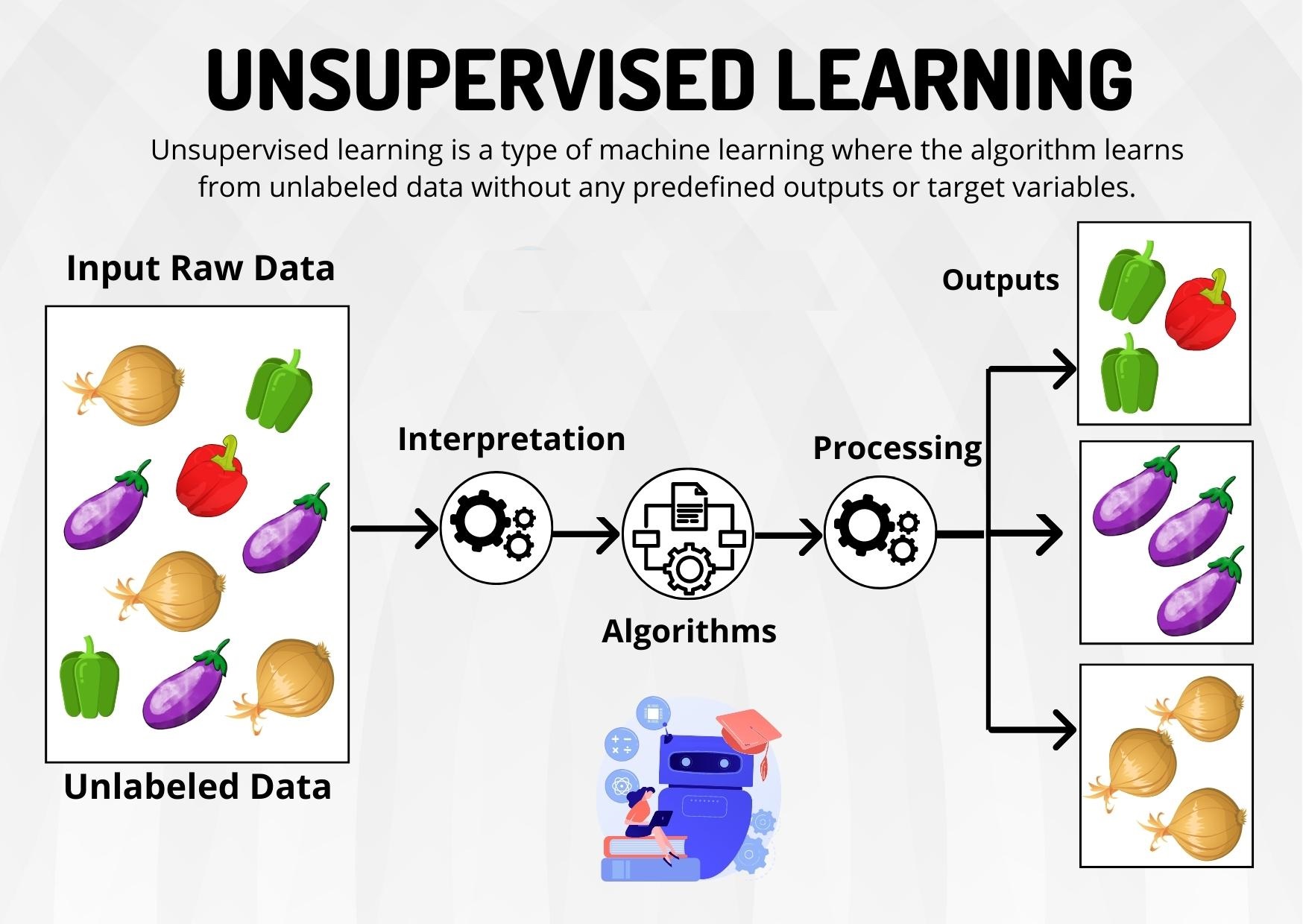

在机器学习的广阔领域中,学习算法可以大致分为三类:监督学习、无监督学习和强化学习。其中,无监督学习因其在没有标签数据的情况下探索数据的潜在结构而备受关注。在本篇博文中,我们将深入探讨无监督学习的基本概念、常见算法及其在实际应用中的重要性。

一、什么是无监督学习?

无监督学习是一种机器学习的类型,它使得算法在没有任何标签数据的情况下对输入数据进行分析。与监督学习不同,后者依赖于已标注的数据集来训练模型,目的是通过学习输入与输出之间的映射关系来进行预测。无监督学习则试图从未标注的数据中发掘潜在的模式和结构,旨在识别数据的内在特征。

无监督学习的主要任务有两个:聚类和降维。

1.1 聚类

聚类是一种将数据集划分为多个组(或簇)的方法,使得同一组内的数据点相似度高而不同组之间的数据点相似度低。聚类算法通过分析数据点之间的距离或相似性来确定这些组的边界。常见的聚类算法包括K-Means、层次聚类和DBSCAN等。聚类的应用非常广泛,例如在市场营销中,可以将客户分成不同的群体,以制定更有针对性的营销策略。

1.2 降维

降维则是通过减少数据集中的特征数量来简化数据,同时尽量保留其重要的信息。这种方法在数据可视化和高性能计算中尤为重要。降维可以帮助减少过拟合,提升模型的训练速度。主成分分析(PCA)和t-SNE是两种常用的降维技术。通过降低数据的维度,可以将复杂的高维数据映射到低维空间,便于进行进一步的分析和理解。

1.3 无监督学习的特点

无监督学习的一个显著特点是它不依赖于标签,因此可以处理大规模的、未标注的数据。这使得无监督学习在许多实际应用中具有广阔的前景,例如在图像处理、自然语言处理和生物信息学等领域。通过无监督学习,研究人员和工程师能够从庞大的数据集中提取信息,而无需进行劳动密集的标注工作。

二、无监督学习的应用

无监督学习在各行各业中都有广泛的应用,它能够帮助我们从复杂的数据集中抽取有用的信息。以下是一些具体的应用示例,展示无监督学习的强大能力和灵活性。

2.1 客户细分

在市场营销中,企业可以使用无监督学习对客户进行细分。通过聚类算法,企业能够识别不同类型的客户群体,了解他们的购买行为、偏好和需求。这种分析帮助企业制定更有效的营销策略,从而提升客户满意度和忠诚度。例如,在线零售商可以根据客户的购买历史将顾客分为频繁购买者、偶尔购买者和潜在客户,以便针对性地推出个性化的促销活动。

2.2 图像处理

在图像处理领域,无监督学习可以用于图像分割和特征提取。通过无监督学习,系统能够自动识别图像中的不同区域,并将其分类。例如,在医学影像分析中,无监督学习可以帮助医生分割出肿瘤区域,从而为后续的分析和诊断提供支持。此外,图像处理中的降维技术也可以用于减少图像数据的维度,提升图像处理和存储的效率。

2.3 异常检测

无监督学习在异常检测中的应用也非常重要。在金融领域,银行和金融机构可以利用无监督学习方法检测信用卡欺诈和其他可疑交易。例如,通过分析历史交易数据,模型可以建立正常交易模式的基线并实时监测交易。一旦发现与正常模式显著偏离的交易,系统就会发出警报,从而帮助防止潜在的欺诈行为。

2.4 推荐系统

无监督学习在推荐系统中的应用日益增多,尤其是在内容推荐和商品推荐方面。通过分析用户的行为数据,无监督学习能够识别出潜在的用户兴趣和偏好,从而为用户提供个性化的推荐。例如,流媒体平台可以利用用户观看历史聚类出相似的用户群体,并基于这些群体的共同偏好向用户推荐相关的电影或电视剧。

2.5 文本分析与自然语言处理

在文本分析和自然语言处理中,无监督学习也发挥着重要作用。通过对大量文本数据进行聚类和主题建模,机器可以发现文本中的潜在主题和关系。这种能力在文档分类、信息检索和情感分析等领域尤其重要。例如,新闻聚合网站可以使用无监督学习方法将新闻文章自动分类,从而帮助用户快速找到感兴趣的内容。

无监督学习的广泛应用展示了其在处理复杂数据时的强大能力。通过从未标注的数据中提取信息,无监督学习为企业和研究人员提供了重要的决策依据和洞察力。随着数据量的不断增长和无监督学习技术的发展,未来无监督学习将会在更多领域发挥重要作用,推动各行业的创新和发展。

三、常见的无监督学习算法

无监督学习算法种类繁多,适用于不同类型的数据和任务。下面我们将详细介绍几种常见的无监督学习算法,分别包括聚类算法、降维算法和关联规则学习。每种算法的介绍中将包含基本原理、应用场景和相关代码示例,以帮助开发人员理解和实现这些算法。

3.1 聚类算法

3.1.1 K-Means算法

原理: K-Means算法是一种广泛使用的聚类算法,旨在将数据集分成K个簇。算法通过反复迭代来优化每个数据点与其对应质心之间的距离,直到达到收敛条件。每个簇的质心是该簇内所有点的均值。

步骤:

- 随机选择K个初始质心。

- 将每个数据点分配给最近的质心,形成K个簇。

- 更新每个簇的质心,计算每个簇内所有点的均值。

- 重复步骤2和3,直到质心不再改变或达到最大迭代次数。

代码示例(使用Python的scikit-learn库):

import numpy as np

import matplotlib.pyplot as plt

from sklearn.cluster import KMeans

# 生成随机数据

np.random.seed(0)

X = np.random.rand(100, 2)

# 使用K-Means进行聚类

kmeans = KMeans(n_clusters=3)

kmeans.fit(X)

# 获取聚类结果

labels = kmeans.labels_

centroids = kmeans.cluster_centers_

# 可视化聚类结果

plt.scatter(X[:, 0], X[:, 1], c=labels, s=50, cmap='viridis')

plt.scatter(centroids[:, 0], centroids[:, 1], c='red', s=200, alpha=0.75, marker='X')

plt.title('K-Means Clustering')

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.show()

3.1.2 DBSCAN算法

原理: DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是一种基于密度的聚类算法。与K-Means不同,DBSCAN可以识别任意形状的簇,并且能够有效处理噪声数据。它的主要思想是通过密度连接的原则来确定簇。

步骤:

- 选择一个点并找到其ε邻域内的所有点。

- 如果该点的邻域内的点数超过某个最小阈值,便将这些点作为一个簇。

- 对于簇中的每个点,重复步骤1和2,直到无法再扩展簇。

- 对于未被分配到任何簇的点,将其标记为噪声。

代码示例(使用Python的scikit-learn库):

from sklearn.cluster import DBSCAN

# 生成随机数据

np.random.seed(0)

X = np.random.rand(100, 2)

# 使用DBSCAN进行聚类

dbscan = DBSCAN(eps=0.1, min_samples=5)

labels = dbscan.fit_predict(X)

# 可视化聚类结果

plt.scatter(X[:, 0], X[:, 1], c=labels, s=50, cmap='viridis')

plt.title('DBSCAN Clustering')

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.show()

3.2 降维算法

3.2.1 主成分分析(PCA)

原理: 主成分分析(PCA)是一种线性降维技术,旨在通过线性变换将数据从高维空间映射到低维空间,尽量保留数据的方差。PCA通过计算协方差矩阵的特征值和特征向量来实现降维。

步骤:

- 标准化数据,使每个特征具有零均值和单位方差。

- 计算协方差矩阵。

- 计算协方差矩阵的特征值和特征向量。

- 选择前K个特征向量,形成新的特征空间。

- 将数据映射到新的特征空间。

代码示例(使用Python的scikit-learn库):

from sklearn.decomposition import PCA

from sklearn.datasets import load_iris

# 加载Iris数据集

iris = load_iris()

X = iris.data

# 使用PCA进行降维

pca = PCA(n_components=2)

X_reduced = pca.fit_transform(X)

# 可视化降维结果

plt.scatter(X_reduced[:, 0], X_reduced[:, 1], c=iris.target, cmap='viridis')

plt.title('PCA of Iris Dataset')

plt.xlabel('Principal Component 1')

plt.ylabel('Principal Component 2')

plt.show()

3.2.2 t-SNE

原理: t-SNE(t-distributed Stochastic Neighbor Embedding)是一种用于高维数据可视化的非线性降维技术。t-SNE通过保留数据点之间的相似度关系,使得在低维空间中相似的数据点尽量靠近,而不相似的数据点尽量远离。

步骤:

- 计算高维数据点之间的相似度。

- 在低维空间中,使用随机初始化的点构建分布。

- 通过优化算法调整低维空间中的点,使其分布尽量保留高维空间中的相似度。

代码示例(使用Python的scikit-learn库):

from sklearn.manifold import TSNE

# 使用t-SNE进行降维

tsne = TSNE(n_components=2, random_state=0)

X_embedded = tsne.fit_transform(X)

# 可视化降维结果

plt.scatter(X_embedded[:, 0], X_embedded[:, 1], c=iris.target, cmap='viridis')

plt.title('t-SNE of Iris Dataset')

plt.xlabel('t-SNE Component 1')

plt.ylabel('t-SNE Component 2')

plt.show()

3.3 关联规则学习

3.3.1 Apriori算法

原理: Apriori算法是一种经典的关联规则学习算法,主要用于挖掘频繁项集和生成关联规则。该算法采用“自下而上”的策略,通过迭代生成候选项集并计算其支持度,识别出频繁项集。

步骤:

- 从数据集中找到所有单个项的支持度。

- 生成频繁项集并计算其支持度。

- 使用频繁项集生成关联规则,并计算其置信度。

代码示例(使用Python的mlxtend库):

from mlxtend.frequent_patterns import apriori, association_rules

import pandas as pd

# 创建交易数据

data = {'Milk': [1, 1, 0, 0, 1],

'Bread': [1, 1, 1, 0, 1],

'Eggs': [0, 1, 1, 1, 0]}

df = pd.DataFrame(data)

# 使用Apriori算法生成频繁项集

frequent_itemsets = apriori(df, min_support=0.4, use_colnames=True)

# 生成关联规则

rules = association_rules(frequent_itemsets, metric="confidence", min_threshold=0.5)

print("Frequent Itemsets:")

print(frequent_itemsets)

print("\nAssociation Rules:")

print(rules)

这些无监督学习算法为数据分析提供了强大的工具。无论是聚类、降维还是关联规则学习,开发人员都可以根据具体需求选择合适的算法,并通过实际代码示例快速上手。随着数据科学和机器学习的不断发展,深入理解和掌握这些算法将成为开发人员提升技能和优化数据分析能力的重要一环。

四、无监督学习的挑战与未来

无监督学习作为一种重要的机器学习方法,虽然在许多领域中展现出了巨大的潜力和应用价值,但其在实际应用中仍然面临诸多挑战和限制。以下是一些主要的挑战以及未来发展方向的探讨。

4.1 挑战

4.1.1 缺乏标注数据的评估标准

无监督学习的一个主要挑战是缺乏明确的评估标准。在监督学习中,我们可以使用标签来评估模型的准确性和性能。然而,在无监督学习中,由于没有标签,往往难以判断模型的效果和输出的质量。例如,聚类结果的评估通常依赖于轮廓系数、Davies-Bouldin指数等指标,这些指标在不同场景下可能会产生偏差。

4.1.2 模型选择与参数调整

无监督学习中的模型选择和参数调整往往依赖于先验知识和经验。不同的数据集和任务可能需要不同的算法和参数设置,例如,K-Means聚类中的K值选择、DBSCAN中的ε和min_samples参数。这些超参数的选择可能会显著影响算法的输出结果,而缺乏有效的调整策略可能导致模型性能下降。

4.1.3 处理高维数据的挑战

高维数据(即特征数量大于样本数量的数据)是无监督学习中的常见问题。高维数据会导致“维度诅咒”,使得数据点之间的距离变得难以衡量,进而影响聚类效果和降维质量。在高维空间中,数据的稀疏性增加,传统的无监督学习算法可能无法有效捕捉数据的内在结构。

4.1.4 噪声和异常值的影响

无监督学习算法对噪声和异常值的敏感性是一个重要的挑战。在许多实际场景中,数据集可能包含噪声或异常值,这些数据点可能会干扰模型的学习过程并导致错误的结果。例如,在聚类中,噪声点可能被错误地归类到某个簇中,从而影响整体的聚类结果。

4.2 未来发展方向

随着深度学习技术的不断进步和数据规模的快速增长,无监督学习的未来发展潜力巨大。以下是几个可能的发展方向:

4.2.1 深度学习与无监督学习的结合

深度学习在特征提取和表示学习方面表现出色,结合深度学习的方法可以显著提升无监督学习的能力。例如,自编码器、生成对抗网络(GANs)等深度学习模型在无监督学习任务中应用广泛,可以帮助自动提取数据的深层特征。

4.2.2 迁移学习与无监督学习的结合

迁移学习是一种通过借用在源领域上获得的知识来改善目标领域的学习过程的方法。将迁移学习与无监督学习结合起来,可以在没有标注数据的情况下提升模型的适应能力和泛化能力。这种方法在处理新领域的数据时将变得尤为重要。

4.2.3 强化学习与无监督学习的交叉

强化学习近年来取得了显著进展,未来也可能与无监督学习产生交叉。通过设计新的学习框架,使得无监督学习能够借助强化学习中的反馈机制,可以提升模型在复杂环境中的学习能力。

4.2.4 解释性与可解释性的研究

无监督学习的黑箱特性使得模型的可解释性成为一个重要的研究课题。未来的研究将更关注于提升无监督学习模型的可解释性,以便用户能够理解模型的输出和决策过程。这不仅有助于提高用户的信任,还能在多个领域(如医疗和金融)中推动无监督学习的应用。

五、结语

无监督学习作为机器学习的重要分支,凭借其在没有标签的数据中发现潜在模式和结构的能力,已在多个领域取得了显著成果。从客户细分到异常检测,从图像处理到文本分析,无监督学习展现了其强大的应用价值。

然而,无监督学习仍面临许多挑战,包括评估标准的缺乏、模型选择的复杂性、处理高维数据的困难,以及对噪声和异常值的敏感性。面对这些挑战,结合深度学习、迁移学习以及其他新兴技术的发展,无监督学习的未来充满了机遇。随着数据科学的不断进步,无监督学习将在数据分析和人工智能领域中发挥越来越重要的作用。

3824

3824

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?