欢迎大家关注我们的网站和系列教程:http://panchuang.net/ ,学习更多的机器学习、深度学习的知识!

目录:

- 门控循环神经网络简介

- 长短期记忆网络(LSTM)

- 门控制循环单元(GRU)

- TensorFlow实现LSTM和GRU

- 参考文献

门控循环神经网络在简单循环神经网络的基础上对网络的结构做了调整,加入了门控机制,用来控制神经网络中信息的传递。门控机制可以用来控制记忆单元中的信息有多少需要保留,有多少需要丢弃,新的状态信息又有多少需要保存到记忆单元中等。这使得门控循环神经网络可以学习跨度相对较长的依赖关系,而不会出现梯度消失和梯度爆炸的问题。如果从数学的角度来理解,一般结构的循环神经网络中,网络的状态和之间是非线性的关系,并且参数W在每个时间步共享,这是导致梯度爆炸和梯度消失的根本原因。门控循环神经网络解决问题的方法就是在状态和之间添加一个线性的依赖关系,从而避免梯度消失或梯度爆炸的问题。

二、长短期记忆网络(LSTM)

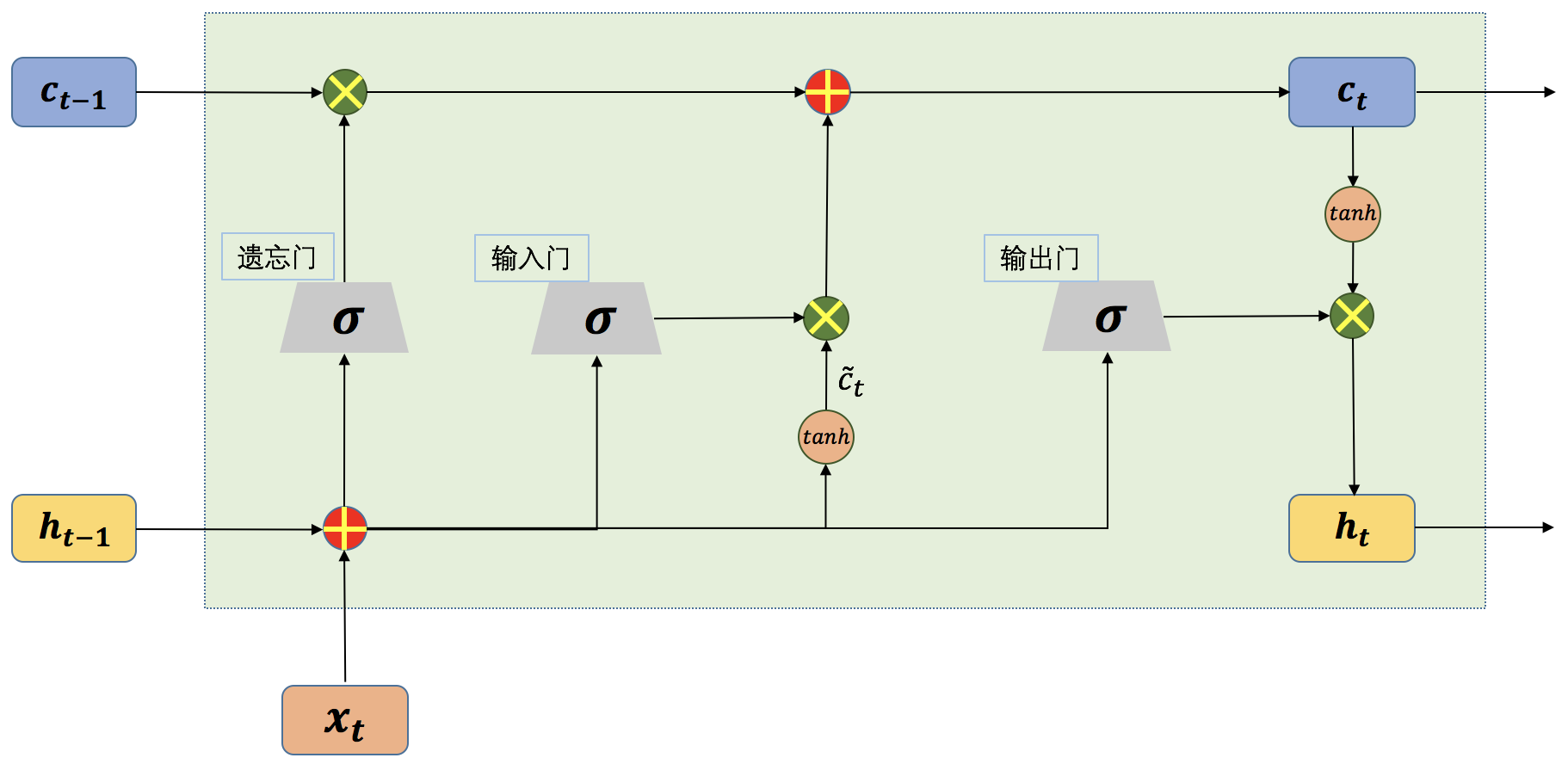

长短期记忆网络(Long Short-term Memory,简称LSTM)的结构如图1所示,LSTM[1]的网络结构看上去很复杂,但实际上如果将每一部分拆开来看,其实也很简单。在一般的循环神经网络中,记忆单元没有衡量信息的价值量的能力,因此,记忆单元对于每个时刻的状态信息等同视之,这就导致了记忆单元中往往存储了一些无用的信息,而真正有用的信息却被这些无用的信息挤了出去。LSTM正是从这一点出发做了相应改进,和一般结构的循环神经网络只有一种网络状态不同,LSTM中将网络的状态分为内部状态和外部状态两种。LSTM的外部状态类似于一般结构的循环神经网络中的状态,即该状态既是当前时刻隐藏层的输出,也是下一时刻隐藏层的输入。这里的内部状态则是LSTM特有的。

在LSTM中有三个称之为“门”的控制单元,分别是输入门(input gate)、输出门(output gate)和遗忘门(forget gate),其中输入门和遗忘门是LSTM能够记忆长期依赖的关键。输入门决定了当前时刻网络的状态有多少信息需要保存到内部状态中,而遗忘门则决定了过去的状态信息有多少需要丢弃。最后,由输出门决定当前时刻的内部状态有多少信息需要输出给外部状态。

图1 单个时间步的LSTM网络结构示意图

从上图我们可以看到,一个LSTM单元在每个时间步都会接收三个输入,当前时刻的输入,来自上一时刻的内部状态以及上一时刻的外部状态。其中,和同时作为三个“门”的输入。为Logistic函数,。接下来我们将分别介绍LSTM中的几个“门”结构。首先看一下输入门,如图2所示:

从上图我们可以看到,一个LSTM单元在每个时间步都会接收三个输入,当前时刻的输入,来自上一时刻的内部状态以及上一时刻的外部状态。其中,和同时作为三个“门”的输入。为Logistic函数,。

接下来我们将分别介绍LSTM中的几个“门”结构。首先看一下输入门,如图2所示:

本文详细介绍了门控循环神经网络的基础,包括长短期记忆网络(LSTM)和门控制循环单元(GRU)的结构、工作原理,并提供了TensorFlow实现LSTM和GRU的示例。通过理解门控机制,LSTM和GRU能更好地处理长期依赖问题,避免梯度消失和梯度爆炸。

本文详细介绍了门控循环神经网络的基础,包括长短期记忆网络(LSTM)和门控制循环单元(GRU)的结构、工作原理,并提供了TensorFlow实现LSTM和GRU的示例。通过理解门控机制,LSTM和GRU能更好地处理长期依赖问题,避免梯度消失和梯度爆炸。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2584

2584

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?