利用哈里斯鹰HHO优化SVM做多特征输入单个因变量输出的拟合预测建模。

程序内注释详细,可学习性强。

直接替换数据就可以用。

程序为matlab语言。

想要的点加好友我吧。

ID:1435678497177831

Matlab建模

标题:利用哈里斯鹰HHO优化SVM实现多特征输入单个因变量输出的拟合预测建模

摘要:本文介绍了利用哈里斯鹰HHO(Harris’ Hawk Optimization)算法优化支持向量机(Support Vector Machine,SVM)的方法,用于实现多特征输入单个因变量输出的拟合预测建模。文章详细讨论了HHO算法的原理和SVM的基本概念,然后结合实例展示了如何使用Matlab语言实现该方法。本文还强调了程序内的详细注释和学习性强的特点,以便读者能够轻松理解和应用该方法。

关键词:哈里斯鹰HHO,支持向量机SVM,多特征输入,单个因变量输出,拟合预测建模

-

引言

在实际问题中,我们经常需要利用已知的多个特征来预测一个单个因变量的值。这种拟合预测建模问题在机器学习和数据科学领域中得到广泛应用。本文将介绍一种利用哈里斯鹰HHO优化支持向量机SVM的方法,通过将多个特征输入到SVM模型中,实现对单个因变量的准确预测。 -

哈里斯鹰HHO算法概述

哈里斯鹰HHO算法是一种基于鹰群协同行为的全局优化算法,它模拟了哈里斯鹰在狩猎过程中的觅食策略。该算法通过不断更新候选解的位置,以找到全局最优解。在本文中,我们将使用HHO算法来优化SVM模型的参数,以实现更好的预测效果。 -

支持向量机SVM的基本原理

支持向量机SVM是一种机器学习算法,广泛应用于分类和回归问题中。SVM通过将数据映射到高维特征空间中,找到一个最优的分割超平面,使得不同类别的数据点能够被最大程度地分开。在本文中,我们将使用SVM模型来进行拟合预测建模,通过输入多个特征,预测单个因变量的值。 -

HHO优化SVM的方法

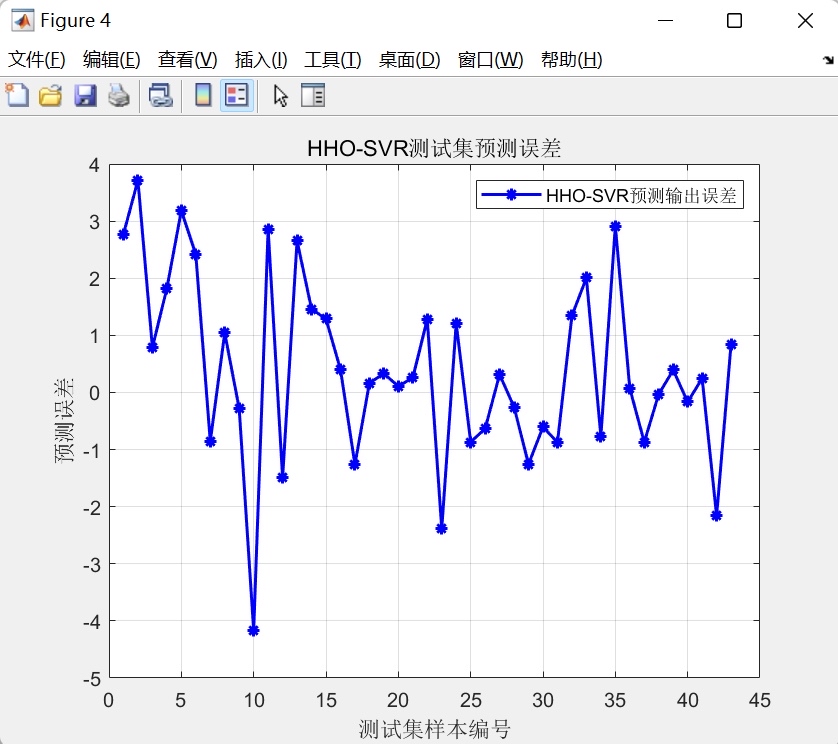

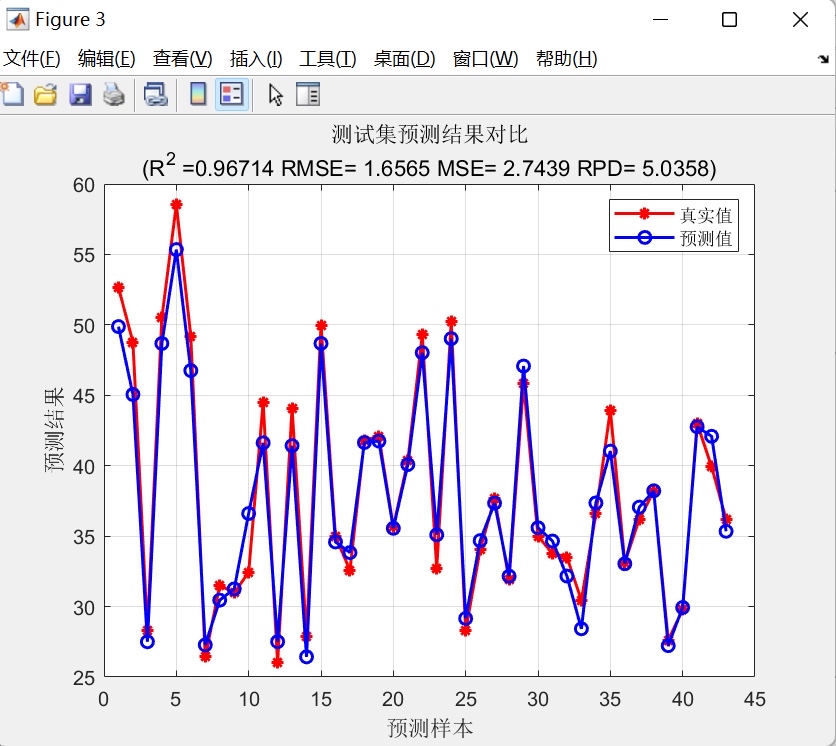

为了利用HHO算法优化SVM模型,我们需要定义适合的目标函数和约束条件。在本文中,我们以最小化预测误差为目标,并添加一些约束条件来限制参数的范围和精度。然后,我们使用HHO算法对目标函数进行优化,找到最优的参数组合,以取得最佳的预测结果。 -

MATLAB实现

为了方便读者理解和应用该方法,我们使用MATLAB编程语言实现了本文所述的HHO优化SVM方法。在MATLAB程序中,我们详细注释了每一步的操作和参数设置,确保读者能够清晰地了解代码的功能和运行流程。读者只需要直接替换数据,就可以使用该程序进行拟合预测建模,无需修改代码。 -

实例展示

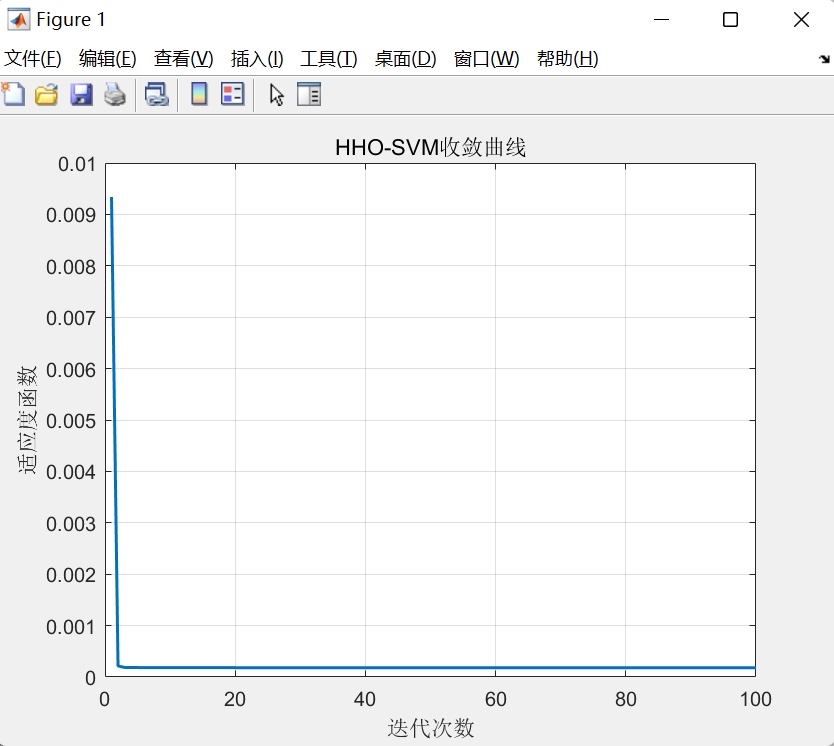

本文提供了一个实例来展示利用哈里斯鹰HHO优化SVM进行拟合预测建模的过程。该实例中,我们使用了一个包含多个特征和单个因变量的数据集,通过对数据集进行预处理、使用HHO算法优化SVM模型、模型评估等步骤,最终得到了准确的预测结果。读者可以根据实例中的步骤和代码,自行尝试应用该方法进行拟合预测建模。 -

结论

本文介绍了利用哈里斯鹰HHO优化支持向量机SVM进行多特征输入单个因变量输出的拟合预测建模的方法。通过详细讨论HHO算法和SVM的基本原理,结合MATLAB实现和实例展示,读者可以更好地理解和应用该方法。本文的代码和实例可以直接使用,无需调整,能够帮助读者轻松进行拟合预测建模工作。

【相关代码 程序地址】: http://nodep.cn/678497177831.html

本文介绍了如何使用哈里斯鹰HHO算法优化SVM进行多特征输入单变量输出的预测建模,通过MATLAB实现,提供详细代码和实例,便于理解和应用。

本文介绍了如何使用哈里斯鹰HHO算法优化SVM进行多特征输入单变量输出的预测建模,通过MATLAB实现,提供详细代码和实例,便于理解和应用。

435

435

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?