最近关于长尾学习,接触到一篇从因果推断角度来解决长尾分类问题的文章——Long-Tailed Classification by Keeping the Good andRemoving the Bad Momentum Causal Effect,该文将长尾问题下暴露的问题抽象为一个因果图,通过对该因果图做调整得到相应的因果效应,进而缓解长尾分类的性能。

一、背景

应对长尾分类问题的方法目前有重采样、重加权、迁移学习、两阶段等,这些方法在一定程度、一定条件下改善了长尾分类问题,但是或多或少都存在一些诟病,比如重采样或导致尾部类过拟合或者头部类欠拟合,两阶段方法和目前主流的一阶段训练方法相比过于复杂;其次,已有的一些方法对效果的提升无法给出确切的原因,就像一个黑盒子,只能拿来用,却不能一探究竟!

基于因果推断的方法,和已有的方法相比,它有一套逻辑来说明长尾分类问题的症结在哪,根据因果推理理论如何解决,这也充分说明了它不再是一个黑盒子,只要理解了其中的因果关系,就能理解该方法为何有效。其次,该方法是一个一阶段的通用处理方法,这极大的促进了该方法和实际应用的结合。

二、相关概念

本文讲解的文章提及到了一些因果推断方面的核心概念,需要一定的概率统计方面的知识背景,同时建议选择性的对参考文献中的文章做一些大致的了解。

- 混淆:混淆(confounding)是指存在一个变量X ,该变量构成了T 和Y 的共同原因,如果忽略了X 的影响,那么T 和Y 之间存在假性相关关系:即T 并非产生Y 的直接原因。如果我们在夏天时候发现游泳溺水的人数增加,如果忽略了气温的影响,仅凭冰淇淋销量与溺水人数呈现出来的正向相关关系,则可能得出吃冰淇淋会导致游泳溺水的错误结论。

- 中介:中介效应

- 后门准则:后门准则backdoor adjustment

- 干预:因果推理初探(4)——干预

- 逆概率加权:一种基于样本的近似条件概率计算方法

- TDE:总直接效应,类似与人的认知

三、因果图

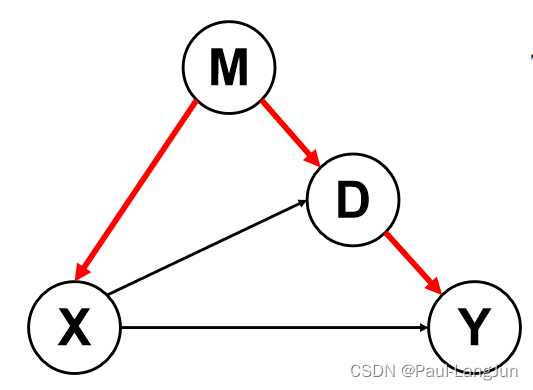

结合因果推断以及动量的相关概念,作者构建了如图所示的因果图。

目标是求X->Y的直接效应(TDE),将TDE作为最终预测Logit的计算,但是存在两条路径阻碍得到该结果:

- 后门路径 X←M→D→Y 会因为M的存在导致X和Y产生错误的依赖关系,比如当X是一个猫头鹰,Y是家猫,但是X和Y压根就没有任何关系

- 中介效应 X→D→Y 会干扰TDE(X -> Y)的计算

因此,作者通过对因果图进行下面方式来计算TDE,即 X→Y:

左侧表示在训练阶段通过因果干预的手段,去除了后门路径的影响,具体使用了因果推断中的do-操作(可简单理解为将X固定位一个值):

因此,左侧效果 = TDE + 中介效应中的有益部分 + 中介效应中的有害部分。

右侧表示推理阶段通过将X置为空,以便减去中介效应中的有害部分(M->D->Y产生的有害bias,由于动量可以稳定梯度,故无法在训练时去掉动量项,只能在推断时去除)。

最终的TDE计算公式是:

3569

3569

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?