在AI界,英伟达的大名无人不知,无人不晓。然而即使在AI芯片界占据绝对霸主地位的英伟达,依旧受制于人。

众所周知,算力与带宽是制衡AI应用的两大关键因素,长期以来高速发展的算力受困于有限的带宽限制了其性能的最大发挥。

而带宽往往取决于芯片的性能,因而采用了先进封装从而克服高性能计算应用程序的内存访问障碍的HBM应运而生。作为一种新兴的高带宽内存,它几乎成为了AI芯片的必备搭档。

HBM到底什么来头?

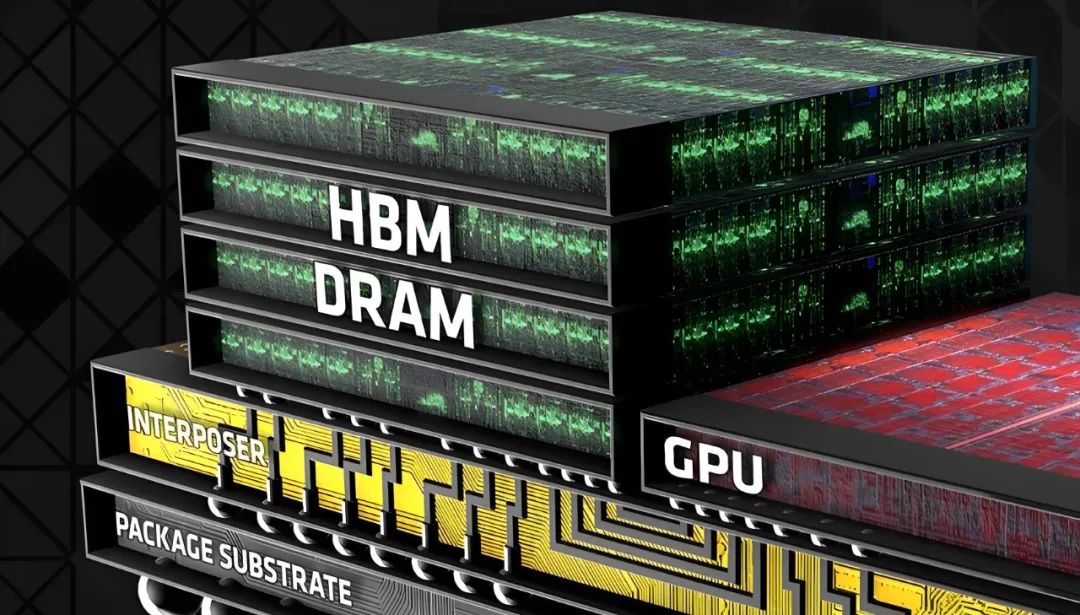

那么何为HBM呢?它是High Bandwidth Memory的缩写,即一种新型的高带宽存储器,通过采用硅通孔(TSV)和微凸块(Microbump)等先进封装方法将各个芯片相互连接,形成一个整体的高带宽内存模块。

简而言之,它改变了常规的DDR(Double Data Rate) 2D平面的堆叠方式而更换成为密度更高的3D立体堆叠技术,它的突破在于在较小的物理空间里实现了大容量、高位宽的DR组合阵列,因此HBM具有更高带宽、更多I/O数量、更低功耗、更小尺寸,同时意味着这将不可避免造成了一定数据延迟以及它的不可扩展性。

AI和高性能领域几乎都是可预测的高并发任务,对于GPU的延迟要求相对不高,相反它对于带宽需求非常敏感,因而它是高端GPU的最佳显存搭档。对比传统的GDDR(Graphics Double Data Rate,即我们常规认识的各类显卡上的核心部件之一显存),HBM可提供高达460GB/s的带宽,是GDDR的4倍多,而功耗仅为GDDR的一半。

HBM发展现状与趋势?

HBM每一次更新迭代都会伴随着处理速度的提高。HBM产品已经从HBM(第一代)迭代到最新的HBM3E(它是HBM3的扩展版本)。如果按照HBM3E目前的速率,下载一部长达163分钟的全高清(Full-HD)电影(1TB)只需不到1秒钟的时间。

尽管DRAM和Flash等作为传统的存储芯片技术在面对AI处理大量数据时显得力不从心,但由于HBM的技术复杂性以及生产难度限制了其在成本敏感的场景应用,因而在整体存储市场占有率较低,目前还不是普及性应用的产品。

HBM最先是由海力士与AMD于2013年联合推出的,但最终入局的玩家是SK海力士、三星和美光。2023年英伟达发布H200芯片,即采用了海力士提供HBM3e内存。同样于2024年推出的地表最强GPU B200,号称配备了192GB内存和高达8TB/S带宽,也是因为其采用了HBM--HBM3e堆叠技术。

HBM的应用领域?

目前,HBM主要应用于需要处理大量数据和高速计算的场景,如HPC用于加速科学研究以及复杂计算任务。

如AI/ML(机器学习),它的出现提升了单位面积的存储器密度,使得AI/深度学习完全放到片上成为可能,带宽不再受制于芯片引脚的互联数量,在一定程度上解决了IO瓶颈。

如数据中心,HBM内存芯片的尺寸相对较小,由于能够在更加紧凑的空间内实现更强大的计算能力,因而是数据中心的理想选择。

如智能驾驶,HBM可以提供快速处理传感器数据所需的带宽。

如虚拟现实(VR)和增强现实(AR),VR和AR应用需要高分辨率和高帧率的图形处理,HBM能够提供所需的内存带宽。

HBM的功耗仅为GDDR5的二分之一,这使得HBM在移动设备和笔记本电脑等功耗受限的环境中具有更广泛的应用前景。

HBM的出现对于AI芯片发展意义非凡。在AI技术领域,HBM作为提升算力的关键因素,正崭露头角。随着对高带宽内存需求增长,人工智能技术的飞速发展,以及5G跟物联网技术的迭代升级,HBM将有广阔的市场发展机遇,预计或将取代传统的存储器成为市场主流。

295

295

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?