[1] The streaming rollout of deep networks - towards fully model-parallel execution

Volker Fischer, Jan Köhler, Thomas Pfeil

Bosch Center for Artificial Intelligence

https://papers.nips.cc/paper/7659-the-streaming-rollout-of-deep-networks-towards-fully-model-parallel-execution.pdf

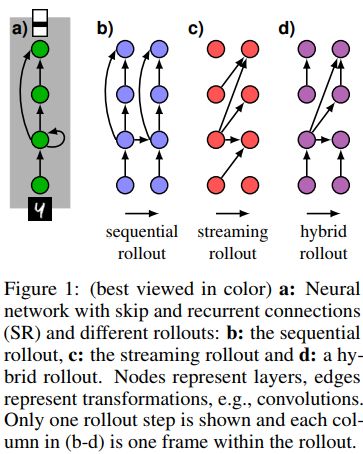

深层神经网络,尤其是循环网络,在控制与外界实时交互的自治体方面很有前景。然而,这需要将时序特征无缝地集成到网络结构中。针对循环神经网络,训练和推理时通常在时间上进行展开,但是展开的方法有多种。

一般在推理过程中,网络的每一层是以序列的形式进行计算的,这就会造成信息集成在时序上是稀疏的,而且响应时间较长。

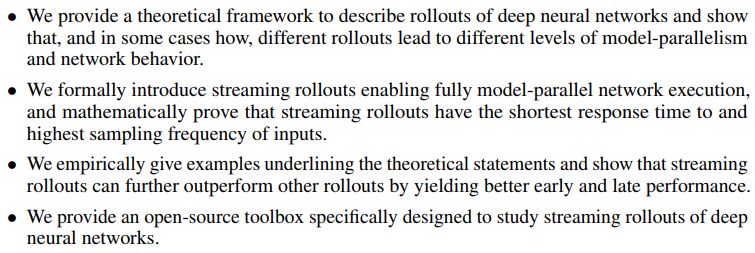

这篇文章针对如何展开,提出了一种理论框架,不同展开方式对应的模型并行度会有所不同。有些特定形式的展开,可以得到更早的并且更频繁的响应,而且早些的响应通常会取得更好的效果。流式展开性能最好,这种展开能够使得网络完全并行化执行,进而利用大量并行设备缩短运行时间。

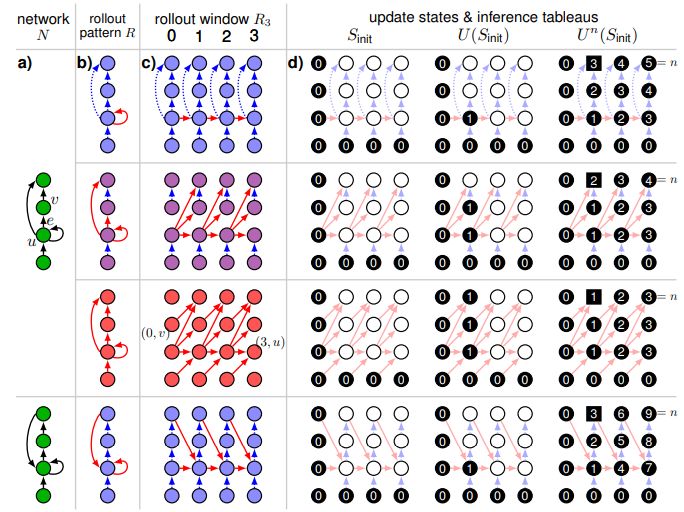

不同的展开方式对比如下

这篇文章的主要贡献可以归纳为

不同的展开方式及对应的更新和推理对比如下

代码地址

https://github.com/boschresearch/statestream

![]() 我是分割线

我是分割线![]()

[2] Can We Gain More from Orthogonality Regularizations in Training Deep CNNs?

Nitin Bansal, Xiaohan Chen, Zhangyang Wang

Texas A&M University

https://papers.nips.cc/paper/7680-can-we-gain-more-from-orthogonality-regularizations-in-training-deep-networks.pdf

这篇文章为了更好的训练深层卷积神经网络,提出了新颖的正交正则项,该正则项利用了多种高级分析工具,比如相干性和有限等距特性。这些插拔式正则项可以很方便地用于训练任何卷积神经网络。

作者们将这些方法用于一些效果较好的经典模型,比如ResNet, WideResNet, ResNeXt等,并且在流行的计算机视觉数据集上进行了实验,比如CIFAR-10, CIFAR-100, SVHN以及ImageNet等。

这篇文章提出的正则化方法不仅能够使得模型训练速度更快,而且收敛地更稳定&#x

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2175

2175

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?