一、线性代数的入门知识

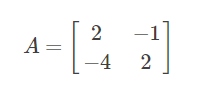

(一)矩阵

1、矩阵的表示

在中学的时候,我们会经常看到这样子的方程组:

看到这样子的方程组,不由感到十分怀念。不过有没有这种感想,当年解三元一次方程组的时候,特别烦,消元后要抄一遍,代入后又抄一遍,特别麻烦。

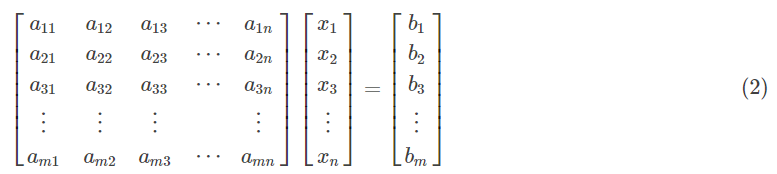

于是数学家发明了矩阵,把方程组中所有系数写到了一个框里面,把所有未知数写到第二个框里,把所有等式右边的值写到第三个框里。

比如方程组 (1) 也可表示为:

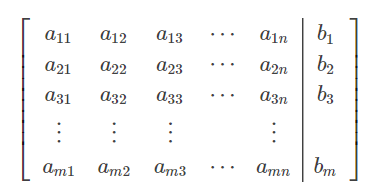

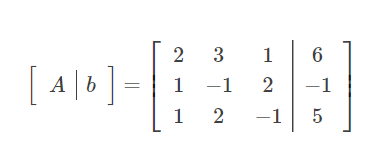

观察 (2) 式不难发现,复杂的方程组用矩阵表示后,还是很复杂,所以可以把 (2) 式更加简洁地表示成增广矩阵:

同理,比如方程组 (1) 也可表示为增广矩阵:

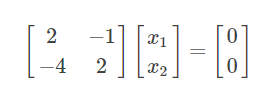

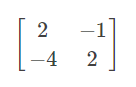

特别地,当方程组的等式右边全为 0,即 bi=0,其中 i=1,2,3…n 时,方程组为齐次线性方程组,增广矩阵可直接表示成系数矩阵。比如增广矩阵 (3) 可直接表示成:

我们称,方程组的等式右边全为 0 的方程组为齐次线性方程组,否则为非齐次线性方程组。

2、矩阵的解方程组

(1)齐次线性方程组

来回顾一下这个方程组:

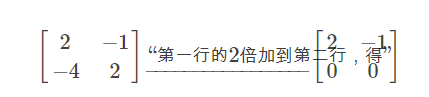

等式右边全为 0,所以把这个方程组写成矩阵形式:

要解这个方程组,当然使用消元法,不同于中学的是直接在矩阵里面消元:

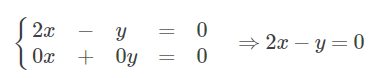

看到消元后的新矩阵是不是觉得很直观,如果你你把新矩阵还原成方程组的形式,有:

仔细观察可发现,原本有两个式子的方程组经过消元后,变成了只有一个方程组。这种情况在中学时,无论做多少题都不会遇到的,

因为在中学里,学的初等数学方程组都是有唯一解的。而在线性代数中,我们把这种情况成为方程组系数矩阵的秩为 1,记为 r(A)=1。

当矩阵的秩小于未知数的个数时,方程组有无数个解;当矩阵的秩等于未知数的个数时,方程组只有零解。

由于方程组 (1) 有两个未知数,而 r(A)=1<2,所以方程组 (1) 有无数个解。设 y=2 , 则 x=1;再设 k 为任意常数,则 x=k, y=2k 为方程组 (1) 的解,写成矩阵的形式为:

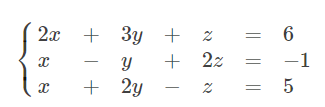

(2)非齐次线性方程组

再来看一个 3 个未知数的方程组:

右边等式不为 0,改写成增广矩阵:

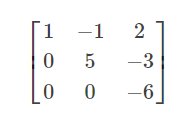

同理,对 [A | b] 进行初等行变换(即消元):

这一次进行初等行变换后,对于任意的非齐次线性方程组,当 r(A)=r(A|b)= 未知数的个数 时,非齐次线性方程组有唯一解;

当 r(A)=r(A|b)< 未知数的个数 时,非齐次线性方程组有无数个解;当 r(A) 不等于 r(A|b) 时,非齐次线性方程组无解。

可见 r(A)=r(A|b)=3,所以 [A|b] 有唯一解,写回方程组形式:

(二)向量

(1)列向量

可能是数学家觉得用矩阵来代表方程组还是太麻烦还废纸,所以又苦思冥想,最终想到了用向量再来继续简化矩阵,举个例子:

(2)行向量

有列向量,自然有行向量。同理,我们对矩阵 A 按行分块,并对每行元素用向量表示。

显然,用向量组便可轻松对矩阵瘦身。

3、线性相关与线性无关

(1)线性相关

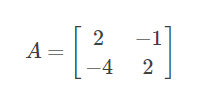

假设有这么一个矩阵

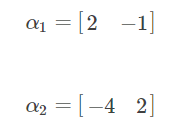

我们对其按行分块,则有向量:

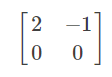

如果用行向量 α1, α2, α3, … , αn 来表示的矩阵 A 经过初等行变换后,某行(即某个向量αi)的元素全变为 0,

那么则称 α1, α2, α3, … , αn 向量组线性相关(可以理解为多个向量间或系数矩阵有线性关系)。

如果齐次线性方程组的系数矩阵有线性关系,那么齐次线性方程组有无穷多个解。了看清楚 α1, α2, α3, … , αn 是否线性相关,对矩阵 A 进行初等行变换后,发现:

所以, α1, α2, α3, … , αn 向量组线性相关

(2)线性无关

假设有这么一个矩阵

我们对其按行分块,则有向量:

如果用行向量 α1, α2, α3, … , αn 来表示的矩阵 A 经过初等行变换后,某行(即某个向量αi)的元素不全为 0,那么则称 α1, α2, α3, … , αn 向量组线性无关。

为了看清楚 α1, α2, α3, … , αn 是否线性无关,对矩阵 A 进行初等行变换后,发现:

所以, α1, α2, α3, … , αn 向量组线性无关。

4、向量空间

向量空间是线性代数中抽象的一部分,常用于物理研究中探索多维空间的奥秘(有没有用于物理中不太清楚,感觉的)。

在笛卡尔直角坐标体系中,向量 (1,0), (0,1) 分别代表了横坐标轴、纵坐标轴,对这两个向量线性组合的整体就可以表示出一个平面,即 2 维向量空间;

向量 (1,0,0), (0,1,0), (0,0,1) 分别代表了 x 坐标轴、y 坐标轴、z 坐标轴,对这三个向量线性组合表示出的整体可表示出一个 3 维向量空间;以此类推。

有规律的是,n 维向量空间中的 n 个坐标轴向量是互相垂直的(就算是 4 维空间的 4 个坐标轴也是垂直的,只不过我们处于三维中,难以感知到四维空间,只能想象)。

我们称向量间的垂直为正交。数学家对向量空间更是大开脑洞,认为不一定是笛卡尔体系的 (1,0,0), (0,1,0), (0,0,1) 才能是坐标轴,

只要是线性无关的向量组中的 n 个向量都可以当做是 n 维向量空间中的坐标轴,相当于将笛卡尔坐标体系的原点固定住,

将所有坐标轴就像陀螺一样旋转某个角度,得出的新坐标轴肯定是线性无关的。

“n 个向量组成的线性无关向量组,在 n 维向量空间中,可充当坐标轴” 这就是线性代数的向量空间的核心思想。

(三)行列式

行列式作为国内各个教材书中的第一个章节的内容,证明了其在线性代数中的重要性。但是如果从教材中的行列式入手学习线性代数,

那是要吃不少苦头的,因为只学了行列式,没有具备矩阵和向量的知识的情况下,很容易一脸懵逼。

由于行列式涉及的概念、性质、计算众多,所以本文只简单介绍一下行列式。

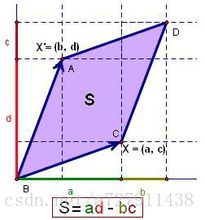

**行列式的本质是什么?**柯西给出了答案。假设在一个平面中有两个向量:x1=(a, c), x2=(b, d);

x1 与横坐标的角度为α,x2 与横坐标的角度为β;

x1 的模为 ||x1||,x2 的模为 ||x2||; 如图:

我们要求图中的 S,即向量平移后端点相交而围成的平行四边形的面积:

S = ||x1|| · ||x2|| · sin(β-α)

= ||x1|| · ||x2|| · (sinβcosα - cosβsinα)

= ad - bc

对 x1 和 x2 向量类似行向量那样子对元素命名:

x1=(a11, a12)

x2=(a21, a22)

重新得到 S = a11 · a22 - a12 · a21,

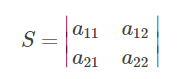

数学家对向量 x1 和 x2 写成行列式,代表了 S 的值:

行列式不过就是将矩阵的括号改成了两条竖线,用竖线包着的元素,最终可以算出一个数,这个数就是行列式,行列式就是一个数,

这个数是不同行不同列元素乘积的代数和。而矩阵本质为表格或数组,这是两者不同之处。

如果继续推,可以推出:在二维空间,行列式是面积;在三维空间,行列式是体积;在高维空间,行列式是一个数。

换句话说,就是由 n 个向量组成的线性无关向量组,可以表示成行列式,并且算出的结果肯定不为 0。

以次可推,由 n 个向量组成的线性相关向量组表示成的行列式值为 0。

(四)特征值与特征向量

特征值与特征向量在线性代数中是最难理解的内容,尤其在阅读国内教程时,直接一个定义拍到脸上,让人措手不及。

特征值与特征向量是线性代数的核心,在机器学习算法中应用十分广泛。

1、定义

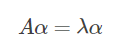

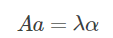

首先,讲到特征值与特征向量,必先讲到定义:设 A 是 n 阶矩阵,如果存在一个数 λ 及非零的 n 维列向量 α ,使得

成立,则称 λ 是矩阵 A 的一个特征值,称非零向量 α 是矩阵 A 属于特征值 λ 的一个特征向量。

观察这个定义可以发现,特征值是一个数,特征向量是一个列向量,一个矩阵乘以一个向量就等于一个数乘以一个向量。这个定义感觉太抽象了,我们来举一个具体的例子:

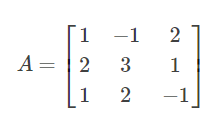

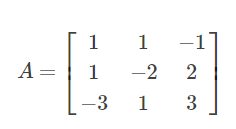

设 A 是 3 阶矩阵,

存在一个数 λ=4 ,

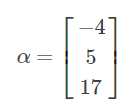

且存在一个非零的 3 维列向量 α ,

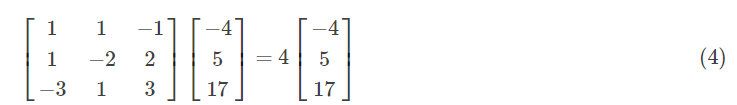

使得 Aα = λα,即

则称 λ=4 为矩阵 A 的特征值,(为了方便,简称 4 为特征值);也称 α=[-4, 5, 17]T 是矩阵 A 属于特征值为 4 的一个特征向量。

(为了方便,简称 [-4, 5, 17]T 为特征向量)

对于上面的 (4) 式,我们可以把它还原为方程组验证此式是否成立,还原过程如下:

显然,每个等式两边相等, Aα = λα 成立!(如果不知道为什么可以还原成方程组的话,请翻回到上面的非齐次方程组部分,可发现在这里 α 相当于解向量, λα 相当于 b 向量)

2、特征值与特征向量的个数

如果是自学线性代数的话,很容易有这么一个误区:认为一个矩阵的特征值与特征向量只有一个。

其实,一个矩阵的特征值可以有多个,相应地,特征向量的个数也随着特征值的数量的变化而变化。

总的来说,一个 n 行 n 列的矩阵的特征值个数少于或等于 n 个。还是以矩阵 A 为例,满足 Aα = λα 的式子有:

另外,一个特征值对应的特征向量的个数也不一定只有一个。 (由于这句话会引申出特别多的性质,所以本文就不举这句话的例子了)

3、给定一个矩阵,求特征值与特征向量的方式

求特征值与特征向量为这么一个过程:设 A 为 n 阶矩阵,a 为非零列向量,λ是一个数,

4、特征值与特征向量该怎么理解

仔细看本文的童鞋就会发现,一个矩阵并非只是单纯的一张表格、数组,它还代表了某种神奇的魔力,

与某个向量相乘后,还能变成一个数。换句话说,保存着很多个数的矩阵经过与特定的向量相乘后,塌缩成了一个数。

对于特征值与特征向量,有许多不同的理解,我自己从网络上的观点总结了一下,大概分为三种理解:

**第一种理解:**从向量的角度来看,一个列向量在左乘一个矩阵后,会经过一系列的线性变换,最终向量的长度会变成原来的 λ 倍。

**第二种理解:**从矩阵的角度来看,矩阵是一种线性变化的描述,特征向量是一个不变的方向,特征值是线性变化的结果。

**第三种理解:**从向量空间的角度来看,因为不同特征值对应的特征向量线性无关,把每个特征向量看做是一个坐标轴,

特征值是对应坐标轴(即特征向量)的坐标值。简单来说,就是用特征值(坐标)与特征向量(坐标轴)来表示原矩阵。

以上三种理解由浅入深,第三种理解才是本质的理解,但首先需要对向量空间有深刻的理解。

4652

4652

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?