目前该工作已被ICLR2025接收,代码和数据均已开源,欢迎大家关注并试用!若感觉好用请不要吝啬各位的star与cite

Arxiv链接: https://arxiv.org/abs/2410.19702

Github链接: https://github.com/OpenGVLab/TimeSuite

动机:

我们发现目前的大多数MLLM在进行长视频理解时容易关注到与问题不相关的片段,从而经常出现幻觉。是否能够通过将时序定位作为辅助任务,通过准确定位到相关事件的长视频子片段,以提升多模态大模型在长视频问答任务上的表现?

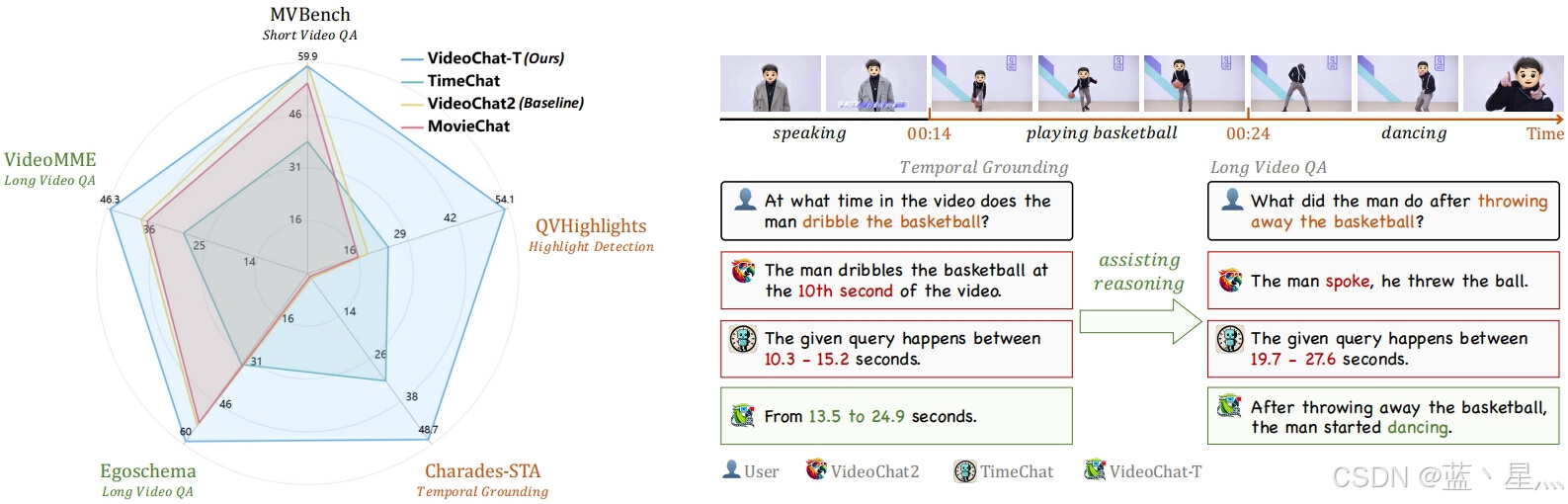

图1 VideoChat-T在长视频问答和时间定位任务上都表现出了很高的性能。我们的TimeSuite提供了一系列新的设计,以增强MLLM的长视频理解能力。它将隐式地赋予MLLM在产生答案时正确观察相应视频片段的能力,从而缓解大模型幻觉的出现。

概述:

针对以上动机,我们提出了TimeSuite,一种利用时间定位数据对短视频MLLMs进行增量微调,从而增强其长视频理解能力的有效方法。具体来说,TimeSuite包含一个处理长视频序列的简单高效框架(VideoChat-T),一个高质量的基于定位的指令调优数据集(TimePro),以及一个精心设计的指令调优任务(Temporal Grounded Caption)。通过联合使用以上组件对MLLMs进行指令微调后,可以有效引导MLLMs在回答问题时关注正确的片段,从而提升长视频问答的准确率。

图2 VideoChat-T的总体架构。首先,长视频被分割成片段,然后通过视频编码器和感知时间的Qformer将其转换为特征嵌入。接下来,所有的视觉tokens都经过Token Shuffle来压缩过长的令牌,并通过TAPE生成自适应的位置编码。最后,将长视频tokens与用户query连接起来,作为LLM的输入,从而生成适当的response。

图2 VideoChat-T的总体架构。首先,长视频被分割成片段,然后通过视频编码器和感知时间的Qformer将其转换为特征嵌入。接下来,所有的视觉tokens都经过Token Shuffle来压缩过长的令牌,并通过TAPE生成自适应的位置编码。最后,将长视频tokens与用户query连接起来,作为LLM的输入,从而生成适当的response。

本文亮点:

• 无需依赖任何外部专家解码器,我们提出的VideoChat-T可以在时序定位任务中实现专家级的性能,同时保持相当的泛化 QA 能力和强大的零样本能力。

• 我们通过引入专家任务的增强了 MLLM 对长视频的全面理解,验证了通过整合专家任务来增强 MLLM 综合能力的可行性。

图3 (a)我们提出的以时间为中心的指令调优数据集,TimePro。该数据集包含了大约349K个高质量和强时间相关性的数据。(b)提出的Temporal Grounded Caption微调数据范式。它有效地通过关注正确的视频片段减少了幻觉的发生。

实验结果

实验结果表明,我们的TimeSuite为提高短视频MLLM的长视频理解能力提供了一个成功的解决方案,VideoChat-T相较于原模型在Egoschema和VideoMME等长视频问答测试基准上的准确率分别提高了5.6%和6.8%。此外,VideoChat-T显示了强大的零样本时间定位能力,显著优于现有的最先进的MLLMs。经过微调后,它的性能甚至可以比肩传统的有监督时间定位专家模型。

图4 VideoChat-T等方法在视频问答任务上的表现。通过使用TimeSuite升级VideoChat2,VideoChat-T在多个长视频基准测试中的性能显示出了显著的改进。

图5 VideoChat-T在Temporal Grounding和Highlight Detection任务上的性能。(FT)表示在评估基准训练集上微调的模型,它们的字体用灰色标记。经典的监督专家模型被标记为※。

269

269

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?