CSDN的博客标题长度有限制,写不全,这篇论文是2016年的一篇名为Knowing when to look: Adaptive attention via a visual sentinel for image captioning1的文章,这篇文章我认为创新点特别的好,用一个十分简单的方式较大程度上提升了Image Caption的效果。

首先介绍一下这篇论文解决的问题,在我们的语言中是由一些虚词和惯用词汇的,如英语的“the”和“of”以及“behind a red stop”后接“sign”,在Image Caption生成句子时,生成这些词并不需要很多的视觉信息,而更多的来源于我们的语言模型(Language Model)。在这篇论文,作者提出了一种模型让该模型自适应(adaptive)决定什么时候更依靠视觉信息,什么时候更依靠语言模型,即让网络学习到when to look。

总结起来这篇论文的贡献点如下(我的总结,非原文的contribution):

- 提出了一种新的Spatial Attention的模型;

- 提出了Adaptive Attention,让网络自适应的去决定依靠视觉信息或语言模型。

1. Spatial Attention Model

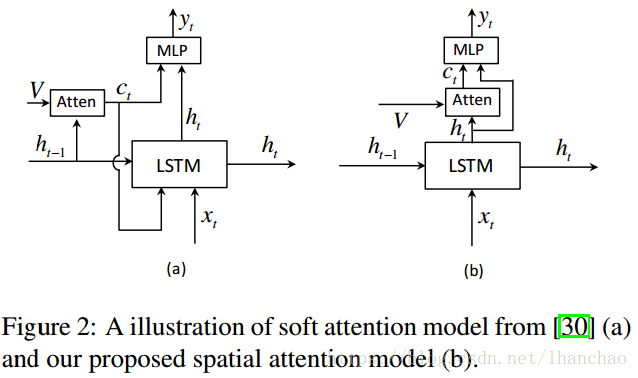

如图所示,新的Spatial Attention模型与Show, attend and tell一文中的Attention模型的差别如下:

这里的主要区别在于 c t c_t ct不再参与LSTM的输出结果,且用于生成 c t c_t ct的向量不再是 h t − 1 h_{t-1} ht−1而是 h t h_t ht。

用公式表达如下:

c t = g ( V , h t ) c_t = g(V, h_t) ct=g(V,ht)其中 g g g为Spatial Attention的过程, V = [ v 1 , . . . , v k ] V=[v_1,...,v_k] V=[v1,...,vk], v i ∈ R d v_i\in\mathbb{R}^d vi∈Rd, v i = R e L U ( W a a i ) , a i v_i=ReLU(\bm{W}_a\bm{a}^i), a^i vi=ReLU(Waai),ai是Encoder提取的特征向量,所以 V ∈ R d × y V\in \mathbb{R}^{d \times y} V∈Rd×y&#x

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

610

610

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?