通常在特征提取过程中,会遇到一个很严重的问题,那就是特征维度过多,实际上这些特征对于 表示和分类的贡献度不同,那么哪些特征是重要的?哪些是次要的呢?

这时轮到PCA出场了(想必早已名声在外),PCA即主成分分析(principal component analysis),主要被用于消除样本特征之间的相关性,降低计算复杂度,通俗上称之为降维。

PCA降维来进行判定和识别,给他取个名字叫“特征空间”。不用说,这个空间一定非常好(给一句表白的机会:“表妹,我有很多优点”):

a) 空间能够用向量来表示,方便计算;

b)向量维度不要太多;

c) 同类型的图像更趋于一致,不同的图像更加可区分;

那么怎么样才能得到这个特征空间呢?

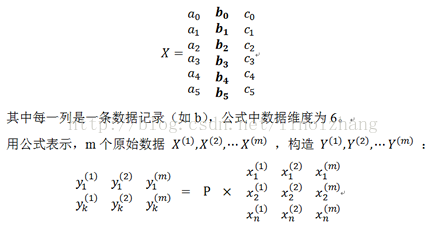

PCA方法的本质目标就是找到一个线性变换 P,将原始数据 X(维度为n)转换到一个新的空间 Y(维度为k,k<n),即 Y=PX ,使得变换后数据的可区分度最高,给出原始数据X的示例:

那么如何构造矩阵P呢?我们先给出结论:

1)针对原始样本数据,构造对应协方差矩阵 (n*n);

2)求 的 特征值和特征向量(n个);

3)选择前k个最大特征值对应的特征向量,组成矩阵P(n*k);

好像很简单,对不对?如果你不想了解理论基础,仅限于了解及普及,请跳过本节以下内容。

我们先看个简单的例子。

这样我们得到了一个结论:

代表数据在新特征空间P下的方差, 值越大越好。

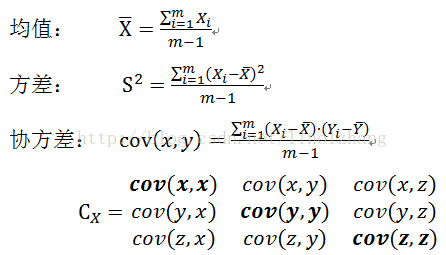

下面直接列出要用到的一些公式,本节假定你已经熟悉了简单的相关矩阵概念(如果不是,请使用Google或者Bing搜索,如果自诩爱国,又不屑于用某度,请自行Python爬虫):

协方差表明了两个随机变量之间的相关性,值为正说明两者是正相关的,值为负说明两者是负相关的,值为0说明两者不相关。

根据上述理论,目标转换为构造新空间Y下的协方差矩阵 ,使其具有如下特点:

1)对角阵,即非对角线元素全部为0

协方差越小,相关性越低,协方差为0表示没有相关性。

2)对角线元素从左上角到右下角降序排列

对角线元素(加粗部分)为方差,方差越大,表示保留的重要信息越多。

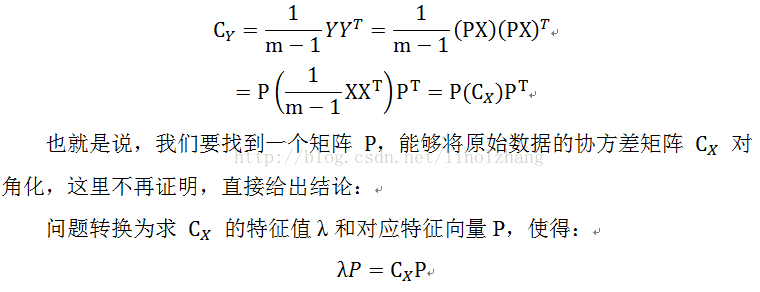

公式推导:

取最大的K个特征值,构造对应特征向量P,即实现了降维变换。

718

718

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?