对Alpha-zero很感兴趣,所以耐心阅读了mastering the game of go without human knowledge

Deepmind 官网的介绍:AlphaGo Zero: Learning from scratch

在阅读的过程中,对蒙特卡洛树搜索算法不甚了解,下面翻译了youtube上一位英国教授的网络课程视频。

同时,我在CSDN资源中上传了自己研究AlphaGo的两篇文章后,写的两个版本的AlphaGo算法结构和MCTS结构的对比分析的文章,名为"AlphaGo VS AlphaGo Zero 对比分析讲解",有兴趣的读者可以下载。

##蒙特卡洛树搜索(MCTS)算法

MCTS算法是一种决策算法,每次模拟(simulation)分为4步:

- Tree traversal:

U C B 1 ( S i ) = V i ‾ + c log N n i , c = 2 UCB1(S_i) = \overline{V_i}+c\sqrt{\frac{\log N}{n_i}}, c=2 UCB1(Si)=Vi+cnilogN,c=2

其中, V i ‾ \overline{V_i} Vi表示 S i S_i Si状态的平均value(下面会进一步解释) - Node expansion

- Rollout (random simulation)

- Backpropagation

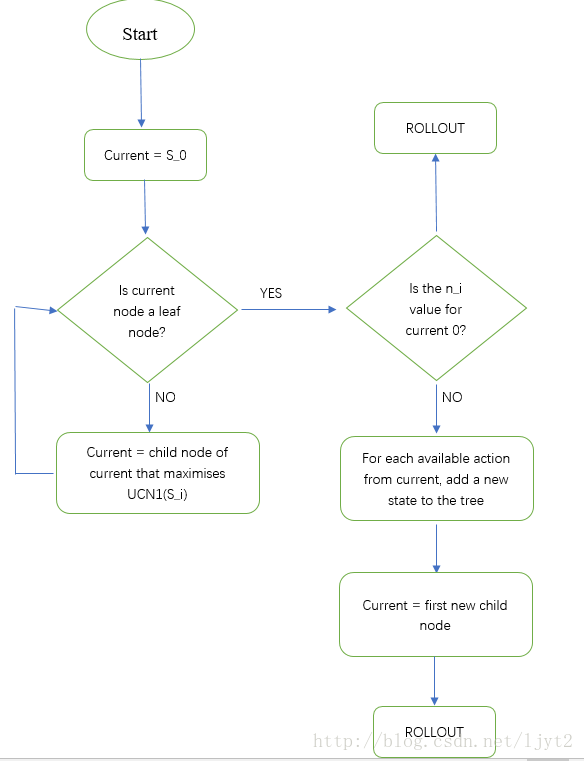

步骤1,2的流程图如下:

步骤3 Rollout 的细节:

Rollout(S_i):

loop forever:

if S_i is a terminal state:

return value(S_i)

A_i = random(available-actions(S_i))

S_i = simulate(A_i,S_i)

讲一个具体的例子:

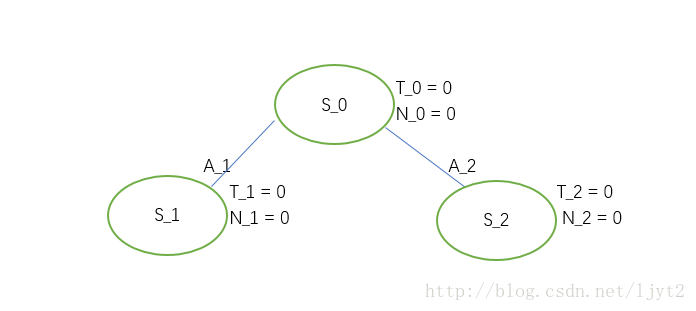

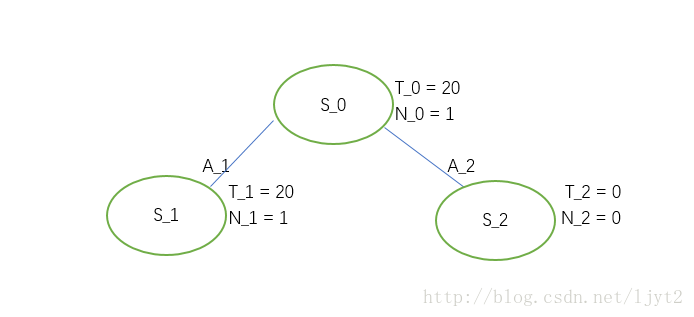

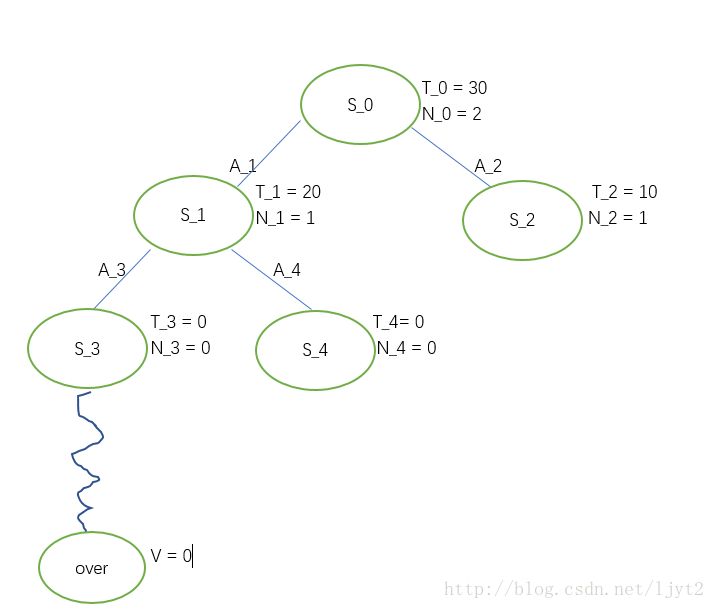

- 树的初始状态:

T 表示总的 value, N 表示被访问的次数(visit count)。A表示动作(action).

第一次迭代(iteration):

从状态 S 0 S_0 S0开始,要在下面两个动作中进行选择(假设只有两个动作可选),选择的标准就是 U C B 1 ( S i ) UCB1(S_i) UCB1(Si)值。显然可算得: U C B 1 ( S 1 ) = U C B 1 ( S 2 ) = ∞ UCB1(S_1)=UCB1(S_2)=\infty UCB1(S1)=UCB1(S2)=∞

这种情况下,我们就按顺序取第一个,即 A 1 A_1 A1。从而,达到状态 S 1 S_1 S1。

按照步骤1,2的流程图,我们现在需要判断目前的结点 S 1 S_1 S1(current node)是不是叶节点,这里叶节点是指其没有被展开(expansion)过。显然,此结点没有被展开过,所以是叶节点。接下来,按照流程图,需要判断结点 S 1 S_1 S1被访问的系数是否为0。是0,所以要进行Rollout。

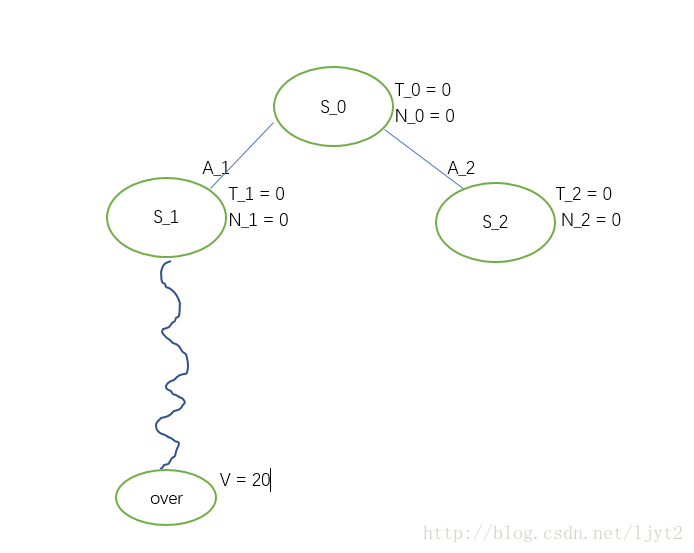

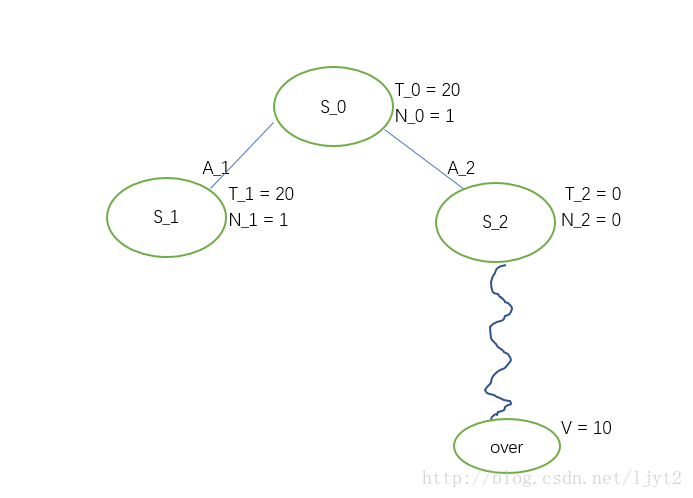

Rollout其实就是在接下来的步骤中每一步都随机采取动作,直到停止点(围棋中的对局结束),得到一个最终的value。

假设Rollout最终值为20.

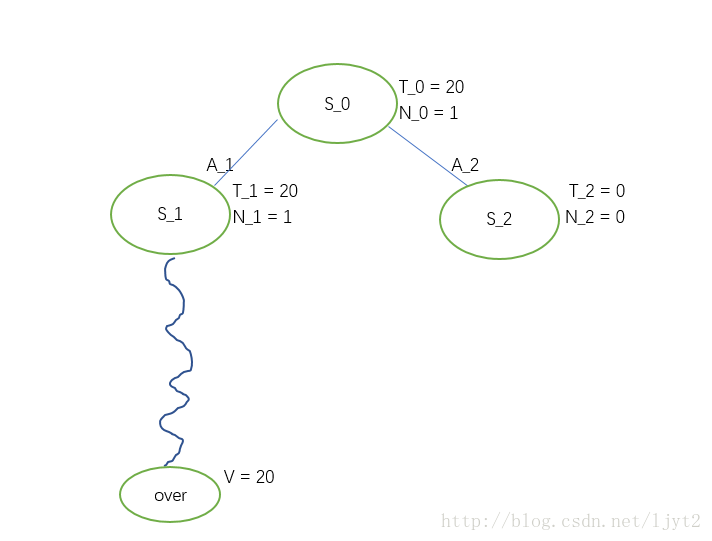

接下来,进行步骤4 Backpropagation,即利用Rollout最终得到的value来更新路径上每个结点的T,N值。

之后把Rollout的结果删除:

MCTS的想法就是要从 S 0 S_0 S0出发不断的进行迭代,不断更新结点值,直到达到一定的迭代次数或者时间。

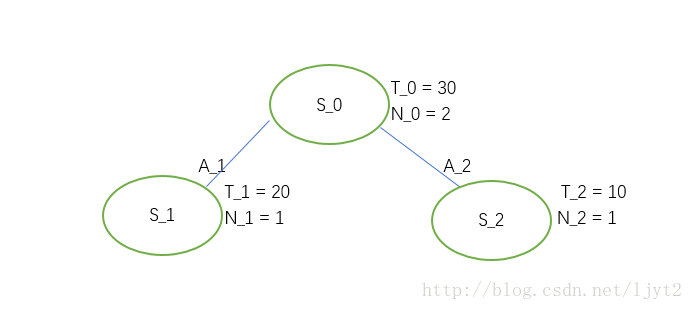

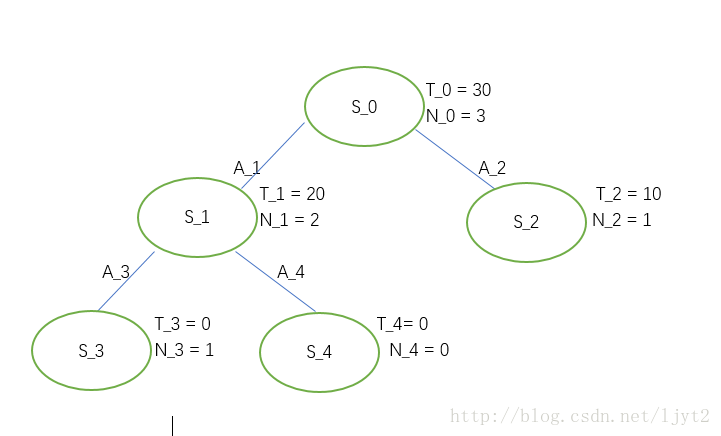

第二次迭代:

我们从 S 0 S_0 S0出发进行第二次迭代(iteration):

首先,计算下面两个结点

S

1

,

S

2

S_1,S_2

S1,S2 的

U

C

B

1

UCB1

UCB1值:

U

C

B

1

(

S

1

)

=

20

U

C

B

1

(

S

2

)

=

∞

UCB1(S_1) = 20 ~~~~ UCB1(S_2) = \infty

UCB1(S1)=20 UCB1(S2)=∞

所以,选动作

A

2

A_2

A2,从而达到状态

S

2

S_2

S2。

同上,现在要判断结点 S 2 S_2 S2是否是叶结点。是,所以继续判断其被访问的次数。是0,所以进入Rollout, 假设Rollout最终值为10.

之后进行Backpropogation:

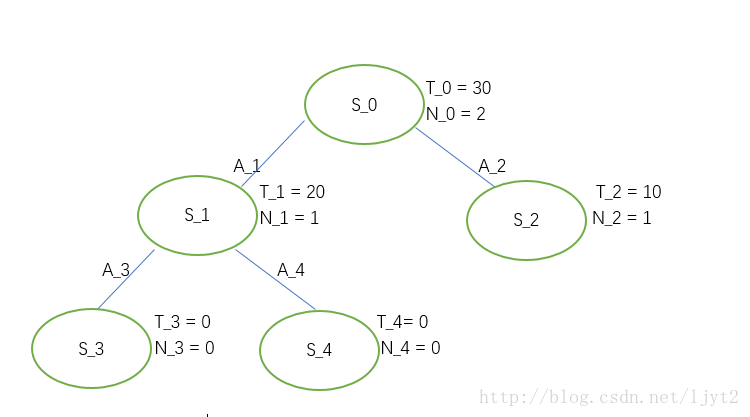

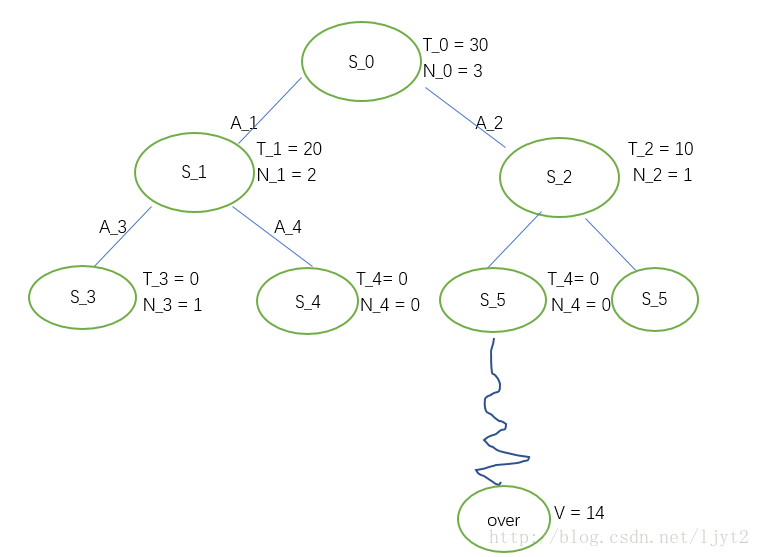

第三次迭代:

首先,计算UCB1值: U C B 1 ( S 1 ) ≈ 21.67 U C B 1 ( S 2 ) ≈ 11.67 UCB1(S_1) \approx 21.67 ~~~ UCB1(S_2) \approx 11.67 UCB1(S1)≈21.67 UCB1(S2)≈11.67

执行动作

A

1

A_1

A1,进入状态

S

1

S_1

S1。

是否是叶节点? 是。

被访问次数是否为0?否。

按照流程图所示,现在进入Node expansion步骤。同样假设只有两个动作可选。

选择 S 3 S_3 S3进行 Rollout,假设Rollout最终值为0.

更新路径上每个结点的值,之后删除Rollout的值:

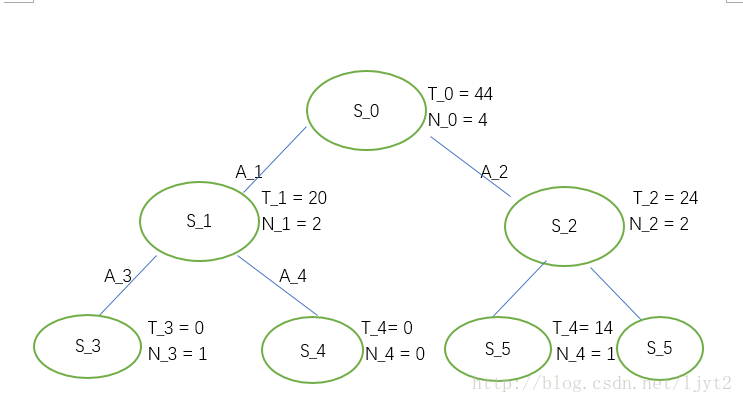

第四次迭代:

首先,计算UCB1值: U C B 1 ( S 1 ) = 10 + 2 log 3 2 ≈ 11.48 U C B 1 ( S 2 ) ≈ 12.10 UCB1(S_1) = 10+2\sqrt{\frac{\log3}{2}} \approx 11.48 ~~~ UCB1(S_2) \approx 12.10 UCB1(S1)=10+22log3≈11.48 UCB1(S2)≈12.10

选择 A 2 A_2 A2,进入状态 S 2 S_2 S2, 接下来和第三次迭代一样的步骤:

更新路径上的结点:

假设我们设定最大迭代次数为4,则我们的迭代完毕。这时,利用得到的树来决定在 S 0 S_0 S0处应该选择哪个动作。根据UCB1值,显然我们要选择动作 A 2 A_2 A2.

以上就是MCTS的过程,是翻译自youtube.。

以上内容如有错误,皆由博主负责,与youtube上教授无关。

370

370

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?